Werbung

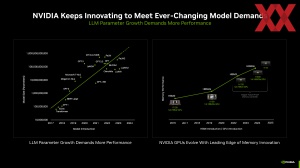

Zur Supercomputing 2023 stellt NVIDIA den H200-Beschleuniger als Nachfolger, bzw. verbesserte Version des H100 vor. Grundsätzlich basiert dieser auf der Hopper-Architektur und die bisherigen Hinweise deuten daraufhin, dass NVIDIA hier den gleichen Chip zum Einsatz bringen würde. Aber es gibt einen größeren Speicher und dieser ist sogar schneller. Als Upgrade zum H100 können bestehende Systeme auf den H200-Beschleuniger ausgebaut werden. Das SXM4-Modul passt hinsichtlich seiner elektrischen und thermischen Voraussetzungen in bereits verfügbare Systeme.

NVIDIA selbst spricht für ein Cluster bestehend aus acht H200-Beschleunigern von einer Rechenleistung von 32 PFLOPS. Entsprechend auf einen einzelnen Beschleuniger heruntergerechnet kommen wir also auf etwa 4 TFLOPS. Es ist daher anzunehmen, dass die Rechenleistung der GPU identisch mit der des H100-Beschleunigers ist, was bei genauerer Betrachtung nicht weiter verwunderlich ist – es handelt sich schließlich um den gleichen Chip. Die maximale TDP dürfte demnach bei bis zu 700 W liegen.

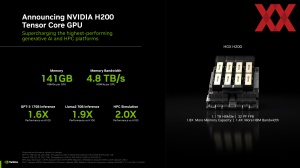

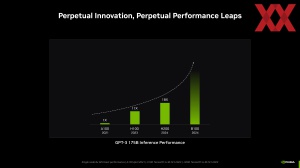

NVIDIA spricht allerdings auch von einer um den Faktor 1,6 höheren Inferencing-Leistung für GPT-3 mit 175 Milliarden Parametern im Vergleich zum H100. Für das Llama2-Modell mit 70 Milliarden Parametern soll die Leistung sogar um den Faktor 1,9 steigen. Dafür verantwortlich ist der größere und schnellere HBM3E-Speicher. Dieser ist nun 141 anstatt wie bisher mit HBM2E 80 GB groß und mit 4,8 TB/s auch deutlich schneller als die 3,35 TB/s des H100.

| GH200 | GH200 (2024) | H100 SXM | H200 SXM | |

| FP64-Rechenleistung (GPU) | 34 TFLOPS | 34 TFLOPS | 34 TFLOPS | 34 TFLOPS |

| FP32-Rechenleistung (GPU) | 67 TFLOPS | 67 TFLOPS | 67 TFLOPS | 67 TFLOPS |

| FP8-Rechenleistung (GPU) | 3,958 TFLOPS | 3,958 TFLOPS | 3,958 TFLOPS | 3,958 TFLOPS |

| INT8-Rechenleistung (GPU) | 3,958 TOPS | 3,958 TOPS | 3,958 TOPS | 3,958 TOPS |

| CPU-Speicher | 480 GB (LPDDR5X) | 480 GB (LPDDR5X) | - | - |

| GPU-Speicher | 96 GB (HBM3) | 141 GB (HBM3E) | 80 GB (HBM2E) | 141 GB (HBM3E) |

| Speicherbandbreite (GPU) | 4 TB/s | 4,9 TB/s | 3,35 TB/s | 4,8 TB/s |

| TDP | 450 bis 1.000 W | 450 bis 1.000 W | bis zu 700 W | bis zu 700 W |

Analog zur aktualisierten Variante des Grace Hopper Superchips (GH200) für 2024, der ebenfalls mit HBM3E ausgestattet ist, kann der H200 durch der Einsatz des schnelleren Speichers mit größerer Kapazität einige Anwendungen beschleunigen. NVIDIA hat den Speichercontroller bereits in der Designphase auf den Einsatz mit HBM2E und HBM3E ausgelegt.

Die OEM- und CSP-Partner sollen ab dem zweiten Quartal 2024 mit der Auslieferung der HGX-H200-Systeme beginnen.

Einen Ausblick gibt NVIDIA zudem auf den B100, der ebenfalls 2024 erscheinen soll. Dieser wird auf einer komplett neuen Architektur basieren und soll die LLM-Leistung noch einmal deutlich steigern.

Grace Hopper Superchip startet 2024 durch

Der für 2023 und zunächst mit HBM2E ausgestattete Grace Hopper Superchip (GH200) soll 2024 durchstarten und zahlreiche HPC- und KI-Systeme bestücken. Der Grace-ARM-Chip mit 72 Kernen und 480 GB an LPDDR5X und eine Hopper-GPU mit 96, bzw. 141 GB an HBM3(E) arbeiten zusammen auf einem Modul.

Ein erstes großes System mit GH200 wird das bereits angekündigte Boost-Modul für den ersten europäischen Exascale-Supercomputer JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research) sein. Hier zum Einsatz kommen werden die GH200-Beschleuniger mit 96 GB HBM3. Insgesamt fast 24.000 GH200 werden verbaut sein. Die Rechenleistung von JUPITER soll dann bei einem Exascale für FP64-Berechnungen und 93 Exaflops für AI-Anwendungen liegen. Die Leistungsaufnahme liegt bei 18,2 MW.

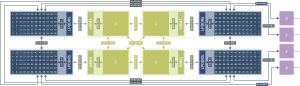

Für JUPITER verwendet werden die GH200-Module in einem Quad-Cluster (Quad GH200). Jedes dieser Module kommt demnach bereits auf 16 PFLOPS an AI-Rechenleistung und besitzt eine zusammengenommene Speicherbandbreite von 2,3 TB/s. Für JUPITER hat ATOS dazu die Eviden Bull Sequana XH3000 Nodes entwickelt.

Aber auch anderen Partner wie HPE wird die Quad GH200 zum Einsatz bringen – darunter im Daw-Supercomputer, der in der vergangenen Woche angekündigt wurde.

Für 2024 sollen die Auslieferungen und die generelle Verfügbarkeit der GH200-Beschleuniger deutlich steigen. Dies geschieht parallel mit den reinen GPU-Lösungen H100 und dann später in 2024 auch dem H200.

Update: Weitere Informationen zur Hardware

Das Jülich Supercomputing Center (JSC) hat weitere Informationen zum Aufbau des JUPITER (oint Undertaking Pioneer for Innovative and Transformative Exascale Research) veröffentlicht. Die Hauptrechenleistung wird vom Booster-Modul aufgebracht. Darin enthalten sind 5.938 Nodes mit jeweils einem Quad-Cluster (Quad GH200) und demnach vier GH200-Beschleuniger. Insgesamt kommen wir also auf 23.752 GH200-Beschleunigern. Diese liefern zusammengenommen 1 EFLOP/s an FP64/HPL-Rechenleistung und theoretisch 70 EFLOPS in FP8-Genauigkeit. Ingesamt verfügen die GH200-Beschleuniger über 2,28 TB ab schnellem HBM3-Speicher.

Neben der Hopper-GPU zweiter Bestandteil des GH200-Beschleunigers ist die Grace-CPU. Jeder GH200 besitzt einen Chip mit 72 Neoverse-V2-Kernen. Insgesamt kommen wir hier also auf 1,7 Millionen Kerne. Jeder CPU stehen 480 GB an LPDDR5X-Speicher zur Seite – also rund 11,4 TB insgesamt.

Während die Anbindung des LPDDR5X des Prozessors mit 500 GB/s in beide Richtungen stattfindet, ist der HBM3 mit 400 GB/s an die GPU Angebunden. Zwischen CPU und GPU können jeweils 450 GB/s in beide Richtungen übertragen werden. Im Quad-Modul können die CPUs mit jeweils 50 GB/s pro Richtung miteinander Daten austauschen, bei den GPUs sind es 150 GB/s. Die externe Kommunikation findet ausgehend vom CPU-Package mit jeweils 64 GB/s statt.

Im Cluster-Modul untergebracht werden mehr als 1.300 Nodes mit jeweils zwei Rhea1-Prozessoren. Diese sollen 5 PFLOP/s an FP64/HPL-Rechenleistung beisteuern. Dies entspricht gerade einmal 0,5 % dessen, was das Booster-Modul zu leisten im Stande ist.

Per InfiniBand-Adapter (HCA) wird jede Node mit viermal 200 GBit/s angebunden. Grundsätzlich verwendet wird ein Mellanox InfiniBand NDR Fabric in der DragonFly+-Topology. Das gesamte Netzwerk besteht aus 51.000 Links und 102.000 logischen Ports mit 25.400 Endpunkten und insgesamt 867 Switches.

An schnellem Speicher vorhanden sind 21 PB an nutzbarer Kapazität, die auf 2 TB/s an Schreib- und 3 TB/s an Lesedurchsatz kommen. Dazu verwendet werden 40 IBM Elastic Storage Server 3500. Weiterhin vorhanden ist ein Storage-Modul mit 300 PB an Kapazität und für Backups und ein Archiv stehen weitere 700 PB zur Verfügung.