Werbung

Ein Startup namens Etched hat einen ASIC namens Sohu vorgestellt, der speziell auf das Inferencing von Transformer-Modellen ausgelegt sein soll. Ausgestattet mit 144 GB an HBM3E sowie bereits reservierten Kapazitäten für die Fertigung bei TSMC will das Startup eine Konkurrenz von NVIDIAs Beschleunigern und dabei um ein Vielfaches schneller sein.

Transformer-Modelle sind eine Art von neuronalen Netzwerken, die speziell für die Verarbeitung von sequenziellen Daten wie Text entwickelt wurden und auf Selbstaufmerksamkeit (Self-Attention) basieren, wodurch sie parallelisierte Verarbeitung und langfristige Abhängigkeiten in den Daten effektiv handhaben können. Sprachbots und Übersetzungshilfen mit entsprechendem Verständnis des Inhalts sind aktuell die wichtigsten Anwendungsbereiche der Transformer-Modelle.

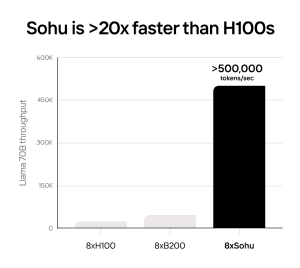

Laut Etched erreicht der Sohu-ASIC eine um bis zu 20fach höhere Leistung als NVIDIA mit den H100-Beschleunigern. Gezeigt wird dies auch für eine projizierte Leistung in Clustern mit jeweils acht Beschleunigern. Neben der schnelleren Ausführung des Inferencings sollen die Sohu-Beschleuniger auch günstiger als die Lösungen von NVIDIA sein.

Etched legt die Sohu ganz konkret auf das Inferencing von Transformer-Modellen aus. Das Training muss weiterhin auf Basis anderer Hardware, wie eben der von NVIDIA stattfinden. In den kommenden Jahren soll der Anteil der Inferencing gegenüber dem Training aber deutlich zunehmen.

Weitere KI-Anwendungen wie Convolutional Neural Networks (CNNs) für die Verarbeitung von Bilddaten kann der Sohu nicht so effizient bzw. gar nicht verarbeiten. Dies gilt auch für Modelle, die ähnlich zu den Transformer-Modellen sind – wie zum Beispiel Recurrent Neural Networks (RNNs) oder Long Short-Term Memory Networks (LSTMs), die ebenfalls zeitliche Abhängigkeiten in Daten mit einbeziehen. Auch Mixture of Experts (MoEs) soll der Sohu unterstützen. Dabei handelt es sich um einen Modellansatz, bei dem eine KI mit mehreren Expertisen trainiert wird, die zusammenarbeiten können. Mit 144 GB an HBM3E soll der Sohu-ASIC Modelle mit einer Größe von bis zu 100 Billion Parametern verarbeiten können.

Auf der Webseite zu sehen gibt es aktuell noch nur Renderings der Hardware, wenngleich Etched bereits von Kunden spricht, die einen zweistelligen Millionenbereich investiert haben sollen. Die Fertigung wird bei TSMC in einem 4-nm-Prozess stattfinden. Neben einer kleiner Fertigungskapazität hat man sich laut eigenen Angaben auch genügend HBM3E gesichert. Wann die ersten Beschleuniger ausgeliefert werden, ist nicht bekannt.

Unter den Leitern bei Etched befinden sich auch einige bekannte Gesichter, wie Ajat Hukkoo, der das Hardware-Engineering leitet und zuvor bei Intel in der Custom-Silicon-Gruppe tätig war.