Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] AMD Bulldozer "Zambezi" 32nm "New CPU Architecture" Sockel AM3+ [Part 3]

- Ersteller Duplex

- Erstellt am

- Mitglied seit

- 26.01.2009

- Beiträge

- 1.615

liegt vielleicht an cnq

Nein.

Klick in meine Signatur.

Da muss ich noch mal nachhaken: In einem anderen AMD-Rechner oder in nem Intel-Rechner?@Opteron

In einem anderen Pc läuft das Kit 1866 mit allen vier Riegeln.

Wäre ja nichts Neues, wenn es da Unterschiede gäbe.

Wenns ein Intel ist, probiers mal mit dem höheren RefTakt, ansonsten kurioser / BIOS / sostwas Bug (zumindest bei 1 DIMM pro Kanal).

Orange8

Neuling

- Mitglied seit

- 05.12.2011

- Beiträge

- 43

Nein.

Klick in meine Signatur.

ja die vcore, die cpu-z ausliest ist immer etwas höher als die eingestellte vid bei k10stat. das kann ich bestätigen ist doch aber kein problem, da die spannung nicht schwankt sondern etwas höher scheint, damit kann man doch aber arbeiten

betrachtet man die werte von vid bspw mit coretemp, dann stimmen die mit den eingestellten vid-werten von k10stat genau überein. wenn dann die vcore minimal abweicht liegt das an der automatik des gigabyte bios. ich sehe hier nicht wirklich ein problem.

Zuletzt bearbeitet:

- Mitglied seit

- 15.11.2002

- Beiträge

- 27.544

Tritt dieses Problem eventuell erst ab einer bestimmten GB Anzahl auf? Konnte jetzt mit 4x2GB zumindest mal problemlos mit 1866 und 2133 booten.

Sind allerdings keine 4 gleiche Module sonder 2 unterschiedliche Kits von GSkill und der 8120 ist auf 4Threads gedrosselt.

Pc startet bei 1866 wirklich nur mit einem Riegel. Da habe ich jetzt nicht alle Bänke ausprobiert.

Das mit dem einen DIMM pro Kanal wird aber auch nirgendwo erwähnt oder doch?

AMDs offizielle Aussage ist: Zwei bestückte DIMMs im Dual-Channel machen DDR3-1866. Vier bestückte DIMMs im Dual-Channel offiziell nur DDR3-1600. Bei Vollbestückung schraubt ja auch Intel beispielsweise bei SNB-E runter. Das wird aber nicht sehr offen kommuniziert und ich habe es auch erst auf Nachfrage erfahren.

Es kann aber auch sein, dass es läuft. Wir haben hier einen FX-8150 mit 4x 4 GB Corsair Vengeance. Das System bootet, der 3DMark und Prime laufen durch, aber sobald BF3 gestartet wird, stürzt die Anwendung ab. Es hängt also offenbar auch von den Modulen ab, ob es funktioniert oder nicht.

madpenguin

Semiprofi

AMDs offizielle Aussage ist: Zwei bestückte DIMMs im Dual-Channel machen DDR3-1866. Vier bestückte DIMMs im Dual-Channel offiziell nur DDR3-1600. Bei Vollbestückung schraubt ja auch Intel beispielsweise bei SNB-E runter. Das wird aber nicht sehr offen kommuniziert und ich habe es auch erst auf Nachfrage erfahren.

Es kann aber auch sein, dass es läuft. Wir haben hier einen FX-8150 mit 4x 4 GB Corsair Vengeance. Das System bootet, der 3DMark und Prime laufen durch, aber sobald BF3 gestartet wird, stürzt die Anwendung ab. Es hängt also offenbar auch von den Modulen ab, ob es funktioniert oder nicht.

Sorry fürs OT, aber warum kriegt das AMD beim BD nicht hin, während es beim LLano, zumindest bei mir, mit 4x4GB @1937Mhz funkioniert: booten, 3dMark, Spiele (auch BF3), etc.

MusicIsMyLife

Urgestein

- Mitglied seit

- 20.08.2002

- Beiträge

- 3.333

- Desktop System

- Alltagssystem

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASRock B650M PG Riptide

- Kühler

- Watercool Heatkiller IV Pro Copper

- Speicher

- 4x 32 GB G.Skill TridentZ 5 RGB (F5-6000J3040G32X2-TZ5RS)

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- ASUS ROG Swift PG42UQ, Philips BDM4065UC (3840x2160), Samsung C27HG70 (2560x1440)

- SSD

- Micron 9300 Pro 7,68 TB, Samsung 850 Evo 4 TB

- HDD

- keine, SSD only...

- Opt. Laufwerk

- LG CH08LS10 Blu-ray Disc-Player

- Soundkarte

- Creative SoundBlasterX AE-5 Plus

- Gehäuse

- Dimastech BenchTable EasyXL (vorübergehend)

- Netzteil

- MSI MPG A1000G PCIE5

- Keyboard

- ASUS ROG Strix Flare

- Mouse

- SteelSeries Sensei 310

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Internet

- ▼270 MBit ▲45 MBit

Schon klar

Also 2x4 GB @1.65v geht auch nicht,habe beide Kanäle probiert.

Jut dann werde ich erstmal 4x4 @1600 machen. Falls es wiedererwarten doch am Board liegt und ein Biosupdate was bringt gebe ich Bescheid.

Wenn du nicht "tief im Westen" wohnen würdest, würde ich dir ein Treffen anbieten, bei dem wir mal weitere Mainboards mit deiner CPU und deinem RAM testen. Aber so liegt wohl jede Menge Deutschland zwischen unseren Wohnorten.

Sorry, dass meine teils doofen Fragen nicht zur Problemlösung beitragen konnten.

Es kann aber auch sein, dass es läuft. Wir haben hier einen FX-8150 mit 4x 4 GB Corsair Vengeance. Das System bootet, der 3DMark und Prime laufen durch, aber sobald BF3 gestartet wird, stürzt die Anwendung ab. Es hängt also offenbar auch von den Modulen ab, ob es funktioniert oder nicht.

Ich denke noch immer, dass der Speichercontroller ausschlaggebend ist. Ich habe nämlich auch einen FX-8150 mit 4x 4 GB Corsair Vengeance getestet - mit dem Ergebnis, dass bei DDR3-1866 nur 12 GB beim Boot erkannt wurden. Ich denke, dass der Speichercontroller zu große Unterschiede aufweist und AMD genau deshalb mit vier Riegeln nur DDR3-1600 garantiert. Was anderes ist diese Spezifikation ja nicht.

Wer mit 4x 4 GB DDR3-1866 zum Laufen bekommt, der hat halt Glück gehabt, da er sich außerhalb der Herstellervorgabe bewegt. Wer das nicht schafft, der fällt auf einen Wert zurück, der von AMD auch garantiert wird.

Sorry fürs OT, aber warum kriegt das AMD beim BD nicht hin, während es beim LLano, zumindest bei mir, mit 4x4GB @1937Mhz funkioniert: booten, 3dMark, Spiele (auch BF3), etc.

Wie bereits gesagt: DDR3-1866 kann auch bei vier Riegeln mit dem Bulldozer funktionieren. Es wird halt nicht garantiert. Genauso wird bei deinem Llano auch kein Speichertakt von DDR3-1937 garantiert - dass es dennoch läuft ist schlichtweg einem guten Speichercontroller und Glück beim CPU-Kauf zu verdanken.

Da muss ich noch mal nachhaken: In einem anderen AMD-Rechner oder in nem Intel-Rechner?

Wäre ja nichts Neues, wenn es da Unterschiede gäbe.

Wenns ein Intel ist, probiers mal mit dem höheren RefTakt, ansonsten kurioser / BIOS / sostwas Bug (zumindest bei 1 DIMM pro Kanal).

Ist ein i7 2600k System. Ich werde Nachher mal 2 Dimms mit dem höheren RefTakt ausprobieren.

Wenn du nicht "tief im Westen" wohnen würdest, würde ich dir ein Treffen anbieten, bei dem wir mal weitere Mainboards mit deiner CPU und deinem RAM testen. Aber so liegt wohl jede Menge Deutschland zwischen unseren Wohnorten.

Sorry, dass meine teils doofen Fragen nicht zur Problemlösung beitragen konnten.

Ich habe mal Cottbus als Referenz genommen. Die kürzeste Srecke wären 613 km

Trotzdem Danke für das Angebot.

Trotzdem Danke für das Angebot.- Mitglied seit

- 26.01.2009

- Beiträge

- 1.615

ja die vcore, die cpu-z ausliest ist immer etwas höher als die eingestellte vid bei k10stat. das kann ich bestätigen ist doch aber kein problem, da die spannung nicht schwankt sondern etwas höher scheint, damit kann man doch aber arbeiten

betrachtet man die werte von vid bspw mit coretemp, dann stimmen die mit den eingestellten vid-werten von k10stat genau überein. wenn dann die vcore minimal abweicht liegt das an der automatik des gigabyte bios. ich sehe hier nicht wirklich ein problem.

Wenn das für dich normal ist, dann hast du andere Ansprüche an ein 150€ Brett als ich.

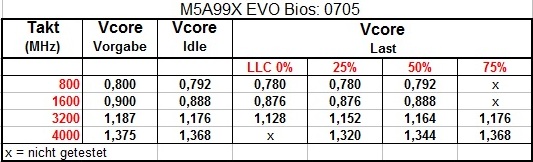

Für mich wäre eher das normal:Zusammenfassung:

VCore Stabilität:

Getestet mit einem X6 1090T

Leider wird sich daran auch höchstwahrscheinlich nichts ändern, da es nicht möglich ist LLC nachträglich zu implementieren. Das Problem wird wohl erst mit den nächsten Boardrevisionen behoben.

Reous

Mr AMD

- Mitglied seit

- 14.01.2007

- Beiträge

- 10.168

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5700G

- Mainboard

- ASUS Strix B550-I Gaming (2007I)

- Kühler

- Thermalright ARO M14G

- Speicher

- G.Skill TridentZ 4000C19 32GB @ DDR4-4000C16

- Grafikprozessor

- AMD Radeon Vega 8 (iGPU)

- SSD

- Samsung M.2 SSD 980 500GB

- HDD

- Seagate BarraCuda Compute 2TB + 3TB

- Soundkarte

- Creative Titanium Fatality Pro

- Gehäuse

- Alu Tower Eigenbau

- Netzteil

- Seasonic Platinum Fanless 400W

- Betriebssystem

- Windows 10 x64

@orange: Da kann man einstellen was man will. Es funktioniert leider nicht da es kein LLC hat. Hatte am Anfang auch ein UD7 und die gleichen Probleme. Zum Glück hab ich jetzt ein Asus

MusicIsMyLife

Urgestein

- Mitglied seit

- 20.08.2002

- Beiträge

- 3.333

- Desktop System

- Alltagssystem

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASRock B650M PG Riptide

- Kühler

- Watercool Heatkiller IV Pro Copper

- Speicher

- 4x 32 GB G.Skill TridentZ 5 RGB (F5-6000J3040G32X2-TZ5RS)

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- ASUS ROG Swift PG42UQ, Philips BDM4065UC (3840x2160), Samsung C27HG70 (2560x1440)

- SSD

- Micron 9300 Pro 7,68 TB, Samsung 850 Evo 4 TB

- HDD

- keine, SSD only...

- Opt. Laufwerk

- LG CH08LS10 Blu-ray Disc-Player

- Soundkarte

- Creative SoundBlasterX AE-5 Plus

- Gehäuse

- Dimastech BenchTable EasyXL (vorübergehend)

- Netzteil

- MSI MPG A1000G PCIE5

- Keyboard

- ASUS ROG Strix Flare

- Mouse

- SteelSeries Sensei 310

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Internet

- ▼270 MBit ▲45 MBit

Jop hatte das Gigabyte auch schrott, nur schwankungen tauschen lassen gegen Asus Sabortooth stabiles teil, würde es nie wieder hergeben gegen Gigabyte.

Ich habe sowohl mit dem Crosshair V als auch mit dem UD7 Erfahrungen. Und ich kann beim besten Willen nicht erkennen, wo das UD7 "Schrott" sein soll(geschweige denn die Gigabyte-Boards generell). Was manche User hier für eine Art und Weise an den Tag legen, passt auf keine Kuhhaut.

Was dem Gigabyte GA-990FXA-UD7 gegenüber dem ASUS Crosshair V Formula fehlt, sind folgende drei Dinge:

1. LLC

2. eine DDR3-2133-Option

3. die Möglichkeit zur Abschaltung einzelner Kerne/Module

Sowas sind sachliche (und korrekte) Argumente. Die kann jeder nachvollziehen. Und auch wenn diese Optionen (noch) fehlen, so machen sie ein Board noch lange nicht zum "Schrott".

Die Möglichkeit zur Abschaltung einzelner Kerne/Module ist beim neuen Beta-Bios F7g dabei zumindest für das UD5.

freeman303

Enthusiast

Stromverbraucht der aktuellen AM3+ Mainboards

Hallo,

für die AM3 Boards und Phenom, bzw. Athlon X4 gibt es hier im Forum einen schönen Stromspar-Thread, in dem AM3-Mainboards auf ihren Stromverbrauch analysiert wurden und sich letztlich für den AM3-Prozessor zwei Gigabyte und ein Biostar Mainboard als die Stromsparendsten herausgestellt haben.

Ich nutze im Server das dort genannte Biostar Board, welches im Idle tatsächlich saumäßig sparsam ist und trotzdem als einziges ECC RAM tatsächlich unterstützt (auch im Bios), auch mit Tests nachgewiesen (mit einem defekten DIMM und einmal mit deaktivierten und aktiviertem ECC getestet).

Für den AM3+ gibt es solche Informationsquellen noch nicht. Die Boards und der BD sind noch nicht so lange genug auf dem Markt.

Trotzdem wäre es interessant zu wissen, wie der Leistungsverbrauch der typischen BD-Mainboards sich zueinander verhält.

Ich werfe mal die üblichen Verdächtigen ins Rennen:

ASUS Crosshair V Formula

ASUS Sabertooth 990FX

Gigabyte GA-990FXA-xx

MSI 990FXA-GD80

Bisher konnte ich nur herausfinden, dass das Sabertooth ca. 4 Watt weniger im Idle verbrauchen soll als das Crosshair V Formula von ASUS.

Die Suche bei Google gestaltet sich ziemlich nervig, da recht ergebnislos. Vielleicht suche ich auch falsch.

Hat ggf. jemand schon bezüglich der obigen Boards sich nach dem Stromverbrauch der Boards selbst informiert oder kann von einem dieser Boards behaupten, es würde besonders sparsam sein?

Oder ist es vielmehr so, dass diese vier genannten Boards den Stromverbrauch ohnehin nur um +/- 5 Watt beeinflussen können, da sie fast gleichwertig sind?

Gruss

Freeman

Hallo,

für die AM3 Boards und Phenom, bzw. Athlon X4 gibt es hier im Forum einen schönen Stromspar-Thread, in dem AM3-Mainboards auf ihren Stromverbrauch analysiert wurden und sich letztlich für den AM3-Prozessor zwei Gigabyte und ein Biostar Mainboard als die Stromsparendsten herausgestellt haben.

Ich nutze im Server das dort genannte Biostar Board, welches im Idle tatsächlich saumäßig sparsam ist und trotzdem als einziges ECC RAM tatsächlich unterstützt (auch im Bios), auch mit Tests nachgewiesen (mit einem defekten DIMM und einmal mit deaktivierten und aktiviertem ECC getestet).

Für den AM3+ gibt es solche Informationsquellen noch nicht. Die Boards und der BD sind noch nicht so lange genug auf dem Markt.

Trotzdem wäre es interessant zu wissen, wie der Leistungsverbrauch der typischen BD-Mainboards sich zueinander verhält.

Ich werfe mal die üblichen Verdächtigen ins Rennen:

ASUS Crosshair V Formula

ASUS Sabertooth 990FX

Gigabyte GA-990FXA-xx

MSI 990FXA-GD80

Bisher konnte ich nur herausfinden, dass das Sabertooth ca. 4 Watt weniger im Idle verbrauchen soll als das Crosshair V Formula von ASUS.

Die Suche bei Google gestaltet sich ziemlich nervig, da recht ergebnislos. Vielleicht suche ich auch falsch.

Hat ggf. jemand schon bezüglich der obigen Boards sich nach dem Stromverbrauch der Boards selbst informiert oder kann von einem dieser Boards behaupten, es würde besonders sparsam sein?

Oder ist es vielmehr so, dass diese vier genannten Boards den Stromverbrauch ohnehin nur um +/- 5 Watt beeinflussen können, da sie fast gleichwertig sind?

Gruss

Freeman

Mick_Foley

Semiprofi

- Mitglied seit

- 10.02.2008

- Beiträge

- 15.045

Ich bezweifel, dass irgendeins dieser FX-Boards zu den Stromsparwunder gehört, da würde ich einzwei Stufen tiefer gucken.

Ansonsten, drei von deienn Boards haben Sammelthreads:

Mainboard-Sammelthreads - Forum de Luxx

Ansonsten, drei von deienn Boards haben Sammelthreads:

Mainboard-Sammelthreads - Forum de Luxx

smoothwater

Enthusiast

- Mitglied seit

- 18.07.2006

- Beiträge

- 2.600

- Ort

- Halle (Saale)

- Desktop System

- Redeemer

- Laptop

- HP ProBook 445 G8, Ryzen 5600U, 32GB RAM, 500GB SSD, openSUSE Tumbleweed KDE

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- MSI X570 UNIFI

- Kühler

- Noctua NH-D15 Chromax

- Speicher

- 64 GB DDR4-3200 Kingston HyperX Fury

- Grafikprozessor

- AMD Radeon RX 7900 XTX PG OC Edition

- Display

- zwei Dell S2817Q

- SSD

- WD_BLACK SN850X 1TB + Samsung 970 Evo Plus 1 TB

- Opt. Laufwerk

- LG BluRay extern per USB3-Case

- Soundkarte

- onboard

- Gehäuse

- Lian Li O11 Dynamic XL in silber

- Netzteil

- Seasonic Prime TX 750

- Keyboard

- Cherry MX-Board 3.0 (blue Switches)

- Mouse

- Razer Basilisk

- Betriebssystem

- openSUSE Tumbleweed KDE auf SSD 1

- Webbrowser

- Firefox

- Sonstiges

- Asus XG-C100C 10 GBit/s

- Internet

- ▼1 GBit/s ▲200 MBit/s

Wer Strom sparen möchte, ist wohl in der 970-er/990X-er besser beraten, als mit einem vollgestopften 990FX.

Direkt vergleichen kann man die Boards eh nicht, da die AUsstattung doch recht unterschiedlich ist und jeder Hersteller seine Ausrichtung hat. MSI hat im Vergleich der aktuellen Boards weniger Onboardkomponenten als ASUS, Gigabyte ist eher auf Stabilität@Stock getrimmt (meist bissl mehr VCore als andere Boards). Biostar und AsRock streben ja jetzt erstmal richtig nach oben, sodass es für mich noch etwas schwierig ist einzuschätzen, wohin die Richtung gehen soll. Zumindest AsRock hat derzeit recht interessante Boards im 990er Bereich, wenn die mir auch designseitig nicht zusagen.

Direkt vergleichen kann man die Boards eh nicht, da die AUsstattung doch recht unterschiedlich ist und jeder Hersteller seine Ausrichtung hat. MSI hat im Vergleich der aktuellen Boards weniger Onboardkomponenten als ASUS, Gigabyte ist eher auf Stabilität@Stock getrimmt (meist bissl mehr VCore als andere Boards). Biostar und AsRock streben ja jetzt erstmal richtig nach oben, sodass es für mich noch etwas schwierig ist einzuschätzen, wohin die Richtung gehen soll. Zumindest AsRock hat derzeit recht interessante Boards im 990er Bereich, wenn die mir auch designseitig nicht zusagen.

Unrockstar

Enthusiast

- Mitglied seit

- 16.01.2005

- Beiträge

- 2.763

- Desktop System

- Haupt_PC

- Details zu meinem Desktop

- Prozessor

- 5700X

- Mainboard

- MSI X470 Gaming Plus Max

- Kühler

- Arctic Freezer 2 240

- Speicher

- Crucial Ballistix Sport 32GB DDR 3200

- Grafikprozessor

- EVGA 3060Ti

- Display

- HP Envy 32

- SSD

- PNY 1TB M.2 SSD, Crucial MX300 500GB (Div SSD)

- Soundkarte

- Steinberg UR22 MK2

- Gehäuse

- Fractal Define R5

- Netzteil

- Corsair TX550M

- Keyboard

- Corsair Strafe RGB

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Chrome

- Internet

- ▼100Mbit ▲19Mbit

Naja im Vergleich zu den alten AsRock Abfall sind diese Boards genau das was der Kunde braucht. Innovatives zum kleinen preis.. Wenn man nen Bulli möglichst günstig befeuern will, dann würde ich vllt auf einen 880g oder wie schon gesagt nen 970 setzen, der 990FX dürfte wie der 990X verdammt viel verbraten

Ausserdem bekommt du nen gutes 880g Mainboard auch schon ab 60€, laut c't sind diese auch nochn ticken Sparsamer als die 970er Bretter. Also vllt auch mal die fühler dahin strecken, denn wenn du nen Schnäppchen ergatterst, haben diese Boards durchaus Daseinsberechtigung. Finger weg von 760g und sonem Schrott ^^

Ausserdem bekommt du nen gutes 880g Mainboard auch schon ab 60€, laut c't sind diese auch nochn ticken Sparsamer als die 970er Bretter. Also vllt auch mal die fühler dahin strecken, denn wenn du nen Schnäppchen ergatterst, haben diese Boards durchaus Daseinsberechtigung. Finger weg von 760g und sonem Schrott ^^

Himaru

Semiprofi

- Mitglied seit

- 02.01.2009

- Beiträge

- 1.600

Wobei man dann allerdings auf HT 3.1 verzichtet. B.t.w., hat da eigentlich irgendjemand schon mal herausgefunden, ob das einen spürbaren Performancezuwachs ergibt? Ich habe schon überall gesucht, aber da hat sich irgendwie noch keiner mit beschäftigt.

freeman303

Enthusiast

@Mick_Foley & smoothwater:

Problem ist, ich benötige ein Board mit integrierter DVI-Grafik und 3x PCIe 16x Steckplätzen (min. 8x + 4x + 4x). Oder ein Board ohne ingegrierter DVI-Grafik und dafür zusätzlichem einem PCIe x1 bis x16 wohin ich eine sparsame DVI-Grafikkarte einstecken kann.

Die erst genannten drei PCIe Slots benötige ich für Raid-Controller, Intel Quad-NIC und Infiniband-Controller.

Freeman

Problem ist, ich benötige ein Board mit integrierter DVI-Grafik und 3x PCIe 16x Steckplätzen (min. 8x + 4x + 4x). Oder ein Board ohne ingegrierter DVI-Grafik und dafür zusätzlichem einem PCIe x1 bis x16 wohin ich eine sparsame DVI-Grafikkarte einstecken kann.

Die erst genannten drei PCIe Slots benötige ich für Raid-Controller, Intel Quad-NIC und Infiniband-Controller.

Freeman

Mick_Foley

Semiprofi

- Mitglied seit

- 10.02.2008

- Beiträge

- 15.045

Die FX990 Boards haben keine intigrierte GPU.  Da solltest du sowas nehmen:

Da solltest du sowas nehmen:

ASRock > Products > 880G Extreme3

Da solltest du sowas nehmen:

Da solltest du sowas nehmen:ASRock > Products > 880G Extreme3

Offenbar sind aber die Boards doch ziemlich unschuldig. Zambezi hat vielmehr offenbar mit problematischen Leckströmen zu kämpfen und ist deshalb ziemlich problematisch vom Stromverbrauch her:

AMD FX - Die Zweite... - Prozessoren - Planet 3DNow! Forum

Daher der hohe Stromverbrauch auch bei relativ niedrigen Spannungen. Entweder gibts Exemplare mit hohen Spannungen und relativ schlechter Taktbarkeit oder eben welche mit niedrigen Spannungen und sauschlechter Wärmeeffizienz. Da Vishera erst in frühestens 8 Monaten erwartet werden kann, denke ich nun doch, dass es noch eine Rev.C geben wird, die dieses Problem lösen könnte. Eventuell kann man garnicht auf Ultra-LowK verzichten langfristig. Man merkt der CPU eben leider an allen Ecken und Enden an, dass er erst Rev.B ist - sehr langsame Caches, problermatisch platzierte Leiterbahnen, evtl ungünstige Hotspots in der FPU usw. Löst man all diese Probleme gibts mMn ein Taktfeuerwerk.

Mit der Leckströme-Begründung sind beide Tabellen schlüssig.

AMD FX - Die Zweite... - Prozessoren - Planet 3DNow! Forum

Daher der hohe Stromverbrauch auch bei relativ niedrigen Spannungen. Entweder gibts Exemplare mit hohen Spannungen und relativ schlechter Taktbarkeit oder eben welche mit niedrigen Spannungen und sauschlechter Wärmeeffizienz. Da Vishera erst in frühestens 8 Monaten erwartet werden kann, denke ich nun doch, dass es noch eine Rev.C geben wird, die dieses Problem lösen könnte. Eventuell kann man garnicht auf Ultra-LowK verzichten langfristig. Man merkt der CPU eben leider an allen Ecken und Enden an, dass er erst Rev.B ist - sehr langsame Caches, problermatisch platzierte Leiterbahnen, evtl ungünstige Hotspots in der FPU usw. Löst man all diese Probleme gibts mMn ein Taktfeuerwerk.

Wenn das für dich normal ist, dann hast du andere Ansprüche an ein 150€ Brett als ich.

Für mich wäre eher das normal:

Leider wird sich daran auch höchstwahrscheinlich nichts ändern, da es nicht möglich ist LLC nachträglich zu implementieren. Das Problem wird wohl erst mit den nächsten Boardrevisionen behoben.

Mit der Leckströme-Begründung sind beide Tabellen schlüssig.

Zuletzt bearbeitet:

Mick_Foley

Semiprofi

- Mitglied seit

- 10.02.2008

- Beiträge

- 15.045

Naja trotzdem werden die dicken Boards mehr verbrauchen als die kleinen, darum ging es ja gerade.  Ansonsten dürftest du recht haben.

Ansonsten dürftest du recht haben.

Ansonsten dürftest du recht haben.

Ansonsten dürftest du recht haben.

Naja trotzdem werden die dicken Boards mehr verbrauchen als die kleinen, darum ging es ja gerade.Ansonsten dürftest du recht haben.

Das sicher, der 65nm-Chipsatz hat ja mehr Verbrauch und die zig Zusatzchips ebenfalls. Vielleicht wird man beim 1090FX eine Besserung sehen, da dort ja keine Zusatz-SATA und USB3-Chips mehr benötigt werden (8 native SATA3-Ports und 4 USB3-Ports). Auf Firewire verzichten ja viele (zum Glück) mittlerweile wieder viele.

Zuletzt bearbeitet:

- Mitglied seit

- 26.01.2009

- Beiträge

- 1.615

[...]

Mit der Leckströme-Begründung sind beide Tabellen schlüssig.

Nicht ganz.

Meine Ergebnisse sind auch mit einem Thuban entstanden.

Mittlerweile ist ein neues Beta Bios erschienen. Hier wurde die Option "APM Master Mode" integriert.

Beim Bulli sorgt es dafür, dass die VCore- und Taktsprünge geringer werden. Mein x6 zeigt sich aber leider völlig unbeeindruckt.

merry Xmas

AMD plant Phenom II X8? -mit Bulldozer-Architektur, für am3+ Boards- (ohne Turbo-Core-Funktion, günstiger Preis)

Phenom II X8 3020 mit 3,00GHz Takt und 125 Watt Verlustleistung

Phenom II X8 2820 mit 2,80 GHz Takt und 95 Watt Verlustleistung

Phenom II X8 2520 mit 2,50 GHz Takt und 95 Watt Verlustleistung

Phenom II X8 2420 mit 2,40 GHz Takt und 95 Watt Verlustleistung

AMD plant Phenom II X8? - News Hartware.net

jetway HA18 cpu support -unten-

Zuletzt bearbeitet:

- Mitglied seit

- 17.02.2009

- Beiträge

- 19.427

- Desktop System

- A4-SFX No.20 "End of the Line"; Idle: 21W | Load: 280-320W

- Laptop

- Lenovo Yoga 7 [2022, Ryzen 6800U]

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7745HX @100W cTDP

- Mainboard

- Minisforum BD770i (UEFI 1.09)

- Kühler

- Integriert, Top-Blower, 4 Heatpipes. [Arctic P12 Slim PWM]

- Speicher

- 2*16Gb Corsair Vengeance DDR5 SO-DIMM 5600 CL48 @6000 CL38

- Grafikprozessor

- Inno3D GeForce RTX 4070 Ti SUPER X3 OC

- Display

- HP Omen 32q [Version 2023]

- SSD

- Corsair MP700 PCIe 5.0 NVMe 2Tb [Win 11 Pro] | MP600 Core XT PCIe 4.0 2Tb [CachyOS]

- HDD

- Ext. USB 3.2 [Crucial P3 Plus SSD 2TB M.2 PCIe Gen4 NVMe]

- Soundkarte

- Edifier M60 @USB; Anker Soundcore H30i @BT

- Gehäuse

- DAN Cases A4-SFX V4.1 Silber [2* Noctua NF-A9x14 PWM im Boden, ausblasend]

- Netzteil

- Corsair SF750 Platinum [Custom Cables by CablesterCustom]

- Keyboard

- Logitech MX Keys S

- Mouse

- Logitech MX Master 3S

- Betriebssystem

- Windows 11 Pro | CachyOS

- Webbrowser

- Mozilla Firefox (64-Bit)

- Internet

- ▼180 ▲45

Klingt nett

gesendet von meinem Defy CM 2.3.7 via HardwareLuxx App

gesendet von meinem Defy CM 2.3.7 via HardwareLuxx App

Ähnliche Themen

- Antworten

- 7

- Aufrufe

- 649