Ich hab mir das Brett auch schon angeschaut, bin aber noch nicht 100% schlau draus.

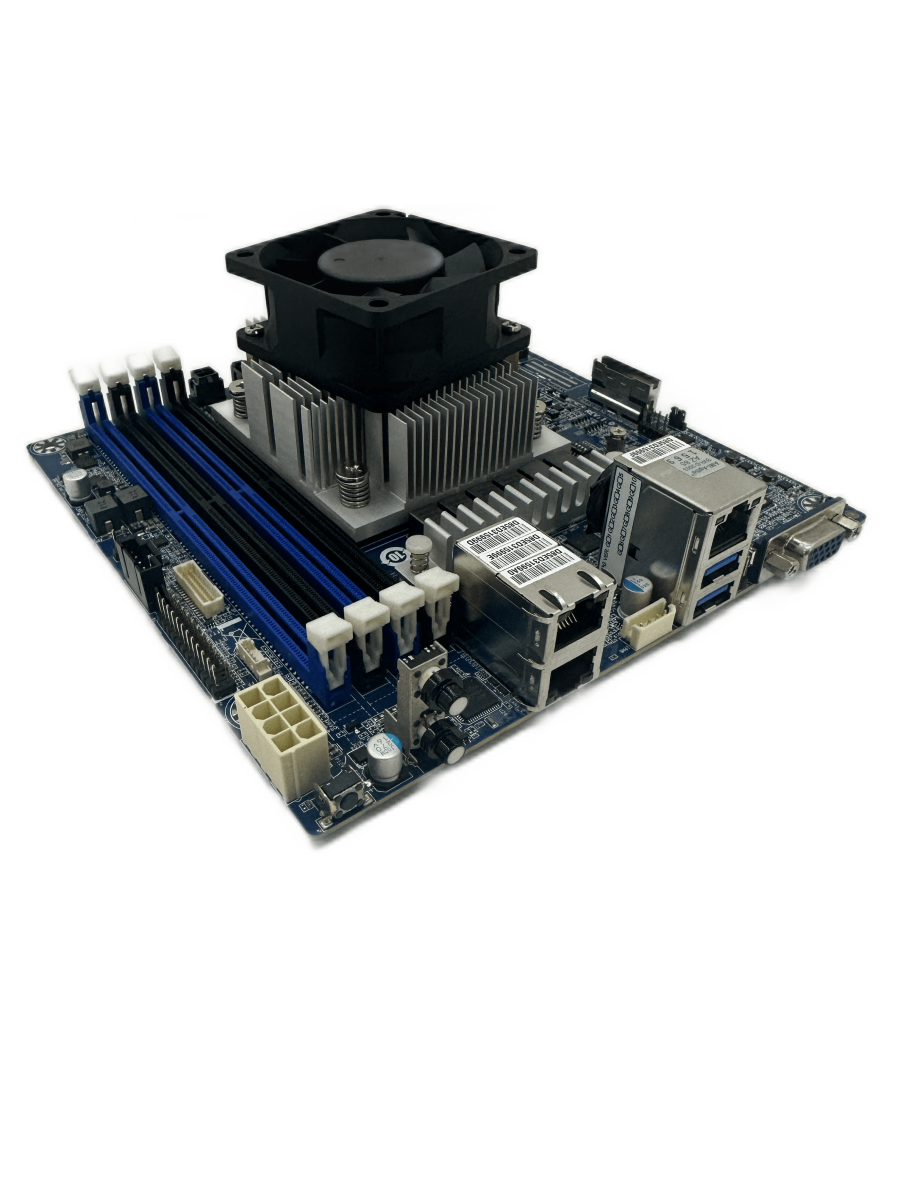

Des sind 4x SATA am Brett und 1x SlimSAS, oder?

Also könntest du jetzt 8x SATA bekommen oder 4x SATA und 4x PCIe über irgend einen dubiosen SFF-PCIe Adapter deiner Wahl vom Chinamann, oder?

Für 8x SATA und PCIe für die NIC bräuchtest du doch 2x SlimSAS am Brett, oder? Sind da 2 und ich seh sie nicht?

Was evtl. auch ginge wäre nen HBA an den SlimSAS machen für mehr SATA und ne NIC auf den M.2? Auch Adapterhölle.

Eig. schade drum, aber wenn alle SATA voll sind, muss ja wohl

.. Machst es dann so, dass dus "unsachgemäß" installierst und den Datenträger "teilst", damit du ihn auch als Laufwerk für die "Apps" verwenden kannst unter TrueNAS? Urbackup etc.? Oder verwendest da gar nix?

Joa, DE Preise sind fies, auf ebay aus CN bekommst um zu 2 davon nen neuen HBA gartis dazu ^^... ja ne, kann man kaufen, ich mag diese hellblauen Kabel, hab die in SATA-SATA Ausführung als auch in SFF-SATA Ausführung. Finde die für unseren Heimgebrauch äußerst praktisch.

Case&PSU: Hab ich mir nie genauer angesehen. k.A. was die Case im verlinkten Thread können, habs nur überflogen. Mir hätte das "große" gefallen, werd aber die Finger sein lasse, weiterhin meinen Gebrauchtkram nehmen und mal auf 19" gehen. Zum PSU kann ich nix sagen, musst dir selbst raussuchen, gibt ja zum Glück schon massenhaft Messergebnisse, sonst robotR fragen, ob er ein gutes SFX im Kopf hat.

.. Machst es dann so, dass dus "unsachgemäß" installierst und den Datenträger "teilst", damit du ihn auch als Laufwerk für die "Apps" verwenden kannst unter TrueNAS? Urbackup etc.? Oder verwendest da gar nix?

.. Machst es dann so, dass dus "unsachgemäß" installierst und den Datenträger "teilst", damit du ihn auch als Laufwerk für die "Apps" verwenden kannst unter TrueNAS? Urbackup etc.? Oder verwendest da gar nix?