DunklerRabe

Enthusiast

- Mitglied seit

- 01.05.2010

- Beiträge

- 2.294

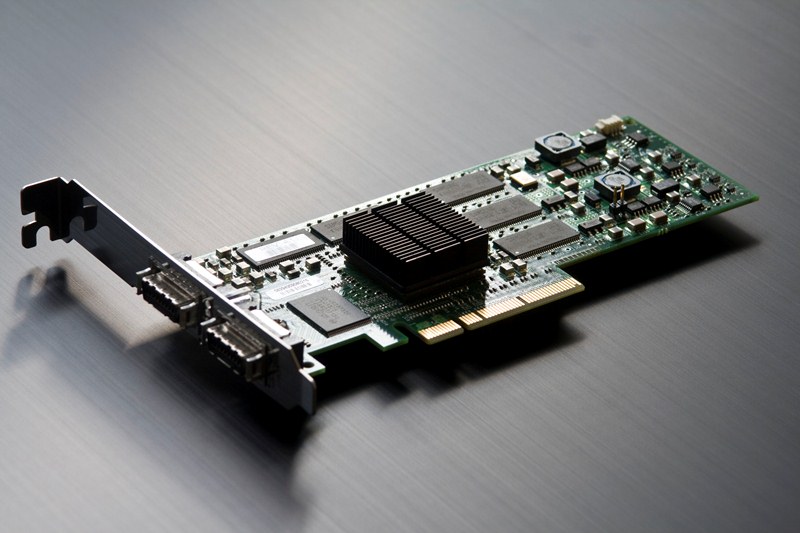

HP baut ja keine eigene Hardware in dem Sinne was das Zubehör usw. angeht, daher gehe ich auch davon aus, dass es sich um diese oder eine ähnliche Karte handelt.

Bei den Netzwerkkarten von HP hab ich jedoch die Erfahrung gemacht, dass die originalen Herstellertreiber (Intel) für das Basismodell nicht immer für HPs OEM Karten funktionieren. Inwiefern das für die IB Karten gilt kann ich nicht sagen.

Bei den Netzwerkkarten von HP hab ich jedoch die Erfahrung gemacht, dass die originalen Herstellertreiber (Intel) für das Basismodell nicht immer für HPs OEM Karten funktionieren. Inwiefern das für die IB Karten gilt kann ich nicht sagen.

Aber leider noch immer nichts für OSx

Aber leider noch immer nichts für OSx