Auch nur Kopfsache ^^ Pack nen Wasserkühler drauf und das Teil ist eh extremst winzig. Verliert sich sogar bei mir im Gehäuse.Ja, es geht ja nicht allein um das Design, zumal ich mir das innere auch nicht mehr anschauen kann...aber ich weiss, dass ich da kein Monster drin hab, ist halt Kopfsache nebst Platzeinsparung

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Ab 899 Euro: NVIDIA stellt die GeForce RTX 4070 Ti offiziell vor

- Ersteller HWL News Bot

- Erstellt am

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Ja innerhalb 2 Jahren die uvps fast zu verdoppeln ist schon geilWas laberst du denn?Es gab mal Zeiten da hat ne Geforce 2Ultra zum Release ne UVP von 500Dollar gehabt und die Karten waren kaum unter 1200DM zu bekommen, jetzt kannst ja mal 22 Jahre Inflation drauf rechen. Kennste noch die 6800Ultra? auch ne UVP von 500Dollar und im Euroraum knapp 600€ zum Release, rechne da mal 17 Jahre Inflation drauf. All das Sind Preise die "ähnlich" derer heute sind. Wenn man von einer Bereinigten inflation von "NUR" 3% ausgeht, kostete die GF2Ultra dann heutige 1150€ und die 6800U 971€...n Alles andere als halb so teuer....

Inflation 10% sind keine 100%

Inflation 10% sind keine 100%

BigLA

Urgestein

- Mitglied seit

- 14.06.2001

- Beiträge

- 4.733

- Ort

- Bochum

- Desktop System

- 4ever

- Laptop

- Asus 15,6", core i3 370M, 4GB, 250GB SSD ;)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 5600

- Mainboard

- Asus ROG Strix B550-XE Gaming Wifi

- Kühler

- be quiet Pure Rock 2 Black-AM4

- Speicher

- 32GB (2x16GB) Crucial Ballistix DDR4-3600 CL16 RGB red

- Grafikprozessor

- nVidia GeForce RTX 3060ti Founders

- Display

- iiyama ProLite XB3270QS-B1 31,5"

- SSD

- *neu*1TB WD SN850X OS, 1TB Lexar 710@PCIe4x4-Karte, 1TB Kioxia EXCERIA G2 Data

- HDD

- 1TB Seagate Ironwolf (offline/Backup)

- Opt. Laufwerk

- Ich habe losgelassen... extern :D

- Soundkarte

- ALC 1220A Asus

- Gehäuse

- Jonsbo U4 Silber

- Netzteil

- be quiet 650 Watt Straight Power Platinum

- Keyboard

- Cherry Stream

- Mouse

- Logitech MX Anywhere, Cherry Gentix 4k, HP Travel BT

- Betriebssystem

- Win11 Pro

- Webbrowser

- alle

- Sonstiges

- HP Drucker DJ 3050 (noch in schwarz!)

Ohne zu sehr abzudriften, aber ne, ich bin trocken  und bleibe es auch, das wäre mir zuviel Aufwand

und bleibe es auch, das wäre mir zuviel Aufwand

Aber die schnuckelige 3060ti ist ja eh erstmal außerhalb jeglicher Diskussion... die kleine niedliche die ...

und bleibe es auch, das wäre mir zuviel Aufwand

und bleibe es auch, das wäre mir zuviel Aufwand

Aber die schnuckelige 3060ti ist ja eh erstmal außerhalb jeglicher Diskussion... die kleine niedliche die ...

SchneeLeopard

Legende

Laut nVidia, allerdings bezweifel ich das, denn selbst eine RTX 4080 ist "nur" ca. 50% schneller als eine RTX 3090 mit oder ohne Ti unter Raytracing.Laut nVidia ist die 4070 Ti bis zu drei mal schneller als die 3090 und ohne DLSS3 gehört die eh zum Alteisen.

Benchmarks: Cyberpunk 2077 (Raytracing) - Seite 9 - Hardwareluxx

GeForce RTX 4080 Partner-Designs: Karten von ASUS, INNO3D, Gigabyte und MSI im Test.

Und selbst ohne Raytracing ist die 4080 gerade mal nur max. 20% schneller.

Benchmarks: Shadow of the Tomb Raider - Seite 13 - Hardwareluxx

GeForce RTX 4080 Partner-Designs: Karten von ASUS, INNO3D, Gigabyte und MSI im Test.

Das mit 3x so schnell wird also nicht hinkommen.

Dazu kommen gestiegene Fertigungskosten (je kleiner der Node desto teurer wird es, zudem bedient sich Nvidia eines Custom Nodes und nicht bloß einfach der Standardkost) samt dazugehöriger natürlich gestiegener Forschungskosten, gestiegene Transportkosten, gestiegene Rohstoffpreise ect. ect. Da ist nicht nur Inflation im Spiel... Die ist nur das i Tüpfelchen... Das eine Semester BWL das ich hatte, hat mir sehr geholfen zu verstehen wie solche Preise zustande kommen und bringe daher dann doch etwas Verständnis dafür mitJa innerhalb 2 Jahren die uvps fast zu verdoppeln ist schon geilInflation 10% sind keine 100%

Zumal die UVP der Vorgängergeneration (Ampere) teilweise sogar niedriger war als die der Gen (Turing) davor. Ampere war preislich (UVP nicht Realpreise) ein Ausnahmefall und würde ich nur bedingt als Vergleich hernehmen.

Zumal die UVP der Vorgängergeneration (Ampere) teilweise sogar niedriger war als die der Gen (Turing) davor. Ampere war preislich (UVP nicht Realpreise) ein Ausnahmefall und würde ich nur bedingt als Vergleich hernehmen.xXx-Eagleone-xXx

Legende

- Mitglied seit

- 05.01.2005

- Beiträge

- 11.132

- Ort

- Nähe Köln/Bonn

- Desktop System

- kanister-mister

- Details zu meinem Desktop

- Prozessor

- AMD-Ryzen-3900X @ +200mhz PBO

- Mainboard

- Gigabyte-B550-GAMING-X

- Kühler

- EKWB-CPU und EKWB-Fullcover Graka

- Speicher

- 32GB-GSkill-Ripjaws-DDR4-3600 @ 15-14-15

- Grafikprozessor

- Referenz-AMD-RX6800-16GB @2,6Ghz

- Display

- Samsung-Odyssey-G5-C34G55T @ 165hz

- SSD

- 3x1000GB-Crucial-MX500, 3x1000GB-Samsung-QVO860

- HDD

- ---

- Opt. Laufwerk

- ---

- Soundkarte

- Onboard

- Gehäuse

- Corsair 4000D Airflow

- Netzteil

- 850W Enermax Revolution D.P.

- Keyboard

- Havit Mechanisch

- Mouse

- Logitech MX518 - Refresh

- Betriebssystem

- Windows-11-Prof

- Webbrowser

- Google-Chrome

- Internet

- ▼100 Mbit ▲40 Mbit

Also du redest von früher und kommst dann mit der letzten Generation, was nun? Aber egal, ich wollte nur sagen ob dass Preise wie jetzt schon sehr oft vorgekommen sind und sicherlich nichts mega ungewöhnliches sind.Ja innerhalb 2 Jahren die uvps fast zu verdoppeln ist schon geilInflation 10% sind keine 100%

Natürlich ist ne UVP Verdoppelung nicht schön, aber wenn man mal für die Hersteller die gestiegen Produktionskosten ansieht, ist das auch deutlich mehr als 10% der Inflation. Das müssen die weiter geben, dann kommen ja wegen der Lage noch Lohnerhöhung zu und all das wird weiter gegeben an uns.

Ich will damit auch nicht schönreden, dass sich etwas mehr in die eigene Tasche gewirtschaftet wird, aber ganz so dramatisch ist es nicht, wie viele behaupten...

Grüße

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Wow bis zu 3x schneller dann musst du Sie dir kaufenLaut nVidia ist die 4070 Ti bis zu drei mal schneller als die 3090 und ohne DLSS3 gehört die eh zum Alteisen.

und exklusives dlss 3.0 hat Sie auch noch. Für solche Käufer sind die nvidia Folien wirklich klasse

und exklusives dlss 3.0 hat Sie auch noch. Für solche Käufer sind die nvidia Folien wirklich klasse

Beitrag automatisch zusammengeführt:

Höhere Fertigungskosten und Materialkosten bei einem halb so großen Chip? Wenn du in bwl aufgepasst hast ist dir ja bekannt was dann günstiger istDazu kommen gestiegene Fertigungskosten (je kleiner der Node desto teurer wird es, zudem bedient sich Nvidia eines Custom Nodes und nicht bloß einfach der Standardkost) samt dazugehöriger natürlich gestiegener Forschungskosten, gestiegene Transportkosten, gestiegene Rohstoffpreise ect. ect. Da ist nicht nur Inflation im Spiel... Die ist nur das i Tüpfelchen... Das eine Semester BWL das ich hatte, hat mir sehr geholfen zu verstehen wie solche Preise zustande kommen und bringe daher dann doch etwas Verständnis dafür mitZumal die UVP der Vorgängergeneration (Ampere) teilweise sogar niedriger war als die der Gen (Turing) davor. Ampere war preislich (UVP nicht Realpreise) ein Ausnahmefall und würde ich nur bedingt als Vergleich hernehmen.

Rede dir nicht alles schön

Anhänge

Zuletzt bearbeitet:

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.474

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

Und wenn du aufgepasst hättest würdest du den Unterschied von Früher zu Heute kennen:Wow bis zu 3x schneller dann musst du Sie dir kaufenund exklusives dlss 3.0 hat Sie auch noch. Für solche Käufer sind die nvidia Folien wirklich klasse

Beitrag automatisch zusammengeführt:

Höhere Fertigungskosten und Materialkosten bei einem halb so großen Chip? Wenn du in bwl aufgepasst hast ist dir ja bekannt was dann günstiger ist

Rede dir nicht alles schön

Dir ist bewusst dass aktuelle Belichtungen und Verringerung der Chipfläche extrem kostspielig sind. Allein schon in Forschung und Entwicklung? Dann noch die extrem teuren Techniken für die Belichtung?

Ach was rede ich, kleiner und weniger Material muss billiger sein.

Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Früher war doch alles besserUnd wenn du aufgepasst hättest würdest du den Unterschied von Früher zu Heute kennen:

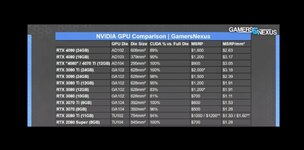

Anhang anzeigen 836162

für dich habe ich die aktuellen Chipgrößen extra vergrößert

für dich habe ich die aktuellen Chipgrößen extra vergrößertVielleicht fällt dir dann etwas auf

Anhänge

Es ist nun mal so je komplexer eine Fertigung ist (und sie ist komplexer je kleiner es wird - das ist quasi als Fakt zu sehen) umso teurer wird es, weil da auch andere (teurere und bestimmt nicht wartungsärmere) Gerätschaften arbeiten und nicht die Urgesteine die noch heutzutage simple 14, 16, 20nm aufwärts Chips herstellen die quasi schon Betriebssteuerlich abgeschrieben sind und nur mehr Gewinn abwerfen. Die Chipgröße hat wenig damit zu tun wie teuer der sein "darf". Wenn ich jetzt Chipgröße anhand von Transistoren vergleiche hätte ich zwischen 4080 und 3080 ca. 66% der Chipfläche aber etwas über 38% mehr Transistoren. Auf einmal ist der neue Chip "größer"Höhere Fertigungskosten bei einem halb so großen Chip? Rede dir nicht alles schön

Fagus

Enthusiast

- Mitglied seit

- 31.10.2011

- Beiträge

- 640

Wie kommt man eigentlich auf die Rechnung, dass umso kleiner der Chip umso geringer die Kosten für die Fertigung sind? Hat dafür jemand eine Quellen-Angabe? Ist das nicht eher eine Milchmädchenrechnung? Wenn ich das richtig verstanden habe, ist doch eher so: Umso kleiner der Chip, umso höher die Wafer-Kosten:

www.pcgameshardware.de

www.pcgameshardware.de

TSMCs 3 nm: Höhere Preise bei GPUs und iPhone 15 durch steigende Wafer-Preise

Der Preis für TSMCs Wafer soll einen neuen Höchststand erreicht haben. Das wirkt sich auf kommende Produkte, wie Grafikkarten und das iPhone 15 aus.

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.474

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

Ja, mir fällt auf dass du augenscheinlich keine Ahnung hast wovon du redest. Das ist aber auch alles!Früher war doch alles besserfür dich habe ich die aktuellen Chipgrößen extra vergrößert

Vielleicht fällt dir dann etwas auf

Gurkengraeber

Legende

- Mitglied seit

- 10.03.2005

- Beiträge

- 11.421

- Ort

- Düsseldorf

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-12700K

- Mainboard

- Asus Prime Z690-A

- Kühler

- Alpenföhn Gletscherwasser White 280

- Speicher

- 48GB G.Skill Trident Z5 RGB white DDR5-7600 CL38 @ 6800MT/s

- Grafikprozessor

- Gigabyte GeForce RTX 4090 Aero OC

- Display

- Samsung Odyssey G7A LS28AG700NUXEN

- SSD

- M.2 1TB Crucial P5 & M.2 2TB Samsung Evo 970 Plus

- Gehäuse

- NZXT H7 Flow White

- Netzteil

- Seasonic Prime PX-850

- Betriebssystem

- Windows 11 Pro

Wo sind denn nun die Reviews? Fiel das NDA nicht um 00:00 Uhr? Immer dieses hinhalten...

BigLA

Urgestein

- Mitglied seit

- 14.06.2001

- Beiträge

- 4.733

- Ort

- Bochum

- Desktop System

- 4ever

- Laptop

- Asus 15,6", core i3 370M, 4GB, 250GB SSD ;)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 5600

- Mainboard

- Asus ROG Strix B550-XE Gaming Wifi

- Kühler

- be quiet Pure Rock 2 Black-AM4

- Speicher

- 32GB (2x16GB) Crucial Ballistix DDR4-3600 CL16 RGB red

- Grafikprozessor

- nVidia GeForce RTX 3060ti Founders

- Display

- iiyama ProLite XB3270QS-B1 31,5"

- SSD

- *neu*1TB WD SN850X OS, 1TB Lexar 710@PCIe4x4-Karte, 1TB Kioxia EXCERIA G2 Data

- HDD

- 1TB Seagate Ironwolf (offline/Backup)

- Opt. Laufwerk

- Ich habe losgelassen... extern :D

- Soundkarte

- ALC 1220A Asus

- Gehäuse

- Jonsbo U4 Silber

- Netzteil

- be quiet 650 Watt Straight Power Platinum

- Keyboard

- Cherry Stream

- Mouse

- Logitech MX Anywhere, Cherry Gentix 4k, HP Travel BT

- Betriebssystem

- Win11 Pro

- Webbrowser

- alle

- Sonstiges

- HP Drucker DJ 3050 (noch in schwarz!)

Wie haben es die Hersteller nur geschafft, in den letzten 40 Jahren das ganze Verhältnis im groben trotz kleineren/modernen Fertigungen und trotz steigenden Fertigungskosten in einer moderaten Preissteigerungswelle beizubehalten und was ist plötzlich so extrem anders, dass dieses Prinzip daneben ist? und ich schliesse jetzt mal im Durchschnitt alle Schwankungen und Peaks da mit ein, trotzdem sticht der Preisanstieg der Produkte doch schon größer heraus...

P.S. War es nicht zwischendurch auch so, dass bei kleinerer Fertigung Kosteneinsparung gab, da es mehr "Stück" pro Wafer gab? Dagegen rechnen kann man gern die moderneren Belichtungsmaschinen etc.!? Zumindest hat dieses "balancing" in früheren Zeiten (s.o.) nicht zu so drastischen Schwankungen geführt...

Zumindest hat dieses "balancing" in früheren Zeiten (s.o.) nicht zu so drastischen Schwankungen geführt...

P.S. War es nicht zwischendurch auch so, dass bei kleinerer Fertigung Kosteneinsparung gab, da es mehr "Stück" pro Wafer gab? Dagegen rechnen kann man gern die moderneren Belichtungsmaschinen etc.!?

Zumindest hat dieses "balancing" in früheren Zeiten (s.o.) nicht zu so drastischen Schwankungen geführt...

Zumindest hat dieses "balancing" in früheren Zeiten (s.o.) nicht zu so drastischen Schwankungen geführt...Nuestrass

Banned

- Mitglied seit

- 23.04.2022

- Beiträge

- 2.819

Es ist nun mal so je komplexer eine Fertigung ist (und sie ist komplexer je kleiner es wird - das ist quasi als Fakt zu sehen) umso teurer wird es, weil da auch andere (teurere und bestimmt nicht wartungsärmere) Gerätschaften arbeiten und nicht die Urgesteine die noch heutzutage simple 14, 16, 20nm aufwärts Chips herstellen die quasi schon Betriebssteuerlich abgeschrieben sind und nur mehr Gewinn abwerfen. Die Chipgröße hat wenig damit zu tun wie teuer der sein "darf". Wenn ich jetzt Chipgröße anhand von Transistoren vergleiche hätte ich zwischen 4080 und 3080 ca. 66% der Chipfläche aber etwas über 38% mehr Transistoren. Auf einmal ist der neue Chip "größer"

Ja weshalb war dann die uvp der letzte 5 gpu Generationen ungefähr gleich ? Unglaublich nach deiner Erklärung

- Mitglied seit

- 17.07.2003

- Beiträge

- 4.372

- Ort

- Dresden

- Desktop System

- SecondWorld

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Asus ROG Strix B650E-F

- Kühler

- NZXT Kraken Z73

- Speicher

- 2 x 16 Gb DDR5-6000 CL30 G.Skill Trident Z5 Neo RGB

- Grafikprozessor

- PNY GeForce RTX 4090 XLR8 Gaming Verto Epic-X RGB Overclocked

- Display

- Alienware AW3225QF

- SSD

- Western Digital WD_BLACK SN850X NVMe SSD 2TB + Western Digital WD_BLACK SN850X NVMe SSD 4TB

- Soundkarte

- 2x MINX MIN22 + Topping MX3s, Audeze Maxwell

- Gehäuse

- Thermaltake Core P3 TG Pro schwarz

- Netzteil

- Corsair HX1200 Platinum

- Keyboard

- Keychron K4 V2

- Mouse

- Logitech G Pro X Superlight

- Betriebssystem

- Windows 11

- Webbrowser

- Chrome

- Internet

- ▼1000mBit ▲50Mbit

Das ist echt zu geil. Nvidias Marge fällt von 65%(!) auf 45% und der Konzern kündigt großspurig an, dass man die langfristig projizierte Marge aber werde halten können. Ja wie wohl? Und kann kommen manche hier mit nem Semester BWL um die Ecke weil ja alles teurer wird mit dem Sprit und so.

Ey jetzt mal ernsthaft. Hier wird gemolken was das Zeug hält solange es geht, weil Nvidia einfach ihre alte Marge wieder haben will. Und der Einbruch auf 45% muss erstmal kompensiert werden.

Und AMD ist auch nicht viel besser mit ihrer Preisgestaltung. Die 7900 XT für 999€ Straßenpreis ist auch affig.

Wird sich zeigen ob die Kunden oder Nvidia den längeren Atem hat. Schade, dass Intel noch so verkackt und AMD seine Preise einfach nur an NVidia orientiert.

Ey jetzt mal ernsthaft. Hier wird gemolken was das Zeug hält solange es geht, weil Nvidia einfach ihre alte Marge wieder haben will. Und der Einbruch auf 45% muss erstmal kompensiert werden.

Und AMD ist auch nicht viel besser mit ihrer Preisgestaltung. Die 7900 XT für 999€ Straßenpreis ist auch affig.

Wird sich zeigen ob die Kunden oder Nvidia den längeren Atem hat. Schade, dass Intel noch so verkackt und AMD seine Preise einfach nur an NVidia orientiert.

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.474

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

Das bezweifelt auch gar keiner. Aber die Milchmädchenrechnung von Chipgröße und Material auf Fertigungskosten zu kommen erschließt sich mir nun mal nicht...Wie haben es die Hersteller nur geschafft, in den letzten 40 Jahren das ganze Verhältnis im groben trotz kleineren/modernen Fertigungen und trotz steigenden Fertigungskosten in einer moderaten Preissteigerungswelle beizubehalten und was ist plötzlich so extrem anders, dass dieses Prinzip daneben ist? und ich schliesse jetzt mal im Durchschnitt alle Schwankungen und Peaks da mit ein, trotzdem sticht der Preisanstieg der Produkte doch schon größer heraus...

P.S. War es nicht zwischendurch auch so, dass bei kleinerer Fertigung Kosteneinsparung gab, da es mehr "Stück" pro Wafer gab? Dagegen rechnen kann man gern die moderneren Belichtungsmaschinen etc.!?

Induktor

Enthusiast

- Mitglied seit

- 03.11.2019

- Beiträge

- 3.172

- Laptop

- Lenovo Yoga Pro 7 - Ryzen AI 9 365 - Radeon 880M - 32GB LPDDR5x-7500 - 14,5" OLED (2880*1800) 120Hz - Intel AX210

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen-7 9800X3D (+200/ -42)

- Mainboard

- MSI X870E Carbon Wifi (A3)

- Kühler

- Arctic LF III 280 & 2x Toughfan 14 Pro

- Speicher

- 32GB - 6200 MT/s (CL26-8-36-30 - tRFC 120ns)

- Grafikprozessor

- MSI RTX 4080 Gaming X Trio (Shroud Mod 3x T30 + 400w vBIOS)

- Display

- Alienware AW2725DF (OLED 360Hz)

- SSD

- Samsung 990 Pro & 980 Pro

- Gehäuse

- Open Benchtable V2 (vertikal)

- Netzteil

- Corsair AX850 (Titanium)

- Sonstiges

- Thermal Grizzly AM5 Frame

Worauf sich häufig bezogen wird, sind die yields pro Wafer. Ist der Chip kleiner, passen mehr davon auf einen Wafer und entsprechend sinkt der Preis pro Stück. Forschung und Entwicklung + die Technologie eine kleine Fertigungsgröße zu verwenden, wird dabei häufig außer Acht gelassen.Wie kommt man eigentlich auf die Rechnung, dass umso kleiner der Chip umso geringer die Kosten für die Fertigung sind? Hat dafür jemand eine Quellen-Angabe? Ist das nicht eher eine Milchmädchenrechnung? Wenn ich das richtig verstanden habe, ist doch eher so: Umso kleiner der Chip, umso höher die Wafer-Kosten:

BigLA

Urgestein

- Mitglied seit

- 14.06.2001

- Beiträge

- 4.733

- Ort

- Bochum

- Desktop System

- 4ever

- Laptop

- Asus 15,6", core i3 370M, 4GB, 250GB SSD ;)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 5600

- Mainboard

- Asus ROG Strix B550-XE Gaming Wifi

- Kühler

- be quiet Pure Rock 2 Black-AM4

- Speicher

- 32GB (2x16GB) Crucial Ballistix DDR4-3600 CL16 RGB red

- Grafikprozessor

- nVidia GeForce RTX 3060ti Founders

- Display

- iiyama ProLite XB3270QS-B1 31,5"

- SSD

- *neu*1TB WD SN850X OS, 1TB Lexar 710@PCIe4x4-Karte, 1TB Kioxia EXCERIA G2 Data

- HDD

- 1TB Seagate Ironwolf (offline/Backup)

- Opt. Laufwerk

- Ich habe losgelassen... extern :D

- Soundkarte

- ALC 1220A Asus

- Gehäuse

- Jonsbo U4 Silber

- Netzteil

- be quiet 650 Watt Straight Power Platinum

- Keyboard

- Cherry Stream

- Mouse

- Logitech MX Anywhere, Cherry Gentix 4k, HP Travel BT

- Betriebssystem

- Win11 Pro

- Webbrowser

- alle

- Sonstiges

- HP Drucker DJ 3050 (noch in schwarz!)

Den letzten Satz verstehe ich nicht so ganz, denn "Material" und Chipgröße sind doch Teil der Fertigungskosten, diese Variablen sind doch nebst Produktionsmaschinen und Lohnkosten essentieller Bestandteil dieser!? oder verstehe ich die Aussage falsch?

War auf @Tremendous bezogen...

War auf @Tremendous bezogen...

Oder TSMC das für seine Chips verlangt was sie nun mal nach Ansicht von TSMC kosten sollen ist noch keinem in den Sinn gekommen? Würden NVidia und AMD überhaupt billiger verkaufen können? Das AMD bei seinem Kühler gespart und NVidia nicht Unsummen für Adapter ausgibt wissen wir ja mittlerweile.und AMD seine Preise einfach nur an NVidia orientiert.

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.474

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

D

Ob ich nun 2g Silizium habe oder 5g ist nicht der Kostentreiber. Der Kostentreiber ist die Belichtungstechnik und wieviel ich aus der Fläche dann rausholen kann. Und da kommen die Kosten zu Stande. Dann was noch alles um den Nacktchip konzipiert und angehangen werden muss. Der Materialwert der Rohstoffe ist völlig unerheblich, allein was man aus den Rohstoffen macht kostet den Hersteller...Den letzten Satz verstehe ich nicht so ganz, denn "Material" und Chipgröße sind doch Teil der Fertigungskosten, diese Variablen sind doch nebst Produktionsmaschinen und Lohnkosten essentieller Bestandteil dieser!? oder verstehe ich die Aussage falsch?

War auf @Tremendous bezogen...

- Mitglied seit

- 17.07.2003

- Beiträge

- 4.372

- Ort

- Dresden

- Desktop System

- SecondWorld

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Asus ROG Strix B650E-F

- Kühler

- NZXT Kraken Z73

- Speicher

- 2 x 16 Gb DDR5-6000 CL30 G.Skill Trident Z5 Neo RGB

- Grafikprozessor

- PNY GeForce RTX 4090 XLR8 Gaming Verto Epic-X RGB Overclocked

- Display

- Alienware AW3225QF

- SSD

- Western Digital WD_BLACK SN850X NVMe SSD 2TB + Western Digital WD_BLACK SN850X NVMe SSD 4TB

- Soundkarte

- 2x MINX MIN22 + Topping MX3s, Audeze Maxwell

- Gehäuse

- Thermaltake Core P3 TG Pro schwarz

- Netzteil

- Corsair HX1200 Platinum

- Keyboard

- Keychron K4 V2

- Mouse

- Logitech G Pro X Superlight

- Betriebssystem

- Windows 11

- Webbrowser

- Chrome

- Internet

- ▼1000mBit ▲50Mbit

Schau dir bitte den Screenshot von dem User mit der Die-Größe an. Das ist schon sehr aufschlussreich.Oder TSMC das für seine Chips verlangt was sie nun mal nach Ansicht von TSMC kosten sollen ist noch keinem in den Sinn gekommen? Würden NVidia und AMD überhaupt billiger verkaufen können? Das AMD bei seinem Kühler gespart und NVidia nicht Unsummen für Adapter ausgibt wissen wir ja mittlerweile.

Ein über 600mm² Monsterchip als Haloprodukt kostet mit fetter Marge 1600$ UVP. Oder glaubst du Nvidia verkauft die 4090 mit Verlust? Einen guten 600mm² Chip zu produzieren ist TEUER. Und das Ding ist nichtmal Vollausbau.

Und jetzt schaut man mal auf die 4080. Was fällt da auf?

Induktor

Enthusiast

- Mitglied seit

- 03.11.2019

- Beiträge

- 3.172

- Laptop

- Lenovo Yoga Pro 7 - Ryzen AI 9 365 - Radeon 880M - 32GB LPDDR5x-7500 - 14,5" OLED (2880*1800) 120Hz - Intel AX210

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen-7 9800X3D (+200/ -42)

- Mainboard

- MSI X870E Carbon Wifi (A3)

- Kühler

- Arctic LF III 280 & 2x Toughfan 14 Pro

- Speicher

- 32GB - 6200 MT/s (CL26-8-36-30 - tRFC 120ns)

- Grafikprozessor

- MSI RTX 4080 Gaming X Trio (Shroud Mod 3x T30 + 400w vBIOS)

- Display

- Alienware AW2725DF (OLED 360Hz)

- SSD

- Samsung 990 Pro & 980 Pro

- Gehäuse

- Open Benchtable V2 (vertikal)

- Netzteil

- Corsair AX850 (Titanium)

- Sonstiges

- Thermal Grizzly AM5 Frame

Gibt es für diese Behauptung auch eine Quelle? Laut verschiedenen Quellen ist die Software drumherum der größte Kostentreiber:Der Kostentreiber ist die Belichtungstechnik

Selbst bei einem Artikel aus 2014 sah das nicht anders aus.

Zeitmangel

Experte

- Mitglied seit

- 23.08.2020

- Beiträge

- 3.050

Macht so eine GPU mittlerweile 96% des Preises einer Graka?Dazu kommen gestiegene Fertigungskosten

Custom hier und custom da und Transport, Entwicklung und Forschung... Eine PS4 mit 500GB kostet(e) die meiste Zeit zwischen 499 und 549. Eine PS5 mit 825GB und Laufwerk, die meiste Zeit unter 700€.

Was soll uns das jetzt sagen? Ja genau. Was sagt uns das? Mal kurz die Prozentrechnung auffrischen...

Zuletzt bearbeitet:

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.474

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

Es ging um die Behauptung dass mit kleinerem Chip weniger Material erforderlich ist und somit der Preis in gleichem Maße fallen müsse. Rohmaterial ist aber nicht der Kostentreiber bei der Produktion. Bei der Produktion ist es die Belichtung. Bei der Entwicklung sieht das natürlich anders aus. Aber das weiß unser BWL Justus hier im Thread wahrscheinlich besser als wir...Gibt es für diese Behauptung auch eine Quelle? Laut verschiedenen Quellen ist die Software drumherum der größte Kostentreiber:

Nein, denn ich habe für turbofucker mal so einen thread gemacht ind der wurde sofort geschlosse ln.Ein ernst gemeinter Vorschlag: Macht es vielleicht Sinn einen "ich hasse die NVidia Preise und NVidia gleich mit" Thread aufzumachen, wo all das ganze Gelaber abgeladen werden kann, so dass die eigentlichen Threads zum Thema sich dann wieder auf die echten Informationen konzentrieren können und nicht so verwässert werden?

- Mitglied seit

- 17.07.2004

- Beiträge

- 28.626

- Ort

- Laupheim

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- ASUS TUF Gaming B650-Plus WIFI

- Kühler

- be quiet! Dark Rock 4

- Speicher

- G.Skill Flare EXPO X5 32 GB DDR5-6000 CL32

- Grafikprozessor

- Palit GeForce RTX 5070 Ti GameRock

- Display

- Dell Alienware AW3423DWF

- SSD

- Samsung SSD 970 EVO Plus 1 TB

- Soundkarte

- Creative Sound Blaster Z

- Gehäuse

- be quiet! Pure Base 500DX

- Netzteil

- Corsair HX750 Platinum

- Keyboard

- Sharkoon Skiller SGK30 Red

- Mouse

- Sharkoon Light² 200

- Betriebssystem

- Windows 11 Home

- Sonstiges

- Asus Rog Ally

- Internet

- ▼1 GBit ▲50 MBit

1k für die 4070 (das "ti" macht es auch nicht mehr besser) ... Prost Mahlzeit

Keine Ahnung, ob ich die mir mal kaufe. Aktuell eher nicht...

Keine Ahnung, ob ich die mir mal kaufe. Aktuell eher nicht...

- Mitglied seit

- 10.05.2006

- Beiträge

- 5.700

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D @150 W

- Kühler

- Noctua NH-D15 G2

- Speicher

- 32 GB DDR4

- Grafikprozessor

- PNY 3090 @3x Noctua NF-A9

- Display

- LG OLED42C29LB

- SSD

- Samsung 990 Pro 2TB || Evo 850 4TB || PM981a 1TB

- Soundkarte

- SoundBlaster X7 LE

- Gehäuse

- Jonsbo Z20W

- Netzteil

- Corsair SF750

- Keyboard

- Cherry KW X ULP

- Mouse

- Razer Viper Ultimate

- Sonstiges

- Ora Funky Cat 400 Pro

- Internet

- ▼100 ▲40

Na wenn der Chip grob halb so groß ist von der Fläche her, dann kostet er auch nur halb so viel.Wie kommt man eigentlich auf die Rechnung, dass umso kleiner der Chip umso geringer die Kosten für die Fertigung sind? Hat dafür jemand eine Quellen-Angabe? Ist das nicht eher eine Milchmädchenrechnung? Wenn ich das richtig verstanden habe, ist doch eher so: Umso kleiner der Chip, umso höher die Wafer-Kosten:

TSMCs 3 nm: Höhere Preise bei GPUs und iPhone 15 durch steigende Wafer-Preise

Der Preis für TSMCs Wafer soll einen neuen Höchststand erreicht haben. Das wirkt sich auf kommende Produkte, wie Grafikkarten und das iPhone 15 aus.www.pcgameshardware.de

Nicht Strukturbreite und Chipfläche verwechseln. 😉

Ähnliche Themen

- Antworten

- 4

- Aufrufe

- 1K

- Antworten

- 20

- Aufrufe

- 1K

- Antworten

- 183

- Aufrufe

- 11K

- Antworten

- 22

- Aufrufe

- 2K

- Antworten

- 8

- Aufrufe

- 2K