Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

[Sammelthread] AMCC 3ware 9650SE PCI-e RAID-Controller (+ Kurz-Review)

- Ersteller DoubleJ

- Erstellt am

den Kontroller initialisiert sich ja nicht. Die Treiberinstalation schlaegt somit fehl. ich muss ja auch ins Controllerbios kommen

EselMetaller

Enthusiast

ist "Secure Boot" deaktiviert?

Jop ebenfalls deaktiviert. Scheint mich echt einfach inkompatibel mit dem X370 Chipsatz zu sein.

aktuell nicht. Ich glaub die Schnittmenge zwischen 3ware und am4 x370 Besitzern ist sehr gering.

Luckysh0t

Enthusiast

Ich hatte unter Win 10 + X350 auch probleme mit meinem 9650SE - es gab immer wieder hänger im Windows Betrieb.

Jetzt sind meine Daten im Homeserver und im PC nur noch eine SSD.

Der Kontroller liegt nun einfach rum - vorerst.

Jetzt sind meine Daten im Homeserver und im PC nur noch eine SSD.

Der Kontroller liegt nun einfach rum - vorerst.

Zuletzt bearbeitet:

Wenn jemand ein AM4 Mainboard besitzt und ein 3ware Raidcontroller darauf zum laufen bekommen hat bitte hier erwähnen. Würde mich interessieren ob es Mainboards gibt bei dennen die Controller noch einzusetzen sind.

Captainfist

Neuling

- Mitglied seit

- 11.09.2017

- Beiträge

- 1

Kann hier zwar auch nicht weiterhelfen aber ich bin auch besitzer des 3ware 9650SE 16ml.

Habe jetzt das Asus Zenith mit dem X399 Chipsatz von AMD mit dem CPU 1950X.

Und was soll ich sagen, meiner bootet nicht mal wenn die Karte verbaut ist. Diverse andere Addon karten verursachen dasselbe Problem.

Bleibt komplett stehen beim Punkt Code:92 Test NVRAM.

Mit CSM hab ich auch schon rumgespielt ohne erfolg.

Von nem Kumpel der irgendwo in der IT arbeitet hab ich erfahren das viele neue Mainboards die alten PCIe 1.1 Karten nicht unterstützen,

die haben da ein ähnliches problem, sie wollten bei den alten Raid-Controllern bleiben da sie noch genug Speed bieten, jedoch mehr rechenpower benötigt wurde.

(lösungsansatz die chipsatzgebundenen PCIe 2.0 slots nutzen und/oder die anbindung mit bios setting auf PCIe 1.0 verringern brachte kein erfolg.)

Für mich reicht der Controller massig aus zumindest für um mein zeug zu speichern.

Anderen Kaufen kommt eventuell in frage nur müßte man erstmal wissen woran es liegt nicht das andere auch nicht gehen.

freue mich über antworten.

Habe jetzt das Asus Zenith mit dem X399 Chipsatz von AMD mit dem CPU 1950X.

Und was soll ich sagen, meiner bootet nicht mal wenn die Karte verbaut ist. Diverse andere Addon karten verursachen dasselbe Problem.

Bleibt komplett stehen beim Punkt Code:92 Test NVRAM.

Mit CSM hab ich auch schon rumgespielt ohne erfolg.

Von nem Kumpel der irgendwo in der IT arbeitet hab ich erfahren das viele neue Mainboards die alten PCIe 1.1 Karten nicht unterstützen,

die haben da ein ähnliches problem, sie wollten bei den alten Raid-Controllern bleiben da sie noch genug Speed bieten, jedoch mehr rechenpower benötigt wurde.

(lösungsansatz die chipsatzgebundenen PCIe 2.0 slots nutzen und/oder die anbindung mit bios setting auf PCIe 1.0 verringern brachte kein erfolg.)

Für mich reicht der Controller massig aus zumindest für um mein zeug zu speichern.

Anderen Kaufen kommt eventuell in frage nur müßte man erstmal wissen woran es liegt nicht das andere auch nicht gehen.

freue mich über antworten.

Zuletzt bearbeitet:

EselMetaller

Enthusiast

Weiß hier jemand mit Sicherheit, ob der 9650SE im Inter-Tech IPC 4U-4324L 19" Gehäuse Staggered Spinup kann?

GameCollector

Enthusiast

- Mitglied seit

- 08.12.2007

- Beiträge

- 2.822

Das liegt doch daran ob es die verbaute Backplane des Gehäuses unterstützt (afair Pin11 auf dem SATA Stromstecker).

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

Ich würde mal vermuten Ja, da das professionelle Hardware ist.

soweit ich weiß, haben auch die Hot-Swap Schächte bei Íntertech Activity-LEDs, und daß geht am einfacghsten mit einer Beschltung auf Pin 11 des Stromanschussteckers an statt den auf Masse zu legen. Wie der Teufel es will, ist genau dieses für Staggered Spinup gefordert (entweder gegen High Level beschaltet oder offen/unbeschaltet).

Ob der 3ware allerdings staggered Spinup oder doch nur PUIS (Power Up In Standby) kann, kann ich nicht sagen.

Spin-up - Wikipedia

soweit ich weiß, haben auch die Hot-Swap Schächte bei Íntertech Activity-LEDs, und daß geht am einfacghsten mit einer Beschltung auf Pin 11 des Stromanschussteckers an statt den auf Masse zu legen. Wie der Teufel es will, ist genau dieses für Staggered Spinup gefordert (entweder gegen High Level beschaltet oder offen/unbeschaltet).

Ob der 3ware allerdings staggered Spinup oder doch nur PUIS (Power Up In Standby) kann, kann ich nicht sagen.

Spin-up - Wikipedia

EselMetaller

Enthusiast

Danke für die Antwort.

Der 3ware kann beides, im Moment, ohne Backplanes im Lian Li D8000, kann er nur PUIS

Der 3ware kann beides, im Moment, ohne Backplanes im Lian Li D8000, kann er nur PUIS

GameCollector

Enthusiast

- Mitglied seit

- 08.12.2007

- Beiträge

- 2.822

Wie stellst du denn fest das er nur PUIS macht?

EselMetaller

Enthusiast

Wenn er aus dem Standby geweckt wird fahrten die Platten (hörbar) nacheinander hoch, bei einem Cold-Start alle auf einen Schlag.

GameCollector

Enthusiast

- Mitglied seit

- 08.12.2007

- Beiträge

- 2.822

ok, also mit der Ohr-Methode. Dachte das könnte man im Controllermenü irgendwo sehen bzw. aktivieren/deaktivieren.

EselMetaller

Enthusiast

nein, das ist nicht getrennt einstellbar, das läuft über SPU mit.

Hier kann man nur einstellen:Ja/Nein, Anzahl Platten die auf einmal anlaufen sollen, Zeit zwischen den Anläufen

Hier kann man nur einstellen:Ja/Nein, Anzahl Platten die auf einmal anlaufen sollen, Zeit zwischen den Anläufen

Stefan75

Profi

- Mitglied seit

- 14.11.2017

- Beiträge

- 6

Ich verwende bis jetzt 8x 3/4/5TB USB Platten um meine Daten zu lagern. Alles x2 für die Sicherung. Ich schalt sie nur ein wenn ich sie brauche (ca. alle 2 Tage). Langsam aber sicher wird das mühsam

Ich hab mich intensiv eingelesen in das Thema HW/SW-NAS/ZFS und hab schon nette gebrauchte Server gefunden.

Der Server sieht folgendermassen aus:

- 24 bay 3,5" hotswap

- Supermicro X7DBE

- 16GB ECC memory

- 9650SE-24M8

- Redundantes PS

Ich habe vor den Server auch nur einzuschalten wenn ich die Daten brauche (z.B auch beim Backup auf USB Platten).

Verwenden würde ich gerne meine 7x 3TB WD green (ex Synology 1812, 4 Jahre dauerbetrieb) und 8x 3TB Seagate (ex USB, vielleicht 1000h Betrieb, aber ~5 Jahre alt).

Das OS würde ab Mainboard SATA starten.

Bei HW-Raid würde ich RAID6 machen.

Hier meine Fragen:

a) werden diese Desktop Platten schnell sterben in einem 24 bay Server (z.B. wegen Vibrationen)?

b) werden Desktop Platten oft wegen Lesefehlern aus dem HW-Raid gespuckt?

c) welches OS ist zu empfehlen (Linux/FreeBSD/Win2k8) für SMB oder iSCSI?

d) HW raid (9650 ist alt, ohne Support, HW-Abhängikeit bei Defekt) oder doch lieber ein HBA mit SW Raid+ZFS (aber weniger Platz für Daten wegen vdev, nur Linux/BSD)?

e) ist es besser grad 24 3TB Platten einzubauen, oder nur die 15 und dann hoch migrieren bei bedarf?

Hatte noch nie Probleme mit meinen 20+ USB Platten (bis 140MB/s) und habe ein bisschen Angst das ich mir nur Ärger einhandle mit Raid/HW/Treiber/Filesystemen/LAN-Perf...

Wenn es nur eine 100TB USB Platte gäbe... fertig

Ich hab mich intensiv eingelesen in das Thema HW/SW-NAS/ZFS und hab schon nette gebrauchte Server gefunden.

Der Server sieht folgendermassen aus:

- 24 bay 3,5" hotswap

- Supermicro X7DBE

- 16GB ECC memory

- 9650SE-24M8

- Redundantes PS

Ich habe vor den Server auch nur einzuschalten wenn ich die Daten brauche (z.B auch beim Backup auf USB Platten).

Verwenden würde ich gerne meine 7x 3TB WD green (ex Synology 1812, 4 Jahre dauerbetrieb) und 8x 3TB Seagate (ex USB, vielleicht 1000h Betrieb, aber ~5 Jahre alt).

Das OS würde ab Mainboard SATA starten.

Bei HW-Raid würde ich RAID6 machen.

Hier meine Fragen:

a) werden diese Desktop Platten schnell sterben in einem 24 bay Server (z.B. wegen Vibrationen)?

b) werden Desktop Platten oft wegen Lesefehlern aus dem HW-Raid gespuckt?

c) welches OS ist zu empfehlen (Linux/FreeBSD/Win2k8) für SMB oder iSCSI?

d) HW raid (9650 ist alt, ohne Support, HW-Abhängikeit bei Defekt) oder doch lieber ein HBA mit SW Raid+ZFS (aber weniger Platz für Daten wegen vdev, nur Linux/BSD)?

e) ist es besser grad 24 3TB Platten einzubauen, oder nur die 15 und dann hoch migrieren bei bedarf?

Hatte noch nie Probleme mit meinen 20+ USB Platten (bis 140MB/s) und habe ein bisschen Angst das ich mir nur Ärger einhandle mit Raid/HW/Treiber/Filesystemen/LAN-Perf...

Wenn es nur eine 100TB USB Platte gäbe... fertig

Zuletzt bearbeitet:

EselMetaller

Enthusiast

Hallo Stefan,

ich kann Dir vielleicht ein wenig aus eigener Erfahrung dazu schildern.

Zu meinem Setting: ich habe derzeit 12x WD Red 3TB im Raid6 und noch paar 8 TB und 4 TB auf denen nichts wichtiges liegt als Singeldisks.

Ich nutze zZ noch das Lian Li D8000 Case da es im Wohnzimmer gut sichtbar steht und optisch was hermacht sowie von der Lautstärke her im Rahmen ist, ein 19" Server ginge da nicht.

Zusätzlich gut an der Kiste: die HDDs sind einzeln entkoppelt sodass es keinerlei Vibrationsprobleme gibt obwohl WD die alten Reds nur bis 5 Exemplare im selben Gehäuse freigibt.

Diese Kiste wird halt ordentlich laut sein, dass sollte Dir klar sein.

a) nicht schneller als in einem Desktop-Case auch

b) ja

c) da halte ich mich mal raus, bei mir läuft seit Jahren XP64

d) ich finde den 9650 klasse. Sehr zuverlässig, massig Anschlüsse für den Preis (24 Port für unter 200€, meinen letzten habe ich für 60€ bei iBäh geschossen der liegt nun als Ersatz im Schrank, kommt mit allen aktuellen HDDs klar.

Aber: die Performance hinkt mittlerweile gewaltig hinter neueren Controllern hinterher (gerade beim Rebuild) und die Treiberunterstützung für aktuelle Systeme ist nicht optimal (deswegen auch XP64) sodass ich an Deiner Stelle, da Du eh neu in ein System investierst, nicht mehr zum 9650 greifen würde.

e) 1.) ein einzelnes, großes Raid Array mit 24 Disks ist viel anfälliger als mehrere kleinere. 2.) wenn schon umsteigen und migrieren dann bitte nicht mehr mit "popeligen" 3TB Modellen. Der €/TB Preis ist bei den 3TB zwar derzeit am niedrigsten (aktuell rund 24€ / TB im Desktop-Bereich) , aber z.B. eine 8 TB Seagate Ironwolf NAS liegt derzeit bei 29€ / TB, also nicht die Welt teurer.

Aber auch hierzu noch ein Gedanke zum altehrwürdigen 9650: ein Rebuild mit einer 3TB dauert bei mir etwa 24h. Hochgerechnet dürfte dann ein Defekt einer 8TB Disk im Raid6 knappe drei Tage dauern. Das ist viel Zeit die da verstreicht, in der man sich definitiv einen schnelleren Controller wünscht.

Mein Fazit:

Um Deine bisherigen HDDs irgendwie anzustöpseln und sie "unter ein Dach" zu bekommen ist der 9650 voll OK, aber wenn Du vor hast zu vergrößernsolltest Du mittelfristig auf einen aktuelleren Controller und größere Disks umschwenken.

ich kann Dir vielleicht ein wenig aus eigener Erfahrung dazu schildern.

Zu meinem Setting: ich habe derzeit 12x WD Red 3TB im Raid6 und noch paar 8 TB und 4 TB auf denen nichts wichtiges liegt als Singeldisks.

Ich nutze zZ noch das Lian Li D8000 Case da es im Wohnzimmer gut sichtbar steht und optisch was hermacht sowie von der Lautstärke her im Rahmen ist, ein 19" Server ginge da nicht.

Zusätzlich gut an der Kiste: die HDDs sind einzeln entkoppelt sodass es keinerlei Vibrationsprobleme gibt obwohl WD die alten Reds nur bis 5 Exemplare im selben Gehäuse freigibt.

Der Server sieht folgendermassen aus:

- 24 bay 3,5" hotswap

- Supermicro X7DBE

- 16GB ECC memory

- 9650SE-24M8

- Redundantes PS

Diese Kiste wird halt ordentlich laut sein, dass sollte Dir klar sein.

Hier meine Fragen:

a) werden diese Desktop Platten schnell sterben in einem 24 bay Server (z.B. wegen Vibrationen)?

b) werden Desktop Platten oft wegen Lesefehlern aus dem HW-Raid gespuckt?

c) welches OS ist zu empfehlen (Linux/FreeBSD/Win2k8) für SMB oder iSCSI?

d) HW raid (9650 ist alt, ohne Support, HW-Abhängikeit bei Defekt) oder doch lieber ein HBA mit SW Raid+ZFS (aber weniger Platz für Daten wegen vdev, nur Linux/BSD)?

e) ist es besser grad 24 3TB Platten einzubauen, oder nur die 15 und dann hoch migrieren bei bedarf?

a) nicht schneller als in einem Desktop-Case auch

b) ja

c) da halte ich mich mal raus, bei mir läuft seit Jahren XP64

d) ich finde den 9650 klasse. Sehr zuverlässig, massig Anschlüsse für den Preis (24 Port für unter 200€, meinen letzten habe ich für 60€ bei iBäh geschossen der liegt nun als Ersatz im Schrank, kommt mit allen aktuellen HDDs klar.

Aber: die Performance hinkt mittlerweile gewaltig hinter neueren Controllern hinterher (gerade beim Rebuild) und die Treiberunterstützung für aktuelle Systeme ist nicht optimal (deswegen auch XP64) sodass ich an Deiner Stelle, da Du eh neu in ein System investierst, nicht mehr zum 9650 greifen würde.

e) 1.) ein einzelnes, großes Raid Array mit 24 Disks ist viel anfälliger als mehrere kleinere. 2.) wenn schon umsteigen und migrieren dann bitte nicht mehr mit "popeligen" 3TB Modellen. Der €/TB Preis ist bei den 3TB zwar derzeit am niedrigsten (aktuell rund 24€ / TB im Desktop-Bereich) , aber z.B. eine 8 TB Seagate Ironwolf NAS liegt derzeit bei 29€ / TB, also nicht die Welt teurer.

Aber auch hierzu noch ein Gedanke zum altehrwürdigen 9650: ein Rebuild mit einer 3TB dauert bei mir etwa 24h. Hochgerechnet dürfte dann ein Defekt einer 8TB Disk im Raid6 knappe drei Tage dauern. Das ist viel Zeit die da verstreicht, in der man sich definitiv einen schnelleren Controller wünscht.

Mein Fazit:

Um Deine bisherigen HDDs irgendwie anzustöpseln und sie "unter ein Dach" zu bekommen ist der 9650 voll OK, aber wenn Du vor hast zu vergrößernsolltest Du mittelfristig auf einen aktuelleren Controller und größere Disks umschwenken.

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

Sollte der 9650 aus Performancegründen ausgemustetr werden, würde ich gar keinen Raidcontroller mehr nehmen, sondern einfache SAS/SATA HBAs (vorzugsweise LSI/Broadcom wegen OS Support) und auf software-Raid ujnter Linux / FreeBSD oder Solaris setzen bzw. eine der zahhlreichen NAS-Distris bzw. Storage Appliances nutzen!

Ob nun ZFS oder "einfacheres" LVM Raid mit EXT3/4, UFS zum Einsatz kommt ist eher zweitrangigm, beide Möglichkeiten haben ihre Vor- und Nachteile.

15x3TB = 45 TB Brutto (oder auch Gesamtkapazität bei JBOD oder Raid0 / ZFS Striping >> Eine HDD Faild = kompletter Datenverlust)

Daher Realistische Konfiguration:

3x Raid5/RaidZ1 (4+1) >>> (Grundsätzlich als einzelne Volumes bzw. Pools, da bei einem Raid50 bzw. für den gesamten Pool gilt: es kann eine beliebige HDD ausfallen)

ODER

1x Raid5/RaidZ1 (4+1) PLUS 1x Raid6/Raidz2 (8+2) >>> (Wichtig! Unter ZFS als eigenständige Pools , da sonst das Raidz2 witzlos wäre. Für den gesamten Pool gilt: es kann eine beliebige HDD ausfallen)

ODER

1x Raidz3 (12+3) (ZFS)

= 34 TB Netto

Mit 5 oder 6 8TB HDDs im Raid5/Raidz1 bzw. Raid6/Raidz2 würdest du bereits 40 TB Kapazität haben.

- kleineres Gehäuse möglich

- Besser zu kühlen = leiser

- ein "einfaches" mainboard mit 6 oder mehr SATA-Ports reicht (OS könnte auf USB Stick bzw. USB-SSD) >>>> (empfehlen würde ich da trotzdem was mit Serverchipsatz, ECC fähiger CPU und ECC RAM, aber das ist meine Meinung)

P.S. Ich habe auch vor gut 3 Jahren ein NAS mit insgesamt 15 älteren HDDs (7x2TB und 7x3TB jeweils als Raidz2 Plus Systemplatte) aus älteren vorhanden Komponenten zusammengeschustert! Eine der ursprünglich verbautb WD Green 3TB hat sich mittlerweile verabschiedet.

Das NAS läuft im Monat vielleicht 20h und enthält nur unwichtiges (daher auch nur Consumer Hardware)

Ob nun ZFS oder "einfacheres" LVM Raid mit EXT3/4, UFS zum Einsatz kommt ist eher zweitrangigm, beide Möglichkeiten haben ihre Vor- und Nachteile.

15x3TB = 45 TB Brutto (oder auch Gesamtkapazität bei JBOD oder Raid0 / ZFS Striping >> Eine HDD Faild = kompletter Datenverlust)

Daher Realistische Konfiguration:

3x Raid5/RaidZ1 (4+1) >>> (Grundsätzlich als einzelne Volumes bzw. Pools, da bei einem Raid50 bzw. für den gesamten Pool gilt: es kann eine beliebige HDD ausfallen)

ODER

1x Raid5/RaidZ1 (4+1) PLUS 1x Raid6/Raidz2 (8+2) >>> (Wichtig! Unter ZFS als eigenständige Pools , da sonst das Raidz2 witzlos wäre. Für den gesamten Pool gilt: es kann eine beliebige HDD ausfallen)

ODER

1x Raidz3 (12+3) (ZFS)

= 34 TB Netto

Mit 5 oder 6 8TB HDDs im Raid5/Raidz1 bzw. Raid6/Raidz2 würdest du bereits 40 TB Kapazität haben.

- kleineres Gehäuse möglich

- Besser zu kühlen = leiser

- ein "einfaches" mainboard mit 6 oder mehr SATA-Ports reicht (OS könnte auf USB Stick bzw. USB-SSD) >>>> (empfehlen würde ich da trotzdem was mit Serverchipsatz, ECC fähiger CPU und ECC RAM, aber das ist meine Meinung)

P.S. Ich habe auch vor gut 3 Jahren ein NAS mit insgesamt 15 älteren HDDs (7x2TB und 7x3TB jeweils als Raidz2 Plus Systemplatte) aus älteren vorhanden Komponenten zusammengeschustert! Eine der ursprünglich verbautb WD Green 3TB hat sich mittlerweile verabschiedet.

Das NAS läuft im Monat vielleicht 20h und enthält nur unwichtiges (daher auch nur Consumer Hardware)

Zuletzt bearbeitet:

GameCollector

Enthusiast

- Mitglied seit

- 08.12.2007

- Beiträge

- 2.822

Bei so großen RAIDs (12x HDD, RAID6) ist die Gefahr das es failed auch relativ groß.

Gerade wenn man häufiger dran rumschraubt.

Ich hab mich mittlerweile auf mehrere kleine (Hardware) RAIDs eingeschossen.

Also z.b. 5x3TB RAID5 und das ganze mal 3. Ergibt dann 36TB netto und in jedem Segment dürfte dann eine ausfallen.

Rebuild geht schneller.

Der URE Problematik bei 10^14 (Rebuild schlägt fehl) bei ungefähr 66TB RAID größe geht man so auch erstmal aus dem Weg (selbst bei 5x12TB HDDs).

Ich sag nicht das Software RAID schlechter ist, am Ende muss es halt jeder für sich und seine Bedürfnisse entscheiden,

wie er sein Storage konstruiert.

Gerade wenn man häufiger dran rumschraubt.

Ich hab mich mittlerweile auf mehrere kleine (Hardware) RAIDs eingeschossen.

Also z.b. 5x3TB RAID5 und das ganze mal 3. Ergibt dann 36TB netto und in jedem Segment dürfte dann eine ausfallen.

Rebuild geht schneller.

Der URE Problematik bei 10^14 (Rebuild schlägt fehl) bei ungefähr 66TB RAID größe geht man so auch erstmal aus dem Weg (selbst bei 5x12TB HDDs).

Ich sag nicht das Software RAID schlechter ist, am Ende muss es halt jeder für sich und seine Bedürfnisse entscheiden,

wie er sein Storage konstruiert.

Zuletzt bearbeitet:

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

Deswegen nimmt man auch seagate NAS (IronWolf), die haben eine URE von 1 in 10^15 - nur mal so angemerkt....

So lange du die 3 Raids auch als einzelne Volumes benutzt, iat nur der Inhalt eines Volumes betroffen, wenn in einem Raidset eine 2. HDD ausfällt.

In dem Moment, wo du aus den 3 Raidsets ein gemeinsames Volume erstellst - also als Raid 50 oder über die Datenträgerverwaltung (oder ab win 8.x storage spaces) eine übergreifendes Volume erstellst, geht in dem Falle das gesamte Volume hops.

Nach Murphy's Law wird genau das passieren...

Die Wahrscheinlichkeit, daß während des Rebuilds eine HDD in einem anderen (quasi unbelasteten) Raidsets ausfällt ist ungleich geringer als das eine 2. HDD im betroffenem Raidset ausfällt.

5x3 TB HDDs Raid 5 bei 1in10^14 : 282 Jahre bis Datenverlust

6x8TB Raid 6 bei 1in10^15 : 4.735 Jahre bis Datenverlust

15x3 TB HDDs Raid 50 bei 1in10^14 : ist gar nicht mehr angegeben.....

Fals du selber "spielen" möchtest : RAID Reliability Calculator - Simple MTTDL Model - ServeTheHome

So lange du die 3 Raids auch als einzelne Volumes benutzt, iat nur der Inhalt eines Volumes betroffen, wenn in einem Raidset eine 2. HDD ausfällt.

In dem Moment, wo du aus den 3 Raidsets ein gemeinsames Volume erstellst - also als Raid 50 oder über die Datenträgerverwaltung (oder ab win 8.x storage spaces) eine übergreifendes Volume erstellst, geht in dem Falle das gesamte Volume hops.

Nach Murphy's Law wird genau das passieren...

Die Wahrscheinlichkeit, daß während des Rebuilds eine HDD in einem anderen (quasi unbelasteten) Raidsets ausfällt ist ungleich geringer als das eine 2. HDD im betroffenem Raidset ausfällt.

5x3 TB HDDs Raid 5 bei 1in10^14 : 282 Jahre bis Datenverlust

6x8TB Raid 6 bei 1in10^15 : 4.735 Jahre bis Datenverlust

15x3 TB HDDs Raid 50 bei 1in10^14 : ist gar nicht mehr angegeben.....

Fals du selber "spielen" möchtest : RAID Reliability Calculator - Simple MTTDL Model - ServeTheHome

Zuletzt bearbeitet:

GameCollector

Enthusiast

- Mitglied seit

- 08.12.2007

- Beiträge

- 2.822

ja hab Ironwolf 8TB im Einsatz. Beachte, dass die kleineren Ironwolfs (afair 4TB) mit 10^14 daherkommen.

Mein vorheriger Beitrag war nur ein Beispiel.

Habe sogar mehrere verschiedene RAID Controller im Einsatz. Daher absolut getrennte RAIDs.

Insgesamt juckt mich ein Ausfall nicht mehr so, habe immer ein Backup von allen wichtigen Daten.

Mein vorheriger Beitrag war nur ein Beispiel.

Habe sogar mehrere verschiedene RAID Controller im Einsatz. Daher absolut getrennte RAIDs.

Insgesamt juckt mich ein Ausfall nicht mehr so, habe immer ein Backup von allen wichtigen Daten.

Zuletzt bearbeitet:

Digi-Quick

Urgestein

- Mitglied seit

- 02.09.2009

- Beiträge

- 7.082

stimmt...ja hab Ironwolf 8TB im Einsatz. Beachte, dass die kleineren Ironwolfs (afair 4TB) mit 10^14 daherkommen.

du kannst die VDs aber logisch zusammenfassen, was dann einem JBOD entspricht.Habe sogar mehrere verschiedene RAID Controller im Einsatz. Daher absolut getrennte RAIDs.

unter Linux vai LVM

unter Windows als übergreifendes Volume

Sehr löblich!! Raid ersetzt halt kein Backup, auch ein Raid kann sterben.Insgesamt juckt mich ein Ausfall nicht mehr so, habe immer ein Backup von allen wichtigen Daten.

Stefan75

Profi

- Mitglied seit

- 14.11.2017

- Beiträge

- 6

Danke für all euere Feedbacks...

Mir ist noch eine Alternative empfohlen worden... Snapraid.

Zuerst war ich skeptisch wie das denn funktionieren sollte, aber je mehr ich gelesen/probiert habe, desto mehr gefiel mir die Lösung.

In meinem Fall passt es auch gut: selten Updates, selten online, sparsam.

Zur Zeit generiere ich grad die 'double parity' von meinen 8 USB3 Platten (veracrypt encrypted + NTFS) und schreibe dabei auf 2 USB3 Platten (NTFS).

Durchschnittlich wird mit je 47MB/s parallel gelesen/geschrieben... also total 376MB/s lesen, nicht schlecht für USB3 (5Gbps)

Die Parity Berechnung wird etwa 27 Stunden dauern.. mal schauen wie lang dann ein inkrementelles Update geht.

Musste noch den 'Windows Search' und 'Superfetch' Dienst ausschalten da diese immer wieder 100% disk Aktivität provoziert haben (für nichts)!

Irgendwann werde ich wohl schon ein 24 bay Server zutun...

Mir ist noch eine Alternative empfohlen worden... Snapraid.

Zuerst war ich skeptisch wie das denn funktionieren sollte, aber je mehr ich gelesen/probiert habe, desto mehr gefiel mir die Lösung.

In meinem Fall passt es auch gut: selten Updates, selten online, sparsam.

Zur Zeit generiere ich grad die 'double parity' von meinen 8 USB3 Platten (veracrypt encrypted + NTFS) und schreibe dabei auf 2 USB3 Platten (NTFS).

Durchschnittlich wird mit je 47MB/s parallel gelesen/geschrieben... also total 376MB/s lesen, nicht schlecht für USB3 (5Gbps)

Die Parity Berechnung wird etwa 27 Stunden dauern.. mal schauen wie lang dann ein inkrementelles Update geht.

Musste noch den 'Windows Search' und 'Superfetch' Dienst ausschalten da diese immer wieder 100% disk Aktivität provoziert haben (für nichts)!

Irgendwann werde ich wohl schon ein 24 bay Server zutun...

Zuletzt bearbeitet:

Ich hoffe mir kann hier einer helfen, da ich seit Wochen nicht weiterkomme.

Habe den 9650SE-12ML daran momentan 4 WD RE 3TB zusammengefasst als Raid5. Unter Ubuntu 16.04 bekomme ich nur die einzelnen Platten mit je 2TB zu sehen + den Raid Controllercache aber keine ca.8TB Platte.

Ubuntu 16.04 sollte die passenden Treiber schon an Board haben.

Habe den 9650SE-12ML daran momentan 4 WD RE 3TB zusammengefasst als Raid5. Unter Ubuntu 16.04 bekomme ich nur die einzelnen Platten mit je 2TB zu sehen + den Raid Controllercache aber keine ca.8TB Platte.

Ubuntu 16.04 sollte die passenden Treiber schon an Board haben.

Ich glaube du hast einfach irgendwo die Option gesetzt für die interne Aufteilung des RAIDs, z. B. damit Systeme die kein gpt können die nutzen können.

Schau mal nach der Auto-Carving Einstellung in den Controller Einstellungen.

Gesendet von meinem SGP521 mit Tapatalk

Schau mal nach der Auto-Carving Einstellung in den Controller Einstellungen.

Gesendet von meinem SGP521 mit Tapatalk

Zuletzt bearbeitet:

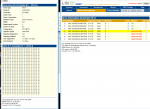

3ware 9650se WD red 10TB

hey

hat vielleicht jemand erfahrung mit der 9650SE und WD Red 10TB

ich betreibe das ganze bis jetzt unter windows 7 mit WD Red 3TB

und wollte den Speicher nun um einen raid 5 verbund mit besagten 10TB platten erweitern

nun bekomme ich leider einen Read Failure zurück

und bin an sonsten ahnungslos

hab ich noch eine möglichkeit das ganze ans laufen zubekommen?

hey

hat vielleicht jemand erfahrung mit der 9650SE und WD Red 10TB

ich betreibe das ganze bis jetzt unter windows 7 mit WD Red 3TB

und wollte den Speicher nun um einen raid 5 verbund mit besagten 10TB platten erweitern

nun bekomme ich leider einen Read Failure zurück

und bin an sonsten ahnungslos

hab ich noch eine möglichkeit das ganze ans laufen zubekommen?

Anhänge

XN04113

Semiprofi

musst Du nicht erst eine UNIT erstellen bevor das verschwindet?

Ähnliche Themen

[Kaufberatung]

"Vernünftige" USB-C Steckkarte gesucht

- Antworten

- 3

- Aufrufe

- 462

- Antworten

- 2

- Aufrufe

- 799

- Antworten

- 66

- Aufrufe

- 11K

[Sammelthread]

HPE ProLiant MicroServer Gen11 G7400/E-2414/E-2434

- Antworten

- 21

- Aufrufe

- 4K

- Antworten

- 3

- Aufrufe

- 646