en ganzen Spaß auf SMT beschränken tust primär du. Wer wovon wie viel Ahnung hat, weißt du gar nicht und es gibt hier schon genug Leute die eine ähnliche Einschätzung abgegeben haben.

Nein, das tuhe ich beileibe nicht, du siehst das wieder volkommen falsch. ( etwa absichtlich?)

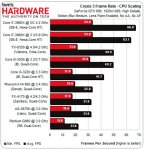

Du redest die ganze Zeit von der schlechten Skalierung von SMT und hast außer dieser Aussage keine stichhaltigen Beweise für einen ineffizienten Code.

Also von was redest du bitte noch? Ich bin gerne offen für Argumente, die ich schon 100 mal gefordert habe, aber es kamen wie bekannt ja keine.

Dein Problem ist, dass du nicht im geringsten objektiv bist, du brichst das alles auf eine Diskussion AMD vs Intel runter und verteidigst deine Firma.

Nein, der Grund warum du so aggro bist, liegt schlicht daran, weil der AMD Prozessor bei massiver Parallelität scheinbar mithalten kann.

Und so etwas erklärst du dir nur mit ineffizientem schlechten Code, ohne wissenschaftlich ranzugehen und mal überhaupt irgendetwas zu recherchieren.

Vereinfach gesagt: AMD skaliert gut = mit dem Spiel stimmt etwas nicht.

Leistung absprechen tun dies nicht um die Leistung von AMD zu schmälern, sondern weil der Code offensichtlich suboptimal ist.

Nochmal, worin liegt die offensichtlichkeit begraben? Erkläre es mir anhand von Beispielen, Argumenten oder Fakten.

Y33H@ hätte bestimmt schon was dazu gesagt, oder irgend jemand anderes, außer deinen Bashing Freunden, wenn es was wissenwertes zu erzählen gäbe.

Dazu kommen noch genug Benches die auf Very High eine grützige Performance mit 350€-GPUs bieten, selbst in geringen Auflösungen. Was sind dann deine Gegenargumente?

Ich habe Gegenargumente geliefert.

a) Die maximalen Einstellungen nutzen immer sehr rechenintensive Features wie Global Illumination, MSAA kostet extrem da deferred Renderer, etc.. um das maximale herauszuholen, analog zu BF3, BF2, Arma2 ist das doch genauso, dass es an der Spitze nurnoch BQ Gewinn mit extrem hohen Leistungseinsatz gibt.

Das ist nun wirklich nichts neues und nicht ansatzweise irgendein stichhaltiges Argument.

b) Der Code ist bei mittleren Settings scheinbar sehr gut, weil selbst eine HD 7750 dafür reicht, bei immernoch superber Grafik.

Wenn ich mir im Gegenzug andere Shooter ansehe, muss ich dort viel mehr Qualität runterdrehen.

Auf diese Argumente hast du noch nie gewantwortet, ich auf deine schon.

Und den fett markierten Satz kannst du dir mal durch den Kopf gehen lassen, denn zum einen ist es faszinierend, dass du definierst was Fakten sind und jenseits dieses Wortes passt das perfekt auf dich.

Ich denke es ist vielmehr genau umgekehrt.

Warum muss man da was signifikant verbessern, wenn alles gut läuft?

Solche Patches findest du bei jedem Spiel.

Einen ineffizienten Code kann man sowieso nicht patchen.

Dieser Patch kann sich genauso auf die Zusammenarbeit mit den Grafikkartenherstellern beziehen um das maximum herauszuholen.

Wie groß diese Verbesserungen sind könnte ja vielleicht mal einer nachmessen.

MadDias schrieb:

bulldozer hat module mit 2 physischen kernen, falls du dir mal die DIE genauer angeschaut hast.

Mr. Dude hat erst vor kurzem einen Dieshot gepostet und nein, dort sich keine 2 Physischen Kerne in einem Modul.

da es sich bei bulldozer um 2 identische kerne in einem modul handelt, die sich auch noch eine ganze menge logik teilen, könnte man davon ausgehen, dass sie multithreaded um einiges besser sind als die alten deneb und thuban kerne.

Ne, das gibt keinen Sinn, was du da sagst. Gerade wenn sich ein Kern etwas teilt, muss die Multithreading Performance sinken.

Deswegen sind es ja auch 2 Threads mehr beim FX-8XXX, ansonsten würde man multitthreaded gegen nen Phenom II 1100T verlieren.

du behauptest ja selbst, das ein fx-6300 auf augenhöhe mit einem thuban wäre. wieso also nicht auch den 4000er mit einem deneb vergleichen?

Kann man ja auch vergleichen, da die FX mehr Takt haben und das so wieder ausgleichen.

Trotzdem hat ein FX-4300 keine Chance gegen den Deneb 965Be bei gleichem Takt in Multithreaded Apps, bei weitem nicht.

Weißt du jetzt auch noch, wie hoch der FX-4300 taktet?

Weißt du jetzt auch noch, wie hoch der FX-4300 taktet?