Es sind im Prinzip immer die gleichen Probleme wenn es um die Einschätzung des Stromverbrauchs geht. Die Boards/Spawa/Biose haben ebenso wie die Lasttools merklichen Einfluss, der Knackpunkt ist aber wie immer die VID bzw. anliegende Vcore und eine mögliche Diskrepanz zwischen beiden. Ich weiß nicht woran es liegt, aber die Inkonsistenz und Verwirrung bezüglich Spannungen von AMD-CPUs nimmt scheinbar mit jedem Launch immer stärker zu.

Es gibt Exemplare mit (angeblichen) 1,4 VID oder lediglich real anliegender Vcore (wer weiß das schon genau? die Tester? mittlerweile wie es scheint nicht mal mehr die Boardhersteller...), aber es gibt auch Samples mit 1,25-1,275V (wo allerdings dennoch zum Teil fast 0,1V mehr anliegt als eigentlich sollte).

Llano, die zweite Stufe der Fusion - Prozessoren - Planet 3DNow! Forum

Ein weiteres Problem stellt die oben zu erkennende Versorgungsspannung für die APU da. Laut VID sollten es nur 1,275 V sein, stattdessen stellte das Board 1,36 V ein.

Oder hier das Sampel bei dem das Board doch tatsächlich unglaubliche 1,26V@Load anlegt:

Llano & Lynx: Neue APU & Plattform von AMD : AMD A8-3850 APU (Llano) - Artikel Hartware.net

Dementsprechend liegt der Stromverbrauch auch etwa auf 65W TDP CPU Niveau:

Llano & Lynx: Neue APU & Plattform von AMD : Stromverbrauch - Artikel Hartware.net

Ich weiß nicht wie AMD die Sache mit den Spannungen in den Griff kriegen soll? Müssten sie die Board-Hersteller wie Intel mal an die Leine nehmen und etwas mehr Befehle in Form von strengeren Auflagen erteilen? Oder liegt es am CPU-Hersteller selbst, spielen die dort Zufallsgenerator bei der Selektion und Einteilung der CPUs? Ansonsten frag ich mich wie sowas zustande kommt:

AMDs Llano-APU A8-3850 im Test - Gelegenheitsspieler aufgepasst - Undervolting (Seite 31)

Unter Last hingegen macht sich der Vorteil durchaus bemerkbar. So sinkt der Verbrauch bei CPU-Last von fast 96 Watt auf phänomenale 54 Watt. Da fragt man sich doch ernsthaft, warum AMD eine solch hohe Spannung von Haus aus anlegt. Sicherlich bedarf es Sicherheitsmargen, aber fast ein Viertel Volt?

In dieser Form ist die A8-3850 CPU doch ein No-Go für alle Leute die auf Effizienz Wert legen. Bekommt man beim Kauf eine CPU mit 1,25VID oder 1,4VID? Legt das Board A, B oder C die richtige Spannung an oder nicht? Das ist ja mittlerweile fast wie bei der Lotterie...

Edit: Ich verstehe einfach nicht wieso AMD nicht ebenfalls wie Intel einen gewissen Vdroop vorschreibt, so würde selbst eine 1,4VID CPU unter Volllast z.B. mit lediglich ca. 1,32-1,34V versorgt werden. Die Board-Hersteller könnten das aber auch auf eigene Faust machen (ASUS hatte das bereits bei den AM3-Boards mit AMD 700er und 800er Chipsatz gemacht), aber wenn ich ehrlich bin kommt es mir so vor, als ob die noch "mit Genuß" bei AMD-CPUs extra Spannung auf die VID daufhauen (mit zum Teil irrwitzigen Begründung).

---------- Beitrag hinzugefügt um 21:53 ---------- Vorheriger Beitrag war um 21:42 ----------

Bei xbitlabs verbraucht ein A8-3800 deutlich weniger als ein X4-630. Vorallem der Idle-Verbrauch von

16.2W sieht da lecker aus

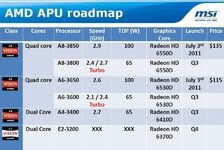

Ja die 65W TDP Modelle sind auch erstmal die einzigen Llanos die für mich in Frage kommen, vor allem ist die GPU genau so stark wie bei den 100W TDP Modellen.

Aber gut, wie ich schon sagt, ohne Ergebnisse bei Teillast ist das nur die halbe Wahrheit. Etwas mehr hatte ich allerdings schon erwartet. Da scheint wohl die iGPU trotzdem einiges auszumachen, auch wenn nur die CPU beansprucht wird. Bei der Spannung ist sicherlich auch noch Spielraum nach unten. Wobei ich das weniger kritisch gegenüber den 45 nm Modellen sehe. Der X4 840 wurde zuletzt auch mit 1,38 V gemessen. So viel weniger als die 1,4 V für den A8 ist das auch nicht.

Aber gut, wie ich schon sagt, ohne Ergebnisse bei Teillast ist das nur die halbe Wahrheit. Etwas mehr hatte ich allerdings schon erwartet. Da scheint wohl die iGPU trotzdem einiges auszumachen, auch wenn nur die CPU beansprucht wird. Bei der Spannung ist sicherlich auch noch Spielraum nach unten. Wobei ich das weniger kritisch gegenüber den 45 nm Modellen sehe. Der X4 840 wurde zuletzt auch mit 1,38 V gemessen. So viel weniger als die 1,4 V für den A8 ist das auch nicht.

Da gibt es CPU, GPU, verschiedene Bus- oder Punkt-zu-Punkt Verbindungen, die jeweils (mit unterschiedlicher Häufigkeit) limitieren können, aber kein geheimes und dieser Theorie folgendes "Ding".

Da gibt es CPU, GPU, verschiedene Bus- oder Punkt-zu-Punkt Verbindungen, die jeweils (mit unterschiedlicher Häufigkeit) limitieren können, aber kein geheimes und dieser Theorie folgendes "Ding". Deine "Kompetenz" sah man ja auch wieder bei Llano, dessen Leistungsaufnahme nachgewiesen unterhalb von Propus liegt und damit deine Theorie Lügen straft. Aber so ist das halt. Du machst oder siehst irgendwas und glaubst, das hätte Allgemeingültigkeit. Hat es aber nicht. Und das solltest du langsam mal begreifen und akzeptieren. Deine "Erfahrungen" haben noch lange nichts mit Fakten zu tun.

Deine "Kompetenz" sah man ja auch wieder bei Llano, dessen Leistungsaufnahme nachgewiesen unterhalb von Propus liegt und damit deine Theorie Lügen straft. Aber so ist das halt. Du machst oder siehst irgendwas und glaubst, das hätte Allgemeingültigkeit. Hat es aber nicht. Und das solltest du langsam mal begreifen und akzeptieren. Deine "Erfahrungen" haben noch lange nichts mit Fakten zu tun.