Minutourus

Enthusiast

Weiß nicht selbst bei 1080p würde ich mich bei 8GB VRAM wohler fühlen als bei 4GB VRAM, aber halt meine persönliche Meinung.....

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Achja, ich würde für eine RX 480 eigentlich 8GB Vram empfehlen:

- Man hat zugriff aufs AMDs Downsampling Feature (alte Spiele in 4K spielen --> verbraucht viel Vram)

- Viele Texturen möglich, diese verbrauchen wenig Leistung aber viel Vram und sorgen für eine viel bessere Grafik

- Höherer Wiederverkaufswert

- 4GB werden in den nächsten Jahren eher knapp

- Mit OC hat die Karte genug Leistung um über 4GB Vram verbrauchen zu können

Wäre ja schonmal toll, wenn hier nicht dauernd über Nvidia diskutiert würde...

Weiß nicht selbst bei 1080p würde ich mich bei 8GB VRAM wohler fühlen als bei 4GB VRAM, aber halt meine persönliche Meinung.....

Ich bin gespannt, wie die Karte mit 8GB und ein paar mehr Shader, etwas mehr Bandbreite im Vergleich zur GTX 980 bei einem gemoddeten Skyrim abschneidet. O_O

Also wer dafür 2000$ ist schon wirklich heftig, hoffe da fällt keiner drauf rein.

Naja wenn ich sone Karte am Mittwoche bekomme, JA.

Ich bin halt in der Heimat und kann nicht sagen ob der Laden meines Vertrauens mir schon am Dienstag ne Karte gibt, überhaupt welche hat usw.!

Aaaaaaaalso ... ich hab eben mal telefoniert:

In dem Shop wo ich gern einkaufe ( seit 15 Jahren ) ist bisher keine Lieferung angekommen in Sachen RX 480, keine genaues Verfügbarkeitsdatum und die können selbst über Retailer aktuell keine Karte vorbestellen oder ordern.

Ich kann also defintiv sagen, dass ich am Mittwoch und Donnerstag ohne RX 480 dastehen werde.

mmcomputer?

Kann irgendwer sagen was für ein GPU Wasserkühler das auf der RX480 ist?? Die meisten dieser Art haben die Schläuche ja immer nach oben abgehend.. aber der kann ja auch direkt von der GPU weg.

Minutorus schick mal bitte Link wo das her ist! Damit könnte man ja direkt am Mittwoch wissen was für OC so mit dem Referenz-PCB geht!!

Ich muss jetzt nochmal drastisch werden, Fimbim. HALT ENDLICH MAL DEN MUND. ES KOMMT ZU 99% GEQUIRLTE SCHEIßE AUS DIR RAUS. Wie kann man so auf seiner Meinung beharren, obwohl diese Meinung purer Müll ist?

Wir wissen, dass nVidia alles super macht und AMD alles schlecht. Die Fury X hatte nen zu hohen Verbrauch bei zu wenig Leistung? Die Leistung war @stock etwa gleichwertig mit einer 980Ti @stock. Ebenso die Stromaufnahme. 4GB HBM machen nicht früher dicht als 6GB GDDR bei einer Ti, ist dir Kompression ein Begriff? Da hat AMD sehr gute Arbeit geleistet.

Die 500$-Aussage ist immer noch auf die Buildquality bezogen. D.h. AMD hat nicht nur 3 Phasen verbaut und billige Komponenten, sondern alles gleichwertig zu den High End Karten. Raff es doch mal!!!!

Es ist einfach widerlich, was bei dir alles an Anti aus dem Maul kommt. Dieser Thread hier wäre ohne dich einfach absolut in Ordnung - auch mit Kritik, aber ruhig. Ich raffe nicht wie man dich offensichtlichen Fanboy ersten Grades einfach hier weiter machen lässt... ist mir unbegreiflich!

Du bist nicht gierig wenn du dein Geld überlegt ausgibst.

Gesendet von meinem H1 mit der Hardwareluxx App

Wird sie nicht, da mittlerweile auch für LTC Asic existierenirgendwie habe ich das gefühl, dass die grafikkarte wieder von miner genutzt wird, hff kommt es nicht zu lieferengpässen deswegen.

Kannst du das testen?

Edit:

Ist das eine RX480? Sieht fast danach aus...

´Der Kühler ( vor allem der Ref-Kühler ) gehört nicht zur Build Quality einer Karte, hier gehts im PCB, VMEM, GPU, Phasen etc.! Der Ref-Kühler tut seinen Zweck und da nehmen sich AMD und nVidia seit Jahren nichts..

Von Wirtschaft hast du genauso wenig Ahnung wie von manchen Dingen scheinbar auch nicht.

nVidia : kleine Stückzahl & große Margen

AMD : große Stückzahl & kleine Margen

Weniger als 15% kaufen teure GPUs für mehr als 300 oder 400€ - und deutlich weniger als 10% der Gamer zahlen mehr als 600€.

Und als Hausaufgabe darfst dich informieren, wie und warum man early adopter so behandelt, wie man sie behandelt!

Nochmal zu deinen Rekordverkäufen:

Es gibt keine offiziellen Zahlen dazu und ich erkläre es dir auch hier eine ausführlich.

Und ganz final nochmal für dich:

1. Sei still - einfach nur still. Vor allem wenn man keine Fakten in der Hand hat und dennoch "Wahrheiten" zu verbreiten versucht!

2. Wenn dir die RX 480 eh nicht zusagt und du mehr negative Punkte findest und sie nicht in Frage kommt. WAS willst du eigentlich hier? -> siehe 1.

3. Du widersprichst dir permanent und Tagesweise selbst in deinen Posts. -> also wieder ab zu 1.

Falscher Thread? Ich glaub von den Hier anwesenden würden alle zur 8GB oder überhaupt nicht zur RX 480 greifen!^^

Ich muss jetzt nochmal drastisch werden, Fimbim. HALT ENDLICH MAL DEN MUND. ES KOMMT ZU 99% GEQUIRLTE SCHEIßE AUS DIR RAUS. Wie kann man so auf seiner Meinung beharren, obwohl diese Meinung purer Müll ist?

Wir wissen, dass nVidia alles super macht und AMD alles schlecht.

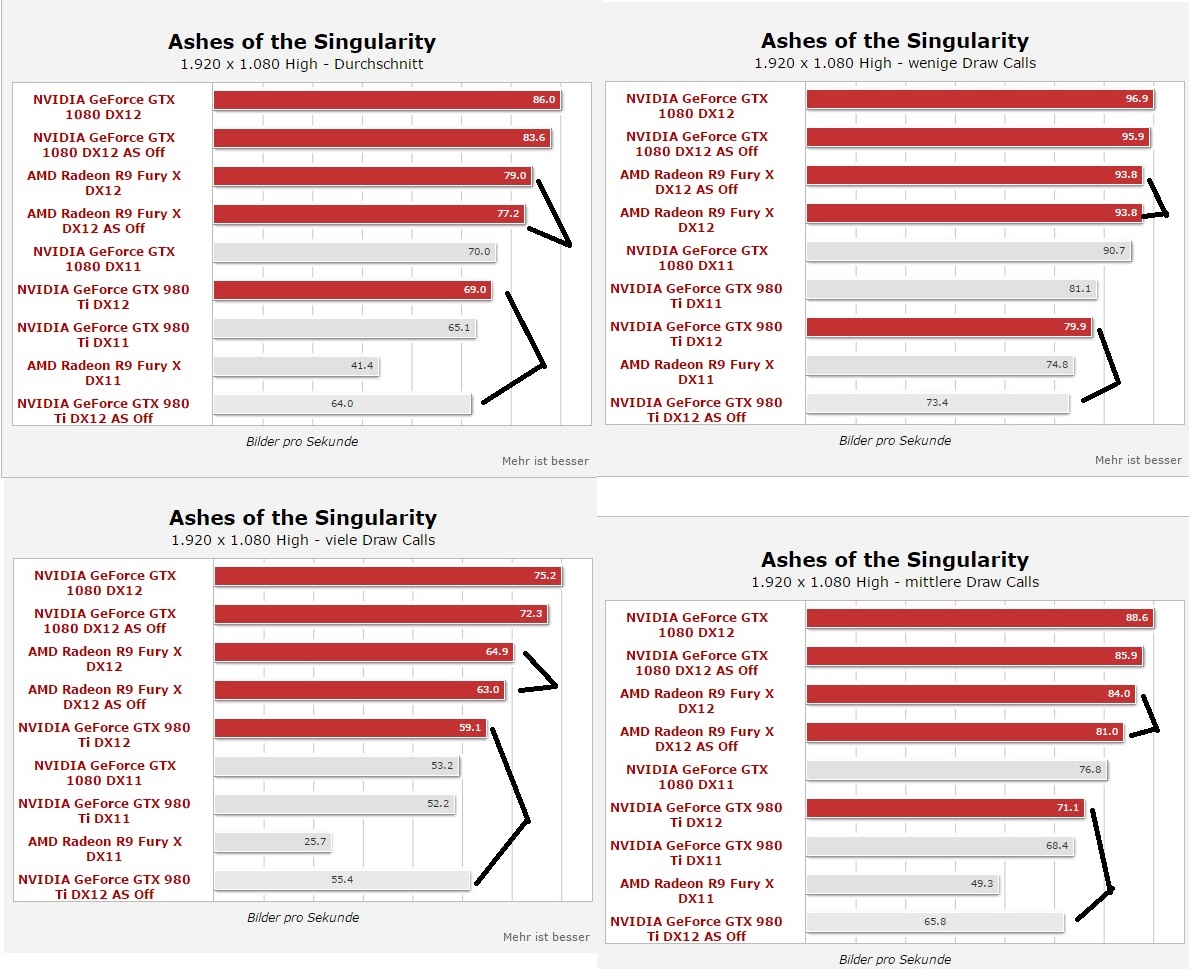

Die Fury X hatte nen zu hohen Verbrauch bei zu wenig Leistung? Die Leistung war @stock etwa gleichwertig mit einer 980Ti @stock. Ebenso die Stromaufnahme.

4GB HBM machen nicht früher dicht als 6GB GDDR bei einer Ti, ist dir Kompression ein Begriff?

Die 500$-Aussage ist immer noch auf die Buildquality bezogen. D.h. AMD hat nicht nur 3 Phasen verbaut und billige Komponenten, sondern alles gleichwertig zu den High End Karten. Raff es doch mal!!!!

Es ist einfach widerlich, was bei dir alles an Anti aus dem Maul kommt. Dieser Thread hier wäre ohne dich einfach absolut in Ordnung - auch mit Kritik, aber ruhig.

Simuliert A-Shader über die CPU. Das hat mit der Grafikkarte wenig gemein und wie schon mehr als einmal geschrieben wird, bekommt man als Tester einen speziellen Pressetreiber zugeschickt, der die Hälfte der Funktionen abschaltet, damit es überhaupt irgendwie lauffähig wird.

Die Leistung einer 1070 gibts in Form der 980Ti auch schon seit bald 2 Jahren. Nur die 1080 bringt wirklich eine neues single GPU Niveau (sofern wir 980Ti OC nicht zählen lassen).Ja, wers glaubt, wird selig. Diese Leistung gibt es schon seit 3 Jahren+ zu kaufen ( erste Titan ), wirklich neu ist nur die der GTX 1070 und GTX 1080.

Die Käufer werden alleine schon daher dezimiert, weil die Käuferschaft bereits mit solch einer Leistung versorgt ist.

Das heißt der geringe Preis wird die Marktateile von AMD kaum verbessern, wenn schon >5000 Stück von GP104 in einem einzigen Shop nicht mal in einem einzigen Monat verkauft sind.

Ach, kurzes PCB = schlechte Qualität? Na dann. Heißt also, nen GTX260 ist ne hochwertigere Karte als eine 980Ti? Denk doch vor dem Posten mal nach.Na wenigstens jemand der nachdenkt, ich meine das PCB ist ja auch viel kürzer als das von 500 Euro Lösungen, AMD wollte wie Nvidia einfach die Kundschaft für blöd verkaufen.

Das wird nicht erkannt, weil die AMD Jungs genau wie die Nvidia Jungs völlig verblendet sind und das verteidigen.

Leute: Low Preis --> Low Qualität/Kosten/Aufwand ist doch klar.

Laut Benchmarks machts bei NV Null Unterschied, weil CPU emulierte ASyncs eben nutzlos und dumm sind. CPU emuliertes ASync geht genau am eigentlichen Sinn und Zweck von ASync vorbei. Man verliert durch die Emulation halt alles an Leistung, das echtes HW-ASync rausholen würde.NV kanns CPU emuliert und laut benchmarks machts Null Unterschied.

du hast doch noch nicht mal nen Plan welche Features DX12 mit sich bringt. und welche man davon beherrschen muss, um DX12 auf die Verpackung zu drucken oder ob es da überhaupt irgendwelche Vorgaben gibt, die von irgendwem kontrolliert werden. du legst das doch nur aufgrund von Schlagzeilen, die dir passen, nach deinem Gutdünken aus.

ne Diskussion ohne 2 unterschiedliche Standpunkte ist keine Diskussion. das wär dann Hypen.

Laut Benchmarks machts bei NV Null Unterschied, weil CPU emulierte ASyncs eben nutzlos und dumm sind. CPU emuliertes ASync geht genau am eigentlichen Sinn und Zweck von ASync vorbei. Man verliert durch die Emulation halt alles an Leistung, das echtes HW-ASync rausholen würde.