DOCa Cola

Enthusiast

ja, klar, als gutscheinHL2 Episode 2 jawohl nur als Gutschein, wann kommt das denn eigentlich mal raus? Ich wäre bereit

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

ja, klar, als gutscheinHL2 Episode 2 jawohl nur als Gutschein, wann kommt das denn eigentlich mal raus? Ich wäre bereit

BOAH

von der Preis/Leistung her macht die X2900XT ja die G80 wirklich übelst platt. Da gibts nichts dran zu rütteln.

BOAH

von der Preis/Leistung her macht die X2900XT ja die G80 wirklich übelst platt. Da gibts nichts dran zu rütteln.

bei einigen Games kommt die 2900XT nichtmal an eine 8600GTS mit 128bit SI ran, wasn das ?

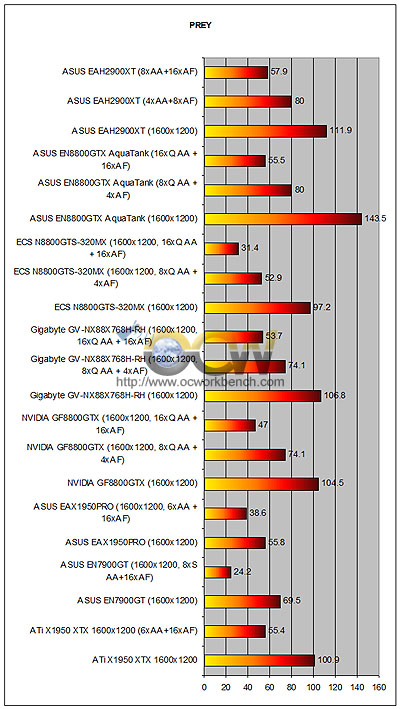

Wenn es nachden Benchmarks von OCfs geht dann konnte das durchaus stimmen.Die X2900 XT liegt erstaunlicherweise knapp unter 8800 GTX

http://666kb.com/i/aob82e5g5xo2j3fht.jpg[/img

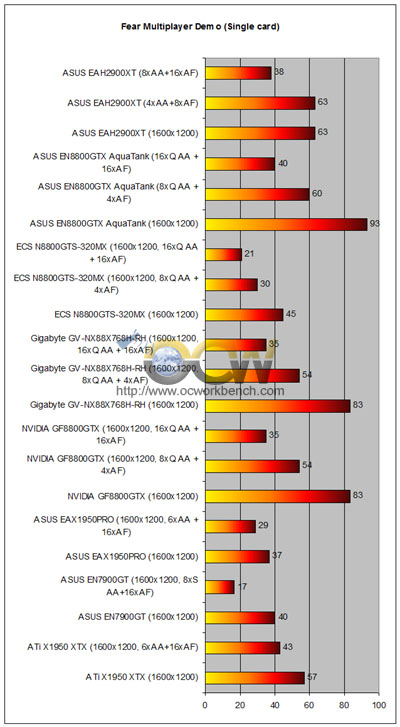

[img]http://666kb.com/i/aob82n7hma55y48xd.jpg[/img

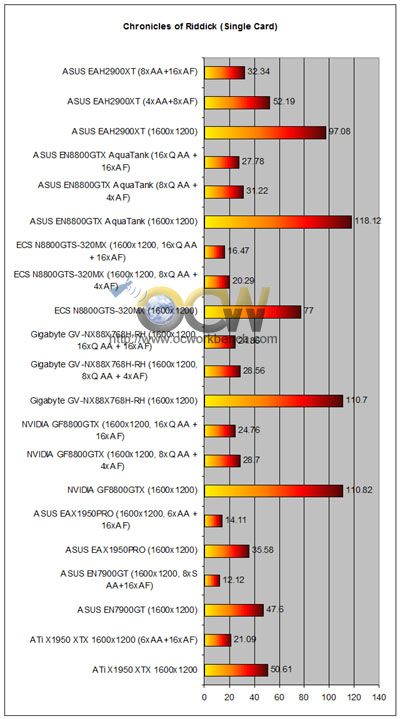

[img]http://666kb.com/i/aob82xjmx1ge8cvu9.jpg[/img

Der Riddick wert ist intressant.Normalerweise klar ne Nv Domäne.[/QUOTE]

Du kannst den Nvidia 8xQ AA Modus nicht mit dem der 2900 vergleichen...

Ach meinst denn unbedeuteten Wert ohne AA?Ob 90 oder 130 FPS ist doch egal.Viel intressanter sind da alle werte.....

PS:Launchtreiber gegen Launchtreiber,das nenn ich Fair.:shoot:

Juuuuuuungs, aufwachen, die Tests sind alle für den Popo, wartet auf CB, die testen mit gleicher BQ, aktuellen Treibern und die testen richtig, den Werten konnte man schon immer vertrauen.

Vor dem CB-Test fälle ich noch kein Urteil!

die bis vor nem halben jahr noch mit nem 4000+ San Diego Single Core gebencht haben

die bis vor nem halben jahr noch mit nem 4000+ San Diego Single Core gebencht haben

immer diese leeren versprechungen.Naja also das Ding ist 100mal für mich gestorben.

öhh passt ne thermaltak toughpower mit 750watt??

Im Idle verbraucht die Karte knapp 5 Watt weniger als der G80, unter Volllast sind es "nur" 17 Watt mehr ,was etwa auf 160 Watt schließen lässt und damit ist der R600-Stromverbrauch noch unter meinen Schätzungen von 180 Watt!!!

Zu den Screenshots sage ich vorerst nichts, außer, dass niemand die BQ zu genau untersucht. Wenn man die beiden Karten mit der BQ anschaut, wirkt das Bild des R600 etwas schwammig.

Die Performance ist ungefähr unter 8800GTX-Niveau mit Tendez gleichzuschließen. Die Treiber sind gut, aber eben nicht auf Performancebasis. Da muss noch einiges getan werden. Bei Dx10 wird der R600 nochmals 10% oder mehr dazugewinnen und damit über die Geforce 8800GTX liegen.

Der Lüfter ist leiser als von der X1950XTX, jedoch lauter als von der 8800GTX.

Ansonsten mein vorläufiges Fazit:

Die Karte positioniert sich optimal mit den 360€. Sie wird ihre Käufer finden. Nach meiner Meinung ist sie der typische R520, jedoch noch viel extremer.

Die Karte wird in Zukunft ihre Stärken zeigen können, die schwächen bleiben und zwar nicht zu knapp.

mfg Nakai

Und was passiert, wenn "Vertex und Geometrieberechnungen" weniger als 4 Komponenten verwenden?

Der G80 hat nur 8x2 Recheneinheiten, die für 16 Pixel genau eine Komponente berechnen.

Ein r600 benötigt 16 Recheneinheiten, um die für 16 Pixel 3 Komponenten zu berechnen. Zwar geschieht dies in einem Takt, dafür bleiben nur noch 48 Recheneinheiten übrig, bei nVidia ganze 7(!) Recheneinheiten.

Ausserdem gibt es einen anderen D3D10 Test, in dem die 8800GTX um Faktor 6 schneller ist.

Bis DX10 gamez draußen sind gibt es von ATI und NV schon wieder was neues und somit sind diese Karten eh schon veraltet.

Als ob du dich besser auskennst.t.t das wage ich zu bezweifeln......

Die Vertexshader sind nicht umsonst 4+1.

In jedem TCP sind 2 MIMD-Kanäle. In jedem dieser MIMD-Kanäle ist eine Vec8-ALU(SIMD) drin.

Imho sind es 16 MIMD-Kanäle.

Jeder Shader des R600 rechnet immer an einen Pixel. Gemäß dem Falle, dass alle Shader des R600 mit einer Vec3-Op ausgelastet werden, ebenso wie alle Shader des G80, so kommt der Schluß, dass der R600 hier besser ist.

Wenn man jetzt an Pixelberechnungen denkt, fällt auf, dass der G80 nach 3 Takten dann 128 Pixel ausspuckt. Der R600 kann 192 Pixel ausspucken.

In dem von mir angegebenen Test wurde fast ausschließlich die Geometrieperformance angeschaut. Und da sieht man wie schnell der R600 sein kann.

Jedoch wurde angemerkt, dass der G80 noch ein paar Probleme damit hat.

(Treiber!)

Im Schnitt sollte der R600 etwa 50 bis 100% schneller in Vertex- und Geoberechnungen sein.

mfg Nakai

Frage an

@Wombat /

@Speedlimiter

ist das AA wirklich so schlecht bei der HD2900 XT, denn es sieht echt matschig aus. Oder kann man den Blur Filter deaktivieren um so eine normale mit dem G80 aufschliessende BQ zu erreichen.

Dies wäre natürlich für uns Kunden oder auch Nichtkunden sicherlich äußerst von Bedeutung.

Also seid ihr beide mal wieder gefragt.

Bitte euer Statement dazu!

. Aber wartet doch mal auf ein Review einer bekannten dt. Seite die hier schon genannt wurde. Allerdings weiss ich nicht genau, ob da schon die Werte aus den aktuellen Treiber mit einfließen. Aber einen Nachtest gibts bestimmt. Auf jeden Fall ist die AF-BQ mit dem .38 wieder besser. Diese scheiX sensationsgeilen Redakteure (@VR-Zone & Co.) , da kann man ja keinen vernünftigen Test erwarten.

. Aber wartet doch mal auf ein Review einer bekannten dt. Seite die hier schon genannt wurde. Allerdings weiss ich nicht genau, ob da schon die Werte aus den aktuellen Treiber mit einfließen. Aber einen Nachtest gibts bestimmt. Auf jeden Fall ist die AF-BQ mit dem .38 wieder besser. Diese scheiX sensationsgeilen Redakteure (@VR-Zone & Co.) , da kann man ja keinen vernünftigen Test erwarten.