Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Auf Niveau einer RTX 3090 Ti: Fünf Modelle der GeForce RTX 4070 Ti im Test

- Ersteller HWL News Bot

- Erstellt am

- Mitglied seit

- 19.05.2006

- Beiträge

- 1.314

- Ort

- am Grill

- Desktop System

- Knecht

- Laptop

- Lenovo T416

- Details zu meinem Desktop

- Prozessor

- i9-9900K@5GHz allcore

- Mainboard

- ASUS Maximus XI Formula

- Kühler

- Aqua Computer kryos CU @ directDie

- Speicher

- 4x8GB 4266MHz CL16-16-16-32

- Grafikprozessor

- RTX3070@H2O@2.1XGHz

- Display

- ACER XB270HU

- SSD

- 1x970EVO 2TB 1x950PRO512GB

- Opt. Laufwerk

- ist da

- Soundkarte

- TOPPING NX4 @AKG702T4

- Gehäuse

- Silverstone TJ-09

- Netzteil

- BQuiet Dark Power Pro 850W

- Keyboard

- Razer Black Widdow

- Mouse

- G502

- Sonstiges

- alles unter Wasser und leise :-)

- Internet

- ▼100k ▲50M

Kleiner Fehler in der Einleitung: Im Vergleich zur 3070ti wird hier beim Speicherinterface gar nichts kaschiert. Denn auch die 3070ti hatte GDDR6X-Speicher! Nur die normale 3070 hatte GDDR6-Speicher...

Erntedanker

Profi

- Mitglied seit

- 28.12.2022

- Beiträge

- 41

Frage in die Runde: Wie bestimme ich die anzusetzende Taktrate die ich zum undervolten ansetze? Hier bei der 4070 TI TUF non OC. Setzt man einfach den Basistakt von 2310 MHz an?

- Mitglied seit

- 04.03.2008

- Beiträge

- 6.496

- Ort

- Hannover

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix B650E-F Gaming WIFI

- Kühler

- Custom Wasserkühlung

- Speicher

- 32GB CORSAIR DOMINATOR PLATINUM 6000Mhz CL28-36-36-36-36

- Grafikprozessor

- Palit GeForce RTX 4080 GameRock

- Display

- Xiaomi G Pro 27i & HP X34

- SSD

- WD_BLACK SN 850 1TB & Kingston KC3000 1TB

- Gehäuse

- Fractal Design TG Light Tint RGB

- Netzteil

- Thermaltake Toughpower GF1 750W

- Keyboard

- ROG Strix Flare II Animate

- Mouse

- RAZER BASILISK V3 PRO + Razer Mouse Dock Pro

- Betriebssystem

- Windows 10

- Sonstiges

- Samsung Galaxy Z Fold4

- Internet

- ▼1082 ▲54

Schau mal hier vorbei;

www.hardwareluxx.de

www.hardwareluxx.de

[Sammelthread] - NVIDIA RTX4000 Undervolting-Sammler

Hi zusammen, dadurch dass es noch keinen derartigen Thread gibt, fangen wir einfach mal an. Die 4090 bietet sich ja hervorragend an für UV ERGEBNISSE Curve 4090er Karten mit 875mv (maximal 310w statt 450+w, ingame oft um die 200w) KFA2 4090 SG - 2610Mhz @ 0,875mv MSI Supreme X - 2610Mhz @...

Gagapa

Experte

- Mitglied seit

- 07.09.2018

- Beiträge

- 311

Zum Thema 192 bit bus ist zu wenig, das stimmt garnicht, weil es immernoch 192bit gddrx6 sind, außerdem läuft die karte mit 21 gbs, mit vram oc sogar 23gbs, schneller als eine 3090er. Das einzige was limitieren könnte ist die Speichergröße von 12gb und nicht die 192 bit Speichergeschwindigkeit.

Hallo, ich wollte die ASUS nehmen, bin aber etwas unsicher geworden, da laut benchmarks (in diesem artikel) die 1% lows und generell die fps niedriger ausfallen als bei den anderen custom modellen…wie kommt das? Bitte um Aufklärung🙏

Lg, Stefan

…und die iChill schneidet für mich hier in jeder Hinsicht am besten ab…am sparsamsten, beste fps, am leisesten, optisch auch top…wow. Nur die 3 8-pin stecker hindern mich an den kauf…

Lg, Stefan

Beitrag automatisch zusammengeführt:

…und die iChill schneidet für mich hier in jeder Hinsicht am besten ab…am sparsamsten, beste fps, am leisesten, optisch auch top…wow. Nur die 3 8-pin stecker hindern mich an den kauf…

MrSl

Enthusiast

- Mitglied seit

- 13.02.2015

- Beiträge

- 737

- Ort

- Winterthur (CH)

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800x3d

- Mainboard

- MSI MPG X570S Carbon Max WiFi

- Kühler

- Arctic Liquid Freezer III 360

- Speicher

- Team Group Extreme 64 GB DDR4-3600 - 4x16GB CL 18 @4000 Mhz

- Grafikprozessor

- MSI Suprim X RTX 4080

- Display

- Alienware AW3423DWF

- SSD

- Patriot Viper VPN100 M.2 512 GB / Samsung 980 Pro EVO 2TB

- HDD

- 4TB Datengrab

- Soundkarte

- Nubert Nuboxx A-125 Pro (DAC)

- Gehäuse

- ABK Case Wall-Mount

- Netzteil

- Be quiet Straight Power 11 Platinum 1000w

- Keyboard

- Logitech G915 Lightspeed

- Mouse

- Logitech G502 Lightspeed

- Betriebssystem

- Win 11 Pro

- Sonstiges

- 12.6“ Sensor Panel - Bambu Lab X1C 3D Drucker - GoXLR Mini - Elgato Streamdeck MKII

- Internet

- ▼10Gbit/s ▲10Gbit/s

Naja, wie gross kann der FPS unterschied denn in realen Szenarien sein? Lass dich nicht davon beeinflussen. Leistungstechnisch wirst du mit jeder 4070ti zufrieden sein.

Zuletzt bearbeitet:

Tech Enthusiast

Enthusiast

- Mitglied seit

- 01.01.2016

- Beiträge

- 3.609

- Desktop System

- PC

- Laptop

- Surface

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 - 5950X

- Mainboard

- Asus Dark Hero x570

- Kühler

- Noctua NH D15

- Speicher

- 32gb - Vengeance 3200

- Grafikprozessor

- PNY RTX 4090

- Display

- 4-eckig

- SSD

- 2tb Samsung 970 Evo

- Gehäuse

- Define zu alt

- Netzteil

- Asus Thor 850W

- Betriebssystem

- Windows 10

- Webbrowser

- Chrome

- Internet

- ▼1150 MBit ▲54 MBit

Messtoleranz. Die 1% Lows schwanken immer extrem.Naja es sind immerhin gute 10fps unterschied in den lows, das ist viel! Und nicht nur bei einem spiel, irgendwie schwächelt die TUF besonders…sehr seltsam.

Sie bilden ja einen Worst-Case ab, der nicht immer auftritt. Würde ich ignorieren. 4070 TI ist 4070 TI. Kein Hersteller macht daraus eine bessere oder schlechtere GPU.

Solange Du kein Blower Kühler findest, sind die alle einigermaßen identisch, bis auf die Temperaturen und Lautstärke der Lüfter. Und beides hat keine Auswirkung auf die Leistung, weil selbst die heißeste 40er Gen GPU noch gute 25-30 Grad unter dem Limit agiert.

Wieso stören Dich so Stecker?…und die iChill schneidet für mich hier in jeder Hinsicht am besten ab…am sparsamsten, beste fps, am leisesten, optisch auch top…wow. Nur die 3 8-pin stecker hindern mich an den kauf…

Die Ada Architektur funktioniert großartig mit wenig Strom. Ob da nun 2, 3 oder 4 Stecker sind, macht bei der 4070 TI keinen Unterschied, weil sie so viel Strom eh nicht zieht. Ist eigentlich reines Marketing, damit Leute meinen da würde mehr OC gehen. Was zwar in der Theorie stimmen mag, aber in der Praxis, bei diesen Karten, keine Relevanz hat.

>>>>>>>>>>Messtoleranz. Die 1% Lows schwanken immer extrem.

Sie bilden ja einen Worst-Case ab, der nicht immer auftritt. Würde ich ignorieren. 4070 TI ist 4070 TI. Kein Hersteller macht daraus eine bessere oder schlechtere GPU.

Bei den anderen Karten konnte ich das nicht beobachten aber ok…^^

Hab damit einen schlechte Erfahrung (mit den 1% lows aKa Micro-ruckler, da ich momentan eine 6900xt besitze…habe alles probiert; temps, minimal takt, im BIOS schlummer modus deaktiviert, fps cap, overclocking, von 5600x auf 5800x 3D gewechselt, und und und… es ist jetzt teils besser geworden, aber ganz weg sind sie nicht, die ruckler, deshalb möchte ich jetzt auf die 4070ti umsteigen…hatte zuerst die 4080 im visier, aber mein prozessor würde diese „bottelnecken“… das widerspiegeln einige videos auf youtube, außerdem spiele ich auf 2k, da ist die 4080 overpower.

Man hat mir grundsätzlich gesagt, das nvidia bessere treiber haben und deshalb in erster linie mehr bzw. besser performen…bin schon sehr gespannt ob dann alles besser wird

______________________________

Wieso stören Dich so Stecker?

Die Ada Architektur funktioniert großartig mit wenig Strom. Ob da nun 2, 3 oder 4 Stecker sind, macht bei der 4070 TI keinen Unterschied, weil sie so viel Strom eh nicht zieht. Ist eigentlich reines Marketing, damit Leute meinen da würde mehr OC gehen. Was zwar in der Theorie stimmen mag, aber in der Praxis, bei diesen Karten, keine Relevanz hat.

>>>>>>>>>>>

Bin einwenig ästhetik freak und stehe nicht besonders auf unnötige kabel, da der adapter ja eh schon so schirch ist😂 und alle anderen TI‘s haben 2, verstehe nicht ganz wozu noch ein weiterer 8er…

MrSl

Enthusiast

- Mitglied seit

- 13.02.2015

- Beiträge

- 737

- Ort

- Winterthur (CH)

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800x3d

- Mainboard

- MSI MPG X570S Carbon Max WiFi

- Kühler

- Arctic Liquid Freezer III 360

- Speicher

- Team Group Extreme 64 GB DDR4-3600 - 4x16GB CL 18 @4000 Mhz

- Grafikprozessor

- MSI Suprim X RTX 4080

- Display

- Alienware AW3423DWF

- SSD

- Patriot Viper VPN100 M.2 512 GB / Samsung 980 Pro EVO 2TB

- HDD

- 4TB Datengrab

- Soundkarte

- Nubert Nuboxx A-125 Pro (DAC)

- Gehäuse

- ABK Case Wall-Mount

- Netzteil

- Be quiet Straight Power 11 Platinum 1000w

- Keyboard

- Logitech G915 Lightspeed

- Mouse

- Logitech G502 Lightspeed

- Betriebssystem

- Win 11 Pro

- Sonstiges

- 12.6“ Sensor Panel - Bambu Lab X1C 3D Drucker - GoXLR Mini - Elgato Streamdeck MKII

- Internet

- ▼10Gbit/s ▲10Gbit/s

Ich habe auch die Asus TUF Gaming OC.. Da ist nur ein Adapter auf 2x 8 Pin bei.. Nicht 3x..

Edit: Ups, du meintest die iChill hat 3x8. Sorry.

Edit: Ups, du meintest die iChill hat 3x8. Sorry.

Ahab geht ab

Urgestein

- Mitglied seit

- 29.12.2014

- Beiträge

- 1.280

>>>>>>>>>

Bei den anderen Karten konnte ich das nicht beobachten aber ok…^^

Hab damit einen schlechte Erfahrung (mit den 1% lows aKa Micro-ruckler, da ich momentan eine 6900xt besitze…habe alles probiert; temps, minimal takt, im BIOS schlummer modus deaktiviert, fps cap, overclocking, von 5600x auf 5800x 3D gewechselt, und und und… es ist jetzt teils besser geworden, aber ganz weg sind sie nicht, die ruckler, deshalb möchte ich jetzt auf die 4070ti umsteigen…hatte zuerst die 4080 im visier, aber mein prozessor würde diese „bottelnecken“… das widerspiegeln einige videos auf youtube, außerdem spiele ich auf 2k, da ist die 4080 overpower.

Man hat mir grundsätzlich gesagt, das nvidia bessere treiber haben und deshalb in erster linie mehr bzw. besser performen…bin schon sehr gespannt ob dann alles besser wird

______________________________

Wieso stören Dich so Stecker?

Die Ada Architektur funktioniert großartig mit wenig Strom. Ob da nun 2, 3 oder 4 Stecker sind, macht bei der 4070 TI keinen Unterschied, weil sie so viel Strom eh nicht zieht. Ist eigentlich reines Marketing, damit Leute meinen da würde mehr OC gehen. Was zwar in der Theorie stimmen mag, aber in der Praxis, bei diesen Karten, keine Relevanz hat.

>>>>>>>>>>>

Bin einwenig ästhetik freak und stehe nicht besonders auf unnötige kabel, da der adapter ja eh schon so schirch ist😂 und alle anderen TI‘s haben 2, verstehe nicht ganz wozu noch ein weiterer 8er…

Lieber ne 4070ti weil ne 4080 von nem 5800X3D geflaschenhalst wird? 🫡

Edit...öschendwie funzten die spoilers per Smartphone net so wie gewollt ✌

flyerdommo

Experte

- Mitglied seit

- 11.06.2019

- Beiträge

- 47

- Details zu meinem Desktop

- Prozessor

- Ryzen 5700X

- Mainboard

- Gigabyte X570 I Pro WiFi

- Kühler

- Noctua NH-L9a-AM4

- Speicher

- 32 GB DDR4-3200 RAM

- Grafikprozessor

- Nvidia RTX 4080 FE

- Display

- Eizo CG2700X

- SSD

- Gigabyte Aorus NVMe SSD (2 TB)

- Gehäuse

- Fractal Design Terra

- Netzteil

- Corsair SF750

- Keyboard

- Mode 65, Taco 75

- Mouse

- Logitech MX Vertical

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Mozilla Firefox

Mich hat an den getesteten Modellen enttäuscht, dass sie durchgehend mindestens drei Slots belegen. Damit gibt es im SFF-Bereich auch weiterhin kaum Alternativen für klassische Gehäuse (DAN A4, Ghost S1 etc.). Hinsichtlich der Preise, die natürlich niemanden begeistern, habe ich den Eindruck, dass man nicht umhin kommt, viel Geld in die Hand zu nehmen, wenn man einen 4K-Monitor besitzt und hohe Leistung haben will. Für Full HD und m.E. auch für WQHD sind RTX 4070Ti, 4080 und 4090 schlicht Overkill. In puncto Temperaturen, Leistung und Effizienz (teils auch im Idle) ist die RTX 4x00-Generation spitzenklasse.

- Mitglied seit

- 17.07.2003

- Beiträge

- 4.372

- Ort

- Dresden

- Desktop System

- SecondWorld

- Details zu meinem Desktop

- Prozessor

- 7800X3D

- Mainboard

- Asus ROG Strix B650E-F

- Kühler

- NZXT Kraken Z73

- Speicher

- 2 x 16 Gb DDR5-6000 CL30 G.Skill Trident Z5 Neo RGB

- Grafikprozessor

- PNY GeForce RTX 4090 XLR8 Gaming Verto Epic-X RGB Overclocked

- Display

- Alienware AW3225QF

- SSD

- Western Digital WD_BLACK SN850X NVMe SSD 2TB + Western Digital WD_BLACK SN850X NVMe SSD 4TB

- Soundkarte

- 2x MINX MIN22 + Topping MX3s, Audeze Maxwell

- Gehäuse

- Thermaltake Core P3 TG Pro schwarz

- Netzteil

- Corsair HX1200 Platinum

- Keyboard

- Keychron K4 V2

- Mouse

- Logitech G Pro X Superlight

- Betriebssystem

- Windows 11

- Webbrowser

- Chrome

- Internet

- ▼1000mBit ▲50Mbit

Also für 1440p ist eine 4070Ti nicht unbedingt Overkill. Aber stimmt dahingehend dass im Grunde schon die 3000er "good enough" für 1440p waren und die 4070Ti halt da jetzt keinen mega krassen Unterschied mehr macht. Will man allerdings Richtung 240fps in 1440p sieht die Sache schon anders aus.

Gurkengraeber

Legende

- Mitglied seit

- 10.03.2005

- Beiträge

- 11.477

- Ort

- Düsseldorf

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-12700K

- Mainboard

- Asus Prime Z690-A

- Kühler

- Alpenföhn Gletscherwasser White 280

- Speicher

- 48GB G.Skill Trident Z5 RGB white DDR5-7600 CL38 @ 6800MT/s

- Grafikprozessor

- Gigabyte GeForce RTX 4090 Aero OC

- Display

- Samsung Odyssey G7A LS28AG700NUXEN

- SSD

- M.2 1TB Crucial P5 & M.2 2TB Samsung Evo 970 Plus

- Gehäuse

- NZXT H7 Flow White

- Netzteil

- Seasonic Prime PX-850

- Betriebssystem

- Windows 11 Pro

Wenn Du ein Ästhet bist (bin ich auch) und auf cleane Looks stehst, dann kaufst Du Dir sowieso ein entsprechendes Kabel von Fasgear, Cablemod oder den Netzteilherstellern und es gibt nur noch einen Strang zur PSU im sichtbaren Bereich des Gehäuses.Bin einwenig ästhetik freak und stehe nicht besonders auf unnötige kabel, da der adapter ja eh schon so schirch ist😂 und alle anderen TI‘s haben 2, verstehe nicht ganz wozu noch ein weiterer 8er…

Also davon nicht beeinflussen lassen beim Kauf. Ich glaube eher dass Du aktuell noch gar nicht klar hast, ob Du überhaupt upgraden willst.

Habe es getan bin umgestiegen von 6900xt auf 4070ti und bin recht froh darüber, performance besser, ruckler deutlich weniger, wenn nicht ganz weg, aber mit einpaar einstellungen im nvidia panel wurden auch die beseitigt…jetzt hab ich nur noch in farcry6 paar ruckler hin und wieder wenn gespeichert wird und in einigen passagen in CS:GO, aber anscheinend ist die 1440p auflösung so sensibel/komplex, dass man ganz ohne ruckler nicht auskommt…

CPU ist die 5800x3D, vielleicht liegt es an AMD…

In Full-HD hatte ich damals nie stutterings, ich kannte dieses „problem“ noch gar nicht vor 2k…

4k soll dann wieder nur GPU lastig sein, sodas es kaum 0.1% lows gibt, dafür muss man halt sich mit weniger fps zufrieden geben, uf ist das alles heikel^^

Da ich die möglichkeit hätte würde ich noch die 4080 testen und dann eine ruhe geben😅 vielleicht sind die 0.1% / 1% lows da besser…aber laut benchmarks hält sich der unterschied in grenzen.

CPU ist die 5800x3D, vielleicht liegt es an AMD…

In Full-HD hatte ich damals nie stutterings, ich kannte dieses „problem“ noch gar nicht vor 2k…

4k soll dann wieder nur GPU lastig sein, sodas es kaum 0.1% lows gibt, dafür muss man halt sich mit weniger fps zufrieden geben, uf ist das alles heikel^^

Da ich die möglichkeit hätte würde ich noch die 4080 testen und dann eine ruhe geben😅 vielleicht sind die 0.1% / 1% lows da besser…aber laut benchmarks hält sich der unterschied in grenzen.

Belo79

Enthusiast

- Mitglied seit

- 30.11.2010

- Beiträge

- 1.627

- Ort

- Nähe Koblenz

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 9800X3D

- Mainboard

- MSI X870 Tomahawk

- Kühler

- Noctua NHU12A Chromax Black

- Speicher

- Cosair Vengeance RGB CL30

- Grafikprozessor

- MSI RTX 4090 Suprim X

- Display

- LG GL850

- SSD

- WD Black 750 1TB; Samsung EVO Plus 960 500GB; Crucial MX500 1TB

- Soundkarte

- Fiio K5 Pro

- Gehäuse

- Fractal Define R6

- Netzteil

- Cosair RM1000X

- Keyboard

- Sharkoon Pure Writer

- Mouse

- Logitech Pro

- Betriebssystem

- Windows 11

- Internet

- ▼VDSL 250

Kann eventuell an deinen Einstellungen liegen. V Sync im Treiber auf immer EIN einstellen, die FPS ein paar unter deiner HZ Zahl des Monitors fixieren und natürlich Gsync einschalten.

Oh okey, hab nämlich v-sync ausgeschalten, da ich tearing hatte…aber dann die fps auf 160 fixiert (habe einen 165hz monitor), davor war es ohne fps limit und tatsächlich, das tearing ist weg…

Also kann ich ohne bedenken wieder v-sync einschalten, kannst du mit erklären wieso? Viele meinen ausgeschalten wäre es besser, und fps fanatiker schalten es immer in den game settings aus…

Danke finde die seite super hilfreich und toll

finde die seite super hilfreich und toll

Also kann ich ohne bedenken wieder v-sync einschalten, kannst du mit erklären wieso? Viele meinen ausgeschalten wäre es besser, und fps fanatiker schalten es immer in den game settings aus…

Danke

finde die seite super hilfreich und toll

finde die seite super hilfreich und toll

GSync muss natürlich global an sein. Wenn dann VSync aus ist und die Framerate über die Hz Zahl des Monitors steigt, dann hast Du Tearing, weil dann nicht mehr synchronisiert wird. Wenn VSync an ist, würde ab 165 Hz (bei Deinem Monitor) auf die Frequenz des Monitors synchronisiert.Oh okey, hab nämlich v-sync ausgeschalten, da ich tearing hatte…aber dann die fps auf 160 fixiert (habe einen 165hz monitor), davor war es ohne fps limit und tatsächlich, das tearing ist weg…

Also kann ich ohne bedenken wieder v-sync einschalten, kannst du mit erklären wieso? Viele meinen ausgeschalten wäre es besser, und fps fanatiker schalten es immer in den game settings aus…

Dankefinde die seite super hilfreich und toll

Die Framerate extra zu limitieren kann man machen und das ist etwas besser für die Latenz als wenn man die Frequenz des Monitors übersteigt, aber das dürften bei 165Hz die allerwenigsten Menschen merken (ich würde eher sagen: Das merkt KEIN Mensch).

Bei eingeschaltetem DLSS Frame Generation (also known as DLSS3) verhält es sich anders. Aber die CS:GO ist das ja kein Thema.

SpoOokY1983

Profi

- Mitglied seit

- 02.01.2023

- Beiträge

- 52

- Ort

- NRW

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600 @ CO -30 all core, +200Mhz PBO Override, BCLK 102Mhz = 5.457 MHz

- Mainboard

- ASRock B650E Phantom Gaming Riptide WiFi, Bios 1.28

- Kühler

- Alphacool Eisbaer LT240 Aurora AIO Digital RGB

- Speicher

- 32GB (2x 16GB) Kingston FURY Beast EXPO RGB DDR5-6000 DIMM CL36-38-38 Dual Kit @ CL30-36-36-36

- Grafikprozessor

- INNO3D GeForce RTX 4070 Ti X3 12GB @ +110/1.400 Mhz (PL 210 Watt)

- Display

- Iiyama GB3271QSU-B1, 31,5“ WQHD 165Hz

- SSD

- 2TB WD SN850X | 1TB Kingston KC3000

- Gehäuse

- NZXT H5 FLOW ALL Black MidiTower mit Sichtfenster

- Netzteil

- 850 Watt Chieftec Chieftronic PowerUp GPX-850FC Modular 80+ Gold

- Keyboard

- Logitech K835 TKL TTC red USB

- Mouse

- Logitech G402

- Betriebssystem

- Windows 11

- Internet

- ▼500 Mbit ▲250 Mbit

Puh, was habe ich schlaflose Nächte hinter mir. Meine Inno3D lief auf knapp unter 3Ghz Core bei allen Games stabil. Nur Witcher 3 hat mich wahnsinnig gemacht, weil es mit FG andauernd stuttert und dann abschmiert. Habe die CPU wieder auf Default gesetzt, RAM Timings auf Jedec. Trotzdem Abstürze. Und was ist? GPU auf maximal 2.850 MHz und es läuft smooth und stabil. Witcher 3 ist damit für mich der absolute Endgegner in Sachen Graka OC 😂.

Verstanden, vielen DankGSync muss natürlich global an sein. Wenn dann VSync aus ist und die Framerate über die Hz Zahl des Monitors steigt, dann hast Du Tearing, weil dann nicht mehr synchronisiert wird. Wenn VSync an ist, würde ab 165 Hz (bei Deinem Monitor) auf die Frequenz des Monitors synchronisiert.

Die Framerate extra zu limitieren kann man machen und das ist etwas besser für die Latenz als wenn man die Frequenz des Monitors übersteigt, aber das dürften bei 165Hz die allerwenigsten Menschen merken (ich würde eher sagen: Das merkt KEIN Mensch).

Bei eingeschaltetem DLSS Frame Generation (also known as DLSS3) verhält es sich anders. Aber die CS:GO ist das ja kein Thema.

Gibt es eigentlich Nachteile von V-sync, weil viele Gamer es deaktiviert bevorzugen…?

Ich habe das Gefühl dass ich das beste Resultat erziele wenn v-sync aus ist und fps limit auf 160 gesetzt ist.

VSync an/aus macht keinen Unterschied, wenn man GSync nutzt und die Framerate immer unterhalb der Maximalfrequenz des Monitors bleibt, und das tut es, wenn Du das Limit auf 160fps setzt.Verstanden, vielen Dank

Gibt es eigentlich Nachteile von V-sync, weil viele Gamer es deaktiviert bevorzugen…?

Ich habe das Gefühl dass ich das beste Resultat erziele wenn v-sync aus ist und fps limit auf 160 gesetzt ist.

Vorsicht: Bei einigen Spielen funktioniert die in-game VSync Einstellung nicht gut. Deswegen besser über den Treiber an oder auszwingen, was einem besser gefällt.

Ich hasse Tearing und habe deswegen VSync immer an, achte aber auch darauf, die maximale Frequenz des Monitors nicht zu erreichen.

Terr0rSandmann

Legende

- Mitglied seit

- 19.06.2010

- Beiträge

- 32.126

- Ort

- Potsdam

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- Asus ROG Strix B650E-I ITX

- Kühler

- Coolermaster 120mm Aio @ Noctua NF-A12x25

- Speicher

- G.Skill Flare X5 32GB 6000 CL36

- Grafikprozessor

- Asus RTX 4090 TUF OC

- Display

- Alienware AW3225QF

- SSD

- Samsung 980 Pro OEM 1TB, Kingston Fury Renegade 2TB

- Soundkarte

- Burson Soloist 3X GT + Topping Centaurus + Dan Clark Expanse

- Gehäuse

- Coolermaster Ncore 100 Max @ Noctua NF-A12x25

- Netzteil

- SilverStone Extreme EX850R SFX

- Keyboard

- Qwertykeys QK75N

- Mouse

- Razer Viper Mini Wireless Signature Edition @ Wallhack MO-001

- Betriebssystem

- Windows 11 64-bit Home

- Sonstiges

- Apple iPhone 15 Pro + Apple iPad Pro 11 M1

Wieso? Ist der 5800X3D nicht immer noch eine Top3 CPU, wenn es ums Gaming geht? Kann mir kaum vorstellen, dass der zum Bottleneck wird (außer man spielt nur FullHD oder so, aber da schaut man sicher eh nicht nach ~1000€ GPUs)Lieber ne 4070ti weil ne 4080 von nem 5800X3D geflaschenhalst wird? 🫡

Ahab geht ab

Urgestein

- Mitglied seit

- 29.12.2014

- Beiträge

- 1.280

Joar, dann lies nochmal. Deshalb habe ich das ja so wiederholt. Weil die 4080 vom 5800X3D geflaschenhalst wird, kauft er lieber ne 4070Ti. Kann man machen

Tech Enthusiast

Enthusiast

- Mitglied seit

- 01.01.2016

- Beiträge

- 3.609

- Desktop System

- PC

- Laptop

- Surface

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 - 5950X

- Mainboard

- Asus Dark Hero x570

- Kühler

- Noctua NH D15

- Speicher

- 32gb - Vengeance 3200

- Grafikprozessor

- PNY RTX 4090

- Display

- 4-eckig

- SSD

- 2tb Samsung 970 Evo

- Gehäuse

- Define zu alt

- Netzteil

- Asus Thor 850W

- Betriebssystem

- Windows 10

- Webbrowser

- Chrome

- Internet

- ▼1150 MBit ▲54 MBit

Weil die Specs nicht 1:1 auf neue Generationen umgerechnet werden können.Warum ist eine 3090Ti eigentlich vergleichsweise langsam wenn man sich die Specs anschaut ? Warum kriegt die diese brachiale Rohleistung "nicht auf den Bildschirm" ?

Finde sie hat auch zu wenig Mehrleistung gegenüber der 3090 ohne "Ti".

Obwohl.... eigentlich passts. Aber schon erstaunlich was für ein Schritt die 4000er Serie ist. Die 4080 wäre für mich sehr interessant, aber zu teuer und für das was sie leistet evtl. zu wenig VRAM.

Die 4070Ti ist ja fast auf Augenhöhe mit der 3090Ti. Aber generell finde ich spart nv da sehr am RAM.

Obwohl.... eigentlich passts. Aber schon erstaunlich was für ein Schritt die 4000er Serie ist. Die 4080 wäre für mich sehr interessant, aber zu teuer und für das was sie leistet evtl. zu wenig VRAM.

Die 4070Ti ist ja fast auf Augenhöhe mit der 3090Ti. Aber generell finde ich spart nv da sehr am RAM.

Zuletzt bearbeitet:

SpoOokY1983

Profi

- Mitglied seit

- 02.01.2023

- Beiträge

- 52

- Ort

- NRW

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600 @ CO -30 all core, +200Mhz PBO Override, BCLK 102Mhz = 5.457 MHz

- Mainboard

- ASRock B650E Phantom Gaming Riptide WiFi, Bios 1.28

- Kühler

- Alphacool Eisbaer LT240 Aurora AIO Digital RGB

- Speicher

- 32GB (2x 16GB) Kingston FURY Beast EXPO RGB DDR5-6000 DIMM CL36-38-38 Dual Kit @ CL30-36-36-36

- Grafikprozessor

- INNO3D GeForce RTX 4070 Ti X3 12GB @ +110/1.400 Mhz (PL 210 Watt)

- Display

- Iiyama GB3271QSU-B1, 31,5“ WQHD 165Hz

- SSD

- 2TB WD SN850X | 1TB Kingston KC3000

- Gehäuse

- NZXT H5 FLOW ALL Black MidiTower mit Sichtfenster

- Netzteil

- 850 Watt Chieftec Chieftronic PowerUp GPX-850FC Modular 80+ Gold

- Keyboard

- Logitech K835 TKL TTC red USB

- Mouse

- Logitech G402

- Betriebssystem

- Windows 11

- Internet

- ▼500 Mbit ▲250 Mbit

Ich habe das BIOS meiner regulären Inno3D 4070-ti X3 non-oc nun auf das der Inno3D 4070-ti IChill mit 320 Watt anstatt 285 Watt Powerlimit geflashed. Und Zack, die 2,9 Ghz laufen stabil und selbst im Fullscreen Furrmark läuft die Karte nun mehr als 100 Mhz höher. GPU-Z zeigt auch knapp über 320 Watt Powerdraw der Karte an 👍🏻.

SpoOokY1983

Profi

- Mitglied seit

- 02.01.2023

- Beiträge

- 52

- Ort

- NRW

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600 @ CO -30 all core, +200Mhz PBO Override, BCLK 102Mhz = 5.457 MHz

- Mainboard

- ASRock B650E Phantom Gaming Riptide WiFi, Bios 1.28

- Kühler

- Alphacool Eisbaer LT240 Aurora AIO Digital RGB

- Speicher

- 32GB (2x 16GB) Kingston FURY Beast EXPO RGB DDR5-6000 DIMM CL36-38-38 Dual Kit @ CL30-36-36-36

- Grafikprozessor

- INNO3D GeForce RTX 4070 Ti X3 12GB @ +110/1.400 Mhz (PL 210 Watt)

- Display

- Iiyama GB3271QSU-B1, 31,5“ WQHD 165Hz

- SSD

- 2TB WD SN850X | 1TB Kingston KC3000

- Gehäuse

- NZXT H5 FLOW ALL Black MidiTower mit Sichtfenster

- Netzteil

- 850 Watt Chieftec Chieftronic PowerUp GPX-850FC Modular 80+ Gold

- Keyboard

- Logitech K835 TKL TTC red USB

- Mouse

- Logitech G402

- Betriebssystem

- Windows 11

- Internet

- ▼500 Mbit ▲250 Mbit

Kurze Frage. Hat die 4070-ti eigentlich ein Voltage-Cap nach oben hin bei 1,1v? Ich habe auf meine Inno3D X3 das MSI SuprimX Bios geflashed und bekomme in GPU-Z immer den Vrel-Status. Im Afterburner scheint der Voltage-Slider keinen Einfluss auf die Spannung zu haben. Übersehe ich hier etwas?

Edit: Der Slider funktioniert doch, zumindest irgendwie. Bei 100% mehr Spannung habe ich 50mv effektiv mehr. Das sollte nochmal einen kleinen Boost geben, ich will die 3Ghz stabil .

.

Edit2: Sieht gut aus und gibt nochmal ein Bisschen mehr FPS:

Edit: Der Slider funktioniert doch, zumindest irgendwie. Bei 100% mehr Spannung habe ich 50mv effektiv mehr. Das sollte nochmal einen kleinen Boost geben, ich will die 3Ghz stabil

.

.Edit2: Sieht gut aus und gibt nochmal ein Bisschen mehr FPS:

Zuletzt bearbeitet:

n3cron

Enthusiast

- Mitglied seit

- 13.05.2020

- Beiträge

- 6.538

- Ort

- DE - BY - MILF

- Details zu meinem Desktop

- Prozessor

- Intel Core i7 13700K 16 (8+8) 3.40GHz So.1700

- Mainboard

- MSI Tomahawk WIFI Intel Z790 So. 1700

- Kühler

- be quiet! Silent Loop 2 360mm All-in-One

- Speicher

- 64GB (2x 32GB) G.Skill Ripjaws S5 weiss DDR5-5600 DIMM CL28

- Grafikprozessor

- Gigabyte Nvidia RTX 3080 Gaming OC 10G

- Display

- Xiaomi Mi Curved Gaming Monitor 34" 144hz@ UWQHD 3440*1440

- SSD

- Samsung 990Pro 2 TB, Samsung 970 Evo Plus M.2 2280 PCIe 3.0 x4 3D-NAND TLC

- Opt. Laufwerk

- -

- Soundkarte

- -

- Gehäuse

- be quiet! Silent Base 802

- Netzteil

- 750 Watt be quiet! Dark Power 13 Modular 80+ Titanium

- Betriebssystem

- Windows 11 Pro

- Internet

- ▼950 Mbit ▲600 Mbit

Weil Nvidia das nicht möchte/konnte. Die haben von Anfang an quasi ne Ente verkauft. Auf dem Papier ein echter Titan, aber wenn der sich bewegt wie ein Faultier. Die haben es nicht hinbekommen alle Shader ordentlich auszulasten. Sieht man auch an dem geringeren Abstand zur 3080TI&3080 12G.Warum ist eine 3090Ti eigentlich vergleichsweise langsam wenn man sich die Specs anschaut ? Warum kriegt die diese brachiale Rohleistung "nicht auf den Bildschirm" ?

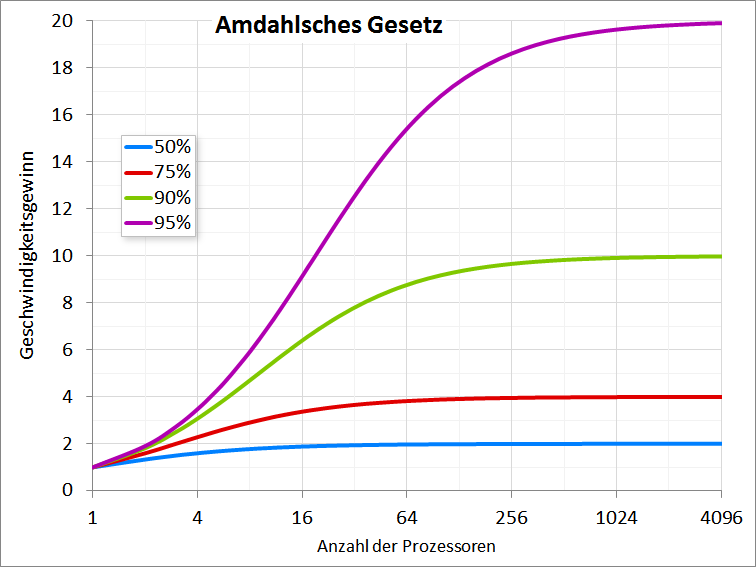

Amdahlsches Gesetz – Wikipedia

Das müssen alle Hersteller "Gewinnen" damit sie ihre X Tausend "Kerne" zu 100% effizient auslasten können.

Gerade bei den Großen Karten sinkt diese Effizienz proportional zur Anzahl.

So kann es sein das 16K Shader nur 60% effektiv sind verglichen mit 10K die 100% schaffen, dazu Taktraten & Abwärme.. und natürlich die Speicheranbindung & Auslastung.

Da wo Echtzeit keine Rolle spielt wie Encoding etc. ist es leichter die Kerne richtig auslasten zu können.

Deshalb können die in synthetischen Benchmarks abheben und haben aber dann die Bremse hier und da in den Spielen.

Nvidias Trick war hier immer gleichzeitig Raytracing und DLSS Kerne auch zu erhöhen mit jeder Leistungsstufe. Persönlich vermute ich da einfach das Marketing dahinter.

Natürlich läuft die 3090TI mit Raytracing weit aus schneller als eine 3070TI, die Frage ist die ich mir hier stelle wie gut würde die 3070TI unter ähnlichen Voraussetzungen laufen mit ggf. 12-16 GB Speicher, gleichen RT-Kernen und Tensor(DLSS) Kernen. Man sieht es auch daran das AMD ohne Raytracing und DLSS im vergleich mit "Standard" Rechenleistung in der Regel immer etwas die Nase vorne hatte dank Infinity Cache.

Der Abstand 6900XT zu 3090/TI ist relativ gering. AMD kann/konnte durchaus in Shaderleistung gleich ziehen.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 183

- Aufrufe

- 13K

- Antworten

- 19

- Aufrufe

- 3K

- Antworten

- 23

- Aufrufe

- 4K

- Antworten

- 8

- Aufrufe

- 2K