Ditoerhöht den WAF für die gesamte IT ganz enorm.

Wenn das Internet ausfällt, ist hier Polen offen... :-/

Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

ESX / ESXi - Hilfethread

- Ersteller XTaZY

- Erstellt am

Trambahner

Urgestein

Kurze Info: X570D4U-2L2T mit 5600X funktioniert wunderbar mit ESXI 7.01 U1c  (ersetzt X11SSH-CTF mit E3-1240v5; der Ryzen hat in etwa die doppelte CPU Power (das Board erlaubt PBO2+OC) )

(ersetzt X11SSH-CTF mit E3-1240v5; der Ryzen hat in etwa die doppelte CPU Power (das Board erlaubt PBO2+OC) )

Passthrough von einem 9400-16i und einer P400 Quadro (nach den üblichen settings) funktionieren. Den Amd-Satacontroller war nicht möglich, durchzureichen. Naja, eh erstmal genug SAS-Ports da,

Die Shell berichtet bei meinen Modulen ( 4x M391A2K43BB1-CTD, laufen @ 3066CL18)

Passthrough von einem 9400-16i und einer P400 Quadro (nach den üblichen settings) funktionieren. Den Amd-Satacontroller war nicht möglich, durchzureichen. Naja, eh erstmal genug SAS-Ports da,

Die Shell berichtet bei meinen Modulen ( 4x M391A2K43BB1-CTD, laufen @ 3066CL18)

Code:

# smbiosDump | grep ECC

ECC: 0x06 (Multi-bit)

ECC: 0x06 (Multi-bit)

ECC: 0x06 (Multi-bit)

ECC: 0x06 (Multi-bit)

Data Width: 64 bits (+8 ECC bits)

Data Width: 64 bits (+8 ECC bits)

Data Width: 64 bits (+8 ECC bits)

Data Width: 64 bits (+8 ECC bits)

Zuletzt bearbeitet:

Ja, hab das Board auch. Im großen und ganzen bin ich zufrieden damit (sieht man von der ASRock-üblichen nicht ganz so guten BIOS/UEFI-Qualität ab... ). Bei servethehome.com hab ich auch einen Thread zu meinem Build.

Bezüglich meinem Post #8057 in dem es um das Problem mit den Netzwerkkarten geht bin ich mittlerweile weiter gekommen ( da es unter anderem ein ESXi-Problem ist für diejenigen, die es interessiert):

Es ist so, dass es unter ESXi (und wie ich meine auch bei gewissen Konstellationen mit Barebone-Systemen*) Probleme durch (Neu-)Adressierung der virtuellen PCIe-Adressen von Netzwerkkarten (und wahrscheinlich auch allen anderen virtuellen PCIe-devices) gibt. ESXi würfelt nämlich die Adressierung von PCIe-Devices unter gewissen Umständen durcheineinander, wenn man neue virtuelle Hardware hinzufügt. Das kann zur Folge haben, dass je nach OS im Gastsystem die Konfiguration zerwürfelt wird und sich das System nicht mehr so verhält wie gewohnt. Wer dazu mehr wissen will: Im OPNsense-Forum hab ich dazu einen Thread eröffnet, der noch erweitert wird.

*Das Problem wurde mir auch von einem Freund berichtet, der eine OPNsense direkt auf Hardware installiert hat. Nachdem er die Grundinstallation mit der Onboard-NIC und einer USB-NIC (für WAN und LAN-Interface) durchgeführt hat, hat er eine Intel Pro Quad PCIe-Karte eingebaut. Danach hat es ihm die Grundkonfiguration verhagelt, so dass WAN und LAN nicht mehr richtig zugewiesen wurden.

Ich hab ihm dann empfohlen im UEFI/BIOS des Mainbords den Punkt "PCIe ARI support" und "PCIe ARI enumeration" von Auto auf Disabled zu stellen, weil ich vermutet habe dass man dieses Problem damit weg bekommen könnte. Es scheint so, als wäre das Problem seitdem weg.

Die Infos zu PCIe ARI im Internet sind etwas spärlich (gibts unter dem Namen auch nur bei AMD? bei Intel heißt es wohl anders), aber scheinbar erlaubt diese Funktion, die Neuadressierung von PCIe-Geräten. Ich kenne die genauen Umstände der Neuadressierung nicht. Soll heißen: Ich weiß nicht ob dies alleine vom UEFI durchgeführt wird wenn man was an der Hardware ändert, ob die Adressierung alleine vom Betriebssystem durchgeführt wird oder ob das ein Zusammenspiel aus UEFI und OS ist. Diese Adressierung scheint sich jedoch immer dann zu ändern, wenn man was an der physischen Hardware bzw. der VM-Hardware ändert (z.B. hinzufügen von vNICs). Während man es bei manchen Boards im UEFI abstellen kann, kann man das bei ESXi nicht so einfach. Dafür muss man gewisse config files von ESXi editieren (mehr dazu ist im oben verlinkten OPNsense-Forum verlinkt).

Kurz und knapp ist es auch hier zusammengefasst:

kb.vmware.com

kb.vmware.com

Bezüglich meinem Post #8057 in dem es um das Problem mit den Netzwerkkarten geht bin ich mittlerweile weiter gekommen ( da es unter anderem ein ESXi-Problem ist für diejenigen, die es interessiert):

Es ist so, dass es unter ESXi (und wie ich meine auch bei gewissen Konstellationen mit Barebone-Systemen*) Probleme durch (Neu-)Adressierung der virtuellen PCIe-Adressen von Netzwerkkarten (und wahrscheinlich auch allen anderen virtuellen PCIe-devices) gibt. ESXi würfelt nämlich die Adressierung von PCIe-Devices unter gewissen Umständen durcheineinander, wenn man neue virtuelle Hardware hinzufügt. Das kann zur Folge haben, dass je nach OS im Gastsystem die Konfiguration zerwürfelt wird und sich das System nicht mehr so verhält wie gewohnt. Wer dazu mehr wissen will: Im OPNsense-Forum hab ich dazu einen Thread eröffnet, der noch erweitert wird.

*Das Problem wurde mir auch von einem Freund berichtet, der eine OPNsense direkt auf Hardware installiert hat. Nachdem er die Grundinstallation mit der Onboard-NIC und einer USB-NIC (für WAN und LAN-Interface) durchgeführt hat, hat er eine Intel Pro Quad PCIe-Karte eingebaut. Danach hat es ihm die Grundkonfiguration verhagelt, so dass WAN und LAN nicht mehr richtig zugewiesen wurden.

Ich hab ihm dann empfohlen im UEFI/BIOS des Mainbords den Punkt "PCIe ARI support" und "PCIe ARI enumeration" von Auto auf Disabled zu stellen, weil ich vermutet habe dass man dieses Problem damit weg bekommen könnte. Es scheint so, als wäre das Problem seitdem weg.

Die Infos zu PCIe ARI im Internet sind etwas spärlich (gibts unter dem Namen auch nur bei AMD? bei Intel heißt es wohl anders), aber scheinbar erlaubt diese Funktion, die Neuadressierung von PCIe-Geräten. Ich kenne die genauen Umstände der Neuadressierung nicht. Soll heißen: Ich weiß nicht ob dies alleine vom UEFI durchgeführt wird wenn man was an der Hardware ändert, ob die Adressierung alleine vom Betriebssystem durchgeführt wird oder ob das ein Zusammenspiel aus UEFI und OS ist. Diese Adressierung scheint sich jedoch immer dann zu ändern, wenn man was an der physischen Hardware bzw. der VM-Hardware ändert (z.B. hinzufügen von vNICs). Während man es bei manchen Boards im UEFI abstellen kann, kann man das bei ESXi nicht so einfach. Dafür muss man gewisse config files von ESXi editieren (mehr dazu ist im oben verlinkten OPNsense-Forum verlinkt).

Kurz und knapp ist es auch hier zusammengefasst:

VMware Knowledge Base

Zuletzt bearbeitet:

Es ist ein FreeBSD Problem, wenn nicht sogar auch eins von ander *nix Systemen. Ich bin nämlich auch schon über ein, zwei Quellen gestolpert, bei denen Leute mit Linux (ich glaub es war Red Hat) von ähnlichen Problemen berichtet haben. Find nur grad die entsprechenden Websites dazu nicht mehr

EDIT: z.B. hier : https://serverfault.com/questions/614216/how-do-i-control-the-ordering-of-network-interfaces

Im Grunde wäre das Problem ja ganz einfach zu fixen (zumindest im Zusammenhang mit Netzwerkkarten). Man müsste einfach noch die MAC abfragen. Ändert sich dann die PCIe-Adresse hinter einer MAC, könnte man die Zuordnung zum device-name (em0 / vmx0 etc.) einfach über die MAC-Adresse wieder korrigieren. Es bräuchte lediglich einen Automatismus, der das selbst macht. Die Möglichkeit dazu gibts nämlich schon:

# ifconfig em0 name eth0

(gefunden hier in den Antworten)

EDIT: z.B. hier : https://serverfault.com/questions/614216/how-do-i-control-the-ordering-of-network-interfaces

Im Grunde wäre das Problem ja ganz einfach zu fixen (zumindest im Zusammenhang mit Netzwerkkarten). Man müsste einfach noch die MAC abfragen. Ändert sich dann die PCIe-Adresse hinter einer MAC, könnte man die Zuordnung zum device-name (em0 / vmx0 etc.) einfach über die MAC-Adresse wieder korrigieren. Es bräuchte lediglich einen Automatismus, der das selbst macht. Die Möglichkeit dazu gibts nämlich schon:

# ifconfig em0 name eth0

(gefunden hier in den Antworten)

Zuletzt bearbeitet:

Weltherrscher

Enthusiast

- Mitglied seit

- 28.04.2008

- Beiträge

- 948

Kann ich jetzt so nicht bestätigen, zumindest am Desktop war die QNAP unter Linux immer enp2s0 und seitdem die Intel im selben Slot steckt, ist diese enp2s0.

Musste dadurch nicht mal was an der VLAN-Konfig ändern.

Also wohl eher ein BSD-Ding.

Dass die USB-Enumeration ab und an mal neue IDs würfelt, ist kein Geheimnis, da muss nur einmal ein Gerät schneller / langsamer antworten und dann wars das.

Würde auf ner *sense niemals mit USB-NEtzwerkkarten ackern.

Musste dadurch nicht mal was an der VLAN-Konfig ändern.

Also wohl eher ein BSD-Ding.

Dass die USB-Enumeration ab und an mal neue IDs würfelt, ist kein Geheimnis, da muss nur einmal ein Gerät schneller / langsamer antworten und dann wars das.

Würde auf ner *sense niemals mit USB-NEtzwerkkarten ackern.

Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

Jetzt muss ich auch hier nochmal in den Thread rein...

Stelle hier gerade alles auf Mikrotik um, aber 10G und ESXI möchte partout nicht laufen.

Folgende Hardwarekombi:

- ESXI 6.7

- Dell Broadcom BCM57810S 10G Netzwerkkarte

- MikroTik CRS328-24P-4S+RM 10G Switch

Folgende Transceiver im Einsatz:

- Broadcom Karte: Finisar FTLX8571D3BCL SFP+ GBIC Modul 850nm

- Mikrotik Switch: Intel AFBR-709DMZ-IN2 UND AUCH MIT DIGITUS 10 Gbit Universal SFP+ Modul, Multimode, LC Duplex, 850 nm, 300 Meter, 10 Gbit/s versucht

- StarTech.com 15m Multimode 50/125 Duplex Glasfaser Kabel genutzt

In ESXI wird auch der Port der Karte erkannt als 10Gbit und im Mikrotik Switch werden auch die Transceiver angezeigt (auch mit entsprechenden Infos zum Transceiver).

Aber ich bekomme, was auch immer ich versuche (Uplink hinzufügen in ESXI), KEINE Verbindung zum Switch hin. Habe auch schon ein DIGITUS LWL Patch-Kabel OM4 LSZH - Duplex Multimode 50/125µ - 10 GBit/s probiert, genau dasselbe Ergebnis.

Ist dort ESXI so zickig oder bin ich nur zu blöd noch irgendwo eine Einstellung zu setzen? Bin echt ratlos mittlerweile.

Stelle hier gerade alles auf Mikrotik um, aber 10G und ESXI möchte partout nicht laufen.

Folgende Hardwarekombi:

- ESXI 6.7

- Dell Broadcom BCM57810S 10G Netzwerkkarte

- MikroTik CRS328-24P-4S+RM 10G Switch

Folgende Transceiver im Einsatz:

- Broadcom Karte: Finisar FTLX8571D3BCL SFP+ GBIC Modul 850nm

- Mikrotik Switch: Intel AFBR-709DMZ-IN2 UND AUCH MIT DIGITUS 10 Gbit Universal SFP+ Modul, Multimode, LC Duplex, 850 nm, 300 Meter, 10 Gbit/s versucht

- StarTech.com 15m Multimode 50/125 Duplex Glasfaser Kabel genutzt

In ESXI wird auch der Port der Karte erkannt als 10Gbit und im Mikrotik Switch werden auch die Transceiver angezeigt (auch mit entsprechenden Infos zum Transceiver).

Aber ich bekomme, was auch immer ich versuche (Uplink hinzufügen in ESXI), KEINE Verbindung zum Switch hin. Habe auch schon ein DIGITUS LWL Patch-Kabel OM4 LSZH - Duplex Multimode 50/125µ - 10 GBit/s probiert, genau dasselbe Ergebnis.

Ist dort ESXI so zickig oder bin ich nur zu blöd noch irgendwo eine Einstellung zu setzen? Bin echt ratlos mittlerweile.

Zuletzt bearbeitet:

Ceiber3

Urgestein

- Mitglied seit

- 21.11.2011

- Beiträge

- 4.923

- Desktop System

- Master System

- Laptop

- P775TM1G i9-9900k, 16 GB Ram, 1 TB NVMe, GTX 1070

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix X670E-I Gaming WIFI

- Kühler

- Externer 1280mm Supernova mit D5 Pumpe und OCTO Steuerung

- Speicher

- 48 GB DDR5-6000 CL30 von Corsair

- Grafikprozessor

- Manli RTX 4090 Gallardo 24 GB DDR6X

- Display

- 3440x1440, 200Hz, HDR1000, Lichtsensor, G-Sync Ultimate

- SSD

- 1x 5.0 M.2 Crucial T700 2 TB OS - 1x 4.0 M.2 Samsung 990 PRO 4 TB Gaming

- HDD

- Nop

- Opt. Laufwerk

- (p≧w≦q)

- Soundkarte

- Asus HIVE mit Optischen Kabel zur 7.1 Anlage

- Gehäuse

- MasterBox NR200P Mini ITX Gehäuse

- Netzteil

- Corsair SF1000 Platinum

- Betriebssystem

- Winerror und Linux Mint, Dualboot

- Webbrowser

- Nur der eine "Firefox"

- Internet

- ▼250 ▲40

Kleine Frage am rande, zickt bei euch auch so bissel ESXI 7.0b rum ?

Mit ESXI 6.7u3 läuft die Webgui richtig schnell, auf dem neuen System mit ESXI 7 läuft sie recht langsam und ich muss manchmal die Gui neu laden.

Auch bei VM's habe ich Probleme das der erste Virtuelle Port manchmal keine IP vom DHCP bekommt.

Was mir momentan ein wenig negativ auffällt, die neue Kiste brauch ganz schön viel Strom im Idle. AMD Prozessoren scheinen da noch nicht ganz so gut zu sein.

Mit ESXI 6.7u3 läuft die Webgui richtig schnell, auf dem neuen System mit ESXI 7 läuft sie recht langsam und ich muss manchmal die Gui neu laden.

Auch bei VM's habe ich Probleme das der erste Virtuelle Port manchmal keine IP vom DHCP bekommt.

Was mir momentan ein wenig negativ auffällt, die neue Kiste brauch ganz schön viel Strom im Idle. AMD Prozessoren scheinen da noch nicht ganz so gut zu sein.

Anhänge

Zuletzt bearbeitet:

Trambahner

Urgestein

Auf ab 7.01 U1c keine Probleme, alles smooth und reaktionsschnell in der WebGui.

Hab die Version genommen, weil man damit als Bootoption (systemMediaSize=min) sehr einfach den Rest des USB-Mediums als Datastore (nicht für scsi-vdisks nutzen, das gibt Fehler) nutzen kann.

Idlebedarf mit 7.01 U1c entspricht bei mir (X570D4U-2L2T und 5600X plus 9400-16i als HBA) ziemlich genau meiner alten Config X11SSH-CTF mit E3-1240v5. (+- 5W).

Daher bei mir keine Probleme mit dem Stromverbrauch, besser als erwartet.

Hab die Version genommen, weil man damit als Bootoption (systemMediaSize=min) sehr einfach den Rest des USB-Mediums als Datastore (nicht für scsi-vdisks nutzen, das gibt Fehler) nutzen kann.

Idlebedarf mit 7.01 U1c entspricht bei mir (X570D4U-2L2T und 5600X plus 9400-16i als HBA) ziemlich genau meiner alten Config X11SSH-CTF mit E3-1240v5. (+- 5W).

Daher bei mir keine Probleme mit dem Stromverbrauch, besser als erwartet.

Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

Keiner eine Idee zur Dell Broadcom 57810S 10Gbit Karte?

Ich bin *gefühlt* einen Schritt weiter.

- Firmware geupdatet auf 15.05.12 (müsste die aktuellste sein)

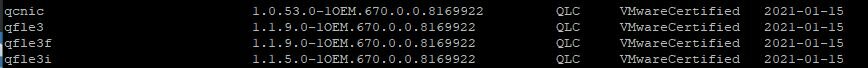

- Treiber auf ESXI 6.7U3 auf Stand gebracht (siehe Screenshot)

Nun kommt aber immer beim Neustart ein Pinkscreen...Und immer noch keine Verbindung zustand, Uplink war für wenige Sekunden da und dann weg.

Gibt's noch irgendwo Logs, wo etwas näheres geführt wird?

So, ich führe weiter Selbstgespräche...LÖSUNG für alle leidgeplagten:

1. FIRMWARE aktualisieren

2. Treiber wie folgt installieren

Host in den Wartungsmodus versetzen und erst einmal die alten Treiber löschen:

esxcli software vib remove --vibname=qcnic

esxcli software vib remove --vibname=qfle3

esxcli software vib remove --vibname=qfle3f

esxcli software vib remove --vibname=qfle3i

NEUSTART

- MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-16816395 einmal auf dem Laptop oder Desktop entpacken, sodass eine neue MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip erscheint.

- Per WinSCP auf dem Host, auf welchem SSH aktiviert ist, einloggen und in den tmp Ordner die MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip hochladen.

- esxcli software vib install -d /tmp/MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip zum installieren ausführen

- Host neu starten (!!!!)

-> Nun sollte es laufen.

Allerdings war dies bei mir nicht das ursächliche Problem, sondern dass der x4 Slot zu wenig Spannung für die Karte abgeworfen hat...Da hätte ich also noch hundert mal die Treiber aktualisieren können.

Die Broadcom 57810S MUSS also in einen x8 Slot rein...Bandbreitentechnisch mag das ja alles hinhauen (wie in meinem anderen Thread besprochen), aber der x4 Schacht wirft wohl zu wenig Spannung zum Betrieb ab. Nun nur hoffen, dass mein SAS2008 Controller, welchen TrueNAS nutzt, ausreichend Spannung (Leistung eher...) bekommt und nicht auch ewig abschmiert.

Ich bin *gefühlt* einen Schritt weiter.

- Firmware geupdatet auf 15.05.12 (müsste die aktuellste sein)

- Treiber auf ESXI 6.7U3 auf Stand gebracht (siehe Screenshot)

Nun kommt aber immer beim Neustart ein Pinkscreen...Und immer noch keine Verbindung zustand, Uplink war für wenige Sekunden da und dann weg.

Gibt's noch irgendwo Logs, wo etwas näheres geführt wird?

So, ich führe weiter Selbstgespräche...LÖSUNG für alle leidgeplagten:

1. FIRMWARE aktualisieren

2. Treiber wie folgt installieren

Host in den Wartungsmodus versetzen und erst einmal die alten Treiber löschen:

esxcli software vib remove --vibname=qcnic

esxcli software vib remove --vibname=qfle3

esxcli software vib remove --vibname=qfle3f

esxcli software vib remove --vibname=qfle3i

NEUSTART

- MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-16816395 einmal auf dem Laptop oder Desktop entpacken, sodass eine neue MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip erscheint.

- Per WinSCP auf dem Host, auf welchem SSH aktiviert ist, einloggen und in den tmp Ordner die MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip hochladen.

- esxcli software vib install -d /tmp/MRVL-E3-Ethernet-iSCSI-FCoE_2.0.123.1-1OEM.670.0.0.8169922-offline_bundle-16816395.zip zum installieren ausführen

- Host neu starten (!!!!)

-> Nun sollte es laufen.

Allerdings war dies bei mir nicht das ursächliche Problem, sondern dass der x4 Slot zu wenig Spannung für die Karte abgeworfen hat...Da hätte ich also noch hundert mal die Treiber aktualisieren können.

Die Broadcom 57810S MUSS also in einen x8 Slot rein...Bandbreitentechnisch mag das ja alles hinhauen (wie in meinem anderen Thread besprochen), aber der x4 Schacht wirft wohl zu wenig Spannung zum Betrieb ab. Nun nur hoffen, dass mein SAS2008 Controller, welchen TrueNAS nutzt, ausreichend Spannung (Leistung eher...) bekommt und nicht auch ewig abschmiert.

Anhänge

Zuletzt bearbeitet:

Hallo Boardies, als absoluter Neuling in Sachen ESXI und aufgrund meiner Krankheit schwindender Gehirnaktivität verzweifele ich gerade an den wahrscheinlich einfachsten Dingen.

Leider kann ich aufgrund meiner nur noch sehr begrenzten geistigen Aufnahmefähigkeit aus den vorhandenen HowTo`s kaum Nutzen ziehen. Wäre es möglich (gerne auch gegen Entlohnung)

mit einem der hier ansässigen Profis eventuell zu telefonieren und das Problem zu schildern? (Schreiben fällt mir schon wahnsinnig schwer)

Falls sich jemand erbarmen kann würde ich mich sehr über eine PM freuen.

Greetz Funne

Leider kann ich aufgrund meiner nur noch sehr begrenzten geistigen Aufnahmefähigkeit aus den vorhandenen HowTo`s kaum Nutzen ziehen. Wäre es möglich (gerne auch gegen Entlohnung)

mit einem der hier ansässigen Profis eventuell zu telefonieren und das Problem zu schildern? (Schreiben fällt mir schon wahnsinnig schwer)

Falls sich jemand erbarmen kann würde ich mich sehr über eine PM freuen.

Greetz Funne

MrPipes

Enthusiast

Hallo zusammen,

ich bin gerade dabei mir ein neue NAS zu konfigurieren (hatte vorher jahrelang ein QNAP).

Folgende Hardware ist verbaut.

Supermicro X11SCH-F

i3 9100

32GB ECC

500GB NVME

2x 8TB an SATA1+2 (AHCI)

16GB USB onboard mit ESXi 7.0.0 installiert

Ich möchte gerne TrueNAS virtualisieren und den SATA Controller durchreichen, nur finde ich den nicht in der Geräteübersicht.

Könnt Ihr mit Tipps geben, was ich hier vielleicht falsch mache.

Sry wenn die Frage blöd ist, aber ich komme hier gerade nicht weiter.

ich bin gerade dabei mir ein neue NAS zu konfigurieren (hatte vorher jahrelang ein QNAP).

Folgende Hardware ist verbaut.

Supermicro X11SCH-F

i3 9100

32GB ECC

500GB NVME

2x 8TB an SATA1+2 (AHCI)

16GB USB onboard mit ESXi 7.0.0 installiert

Ich möchte gerne TrueNAS virtualisieren und den SATA Controller durchreichen, nur finde ich den nicht in der Geräteübersicht.

Könnt Ihr mit Tipps geben, was ich hier vielleicht falsch mache.

Sry wenn die Frage blöd ist, aber ich komme hier gerade nicht weiter.

Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

Am Wochenende erst gemacht:Hallo zusammen,

ich bin gerade dabei mir ein neue NAS zu konfigurieren (hatte vorher jahrelang ein QNAP).

Folgende Hardware ist verbaut.

Supermicro X11SCH-F

i3 9100

32GB ECC

500GB NVME

2x 8TB an SATA1+2 (AHCI)

16GB USB onboard mit ESXi 7.0.0 installiert

Ich möchte gerne TrueNAS virtualisieren und den SATA Controller durchreichen, nur finde ich den nicht in der Geräteübersicht.

Könnt Ihr mit Tipps geben, was ich hier vielleicht falsch mache.

Sry wenn die Frage blöd ist, aber ich komme hier gerade nicht weiter.

1. SSH auf deinem ESXI Host aktivieren

2. Per WinSCP einloggen und nach der "Passthrough.map" suchen (wird auch manchmal anders geschrieben? Passthru.map oder dgl.)

3. Ganz am Ende folgendes einfügen:

Code:

#Intel AHCI Cannon Lake PCH-H AHCI Controller

8086 a352 d3d0 false4. Map speichern

5. Host neu starten

6. Jetzt müsste in deiner Übersicht der Cannon Lake AHCI Controller nicht mehr grau hinterlegt erscheinen

7. Passthrough umschalten

8. Erneuter Neustart vom Host

9. Durchreichen an TrueNAS, fertig ist die Laube

Nur wichtig zu wissen: Es funktioniert dann auch wirklich NUR noch durchgereicht. D.h. ALLE Sata-Anschlüsse gehen an TrueNAS über, wenn du dort noch nen Datastorage für ESXI hattest -> Ist nicht. Maximal per NFS / ISCSI einbinden.

MrPipes

Enthusiast

Danke für die schnelle Hilfe, werde ich so durchführen...habe gerade nochmal alles frisch gemacht.

Datastorage vom ESXi liegt auf der SSD.

Datastorage vom ESXi liegt auf der SSD.

Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

Das ist kein Thema.Danke für die schnelle Hilfe, werde ich so durchführen...habe gerade nochmal alles frisch gemacht.

Datastorage vom ESXi liegt auf der SSD.

NVME ist unabhängig davon, müsstes sonst mal im Handbuch deines Mainboards schauen, wenn das so nicht klappt.

Einige Schnittstellen sind geteilt am Chipset / der CPU dran.

MrPipes

Enthusiast

Hat geklappt, der AHCI wird nun angezeigt...Bin noch neu bezüglich des ESXi und dessen Konfiguration etc...muss also noch viel lernen und bevor ich das System einsetze wird noch

Zeit vergehen, das QNAP läuft solange noch parallel.

Zeit vergehen, das QNAP läuft solange noch parallel.

Ceiber3

Urgestein

- Mitglied seit

- 21.11.2011

- Beiträge

- 4.923

- Desktop System

- Master System

- Laptop

- P775TM1G i9-9900k, 16 GB Ram, 1 TB NVMe, GTX 1070

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix X670E-I Gaming WIFI

- Kühler

- Externer 1280mm Supernova mit D5 Pumpe und OCTO Steuerung

- Speicher

- 48 GB DDR5-6000 CL30 von Corsair

- Grafikprozessor

- Manli RTX 4090 Gallardo 24 GB DDR6X

- Display

- 3440x1440, 200Hz, HDR1000, Lichtsensor, G-Sync Ultimate

- SSD

- 1x 5.0 M.2 Crucial T700 2 TB OS - 1x 4.0 M.2 Samsung 990 PRO 4 TB Gaming

- HDD

- Nop

- Opt. Laufwerk

- (p≧w≦q)

- Soundkarte

- Asus HIVE mit Optischen Kabel zur 7.1 Anlage

- Gehäuse

- MasterBox NR200P Mini ITX Gehäuse

- Netzteil

- Corsair SF1000 Platinum

- Betriebssystem

- Winerror und Linux Mint, Dualboot

- Webbrowser

- Nur der eine "Firefox"

- Internet

- ▼250 ▲40

Also ESXI für Rendering/Gaming VM mit RTX 3090 taugt mir schon mal überhaupt nicht.

1. Die Grafikkarte zeigt bei Last im Gaming oder Rendering immer mal wieder Blackscreen. VM läuft weiter, Grafikkarte zeigt aber kein Bild mehr. Die RTX Karte scheint die PCIe Verbindung zur WIndows 10 VM zu verlieren. Erst dachte ich es liegt am Netzteil, das kann ich aber jetzt komplett ausschließen.

2. Die Leistung ist um welten schlechter in der VM als unter reinen Windows 10. Wir schreiben hier um etwa 100 bis 110 FPS Unterschied zwischen VM Windows 10 und direkt Windows 10.

ESXI + WIndows 10 VM + 3090:

Erster lauf:

www.3dmark.com

Zweiter lauf:

www.3dmark.com

Zweiter lauf:

www.3dmark.com

www.3dmark.com

Windows 10:

www.3dmark.com

www.3dmark.com

Edit: Habe jetzt das ganze nochmal über UnRaid als Hypervisor probiert und hier bekomme ich 0 Blackscreens und die Grafikperfomance ist sehr gut.

www.3dmark.com

www.3dmark.com

1. Die Grafikkarte zeigt bei Last im Gaming oder Rendering immer mal wieder Blackscreen. VM läuft weiter, Grafikkarte zeigt aber kein Bild mehr. Die RTX Karte scheint die PCIe Verbindung zur WIndows 10 VM zu verlieren. Erst dachte ich es liegt am Netzteil, das kann ich aber jetzt komplett ausschließen.

2. Die Leistung ist um welten schlechter in der VM als unter reinen Windows 10. Wir schreiben hier um etwa 100 bis 110 FPS Unterschied zwischen VM Windows 10 und direkt Windows 10.

ESXI + WIndows 10 VM + 3090:

Erster lauf:

I scored 20 245 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16384 MB, 64-bit Windows 10}

I scored 27 835 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16384 MB, 64-bit Windows 10}

Windows 10:

I scored 32 068 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 32768 MB, 64-bit Windows 10}

Edit: Habe jetzt das ganze nochmal über UnRaid als Hypervisor probiert und hier bekomme ich 0 Blackscreens und die Grafikperfomance ist sehr gut.

I scored 28 357 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16382 MB, 64-bit Windows 10}

Zuletzt bearbeitet:

Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

Grafikkarte im BIOS mal von Legcy auf EFI umgestellt, sofern du die Option hast?Also ESXI für Rendering/Gaming VM mit RTX 3090 taugt mir schon mal überhaupt nicht.

1. Die Grafikkarte zeigt bei Last im Gaming oder Rendering immer mal wieder Blackscreen. VM läuft weiter, Grafikkarte zeigt aber kein Bild mehr. Die RTX Karte scheint die PCIe Verbindung zur WIndows 10 VM zu verlieren. Erst dachte ich es liegt am Netzteil, das kann ich aber jetzt komplett ausschließen.

2. Die Leistung ist um welten schlechter in der VM als unter reinen Windows 10. Wir schreiben hier um etwa 100 bis 110 FPS Unterschied zwischen VM Windows 10 und direkt Windows 10.

ESXI + WIndows 10 VM + 3090:

Erster lauf:

Zweiter lauf:

I scored 20 245 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16384 MB, 64-bit Windows 10}www.3dmark.com

I scored 27 835 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16384 MB, 64-bit Windows 10}www.3dmark.com

Windows 10:

I scored 32 068 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 32768 MB, 64-bit Windows 10}www.3dmark.com

Edit: Habe jetzt das ganze nochmal über UnRaid als Hypervisor probiert und hier bekomme ich 0 Blackscreens und die Grafikperfomance ist sehr gut.

I scored 28 357 in Fire Strike

AMD Ryzen 9 3900X, NVIDIA GeForce RTX 3090 x 1, 16382 MB, 64-bit Windows 10}www.3dmark.com

Bei mir lief die Grafikkarte manchmal im Legacy-Modus problemlos, manchmal gar nicht. Im EFI Modus ist nun dauerhaft Ruhe.

Ceiber3

Urgestein

- Mitglied seit

- 21.11.2011

- Beiträge

- 4.923

- Desktop System

- Master System

- Laptop

- P775TM1G i9-9900k, 16 GB Ram, 1 TB NVMe, GTX 1070

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix X670E-I Gaming WIFI

- Kühler

- Externer 1280mm Supernova mit D5 Pumpe und OCTO Steuerung

- Speicher

- 48 GB DDR5-6000 CL30 von Corsair

- Grafikprozessor

- Manli RTX 4090 Gallardo 24 GB DDR6X

- Display

- 3440x1440, 200Hz, HDR1000, Lichtsensor, G-Sync Ultimate

- SSD

- 1x 5.0 M.2 Crucial T700 2 TB OS - 1x 4.0 M.2 Samsung 990 PRO 4 TB Gaming

- HDD

- Nop

- Opt. Laufwerk

- (p≧w≦q)

- Soundkarte

- Asus HIVE mit Optischen Kabel zur 7.1 Anlage

- Gehäuse

- MasterBox NR200P Mini ITX Gehäuse

- Netzteil

- Corsair SF1000 Platinum

- Betriebssystem

- Winerror und Linux Mint, Dualboot

- Webbrowser

- Nur der eine "Firefox"

- Internet

- ▼250 ▲40

Die lief die ganze Zeit im EFI Modus, Legacy-Modus habe ich garnicht probiert, da meiner Meinung nach Unsinn. In UnRaid läuft sie auch im EFI Modus.

Stangensellerie

Experte

- Mitglied seit

- 10.10.2015

- Beiträge

- 115

@Ceiber3

Ich an deiner Stelle wäre ja schon froh, daß du mit einer nvidia-Consumerkarte überhaupt ein Bild in einer ESXi-VM bekommst und nicht mit PSOD, BSOD oder Error10 bestraft wirst. nVidia behinderte ja nach Kräften den virtuellen Betrieb seiner Consumer-Karten. Oder nVidia sieht es jetzt bei seiner 3000er Reihe nicht mehr ganz so eng...

Ich an deiner Stelle wäre ja schon froh, daß du mit einer nvidia-Consumerkarte überhaupt ein Bild in einer ESXi-VM bekommst und nicht mit PSOD, BSOD oder Error10 bestraft wirst. nVidia behinderte ja nach Kräften den virtuellen Betrieb seiner Consumer-Karten. Oder nVidia sieht es jetzt bei seiner 3000er Reihe nicht mehr ganz so eng...

Ceiber3

Urgestein

- Mitglied seit

- 21.11.2011

- Beiträge

- 4.923

- Desktop System

- Master System

- Laptop

- P775TM1G i9-9900k, 16 GB Ram, 1 TB NVMe, GTX 1070

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix X670E-I Gaming WIFI

- Kühler

- Externer 1280mm Supernova mit D5 Pumpe und OCTO Steuerung

- Speicher

- 48 GB DDR5-6000 CL30 von Corsair

- Grafikprozessor

- Manli RTX 4090 Gallardo 24 GB DDR6X

- Display

- 3440x1440, 200Hz, HDR1000, Lichtsensor, G-Sync Ultimate

- SSD

- 1x 5.0 M.2 Crucial T700 2 TB OS - 1x 4.0 M.2 Samsung 990 PRO 4 TB Gaming

- HDD

- Nop

- Opt. Laufwerk

- (p≧w≦q)

- Soundkarte

- Asus HIVE mit Optischen Kabel zur 7.1 Anlage

- Gehäuse

- MasterBox NR200P Mini ITX Gehäuse

- Netzteil

- Corsair SF1000 Platinum

- Betriebssystem

- Winerror und Linux Mint, Dualboot

- Webbrowser

- Nur der eine "Firefox"

- Internet

- ▼250 ▲40

Jep, habe ich nicht aktiviert gehabt. Nutze ESXI auch nicht zum ersten Mal sondern schon viele Jahre Erfahrung.ESXi 6.7 / 7.0c Windows VM mit VBS = virtualization based security waren bei mir arschlangsam, ohne sind sie dann "normal" schnell. Nehme aber an, Du hattest kein VBS aktiviert?

Beitrag automatisch zusammengeführt:

@Ceiber3

Ich an deiner Stelle wäre ja schon froh, daß du mit einer nvidia-Consumerkarte überhaupt ein Bild in einer ESXi-VM bekommst und nicht mit PSOD, BSOD oder Error10 bestraft wirst. nVidia behinderte ja nach Kräften den virtuellen Betrieb seiner Consumer-Karten. Oder nVidia sieht es jetzt bei seiner 3000er Reihe nicht mehr ganz so eng...

Geht auch nicht out of the Box. Man muss die üblichen Tricks für Nvidia Consumer Karten nutzen. Wurde hier ja schon oft beschrieben was man alles machen muss. Bild ja, zu 80% bekomme ich aber Blackscreen sobald Last auf der Karte ist. Mit UnRaid habe ich jetzt 0 Probleme und viel bessere Performance. Reboot geht auch sauber und ich kann ganz einfach alle USB Geräte durchreichen, auch das geht bei ESXI nicht so einfach.

Zuletzt bearbeitet:

towatai

Enthusiast

hat einer von Euch ZUFÄLLIG erfahrungen mit den Flings USB NIC-Treibern + Adapter als primäre NIC unter ESXI 7.01 gesammelt und stieß dort auf Probleme wie eine nicht aktive NIC nach nem reboot, Configs sind nach nem reboot nicht gespeichert etc. ? Der rechner auf dem das ganze läuft hat LEIDER nur ne Realtek NIC OnBoard (Dell OptiPlex 3050 Micro) und funktioniert somit nur bis 6.7+Treibern.

Zuletzt bearbeitet:

[SoD]r4z0r

Enthusiast

- Mitglied seit

- 11.04.2009

- Beiträge

- 3.950

Hab das mal getestet, lief für den Testbetrieb fehlerfrei. Habe die Netzwerkverbindung aber nicht lange unter Last gehabt, kann daher nichts zur Verbindungsstabilität sagen. Die IP wurde bei mir über einen DHCP vergeben, daher kann ich auch nicht sagen ob der ESXi die beim Neustart behalten hätte. Aber das der NIC im Betrieb oder nach dem starten nicht aktiv ist, das war bei mir nicht der Fall.hat einer von Euch ZUFÄLLIG erfahrungen mit den Flings USB NIC-Treibern + Adapter als primäre NIC unter ESXI 7.01 gesammelt und stieß dort auf Probleme wie eine nicht aktive NIC, Configs sind nach nem reboot nicht gespeichert etc. ? Der rechner auf dem das ganze läuft hat LEIDER nur ne Realtek NIC OnBoard (Dell OptiPlex 3050 Micro) und funktioniert somit nur bis 6.7+Treibern.

Das hier eine Option?

Realtek NIC and ESXi 7.0 - Use Passthrough to make use of the Adapter

Das in eine Routing VM und dann das Netzwerk per vnic und vswitch weiterreichen?

USB NIC dann nur zum Einrichten nötig?

Realtek NIC and ESXi 7.0 - Use Passthrough to make use of the Adapter

Das in eine Routing VM und dann das Netzwerk per vnic und vswitch weiterreichen?

USB NIC dann nur zum Einrichten nötig?

towatai

Enthusiast

ich habe ja nur eine NIC ab ESXI 7 und das ist eben diese die dank USB treiber eingebunden wird... sämtliche konfiguration ist nach nem restart futsch, statisch eingestellte IP Adressen, Serverconfig etc. teilweise sogar das root-pw, ländereinstellung etc. ich muss danach auch einmal übers DCUI die NIC wieder aktivieren... vorher ist kein Verbinden möglich  habe diverse 7er Builds durch den esxi-customizer PS gejagt, immer das gleiche problem. ich habe zwar noch nen anderen rechner mit nem Asus P9D-MV Board und zwei Intel-Nics aber da die kiste hier nicht gefordert wird sind 9W (Dell) im idle ggü. 23W (P9D-MV) sehr reizvoll ;-)

habe diverse 7er Builds durch den esxi-customizer PS gejagt, immer das gleiche problem. ich habe zwar noch nen anderen rechner mit nem Asus P9D-MV Board und zwei Intel-Nics aber da die kiste hier nicht gefordert wird sind 9W (Dell) im idle ggü. 23W (P9D-MV) sehr reizvoll ;-)

habe diverse 7er Builds durch den esxi-customizer PS gejagt, immer das gleiche problem. ich habe zwar noch nen anderen rechner mit nem Asus P9D-MV Board und zwei Intel-Nics aber da die kiste hier nicht gefordert wird sind 9W (Dell) im idle ggü. 23W (P9D-MV) sehr reizvoll ;-)

habe diverse 7er Builds durch den esxi-customizer PS gejagt, immer das gleiche problem. ich habe zwar noch nen anderen rechner mit nem Asus P9D-MV Board und zwei Intel-Nics aber da die kiste hier nicht gefordert wird sind 9W (Dell) im idle ggü. 23W (P9D-MV) sehr reizvoll ;-)Gen8 Runner

Experte

- Mitglied seit

- 12.08.2015

- Beiträge

- 1.166

vorher ist kein Verbinden möglichhabe diverse 7er Builds durch den esxi-customizer PS gejagt, immer das gleiche problem. ich habe zwar noch nen anderen rechner mit nem Asus P9D-MV Board und zwei Intel-Nics aber da die kiste hier nicht gefordert wird sind 9W (Dell) im idle ggü. 23W (P9D-MV) sehr reizvoll ;-)

Zufällig noch nen PCIe Steckplatz frei? Dann ne Dual Port Intel Netzwerkkarte rein und Ruhe haben.

Die laufen einfach.

Verbrauch: ~1.5W Idle, max. 2,5W unter Last. 40 Cent im Monat, dafür dauerhaft Ruhe.

Stangensellerie

Experte

- Mitglied seit

- 10.10.2015

- Beiträge

- 115

Das würde mich jetzt wirklich interessieren, welche Tricks du nutzt. Läßt sich das soweit verallgemeinern, daß das nachher auch unabhängig von der Host-CPU einfach läuft?Geht auch nicht out of the Box. Man muss die üblichen Tricks für Nvidia Consumer Karten nutzen. Wurde hier ja schon oft beschrieben was man alles machen muss. Bild ja, zu 80% bekomme ich aber Blackscreen sobald Last auf der Karte ist. Mit UnRaid habe ich jetzt 0 Probleme und viel bessere Performance. Reboot geht auch sauber und ich kann ganz einfach alle USB Geräte durchreichen, auch das geht bei ESXI nicht so einfach.

towatai

Enthusiast

Das ist n Rechner im Micro-Format. Keinerlei Steckplätze vorhanden. Bin schon am überlegen den gegen ein Lenovo Modell zu tauschen. Die haben ne Intel NIC verbaut.Zufällig noch nen PCIe Steckplatz frei?

Trambahner

Urgestein

In manche der Lenovo Thinkcenter/-stations Mini kann man eine normale halblange PCIe x4 oder x8 Karten per Riserkärtchen verbauen.

D.h. eine i350 oder optische 10G Karte reinzimmern sollte kein Problem sein (sofern kein Bioslock existiert).

Es gibt sogar welche, da ist eine i350 schon drin.

Theoretisch kann man dann auch eine X540/X550 verbauen, aber würde ich wg. der Hitzeentwicklung dieser Karten in dem Minigehäuse nicht machen,

D.h. eine i350 oder optische 10G Karte reinzimmern sollte kein Problem sein (sofern kein Bioslock existiert).

Es gibt sogar welche, da ist eine i350 schon drin.

Theoretisch kann man dann auch eine X540/X550 verbauen, aber würde ich wg. der Hitzeentwicklung dieser Karten in dem Minigehäuse nicht machen,

towatai

Enthusiast

Ja, ich habe hier auch noch nen Fujitsi Futro S920. Da kann man wunderbar per Riser alles mögliche reinpflanzen (solange ne kurze Slotblende verfügbar ist). Ist nur leider etwas schwach auf der Brust für Plex etc. Dessen Gehäuse besteht gefühlt auch nur aus Lochblech, da passiv gekühlt. Perfekte Kiste für ne Firewall.