HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 120.408

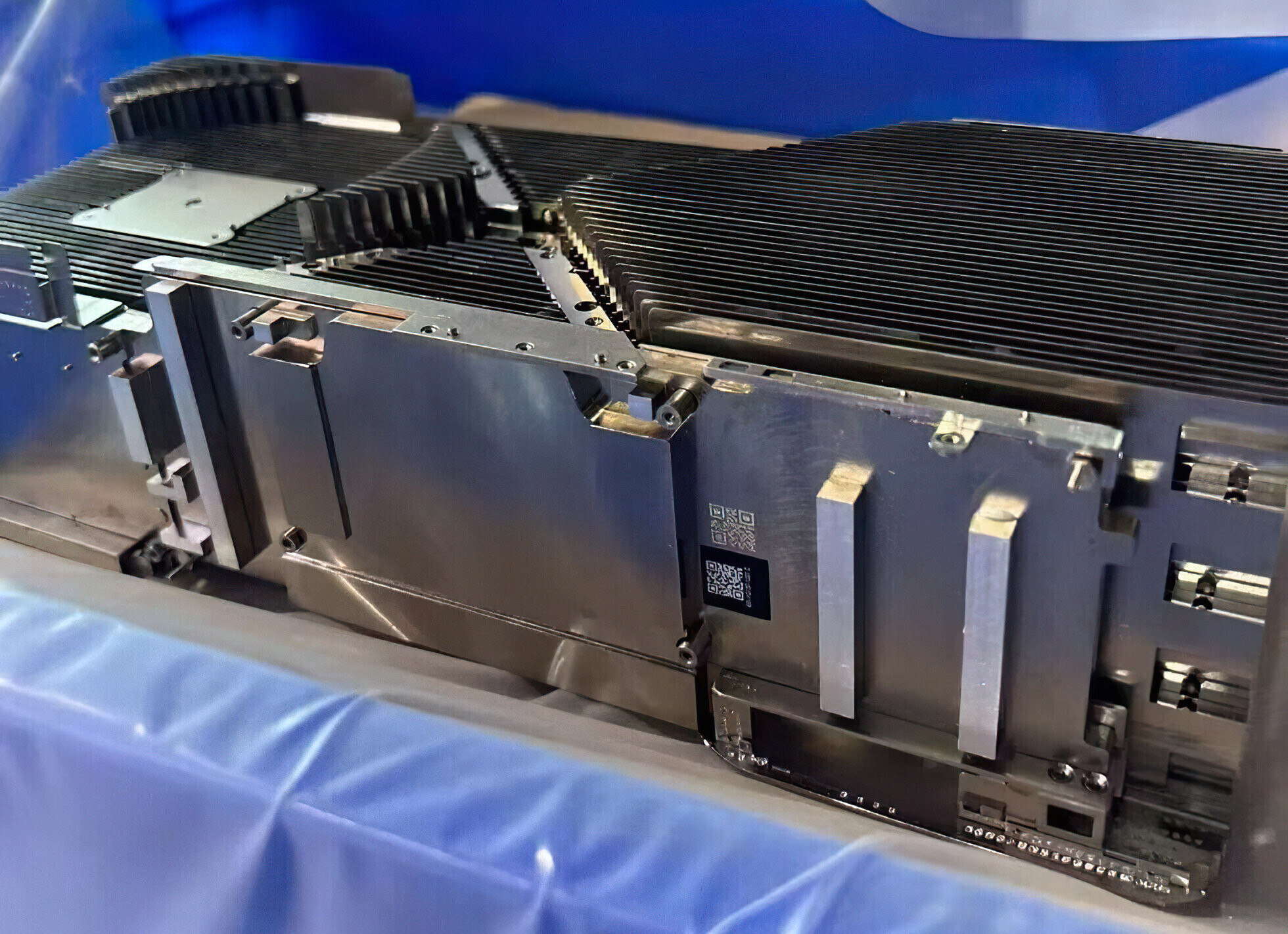

Zu NVIDIAs für dieses Jahr erwarteten neuen Gaming-Flaggschiff, der GeForce RTX 5090, gibt es neue Hinweise, die weiterhin als Gerüchte behandelt werden sollten. Nun scheint ein 512-Bit-Speicherinterface für die GeForce RTX 5090 wieder im Gespräch zu sein. Dem GB202-Chip sollen gleich 16 GDDR7-Speicherchips zur Seite gestellt werden. Im Chiphell-Forum kommt nun neu der Hinweis auf ein "dreiteiliges" PCB für die GeForce RTX 5090.

... weiterlesen

... weiterlesen