The golden Rule... Kein Hate und unterstützt Euch

Here we go again

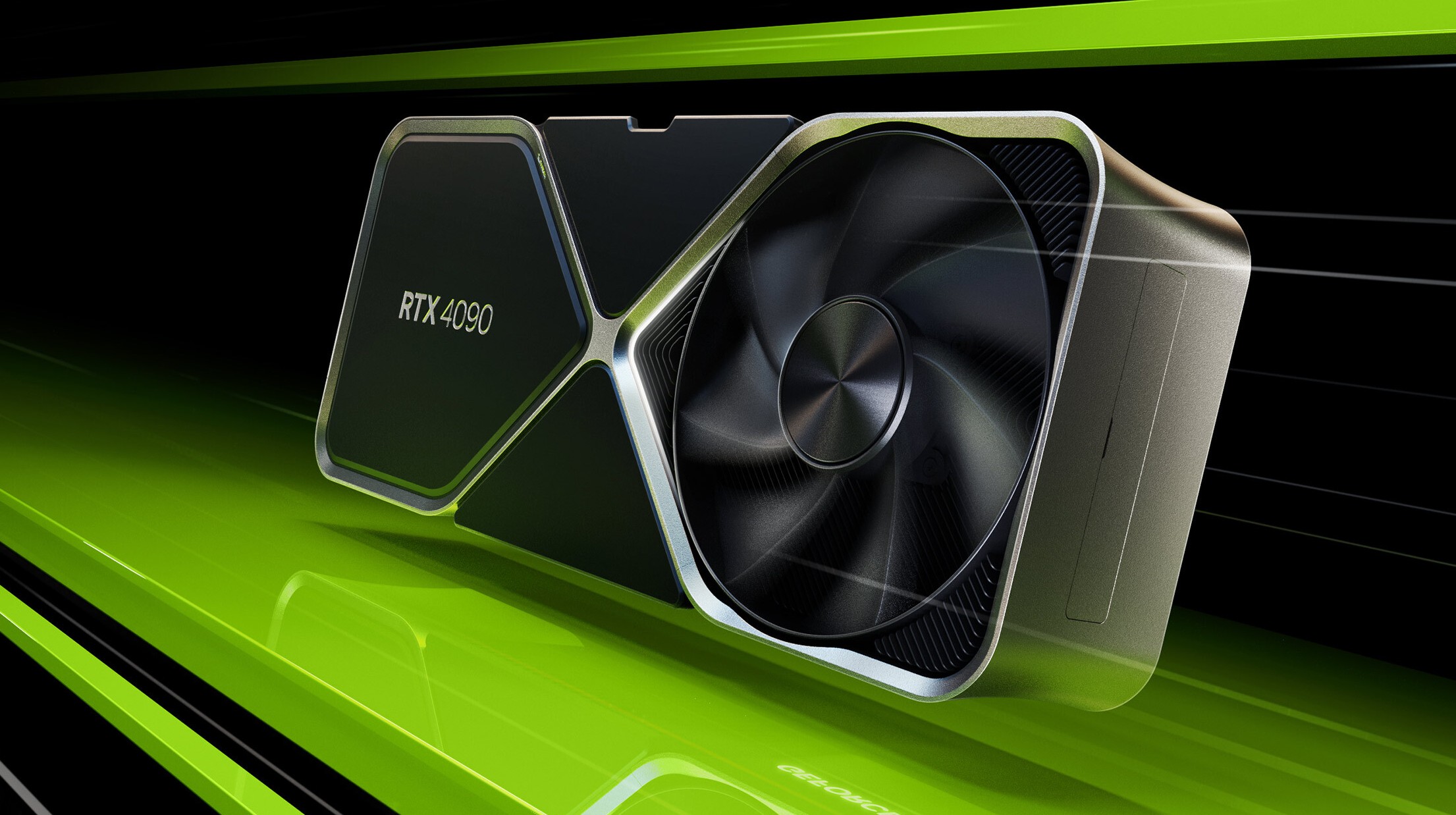

4090...ICH HABE VIEL STROMDURST, ABER NÜCHTERN BIN ICH GENAUSO GEIL

UNDERVOLTET EURE KARTEN UND SPART STROMKOSTEN!!!!

Here we go again

4090...ICH HABE VIEL STROMDURST, ABER NÜCHTERN BIN ICH GENAUSO GEIL

UNDERVOLTET EURE KARTEN UND SPART STROMKOSTEN!!!!

Quelle:

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Youtube Videos ab jetzt direkt anzeigen

Deutliches Leistungsplus und künstliche Frames: GeForce RTX 4090 in der Founders Edition im Test - Hardwareluxx

GeForce RTX 4090 in der Founders Edition im Test.

Gigabyte, INNO3D, MSI und ZOTAC: Vier Custom-Modelle der GeForce RTX 4090 im Test - Hardwareluxx

Gigabyte, INNO3D und MSI: Vier Custom-Modelle der GeForce RTX 4090 im Test.

Karten:

Das sind die Custom-Modelle der GeForce RTX 4090 und RTX 4080 - Hardwareluxx

Das sind die Custom-Modelle der GeForce RTX 4090 und RTX 4080.

News:

Cablemod unveils 90 degree angle 12VHPWR power adapter for GeForce RTX 40 GPUs - VideoCardz.com

Cablemod to solve 12VHPWR cable issues Angled adapter to the rescue. CableMod 12VHPWR Right Angle Adapter Cablemod has announced the highly anticipated 90-degree angle power cable adapter for modern GeForce GPUs. This cable supports the full 600W spec, and it solves the most basic problem with...

GALAX TecLab OC team breaks multiple world records with GeForce RTX 4090 and LN2, up to 3.45 GHz overclock - VideoCardz.com

NVIDIA RTX 4090 OC up to 3.45 GHz GALAX OC TecLab team from Brazil has been working on overclocking GeForce RTX 4090 graphics card. As NVIDIA released its flagship RTX 40 GPU, reviewers and board partners were finally allowed to share the test results featuring custom designs. One of such cards...

NVIDIA's new driver enables "substantial" DirectX12 performance improvements for GeForce RTX GPUs - VideoCardz.com

NVIDIA updates DirectX12 driver, up to 24% better performance in Assassin’s Creed Valhalla Today NVIDIA released a new Game Ready driver for GeForce RTX 4090. It brings much more than just support for the newest architecture, though. The company has been working on improving performance for...

NVIDIA GeForce RTX 4090 graphics cards are now available - VideoCardz.com

NVIDIA releases its fastest gaming GPU yet The flagship RTX 40 GPU is now available. This is the first and the fastest member of the new GeForce RTX 40 family. The RTX 4090 packs an AD102 GPU based on Ada Lovelace architecture. It is equipped with 16384 CUDA cores, 512 Texture Units and...

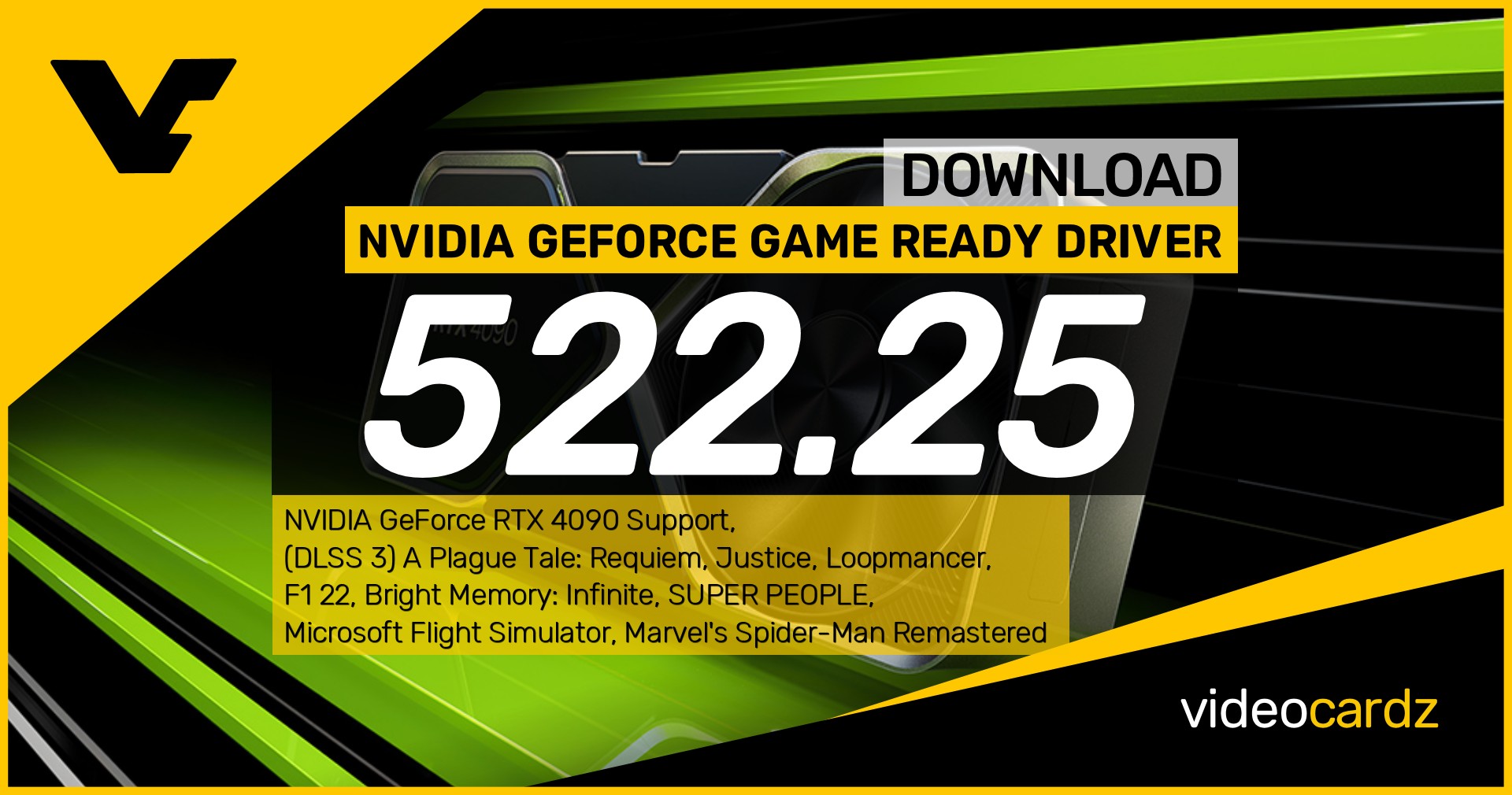

NVIDIA GeForce Game Ready 522.25 WHQL - VideoCardz.com

This new Game Ready Driver provides the best day-0 gaming experience for the latest new DLSS titles including Gotham Knights, Uncharted: Legacy of Thieves Collection, and Dakar Desert Rally. In addition, this Game Ready Driver supports the first new DLSS 3 titles including A Plague Tale...

Wakü News:

[Sammelthread] - Geforce RTX 4090 VRM PCB Wasserblock Liste

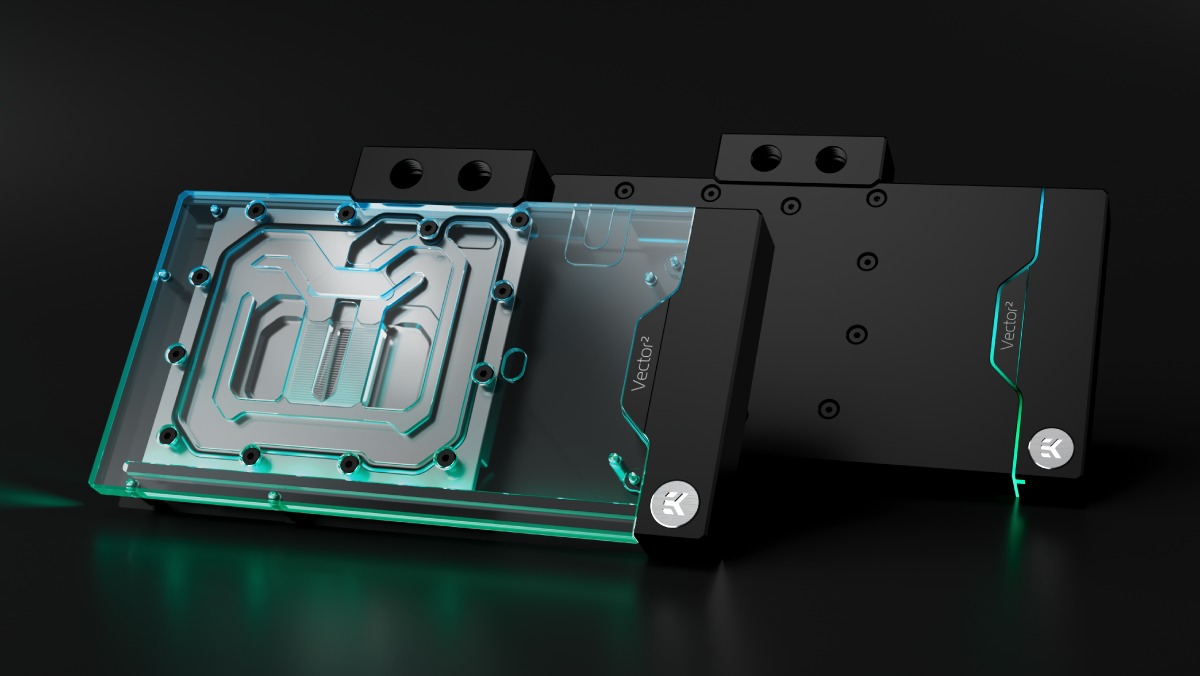

Hallo zusammen, ich denke es wäre ein coole Idee wenn wir hier alle Infos zu den momentant Verfügbahren RTX 4090 sammeln. Modell PT nom/max VRM GPU/MEM Board Layout Wasserblock NVIDIA GeForce RTX 4090 450W/600W 20x70A MP86957 3x70A MP86957 ~1400W VRM founder Alphacool-Acryl EKWB-Acetal...

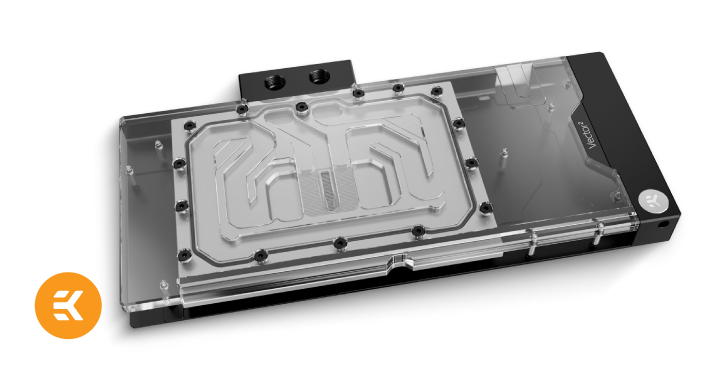

EK Rolls out Water Blocks and Active Backplate Sets for MSI Trio and Suprim RTX 4090 GPUs - ekwb.com

EK, the premium liquid cooling gear manufacturer, is now introducing the ultimate water cooling solution for MSI® Trio and Suprim GeForce® RTX™ 4090 graphics cards. EK-Quantum Vector² Trio RTX 4090 D-RGB comes in the form of a water block with a passive backplate or a cooling solution with an...

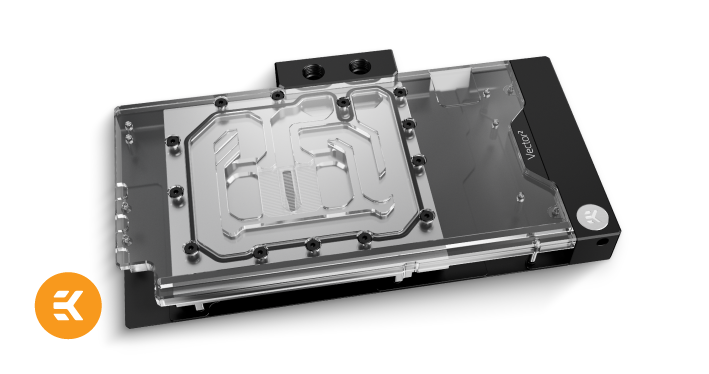

EK Rolls Out New Water Block With Passive and Active Backplate Options for ROG Strix and ASUS TUF RTX 4090 - ekwb.com

EK, the premium liquid cooling gear manufacturer, is now introducing the ultimate water cooling solution for ROG Strix and ASUS TUF GeForce® RTX™ 4090 graphics cards. EK-Quantum Vector² Strix/TUF RTX 4090 D-RGB comes in the form of a water block with a passive backplate or a cooling solution...

EK announces water block for GeForce RTX 4090 Founders Edition, ready for 3 GHz+ clocks - VideoCardz.com

EK GOES ABOVE AND BEYOND TO ROLL OUT WATER BLOCK FOR JUST RELEASED NVIDIA RTX 4090 GPUS The launch of NVIDIA® GeForce® RTX™ graphics cards’ latest edition for gamers and content creators is finally announced. The GeForce RTX 40 Series will be the 3rd generation of RTX graphics cards. Expected...

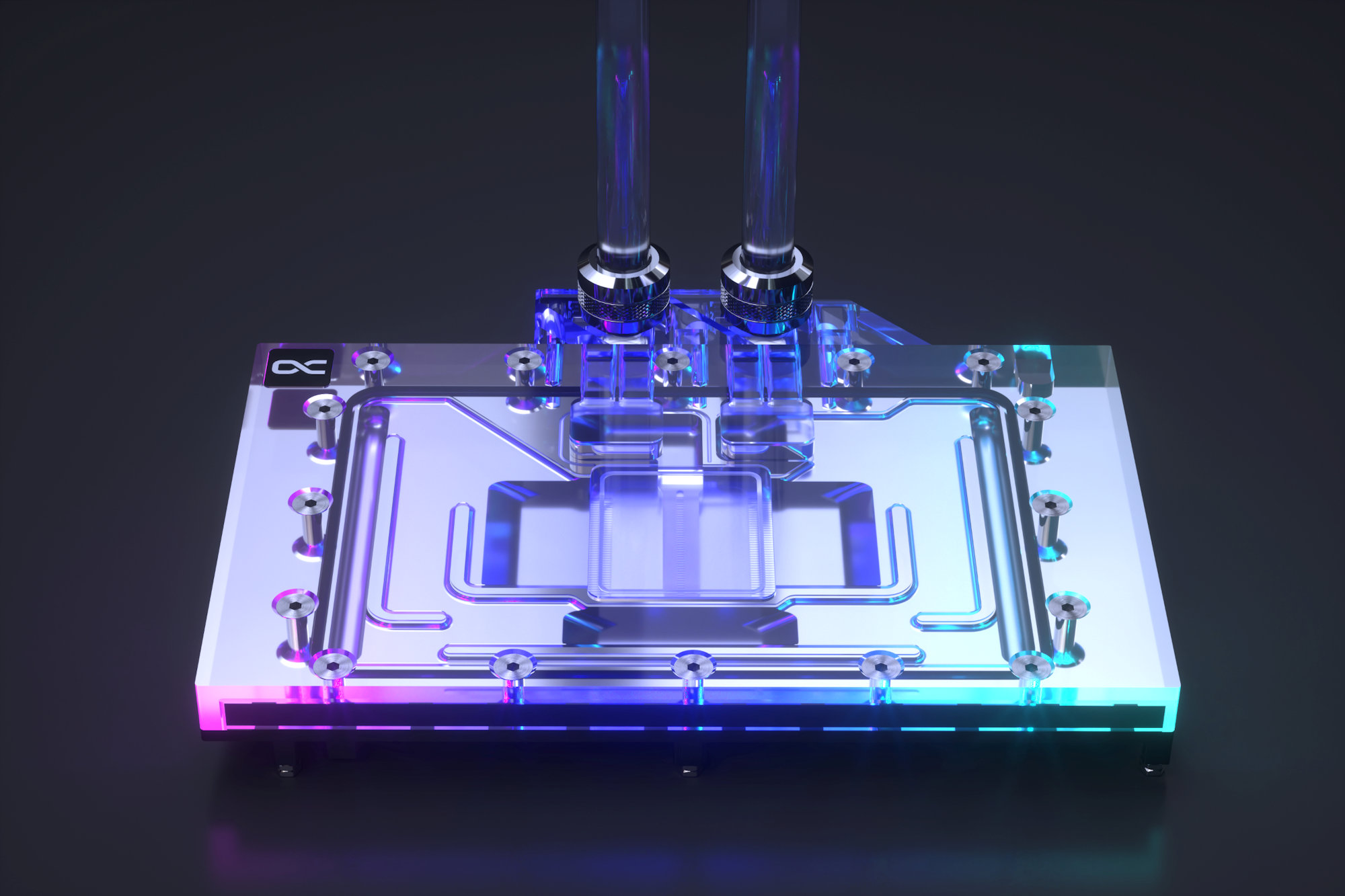

Alphacool releases Eiswolf 2 water cooler for GeForce RTX 4090 - VideoCardz.com

New Cooler for RTX 4090! The new Geforce RTX generation is here and Alphacool obviously offers a water cooler for it as well. The cooler for the new generation is much more than just another Eisblock Aurora GPU cooler. It is the first step towards a new generation of Alphacool coolers that...

Vorstellung 20.9.2022 - 17 Uhr CEST

#ProjectBeyond: NVIDIA startet Kampagne für nächste GeForce-Generation (2. Update) - Hardwareluxx

#ProjectBeyond: NVIDIA startet Kampagne für nächste GeForce-Generation.

GeForce auf der CES 2025

Lass dir die Eröffnungs-Keynote von NVIDIA-CEO Jensen Huang nicht entgehen – live aus Las Vegas.

www.nvidia.com

Shops:

Alternate: https://www.alternate.de/listing.xh...tlink&campaign=AF/DeZanox/Textlinks/Alternate

Amazon: https://www.amazon.de/s?k=rtx+4090&...g=2015_pc-magazin_ratgeber-21&ref=as_li_ss_tl

ARLT: https://www.arlt.com/Hardware/PC-Ko...3_1665086675_c41bcfa362400660aa68799a8d544c1f

Caseking: https://www.caseking.de/pc-komponenten/grafikkarten/nvidia/geforce-rtx-4090?awc=28817_1665086675_8c71f2e2a0b8302f9e83be95d89de776&utm_medium=utm_medium=affiliate&utm_source=http://www.connect.de _550751_Editorial+Content

MediaMarkt: https://www.mediamarkt.de/de/search...inkgenerator-AO&emid=633f34d4aaad325e8546c28e

Mindfactory: https://www.mindfactory.de/search_r...2_1665086677_f0779a4b84d05c6ff304fd720f0d2c19

NBB: https://www.notebooksbilliger.de/produkte/rtx%204090?nbbct=1001_550751&nbb=2177fc&wt_cc8=httpwwwconnectde&pid=11348_1665086678_58bddee53bb045cbf554da788649c09d&awc=11348_1665086678_58bddee53bb045cbf554da788649c09d

NVIDIA: https://www.nvidia.com/de-de/geforce/graphics-cards/40-series/rtx-4090/

ProShop: https://www.proshop.de/Grafikkarte?...1_1665086679_6daff1a5dd54a584f698dce239078ff8

Saturn: https://www.saturn.de/de/search.htm...inkgenerator-AO&emid=633f34d9f418ae2bef4a481b

PowerLimits:

| Karte | Min | Max |

| 4090 Founders Edition | 450W | 600W |

| 4090 Gainward Golden Sample | 450W | 450W |

| 4090 MSI Suprim X | 450W | 450W Silent Mode / 520W Power Modus |

| 4090 STRIX OC | 500W | 600W / Dual Bios |

| 4090 Aorus Master | 450W | 600W |

| 4090 Zotac AMP Extreme | 450W | 495W |

| 4090 MSI Suprim Liquid X | 480W | 530W / Selten auch 600W |

| 4090 Gigabyte Gaming OC | 450W | 600W |

| 4090 Palit Gamerock OC | 450W | 500W |

| CARD | GPU Voltage Phases | GPU Voltage Controller | GPU MOS | MOS Current (A) | Total GPU Current | Memory Voltage Phases | Memory Voltage Controller | Memory MOS | MOS Current (A) | Total Memory Current | Total Phases | Source |

| MSI Suprim X (& Liquid) | 26 | Monolithic MP2891 | Monolithic MP86957 | 70 | 1820 | 4 | Monolithic MP2891 | Monolithic MP86957 | 70 | 280 | 30 | Techpowerup |

| ASUS STRIX OC | 24 | Monolithic MP2891 | OnSemi FDMF3170 | 70 | 1680 | 4 | Monolithic MP2891 | OnSemi FDMF3170 | 70 | 280 | 28 | Techpowerup |

| Nvidia Founders | 20 | Monolithic MP2891 | Monolithic MP86957 | 70 | 1400 | 3 | Monolithic MP2891 | Monolithic MP86957 | 70 | 210 | 23 | Techpowerup |

| Colorful Vulcan (& Neptune) | 24 | uPI uP9512U | Alpha & Omega AOZ5311NQI-03 BLN3 | 55 | 1320 | 4 | uPI uP9512R | Alpha & Omega AOZ5311NQI-03 BLN3 | 55 | 220 | 28 | Techpowerup |

| Zotac AIRO | 24 | uPI uP9512U | Alpha & Omega AOZ5311NQI-03 BLN3 | 55 | 1320 | 4 | uPI uP9512R | Alpha & Omega AOZ5311NQI BLN0 | 50 | 200 | 28 | Techpowerup |

| ASUS TUF OC | 18 | Monolithic MP2888A | Infineon TDA21570 | 70 | 1260 | 4 | uPI uP9512Q | Vishay SIC638A | 50 | 200 | 22 | Hardware Unboxed |

| Gigabyte Gaming OC | 20 | uPI uP9512U | Vishay SIC653A | 50 | 1000 | 4 | uPI uP9512R | Vishay SIC653A | 50 | 200 | 24 | Techpowerup |

| MSI Gaming Trio X | 18 | Monolithic MP2891 | OnSemi NCP303151 | 50 | 900 | 4 | Monolithic MP2891 | OnSemi NCP303151 | 50 | 200 | 22 | CoolPC |

| Palit GameRock OC | 16 | uPI uP9512U | OnSemi NCP302150 | 50 | 800 | 3 | uPI uP9512R | OnSemi NCP302150 | 50 | 150 | 19 | Techpowerup |

| Zotac Trinity OC | 14 | uPI uP9512U | Alpha & Omega AOZ5311NQI-03 BLN3 | 55 | 770 | 4 | uPI uP9512R | Alpha & Omega AOZ5311NQI BLN0 | 50 | 200 | 18 | CoolPC |

| Inno3D X3 OC | 14 | uPI uP9512U | Alpha & Omega AOZ5311NQI BLN0 | 55 | 770 | 3 | uPI uP9512R | Alpha & Omega AOZ5311NQI BLN0 | 55 | 165 | 17 | KitGuru |

| Gigabyte Windforce | 14 | ? | Vishay SIC653A | 50 | 700 | 4 | ? | Vishay SIC653A | 50 | 200 | 18 | profesionalreview |

Quelle: https://www.reddit.com/r/nvidia/comments/y5x5pg/comment/isn62q2/?context=3

Quelle: https://www.reddit.com/r/sffpc/comments/xmp4s9/physical_dimensions_of_rtx_4090_models/

Quelle: Danke an @Brainscan1979

BIOS Flashen (BIOS FLASHEN IST IMMER AUF EIGENE GEFAHR UND KANN DIE GRAFIKKARTE FUNKTIONSUNTÜCHTIG MACHEN!!!)

Tool

NVIDIA NVFlash 5.867 Download

NVIDIA NVFlash is used to flash the graphics card BIOS on Blackwell, Ada, Ampere, Turing, Pascal and all older NVIDIA cards. NVFlash supports BIOS

How To?

Anleitung

1. Als erstes eigenes Original BIOS speichern per GPU-Z als Backup

2. Command Prompt starten per Adminstrator indem man "CMD" eingibt in der Windows Suchleiste

3. Richtigen Pfad angeben zum NVFlash Ordner mit cd: c/.....

4. Dann den Schutz deaktivieren mit "nvflash --protectoff" oder "nvflash64 --protectoff"

5. Dann die Custom ROM (BIOS) angeben mit "nvflash ROM_NAME.rom" oder "nvflash64 ROM_NAME.rom"

6. Falls es nicht funktioniert, da es zum ID-Mismatch kommt, muss man den Schutz gegen ein fremdes Bios deaktivieren mit "nvflash -6 ROM_NAME.rom" oder "nvflash64 -6 ROM_NAME.rom"

7. Enter drücken

8. 2x Y drücken zum bestätigen

9. Screen flackert und die Message sollte kommen, dass alles funktioniert hat

10. PC neu starten

11. Nach dem Neustart warten bis die Grafikkarte wieder erkannt wieder. Kann 1-2 Minuten dauern

Garantie: > Von 15.09.2020 10:00 Uhr. Wenn ihr neuere Infos habt, bitte bescheid geben

Quelle: https://www.computerbase.de/2016-09/grafikkarten-garantie-vergleich/

Speziellen Netzteilstecker für die RTX 4090 bestellen:

Seasonic gibt Ihren Kunden das Kabel Umsonst, für spezielle Seasonic-NT, welche in den letzten 12 Monaten gekauft wurde.

"Starting on October 12, 2022, our complimentary cable offer will be valid for customers who purchased a PRIME 1300, PRIME 1000 or FOCUS 1000 W power supply and a newest, high-power VGA card within the past 12 months. Proofs of both purchases are required to apply for the free 12VHPWR cable. The quantity of free cable sets is limited, and this offer is valid only as long as our supplies last."

https://seasonic.com/cable-request/

Corsair

600W PCIe 5.0 12VHPWR Type-4 PSU Power Cable

The official CORSAIR 600W PCIe 5.0 / Gen 5 12VHPWR PSU Power Cable delivers power from CORSAIR Type-4 PSUs to the most advanced PCIe 5.0 graphics cards.

Store für Corsair, ASUS, EVGA und Seasonic Netzteilstecker:

12VHPWR PCI-e Cable – CableMod Global Store

FAQ:

Brauche ich ein neues Netzteil für die RTX 4000 Reihe? Nein > https://www.nvidia.com/en-us/geforc...6/geforce-rtx-40-series-power-specifications/

Verliere ich Leistung, wenn ich die RTX 4090 mit PCIe 3 laufen lasse? > Ja, ca 2,1%

Also nicht viel

Also nicht vielQuelle: https://www.computerbase.de/2022-10...hnitt_die_geforce_rtx_4090_mit_pcie_30_update

Anhänge

-

1663149915787.png12,8 KB · Aufrufe: 2.633

1663149915787.png12,8 KB · Aufrufe: 2.633 -

1663740699330.png9,7 KB · Aufrufe: 3.505

1663740699330.png9,7 KB · Aufrufe: 3.505 -

1663917323564.png17,5 KB · Aufrufe: 11.792

1663917323564.png17,5 KB · Aufrufe: 11.792 -

1663917392159.png85,2 KB · Aufrufe: 1.845

1663917392159.png85,2 KB · Aufrufe: 1.845 -

1664862132798.png108,9 KB · Aufrufe: 854

1664862132798.png108,9 KB · Aufrufe: 854 -

1664862159294.png9,1 KB · Aufrufe: 838

1664862159294.png9,1 KB · Aufrufe: 838 -

1664862278766.png7,2 KB · Aufrufe: 832

1664862278766.png7,2 KB · Aufrufe: 832 -

1664862319280.png5 KB · Aufrufe: 779

1664862319280.png5 KB · Aufrufe: 779 -

1664862405381.png7,6 KB · Aufrufe: 807

1664862405381.png7,6 KB · Aufrufe: 807 -

1665056332046.png47,2 KB · Aufrufe: 530

1665056332046.png47,2 KB · Aufrufe: 530 -

1665056371177.png79 KB · Aufrufe: 821

1665056371177.png79 KB · Aufrufe: 821 -

1665056772151.png76,2 KB · Aufrufe: 11.959

1665056772151.png76,2 KB · Aufrufe: 11.959 -

1665169879074.png62 KB · Aufrufe: 877

1665169879074.png62 KB · Aufrufe: 877 -

1665387046109.png61,8 KB · Aufrufe: 1.656

1665387046109.png61,8 KB · Aufrufe: 1.656

"Tausche dich arm" will ich sehen

"Tausche dich arm" will ich sehen