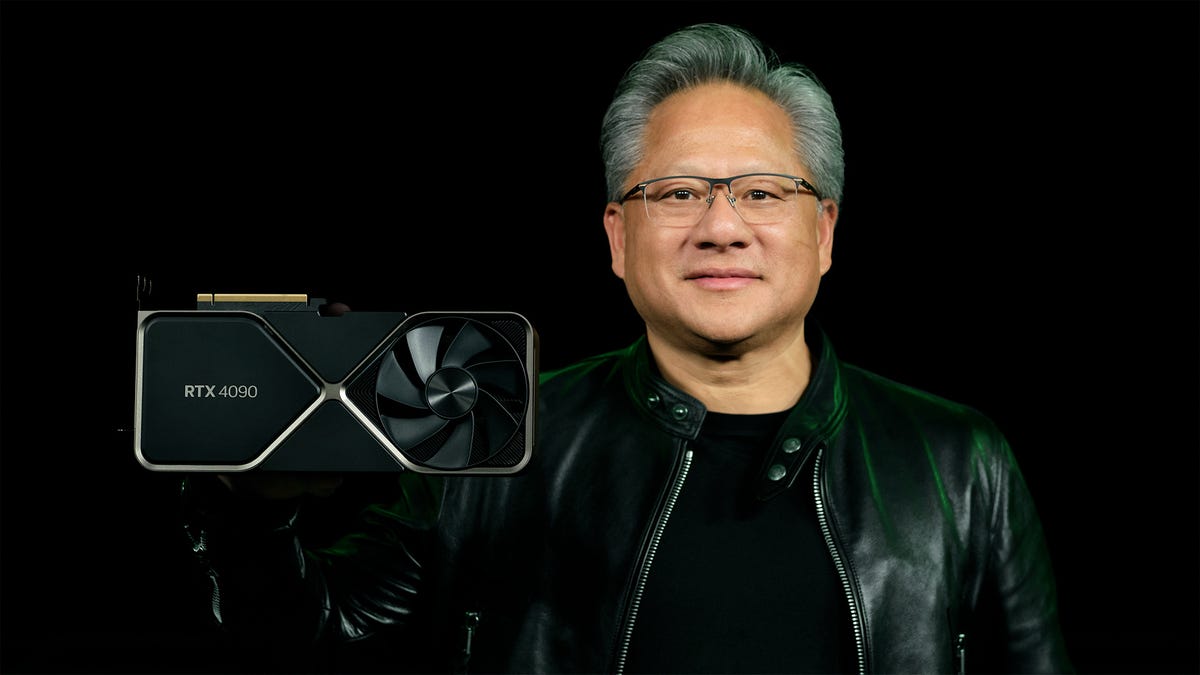

Wilde aussage

When queried over high PC GPU prices, Nvidia’s Jensen Huang said 'Moore’s Law is dead'

kotaku.com

Sehe ich prinzipiell aber genauso, habe ich auch schon vor 2 Jahren in diversen Diskussionen zu DLSS und FSR geschrieben. Und ein paar Posts über deinem auch erst.

Aus den Chips wird man keine großen Leistungssprünge mehr rausholen. Soweit ich das verstanden habe ist man gerade bei den GPUs auch schon ziemlich bei der maximalen Größe. Noch größer um noch mehr Cores reinzukriegen, geht auch nicht. Strom pumpt man neuerdings auch schon massig rein, da kriegt man bald oder hat sogar schon Kühlprobleme. Den Takt kann man auch kaum noch höher schrauben.

Das ist wie bei Autos: 500ps aber nur 2l/100km geht halt einfach nicht. Phüsik und so.

Gleichzeitig steigen die gewünschten Displayauflösungen exponentiell und damit die benötigte GPU-Leistung. Man muss nur mal zurückschauen, oder kann sich sogar noch erinnern. Die Monitorauflösungen sind in den letzten 5-10 Jahren regelrecht explodiert.

Noch dazu nicht nur die Auflösungen, sondern auch noch die Hertz. 60fps reichen heute auch schon nichtmehr, man will 120fps+ haben.

Dazu soll aber auch noch die Grafik immer besser aussehen. Also nicht Auflösung, sondern der Detailgrad, Licht/Schatten, ...

Wie man aktuell sieht, ist das mit UHD auf konventionellem Weg schon ein Problem. Mit QUHD wird das nix mehr.

Nach dem obigen Kommentar, noch ein paar anderen Quellen schließt sich für mich aber denke ich allmählich der Kreis.

Nvidia sieht das halt genau so, kurz gesagt: Mit konventioneller Rohleistung ist kaum mehr eine Steigerung drin. Daher brauchen sie was neues und setzen da jetzt wohl zu nahezu 100% auf neue Techniken wie eben DLSS um Auflösung und Frameraten weiter steigern zu können.

Wie ich schon vor Jahren sagte: Spätestens mit mehr als UHD wird Upscaling der Normalzustand werden. MUSS ja sogar. Ob das jetzt DLSS oder FSR, oder vielleicht sogar noch was ganz anderes wird... wird sich zeigen.

Im Prinzip kann man das als ganz neuen Schritt in der Computergrafik sehen. Also imho durchaus ähnlich wie damals die ersten 3D-Beschleuniger. 3D-Spiele gingen auch vorher schon ohne. Nur ohne hatte man dann halt 20fps, mit hatte man dann auf einmal 60fps und es sah sogar noch besser aus. Und mit der Verbreitung der Karten war man dann auch schnell an einem Punkt angelangt, wo neuere 3D-Spiele ohne 3D-Beschleuniger schlicht nichtmehr spielbar waren.

Ist ganz interessant. Aktuell rendert man ja immernoch ein Bild im Rasterverfahren, erst dieses Bild wird dann via DLSS mit "KI" "verbessert". Wenn KI noch besser wird, kann man sich den Rasterschritt vielleicht sogar sparen und die KI "schätzt" direkt auf den Geometriedaten basierend was für ein Bild rauskommt?