So toll das Tempo auch ist beim Radeon-Treiber so viele Baustellen kommen jedes Major-Release dazu, so sehr wünscht man sich, dass alles harmoniert, anstatt dass Zeugs immer wieder unausgegoren in den Treiber kommt. Die Radeons sehe ich sehr wohl als konkurrenzfähig an, was Features und Funktionen angeht, aber so ein paar Sachen stören dann doch auch im Rückblick betrachtet:

1) ich halte es für ein Gerücht, dass FreeSync bei jemandem jemals problemlos funktioniert hat. "Damals" 2018 (2017 eine RX 56 bei Release gekauft) einen Samsung 28" 4k60 FreeSync-Monitor geholt. Eigentlich eine super Sache gewesen. 50 FPS fühlten sich genauso rund / unrund an wie 60 FPS und ohne FreeSync war das Erlebnis gefühlt auch mit über 60 FPS weniger fluffig als 50 FPS mit FreeSync.

Dennoch war eine Sache halt immer wieder nervig: Helligkeitsflackern in Abhängigkeit von FPS. Gibt es da außer Frame-Limitern eine akzeptable Lösung? Der Frame-Limiter hilft halt nur "oben rum", aber falls FPS schwanken oder unter die Freesync-Range fallen, wird es halt optisch störend. Mit dem jetzigen Monitor MSI 34" UWQHD 100 Hz fällt das störender auf, sodass ich mich sogar entschloss FreeSync auszustellen. Und ich denke jeder Bildschrim falckert. Beim einen fällt das mehr und beim anderen weniger auf. Das ist evtl. auch super subjektiv und stört evtl. nur die besonders empfindlich Wahrnehmenden.

2) beim OC: alles super, gut einstellbar mit den Vegas damals. Heute alles etwas komplexer auch durch das MPT und den Verzicht auf die Spannungskurve bei BN. Ok, fragwürdige Entscheidung und vllt. gibt es tatsächlich nur den Min- und Max-State in Hardware (?) oder es war technisch nicht anders möglich als es so abzubilden (?). Auch finde ich abseits der immensen Zeitinvestition das OC besser als das von NVidia.

Da scheiden sich evtl. die Geister. Evtl. macht der Vergleich "manuelle Schaltung vs. Automatik" da Sinn. Das Erstere stellt höhere Anforderungen an die Bedienung, aber nachdem man es raushat, hat man mehr Kontrolle und das Ergebnis lässt sich "besser" steuern mit mehr Vorteilen.

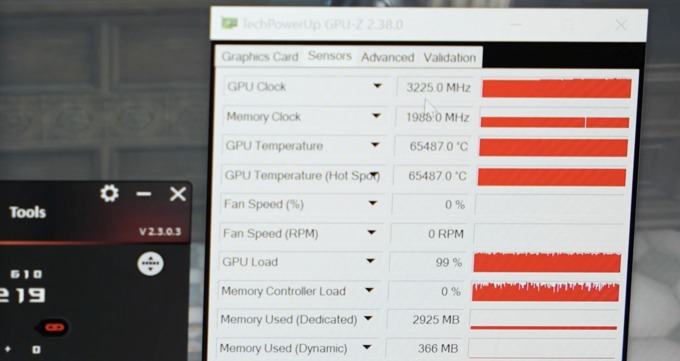

Das OC-Problem was ich mit dem Treiber damals hatte war, dass das OC von der Radeon VII treiberseitig kaputt war. Wenn ich ein OC eingestellt habe sagen wir mal von 2 GHz, hatte die GPU auf einmal heftige GPU-Utilization-Drops. Als Lösung nutzte ich eine Zeitlang die Min-Frequenz vom MPT (2 GHz). Die GPU lief also ständig auf 2 GHz. Mehr Verbrauch gab es im Idle aber nicht sonderlich. Das Problem tauchte auf als Navi10 rauskam. Irgendwann habe ich aus "Spaß" die Lüfter auf 100 % gestellt, obwohl keine angeschlossen waren, da die Karte wassergekühlt war. Ihr glaubt es nicht, aber danach lief die Karte wie eine 1. Interessanterweise konnte Cracky von Rawiioli das dann bei sich reproduzieren. Das war durch Zufall aber ein unabhängiges Ergebnis. Ich hatte den Fix selbst herausgefunden und keinem Bescheid gesagt und Cracky ebenso.

Das ist halt etwas, was in meinen Augen irgendwo symptomatisch ist für den Treiber. Viele Bugs tauchen bei vielen Nutzern reproduzierbar auf. Seltsamerweise (eigentlich nicht verwunderlich) oft nach Major-Releases. Danach wird versucht alles monatelang i.O. zu bringen. Dabei werden Sachen gefixt und wie bei der meisten Software entstehen Bugs an anderer Stelle. Da bleibt manchmal tatsächlich nur der Neuanfang vs. wir machen Jahrzehnte lang mit einer Flickenteppich-Software weiter. Denke, aufgrund der vielen AMD-Karten, die supported werden wollen mit den vielen kompatiblen Spielen, gestaltet sich der Neuanfang als schwierig. Eigentlich wäre das beste Konzept gewesen mit BigNavi einen Navi-Treiber von grundauf für Navi+ neu zu schreiben, alle alten Zöpfe abzuschneiden und zwei Treiber anzubieten: vor und nach Navi-Treiber. Aber ich bin nicht Lisa Su. Die wird schon einen guten Plan haben.

3) nächste Baustelle: Spiele-Einstellungen. Es wird immer noch dringend empfohlen "Enhanced Sync" auszuschalten (da gab es Probleme mit Navi10-Blackscreens und das einzuschalten will ich dann halt auch nicht). Problem war dabei auch (oder ist es immer noch ?), dass das mit bestimmten Start-Settings beim ersten Start standardmäßig aktiv war. Verstehe halt nicht, wieso das Feature da nicht zumindest für Noobs versteckt worden ist. Da hätten es "Profi-Einstellungen" getan. Wer von sich behauptet hätte, Experte zu sein, hätte einen Toggle umlegen können und dann alles mögliche verstellen können. Für die "Noobs" gäbe es dann weniger "experimentelle" Einstellungen und alle wären super glücklich gewesen. Die Noobs hätten nicht viel falsch verstellen können, mit der Konsequenz, dass der Treiber in den höchsten Tönen gelobt werden wäre von allen, anstatt, dass man NVidia höhere Sales ermöglichte, da es irgendwann hieß: "AMD ist schrott, denn die Treiber taugen nichts".

Ist halt leider nicht ganz unrichtig, aber auch nicht ganz richtig. Die Treiber sind prinzipiell besser als die von NVidia, was Features und Nutzbarkeit, Design, etc. betrifft. Nur leider funktionieren Features oft auch in Kombination nicht richtig miteinander.

Beispiel: Anti-Lag führt bei mir zu random-Stuttering in manchen Games. Ob das schon mit dem 21.4.1 gefixt wurde, weiß ich nicht, da ich aus der Diskussion mitgenommen habe, dass es besser ist mit "Schön-Wetter"-OC(UV) auf dem alten Treiber zu bleiben. Auch hier: vllt. nutze ich das nicht richtig. Vllt. geht das nicht gut, wenn gleichzeitig Bildschärfe aktiviert ist, aber leider brauche ich zumindest in Warzone die Bildschärfe.

Weiter: Ich wollte in Cyberpunk die Framerate massiv steigern mit Raytracing. Ansatz: ich schalte Radeon Boost auf 66 %. Dann sind die Bewegungen flüssig(er) ohne großen Qualitätsverlust -> war auch so. Dann schalte ich RIS hinzu, um die Schärfe zu erhöhen und die Reduzierung der Auflösung abzudämpfen -> soweit so gut. Dann machte ich im Spiel adaptives Resolution-Scaling mittels CAS -> massive Bildfehler. Problem dabei: ich hätte schon gerne was Frame-Rate-adaptives gehabt an der Stelle, da je nach Frame-Rate mehr Fidelity möglich gewesen wäre. Normales Down-Scaling habe ich auch probiert, dann war aber entweder die Qualität zu niedrig oder die Frame-Rate nicht hoch genug. Das ließe sich halt durch das Adaptive-Zeugs vermeiden, vor allem da Bewegungen ja eh mit Radeon-Boost gepusht wurden hins. FPS und mit Down-Scaling. Selbst während Bewegungen wurde die Auflösung optisch zu niedrig.

4) Treiberabhängige Display-Probleme (habe da einen Thread dazu). Ich hoffe die Probleme sind seit 21.3.1 endgültig Geschichte. Ein besseres DP-Kabel brachte spürbar Besserung.

5) Utilization-Drops, die angeblich mit dem neuen 21.4.1-Treiber Geschichte sein sollten, untested -.-. Wie wäre es mal gut gewesen, wenn der 21.4.1 nur Fixes und keine OC-Problemchen gehabt hätte -.-?

6) AMD-Link gibt es endlich für PC. Da warte ich solange drauf. Wäre ja eine super Sache gewesen, gäbe es einen Windows-App dafür. Gibt es aber nicht, denn stattdessen möchte AMD grundlos einen zweiten Rechner mit einer AMD-Karte, auf dem der 21.4.1 läuft 🤦♂️ . AMD, jetzt mal ehrlich: wieso gibt es seit Jahren eine AMD-Link-App für Android und für iOS und für Android-Smart-TVs, aber weder für Windows noch für WebOs. Ich wäre einer der wenigen, die das tatsächlich gerne nutzen würden auf dem 4k-TV ohne den Rechner schleppen zu müssen oder mir neues Zeugs zu kaufen.

Also: wieso keine Microsoft-App und wenn, das aus Gründen nicht geht, wieso keinen übergreifenden Client? Steam-In-Home-Gedöns ist entweder nicht gut genug aufgelöst, oder laggy leider. Einmal kurz eine NVidia GTX 1060 gehabt und das war ein erstaunlich unkompliziertes Erlebnis das Streaming auf dem Lappi zu zocken, akzeptable Qualität, gute Frame-rate und wenig Lag. Warum kocht jeder Entwickler hier eine eigene Suppe? Moonlight nur NVidia, AMD-Link nur AMD, NVIdia-Shadowplay nur NVidia und Steam-Gedöns einfach nur schlecht... Möglich, dass mein Router blöd ist und ich mit einer Fritz-Box keine Probleme hätte, aber das sind schon wieder Kosten und mit NVidia auf NVidia läuft es doch auch prima. HW-Decoding sollte ja schnell genug für alle Hersteller sein und das Encodieren übernehme die jeweilige GPU in HW. Steam kriegt es ja so prinzipiell hin, aber die Verbindung oder die Kompression ist doof.

So, genug geschimpft. An sich ist der Treiber absolut brauchbar in Hinsicht auf Gaming, wenn man nur Gaming betreibt und sonst nichts OCed oder einstellt. Sry für den langen Text, aber vllt. habt ihr da ähnliche Erfahrungen?

www.pcgameshardware.de

www.hardwareluxx.de

Als ob du ein Performanceproblem hättest mit deinem Brett von einem Chip.

Als ob du ein Performanceproblem hättest mit deinem Brett von einem Chip. Die Show würde ich gerne hier lesen!

Die Show würde ich gerne hier lesen!  )

)Die Show würde ich gerne hier lesen!

)