Devcom

Enthusiast

- Mitglied seit

- 03.11.2018

- Beiträge

- 1.231

- Ort

- Neben dem Fluss

- Desktop System

- The Unreal

- Details zu meinem Desktop

- Prozessor

- Intel i9 14900KF

- Mainboard

- ASUS ROG Z790 Apex Encore

- Kühler

- Wasser,560er Radi intern+Mo-Ra 420 Noctua,1xD5,2xDDC

- Speicher

- 32Gb G.Skill DDR5 7800mhz

- Grafikprozessor

- SAPPHIRE Radeon RX 7900 XTX NITRO+ Vapor-X 24GB ,Alphacool WB,EVC,

- Display

- Lg 32 850g

- SSD

- 2x Samsung 970 evo 500gb,SPCC 256Gb,Crucial 1Tb

- HDD

- 1xSeagate Ironwolf 12tb

- Gehäuse

- Silverstone Tj 11

- Netzteil

- Corsair Hx 1500i+ Superflower 1300w

- Keyboard

- Endorfy

- Mouse

- Logitech G 602

- Betriebssystem

- Win11/ Bench Win 10

- Webbrowser

- Brave

- Internet

- ▼1000 Mbps ▲50 Mbps

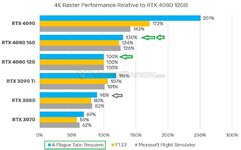

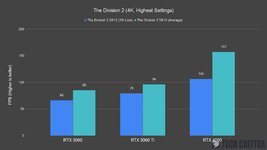

Es sind zur Zeit alles Vermutungen ,ist ja klar... ist was anderes als das:

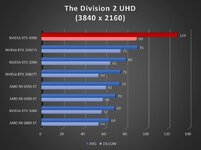

Wenn AMD auf 4080 ti Niveau ist ,das reicht dann für die 4090 mit hoffentlich funktionierenden Mpt ,mit Spannung und PL Erhöhung im TS.

Nvidia lässt nicht ohne Grund so viel Platz zwischen 4080 und 4090.

Und dann hat Amd noch die 7950 -2023-

Es wird spannend.

Wenn das P/L Verhältnis bei der 7900 XT einigermaßen passen sollte, werde ich hier upgraden aber kein NVIDIA!!!!!

Wenn das P/L Verhältnis bei der 7900 XT einigermaßen passen sollte, werde ich hier upgraden aber kein NVIDIA!!!!!