Sollte der Big/Little Ansatz auch nur ansatzweise funktionieren, sodass man damit stark an Die Size sparen kann, weil das Powerlimit eh die Leistung der Cores so stark begrenzt, dass es keinen Sinn macht, da volle Einheiten zu verbauen - dann haben sie schon gewonnen. Der ganze Vergleich - den die Medien da rauf beschwören von wegen AMD 5950X vs. 12900k -> das ist auch eigentlich meiner Ansicht nach gar nicht das Thema. Nach den MF Zahlen verkauft AMD gerade mal knapp 1/10tel so viele 16C wie 6+8C zusammen. Und nur 1/3tel 12+16C zusammen ggü. 6+8C. Für Intel reicht es doch völlig aus ggü. dem 12C gut abzuschneiden. Die letzten 10% - sollen se halt AMD kaufen. Dafür könnte man so ein Alder Lake aber technisch ggü. AMD auch im "H" Notebook bringen. Und mal eben von 8 auf 12, 14C oder 16C hoch gehen. Dafür gibts bei AMD nichtmal ein Design atm. -> das ist dann wieder so ein Markanteilsding.

Ich glaube auch immer noch, dass Intel "to big to fail" ist, aber es gibt auch viele Firmen, die sich über Jahre Millionen- und Milliardenschulden ans Bein gebunden haben, weil eine Strategie nicht aufgegangen ist. Intel kann es sich scheinbar leisten, diese Schiene einfach weiter zu fahren ... und in der ersten Generation zu stolpern. Big/Little hat seine Vorteile und das nicht erst von AMD eingeführte Chiplet Design auch. Die Frage ist, ob Intel von Anfang an das Ganze vernünftig hinbekommt oder erst in Gen 13 oder Gen14, wenn entsprechende Software gut arbeitet und die Effizienz für den Endkunden sichtbar ist. Momentan sehe ich da nur die Effizienz der Produktionskosten seitens Intel.

Ist nicht das erste Mal, das Intel neue Wege geht und gehen muss. Siehe Core CPUs, die damals aus dem sparsamen Mobilbereich kamen, weil Netburst in der Sackgasse stand, oder Tiger Lake (Gen 11), die auch nicht von Ice Lake abstammt.

Ich sehe es nur eben von hinten, vom Endergebnis für den Kunden kritisch.

Jahrelang ergaben neue Produkte eine zum Teil reduzierte Stromaufnahme inkl einer gewissen Leistungssteigerung.

Die letzten Generationen haben einfach nur beim Energieverbrauch zugeschlagen, so dass als Ergebnis beim Endkunden mehr Leistung durch mehr Energieaufnahme ankommt.

Das kann der Kunde aber auch selbst durch OC erreichen, das ist kein Fortschritt im Auge des Endkunden. Vorallem kein Grund, extrem viel Geld für ne neue Plattform und nen Ram auszugeben.

Das ist dann doch zu viel Änderung auf einmal bei Intel.

Auch wenn es so nicht ist, so kommt es einem vor, als würde bestehende Hardware nur mit mehr Strom versorgt, um mehr Leistung zu generieren. Sry

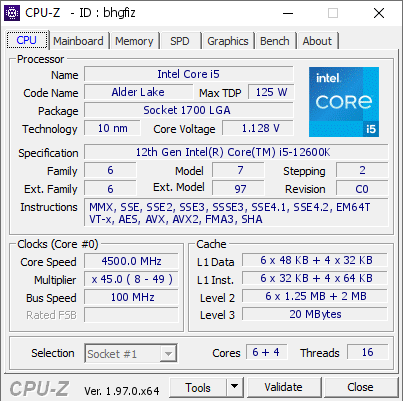

125W TDP für ne i5 12600k ist im Mainstream einfach zu viel! Punkt.

AMD hatte doch bereits mit den mobilen Ryzen 4xxx gezeigt, dass sparsames Energiebuget durchaus mit hoher Leistung kombiniert werden kann.

Wenn man sich in 5 Jahren dann Performance pro Watt ansieht, wird man diese Zeit bei Intel als Stillstand beschreiben können und das in einer Zeit, wo alle von notwendigen Änderungen sprechen, was Energienutzung angeht. Hoffentlich merken Unternehmen irgendwann mal, dass Ressourcen endlich sind, vor allem, wenn Energie weiterhin massiv aus endlichen Ressourcen gewonnen wird.

Ich muss mal eben schnell zur Tanke, ist grade günstiger geworden ...