Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Verständnis Fragen ESXI / Proxmox / ZFS / NAS

- Ersteller fdiskc2000

- Erstellt am

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

HA bzw FT ist aktuell zu Hause nicht geplant

Danke für die Infos

Danke für die Infos

Trambahner

Urgestein

Das ESXI-System selber läuft bei mir von USB Disk geschweige als Miror  Da ist dann noch die Storge-VM (Xigmanas) mit drauf.

Da ist dann noch die Storge-VM (Xigmanas) mit drauf.

VMs hab ich alles bis auf unwichtigen temporären Rumspielkram auf dem NFS-Storage, (dahinter ist ein SSD-Mirror aus zwei PM9A3).

Fällt die USB-Disk aus, muss ich maximal ESXI neu installieren, die Storage VM und ein paar Konfigeinstellungen vornehmen, Die anderen VMs sind dann ja schnell wieder eingehangen, sobald NFS wieder up ist.

> Für zuhause würde ich sagen: so durchfürbar.

Wichtig: Tu Dir einen gefallen und pack VMs nicht mehr auf einen HDD-Pool; das macht keinen wirklichen Spaß bzgl. Reaktionsverhalten und muss heutzutage (trotz ZFS Ramcache) nicht mehr sein.

VMs hab ich alles bis auf unwichtigen temporären Rumspielkram auf dem NFS-Storage, (dahinter ist ein SSD-Mirror aus zwei PM9A3).

Fällt die USB-Disk aus, muss ich maximal ESXI neu installieren, die Storage VM und ein paar Konfigeinstellungen vornehmen, Die anderen VMs sind dann ja schnell wieder eingehangen, sobald NFS wieder up ist.

> Für zuhause würde ich sagen: so durchfürbar.

Wichtig: Tu Dir einen gefallen und pack VMs nicht mehr auf einen HDD-Pool; das macht keinen wirklichen Spaß bzgl. Reaktionsverhalten und muss heutzutage (trotz ZFS Ramcache) nicht mehr sein.

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Es kommen ausschließlich SSDs zum Einsatz, möchte die Kiste fast lautlos betreiben.

Schau mir gerade ZFS for Linux an, viel einfacher geht es gefühlt nicht.

Schau mir gerade ZFS for Linux an, viel einfacher geht es gefühlt nicht.

besterino

Legende

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.663

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

Nee. Einfacher als Original Solaris geht es eigentlich nicht. Wenn man ohne die Updates auskommt… oder die Lizenz zahlen will/kann

Solaris ist ein Betriebssystem das von Sun komplett zusammen und rund um ZFS entwickelt wurde und dazu das einzige Unix war das Windows NT noch Paroli bieten sollte. Ein Filer mit FC/iSCSI, NFS und SMB auf ZFS Basis geht damit auch meiner Ansicht nach unerreicht einfach inkl. Updates zumal Sun ja nicht nur ZFS sondern parallel dazu iSCSI (Comstar) und NFS antwickelte und einen eigenen SMB Server in ZFS integrierte. Man braucht bei Solaris einfach keine 3rd Party Add-ons dafür. Eine Minimalinstallation stellt alles bereit.

Inzwischen würde ich jedoch eher den Solaris Fork OmniOS für einen ZFS Filer empfehlen. Hat als OpenSolaris Abkömmling alle Solaris Vorteile und Dienste, ist so ziemlich die minimalistischste ZFS Option (schnell und stabil) und dazu ein europäisches Projekt (UK und Schweiz). Hauptvorteil auch gegenüber Solaris ist neben der kommerziellen Support Option die eigenen Repositories je Stable oder LTS Version. Das hat nichtmal Solaris und ist ziemlich einzigartig. Man hat damit je OmniOS Version ein Software-Repository das nur Sicherheits und Bugfix Updates liefert (alle zwei bis 6 Wochen) und nicht plötzlich und unerwartet völlig neue Features und Probleme, https://omnios.org/releasenotes.html

Solaris ist zwar sehr stabil und nicht so im Focus bei Hackern. Ohne Updates und Bugfixes (private use) ist es dennoch ein Sicherheitsrisiko. Banken etc schätzen dagegen bei Solaris die garantierten Updates bis mindestens 2034.

Inzwischen würde ich jedoch eher den Solaris Fork OmniOS für einen ZFS Filer empfehlen. Hat als OpenSolaris Abkömmling alle Solaris Vorteile und Dienste, ist so ziemlich die minimalistischste ZFS Option (schnell und stabil) und dazu ein europäisches Projekt (UK und Schweiz). Hauptvorteil auch gegenüber Solaris ist neben der kommerziellen Support Option die eigenen Repositories je Stable oder LTS Version. Das hat nichtmal Solaris und ist ziemlich einzigartig. Man hat damit je OmniOS Version ein Software-Repository das nur Sicherheits und Bugfix Updates liefert (alle zwei bis 6 Wochen) und nicht plötzlich und unerwartet völlig neue Features und Probleme, https://omnios.org/releasenotes.html

Solaris ist zwar sehr stabil und nicht so im Focus bei Hackern. Ohne Updates und Bugfixes (private use) ist es dennoch ein Sicherheitsrisiko. Banken etc schätzen dagegen bei Solaris die garantierten Updates bis mindestens 2034.

Zuletzt bearbeitet:

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Ziemlich abgefahren, wie einfach es mit OpenSolaris ist, zb.: im Raid5 noch eine Hot Spare dazu zu stecken bzw die Erweiterung um eine Disk.

Kenn das bisher nur aus dem Enterprise Bereich, steht dem echt nichts nach.

The Hypetrain has started

Kenn das bisher nur aus dem Enterprise Bereich, steht dem echt nichts nach.

The Hypetrain has started

Ziemlich abgefahren, wie einfach es mit OpenSolaris ist, zb.: im Raid5 noch eine Hot Spare dazu zu stecken bzw die Erweiterung um eine Disk.

Kenn das bisher nur aus dem Enterprise Bereich, steht dem echt nichts nach.

The Hypetrain has started

OpenSolaris war das OpenSource Solaris von Sun. Es wurde von Oracle ca 2010 beendet nachdem die Sun gekauft hatten. Oracle brachte dann das darauf aufbauende kommerzielle Solaris 11. Die Fortsetzung von OpenSolaris war der OpenSource Solaris Fork Illumos mit Distributionen wie OmniOS oder OpenIndiana. Aus ZFS in Illumos entwickelte sich dann das heutige Open-ZFS, das freie ZFS für Free-BSD, Illumos, Linux, OSX und Windows.

ps

Das ZFS Raid Pendant zu Raid-5 heißt Z1. Es heißt anders weil es anders funktioniert, dank Copy on Write kein Write Hole Problem kennt (defektes Raid und Dateisystem nach Absturz) und auch bei Problemen nicht nur Metadaten Fehler erkennt und repariert wie bei ext4 oder ntfs sondern auch Datenfehler.

Raid-Z vdev Erweiterung um einzelne Platten ist noch nicht stable.

Zuletzt bearbeitet:

besterino

Legende

- Mitglied seit

- 31.05.2010

- Beiträge

- 7.663

- Desktop System

- Rechenknecht

- Laptop

- Lenovo Legion 5 (Intel, 4080, 32GB)

- Details zu meinem Desktop

- Prozessor

- Intel i9-13900KS@6300

- Mainboard

- ASUS Maximus Z790 Hero

- Kühler

- Kryo Next S1700, 2xMora 420, Tube 150, 2x Apex VPP, Aquaero 6 Pro, DFS High Flow USB, Farbwerk360

- Speicher

- 32GB (2x16GB @7600)

- Grafikprozessor

- Inno3D RTX 4090 Frostbite

- Display

- 55" OLED (Dell AW5520QF)

- SSD

- 2x4TB NVME PCIe 5.0, Rest (~12TB NVME) über SMB Direct

- HDD

- Näh. Technik von gestern.

- Opt. Laufwerk

- Näh. Technik von gestern.

- Soundkarte

- Cambridge Audio DacMagic 200M

- Gehäuse

- Lian-Li DK-05F

- Netzteil

- Corsair 1000HXi

- Keyboard

- Keychron Q6 Pro, Maxkeyboard Custom Caps, Black Lotus / Dolphin Frankenswitch, Everest Pads

- Mouse

- Swiftpoint Z2

- Betriebssystem

- Windows 11 Pro for Workstations (SMB Direct - yeah baby)

- Sonstiges

- Mellanox ConnectX-4 (Dual 100Gbit Netzwerk + WaKü), Rode NT-USB, Nubert ampX uvm. ...

OmniOS kann aber kein SMB3.1 mit SMB-Multichannel bzw. SMB Direct (RDMA) (wenn nur über die Samba-Krücke) und der Treiber für die ConnectX4 ist auch alles andere als funktional/stable (jedenfalls als SR-IOV Device unter ESXi und auch nativ aufm Blech nicht wirklich)…

Zumindest “last time I checked”…

Zumindest “last time I checked”…

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Die TrueNas Core Entwickler haben FreeBDS mit den ZFS for Linux drunter, was auch "hübsch" aussieht.

Schau ich mir als nächstes direkt mal an.

Schau ich mir als nächstes direkt mal an.

OmniOS kann aber kein SMB3.1 mit SMB-Multichannel bzw. SMB Direct (RDMA) (wenn nur über die Samba-Krücke) und der Treiber für die ConnectX4 ist auch alles andere als funktional/stable (jedenfalls als SR-IOV Device unter ESXi und auch nativ aufm Blech nicht wirklich)…

Zumindest “last time I checked”…

Oracle Solaris 11 und "Original ZFS" hat einige Features die Illumos oder Open-ZFS nicht haben.

Ohne Wartungsvertrag (=mehrere Jahre altes Solaris 11 ohne Updates) ist es aber nicht zu empfehlen.

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

so ganz funktioniert das Design noch nicht, aktuell.Guten Morgen,

aktuell bin ich am hin- und herüberlegen wie ich meine Storage unter das ESXi bereitstelle.

Und wenn ich es richtig verstanden habe, sollte die hier vorgeschlagene Lösung so wie auf dem Bild dann lauffähig sein. (Sorry ich muss mir sowas immer aufmalen)

Jetzt ist die Frage, macht es noch Sinn die OS Disk nochmal in einem Mirror Raid zu hängen, wenn man eh schon dabei ist

Die kleine Storage VM kann man doch gar nicht auf den selben Datastore legen, wo auch das ESXi liegt oder hat sich da was geändert?

Ergo wird ein Datastore für ESX, und ein zweiter Datastore für die Storage VM benötigt.

Habt ihr bei euren Setups dann die Platte/Stick was auch immer auf dem ESX läuft in 2 Partitionen unterteilt oder wie habt ihr das gelöst?

Zuletzt bearbeitet:

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Guten Abend,

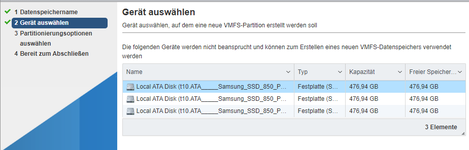

nach diversen probieren und testen, bekomm ich es einfach nicht hin, eine zweite VM auf dem ESXi dataStore abzulegen. (bei mir eine kleine SANDISK SSD)

Möchte ich einen neuen datastore anlegen, wird mir die Sandisk nicht als verfügbare Disk angezeigt und die Partitionen auf der ESXi Disk, kann ich nicht ändern.

Erstelle ich eine neue VM, wird mir der ESXi Datastore nicht mit als verfügbarere Datastore angezeigt, was meiner Meinung nach normal ist.

Was mach ich denn falsch?

Gibt es einen Guide wo beschrieben wird, wie ich meine verbauten Platten an die Storage VM durchreichen kann?

nach diversen probieren und testen, bekomm ich es einfach nicht hin, eine zweite VM auf dem ESXi dataStore abzulegen. (bei mir eine kleine SANDISK SSD)

Möchte ich einen neuen datastore anlegen, wird mir die Sandisk nicht als verfügbare Disk angezeigt und die Partitionen auf der ESXi Disk, kann ich nicht ändern.

Erstelle ich eine neue VM, wird mir der ESXi Datastore nicht mit als verfügbarere Datastore angezeigt, was meiner Meinung nach normal ist.

Was mach ich denn falsch?

Gibt es einen Guide wo beschrieben wird, wie ich meine verbauten Platten an die Storage VM durchreichen kann?

Anhänge

Trambahner

Urgestein

120GB ist zu klein ab ESXI 7, da bei einer Standardinstallation auch noch nen Datastore draufzulegen.

Da müsste man beim Installationsmedium mit Kerneloptionen in der boot.cfg arbeiten, um eine Minimalst-Installation zu erzeugen (da gibts verschiedene Größen als Varianten, z.B. "systemMediaSize=min") und dann auf der Shell händisch partitionieren und ein VMFS6 anlegen. Hab ich selbst bei einer 500er USB-SSD gemacht und kann damit z.B. die Storage-VM für ZFS mit auf die USB-Disk legen. Damit bleibt bei Intel der Onboard-Sata zum Durchreichen an die Storage-VM verfügbar, bei AMD klappt das Letztere eher selten so dass man da einen extra Hostbusadapter braucht, wenn man nicht einzelne Platten per RDM durchreichen will.

Die restlichen VMs liegen ja bei mir dann auf ZFS-Pool via NFS-Datastore.

Edit: gea schreibts ja auch grad. Einzelne Sata-Platten per RDM durchreichen ist offiziell nicht supportet und nur mit Tricks erreichbar. Und Garantie das es geht gibts dafür nicht. Ein extra Hostbusadapter ist da in der Regel die stressfreiere Variante.

Doku dieses Eintrags in der boot.cfg siehe hier bei Vmware selber.

ESXI hat mit Version 7 da eine andere Aufteilung der Partitionen als das noch bis 6.7 der Fall war.

Da müsste man beim Installationsmedium mit Kerneloptionen in der boot.cfg arbeiten, um eine Minimalst-Installation zu erzeugen (da gibts verschiedene Größen als Varianten, z.B. "systemMediaSize=min") und dann auf der Shell händisch partitionieren und ein VMFS6 anlegen. Hab ich selbst bei einer 500er USB-SSD gemacht und kann damit z.B. die Storage-VM für ZFS mit auf die USB-Disk legen. Damit bleibt bei Intel der Onboard-Sata zum Durchreichen an die Storage-VM verfügbar, bei AMD klappt das Letztere eher selten so dass man da einen extra Hostbusadapter braucht, wenn man nicht einzelne Platten per RDM durchreichen will.

Die restlichen VMs liegen ja bei mir dann auf ZFS-Pool via NFS-Datastore.

Edit: gea schreibts ja auch grad. Einzelne Sata-Platten per RDM durchreichen ist offiziell nicht supportet und nur mit Tricks erreichbar. Und Garantie das es geht gibts dafür nicht. Ein extra Hostbusadapter ist da in der Regel die stressfreiere Variante.

Doku dieses Eintrags in der boot.cfg siehe hier bei Vmware selber.

ESXI hat mit Version 7 da eine andere Aufteilung der Partitionen als das noch bis 6.7 der Fall war.

Zuletzt bearbeitet:

Falls es ein Datastore gibt, kann man da virtuelle Platten anlegen. Um physikalische Platten an eine VM durchzureichen kann man entweder den kompletten Plattencontroller durchreichen oder bei einem SAS HBA auch einzelne Platten. Um Sata Platten durchzureichen muss man tricksen.

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Wenn ich das richtig verstehe, wird alles bis 128GB in die ESXi Paritionierung gesteckt und alles was darüber ist, in einen extra VMFS.

@Trambahner

Wie groß ist deine ZFS VM mit eingerechneter RAM Größe?

@gea

ich möchte 3x 512 GB SATA SSDs direkt physisch an meine True NAS VM durchreichen, probiere gerade aus, welche ZFS implementierung mir am besten gefällt

Aber eben ohne zusätzlichen Raidcontroller, wobei ich noch einen Dell PERC 720 rumliegen habe.

@Trambahner

Wie groß ist deine ZFS VM mit eingerechneter RAM Größe?

@gea

ich möchte 3x 512 GB SATA SSDs direkt physisch an meine True NAS VM durchreichen, probiere gerade aus, welche ZFS implementierung mir am besten gefällt

Aber eben ohne zusätzlichen Raidcontroller, wobei ich noch einen Dell PERC 720 rumliegen habe.

Zuletzt bearbeitet:

Trambahner

Urgestein

Ja, bei USB als Datastore wie bei mir ist das dann mit dem Partitionieren eben nochmal trickreicher. Sata wollte ich nicht nutzen damit der für Passthrough frei bleibt, was aber dann nicht geklappt hat.

Die ZFS-VM ? 16GB VDiskspace (thin provisioniert) für FreeBSD , 24GB VRam sowie 2 vCPU (von einem 5600X). Poolsize 6x14TB HDD (WD HC530) als Raidz2 (an 9211-8i (vorher mal 9400-16i) als durchgereichter HBA) sowie 2x8TB SSD (Samsung PM9A3) als Mirror.

von den 16GB Disk sind vielleicht 2 bis max 3 belegt.

Vom Durchreichen einzelner Sata-Disks per RDM und den Tricks halte ich nix; hat beim Probieren vor ein paar Jahren mal nicht stabil funktioniert. Mach ich nie wieder,. Nur noch ganze Controller.

Die ZFS-VM ? 16GB VDiskspace (thin provisioniert) für FreeBSD , 24GB VRam sowie 2 vCPU (von einem 5600X). Poolsize 6x14TB HDD (WD HC530) als Raidz2 (an 9211-8i (vorher mal 9400-16i) als durchgereichter HBA) sowie 2x8TB SSD (Samsung PM9A3) als Mirror.

von den 16GB Disk sind vielleicht 2 bis max 3 belegt.

Vom Durchreichen einzelner Sata-Disks per RDM und den Tricks halte ich nix; hat beim Probieren vor ein paar Jahren mal nicht stabil funktioniert. Mach ich nie wieder,. Nur noch ganze Controller.

Zuletzt bearbeitet:

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

ich mal ob ich noch was mit mehr als 128GB rumliegen habe

@gea

ich möchte 3x 512 GB SATA SSDs direkt physisch an meine True NAS VM durchreichen, probiere gerade aus, welche ZFS implementierung mir am besten gefällt

Aber eben ohne zusätzlichen Raidcontroller, wobei ich noch einen Dell PERC 720 rumliegen habe.

Wenn man einzelne (oder alle) Sata/SAS Platten ohne "Murks" durchreichen möchte, braucht man einen SAS HBA z.B LSI 9300 oder oem.

Ein Raid 5/6 Controller zählt unter ZFS ebenfalls zu "Murks"

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

der PERC zählt auch in die "Murks" Kategorie?

Dieser würde dann die einzelnen Platten durch reichen damit der Raidz1 dann Futter bekommt.

Dieser würde dann die einzelnen Platten durch reichen damit der Raidz1 dann Futter bekommt.

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Bin gerade am einbauen, melde mich, wenn ich fertig damit bin.

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

In meiner naiven Welt hab ich natürlich die falschen SFF 8088 Kabel für den Perc bestellt und vorhin festgestellt, das diese nicht passen.

Weiß wer ob es die Anschlusskabel auch nur mit Datenbus also ohne Strom gibt?

Eine Option wäre diese wie auch dem Bild hier, aber nur das Kabel hab ich noch nicht gefunden und falls ich es finde, muss ich erstmal rausbekommen was für ein Stromstecker das ist, denn der hat keinen passenden Anschluss auf dem Controller selber, also muss mit einem Adapter ans Netzteil angeschlossen werden.

Spezifikation des Controllers

Weiß wer ob es die Anschlusskabel auch nur mit Datenbus also ohne Strom gibt?

Eine Option wäre diese wie auch dem Bild hier, aber nur das Kabel hab ich noch nicht gefunden und falls ich es finde, muss ich erstmal rausbekommen was für ein Stromstecker das ist, denn der hat keinen passenden Anschluss auf dem Controller selber, also muss mit einem Adapter ans Netzteil angeschlossen werden.

Spezifikation des Controllers

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

danke für den Tipp das passt.

Ich hab noch eine andere Frage, könnte mir wer eine dual Port (esxi7 kompatible) 1GBit Netzwerkkarte empfehlen, welche nur einen PCIe Slot belegt?

Meine Dual Port Karte braucht leider mindestens einen 2x Slot, den ich aber nicht mehr frei habe mit GPU und Raid Controller.

Ich hab noch eine andere Frage, könnte mir wer eine dual Port (esxi7 kompatible) 1GBit Netzwerkkarte empfehlen, welche nur einen PCIe Slot belegt?

Meine Dual Port Karte braucht leider mindestens einen 2x Slot, den ich aber nicht mehr frei habe mit GPU und Raid Controller.

Trambahner

Urgestein

# Dell PERC H710P ? Das ist ein Raid-Hardwarecontroller und kein Hostbusadapter . Chipsas SAS2208. > "Murks" für ZFS wenn da keine IT-Mode Firmware drauf ist oder nicht flashbar wäre.

Für ZFS und damit auch zum Durchreichen in eine ESXI-VM oder aber direkt unter Linux/Solaris brauchst Du nen dummen Hostbusadapter ohne jegliche Raidfunktion und ohne Cache.

=> als Mirror-Raidcontroller wo ESXI selber drauf ist, kann man den H710 durchaus nehmen. Aber dafür ist er viel zu überkandidelt.

Was meinst Du mit "2x Slot"? Breite wie bei Grafikkarten (was ich für unwahrscheinliche halte) oder Lanes? Ich nehme an : Lanes.

Dual Port Karten mit vernünftigen Chipsätzen wirst Du nicht finden mit PCIe mit x2 Lanes mechanisch . Aber falls das ein mechanischer x4 Slot ist, der elektrisch 2.0x1 oder 3.0x1 hat, sollte das klappen.

Halte Dich fern von Karten mit Realtek oder Marvell/Aquantia-Chipsätzen für ESXI. Entweder laufen sie gar nicht (mehr) oder nur mit Treibergefrickel. Du willst Da Intel Serverchipsätze (i210, i211, i350, x540, x550).

=> Intel i350-T2 oder Intel i350-T4 sind da Goldstandard (Achtung: da gibts viele Plagiate/Fakes). Die brauchen aber zwingend mechanisch x4 Slots (oder ein x1 Slot, wenn der offen ist und dahinter Platz.).

Alternativ Intel x540/x550 bei 10Gbit Kupfer. Da sind wir dann bei 2.0x8 bzw. 3.0x4 (X550) Slots.

=> Du kannst auch ein Riserkabel/-karte nehmen und aus einem PCIe M.2-Steckplatz (keine Sata-only M.2 !!) einen PCIe-Slot machen und dort ne NIC reinpacken. Vmtl. muss der Slot dann aber mit Strom versorgt werden.

Eventuell kann Dein Board+CPU aber auch per PCIe-Bifurcation und einer Riserkarte den x16-Slot aufteilen, in x8x4x4 oder x8x8 z.B. So kann man evtl. auch PCIe-Slots gewinnen,

Das kann aber nicht jedes Board/CPU/Bios.

Für ZFS und damit auch zum Durchreichen in eine ESXI-VM oder aber direkt unter Linux/Solaris brauchst Du nen dummen Hostbusadapter ohne jegliche Raidfunktion und ohne Cache.

=> als Mirror-Raidcontroller wo ESXI selber drauf ist, kann man den H710 durchaus nehmen. Aber dafür ist er viel zu überkandidelt.

Was meinst Du mit "2x Slot"? Breite wie bei Grafikkarten (was ich für unwahrscheinliche halte) oder Lanes? Ich nehme an : Lanes.

Dual Port Karten mit vernünftigen Chipsätzen wirst Du nicht finden mit PCIe mit x2 Lanes mechanisch . Aber falls das ein mechanischer x4 Slot ist, der elektrisch 2.0x1 oder 3.0x1 hat, sollte das klappen.

Halte Dich fern von Karten mit Realtek oder Marvell/Aquantia-Chipsätzen für ESXI. Entweder laufen sie gar nicht (mehr) oder nur mit Treibergefrickel. Du willst Da Intel Serverchipsätze (i210, i211, i350, x540, x550).

=> Intel i350-T2 oder Intel i350-T4 sind da Goldstandard (Achtung: da gibts viele Plagiate/Fakes). Die brauchen aber zwingend mechanisch x4 Slots (oder ein x1 Slot, wenn der offen ist und dahinter Platz.).

Alternativ Intel x540/x550 bei 10Gbit Kupfer. Da sind wir dann bei 2.0x8 bzw. 3.0x4 (X550) Slots.

=> Du kannst auch ein Riserkabel/-karte nehmen und aus einem PCIe M.2-Steckplatz (keine Sata-only M.2 !!) einen PCIe-Slot machen und dort ne NIC reinpacken. Vmtl. muss der Slot dann aber mit Strom versorgt werden.

Eventuell kann Dein Board+CPU aber auch per PCIe-Bifurcation und einer Riserkarte den x16-Slot aufteilen, in x8x4x4 oder x8x8 z.B. So kann man evtl. auch PCIe-Slots gewinnen,

Das kann aber nicht jedes Board/CPU/Bios.

Zuletzt bearbeitet:

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

danke für die ausführliche Beschreibung,

ich habe das Tomahawk Max 2 Board mit 5x PCIe onboard.

Die 2x 16er Slots sind durch den PERC und Grafikkarte belegt und so habe ich nur noch die kurzen (4x)

Natürlich meinte ich Lanes.

Im Bios gibt es nur die Optionen:

PCIe 16x+ 16x oder 4x 4x 4x 4x.

M2 habe ich zur Zeit gar nicht im Einsatz(ist auch nicht geplant) und den PERC reiche ich mit 3x SATA Platten ohne jegliche Raidkonfig an die ZFS VM durch.

Ich kann mir zwar irgendwie nur schlecht vorstellen, das der Standard Raidcontroller der in allen möglichen Dell PE`s verbaut ist echt "murks" ist, aber da ich erst in der ZFS Welt noch Anfänger bin, möchte ich mich da nicht zu weit aus dem Fenster hängen

Den Perc hatte ich auch noch bin einem alten R720XD rumliegen, der ist natürlich nicht zwingend erforderlich, ich kann mir auch was anderes kaufen.

Zum Thema flashen gibt es hier einen interessanten Post von den Fohdeesha Jungs, ich muss mich erstmal einlesen was es mit dem IT-Mode auf sich hat, alles neue Welt gerade.

Die Intel i350-T2 und eine i210 hab ich bestellt, danke

ich habe das Tomahawk Max 2 Board mit 5x PCIe onboard.

Die 2x 16er Slots sind durch den PERC und Grafikkarte belegt und so habe ich nur noch die kurzen (4x)

Natürlich meinte ich Lanes.

Im Bios gibt es nur die Optionen:

PCIe 16x+ 16x oder 4x 4x 4x 4x.

M2 habe ich zur Zeit gar nicht im Einsatz(ist auch nicht geplant) und den PERC reiche ich mit 3x SATA Platten ohne jegliche Raidkonfig an die ZFS VM durch.

Ich kann mir zwar irgendwie nur schlecht vorstellen, das der Standard Raidcontroller der in allen möglichen Dell PE`s verbaut ist echt "murks" ist, aber da ich erst in der ZFS Welt noch Anfänger bin, möchte ich mich da nicht zu weit aus dem Fenster hängen

Den Perc hatte ich auch noch bin einem alten R720XD rumliegen, der ist natürlich nicht zwingend erforderlich, ich kann mir auch was anderes kaufen.

Zum Thema flashen gibt es hier einen interessanten Post von den Fohdeesha Jungs, ich muss mich erstmal einlesen was es mit dem IT-Mode auf sich hat, alles neue Welt gerade.

Die Intel i350-T2 und eine i210 hab ich bestellt, danke

Zuletzt bearbeitet:

Trambahner

Urgestein

Der Hardwareraidcontroller ist auch absolut ok für z.B. Windows server, aber ist halt ohne IT-Mode nix für ZFS. ZFS will die SSD oder HDD direkt ansprechen ohne weiteren Cache oder Layer dazwischen. Das ist das was "gea" angesprochen hat als er von "Murks für ZFS" schrieb.

Ah, da kommen wir der Hardware doch schon näher. Wichtig zum Empfehlen von Möglichkeiten.

Hm, x4x4x4x4 bringt Dir nix es sei denn Du willst die GPU per Riser auf einen x4-Link beschränken. Für reine Desktopdarstellung und Server-OS mehr als ok, aber nix für gaming.

Falls da eine 2000er oder 3000er APU drin ist, hast Du mein ich sogar nur 8 Lanes, wenn Du die iGPU nutzt. Bei 4000er und 5000er APUs ist das was anderes.

Bei non-APUs könntest wirklich 3.0 x4x4x4x4 nutzen

Problem ist der 450er Chipsatz, der hat alle Lanes die am Chipsatz hängen nur mit 2.0er Standard.

Der zweite (=untere) x16 Slot ist nur mechanisch x16, elektrisch aber 2.0x4 da er am Chipsatz hängt . D.h. mehr als 1700 MB/s kann der Slot nicht übertragen. Und wenn was in anderen x1 PCI_E2/ PCI_E3 steckt, sogar nur elektrisch 2.0x2. Das limitiert Dich dann auf 850 MB/s ! IMO no way gangbar für einen HBA, wenn da SSDs dran hängen.

Die anderen 2.0x1 Slots sind zu, d.h. da geht mechanisch keine x4 Karte.

=> Da Du M.2 nicht als SSD geplant hast, kannst Du diesen Slot per Riseradapter zu einem x4 Slot umnutzen. Da kannste dann eine x4-NIC dranpacken. Es gibt auch solche Adapter mit mechanisch x16, elektrisch x4 . Da kannste dann evtl. sogar nen Raidcontroller oder HBA dranpacken, wenn die Stromversorgung passt und der Controller/HBA sinnvollerweise PCIe gen 3 ist. Meist ist da ein 5+12V Floppystecker dran an den Adaptern.

Ist im Prinzip die einzige Chance auf einen weiteren 3.0x4 PCIe-Link in dem Setup. Aber halt auch nur, wenn der Controller

Interessant, ECC-Funktionalität wird hier in den Specs sogar ausgeschlossen.

Unterm Strich: der B450 bremst Dich hier bzgl. möglicher I/O ziemlich hart aus. Ebenso der gen 2.0 Controller falls da SSDs ran sollen.

Aber ich vermute mal, das ist einfach ein Reuse von Board+CPU aus einer Gaming-Maschine? Recht suboptimal das ganze... zum rumspielen ok, als wirklich genutzter Server: mehhhhhh aus meiner Sicht.

Ah, da kommen wir der Hardware doch schon näher. Wichtig zum Empfehlen von Möglichkeiten.

Hm, x4x4x4x4 bringt Dir nix es sei denn Du willst die GPU per Riser auf einen x4-Link beschränken. Für reine Desktopdarstellung und Server-OS mehr als ok, aber nix für gaming.

Falls da eine 2000er oder 3000er APU drin ist, hast Du mein ich sogar nur 8 Lanes, wenn Du die iGPU nutzt. Bei 4000er und 5000er APUs ist das was anderes.

Bei non-APUs könntest wirklich 3.0 x4x4x4x4 nutzen

Problem ist der 450er Chipsatz, der hat alle Lanes die am Chipsatz hängen nur mit 2.0er Standard.

Der zweite (=untere) x16 Slot ist nur mechanisch x16, elektrisch aber 2.0x4 da er am Chipsatz hängt . D.h. mehr als 1700 MB/s kann der Slot nicht übertragen. Und wenn was in anderen x1 PCI_E2/ PCI_E3 steckt, sogar nur elektrisch 2.0x2. Das limitiert Dich dann auf 850 MB/s ! IMO no way gangbar für einen HBA, wenn da SSDs dran hängen.

Die anderen 2.0x1 Slots sind zu, d.h. da geht mechanisch keine x4 Karte.

=> Da Du M.2 nicht als SSD geplant hast, kannst Du diesen Slot per Riseradapter zu einem x4 Slot umnutzen. Da kannste dann eine x4-NIC dranpacken. Es gibt auch solche Adapter mit mechanisch x16, elektrisch x4 . Da kannste dann evtl. sogar nen Raidcontroller oder HBA dranpacken, wenn die Stromversorgung passt und der Controller/HBA sinnvollerweise PCIe gen 3 ist. Meist ist da ein 5+12V Floppystecker dran an den Adaptern.

Ist im Prinzip die einzige Chance auf einen weiteren 3.0x4 PCIe-Link in dem Setup. Aber halt auch nur, wenn der Controller

Interessant, ECC-Funktionalität wird hier in den Specs sogar ausgeschlossen.

Unterm Strich: der B450 bremst Dich hier bzgl. möglicher I/O ziemlich hart aus. Ebenso der gen 2.0 Controller falls da SSDs ran sollen.

Aber ich vermute mal, das ist einfach ein Reuse von Board+CPU aus einer Gaming-Maschine? Recht suboptimal das ganze... zum rumspielen ok, als wirklich genutzter Server: mehhhhhh aus meiner Sicht.

Zuletzt bearbeitet:

Mac_leod

Enthusiast

- Mitglied seit

- 10.04.2005

- Beiträge

- 366

- Ort

- Dresden

- Desktop System

- Kuh

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asrock X670E Steel Legend

- Kühler

- Cuplex Kryos next, EK Quantum Vektor2 für die GPU, 1x Mora360 1x Mora 420

- Speicher

- G.Skill F5-6400J3239G 2x 16G

- Grafikprozessor

- Geforce RTX 4090

- Display

- 2x DELL S2721DGF

- SSD

- Kingston SKC3000D 4TB

- Netzteil

- Seasonic Vertex 1000W

- Keyboard

- Logitech G915 TKL

- Mouse

- Logitech G903 Lightspeed

- Betriebssystem

- Win11 22H2

- Internet

- ▼250Mbit ▲50MBit

Es steckt ein 2700X drin inkl. einem 32GB RAM Modul (welche wohl nicht so lang allein bleiben wird), den ich am liebsten gegen ein Modell mit iGPU tauschen würde, dann hätte ich den ganzen Spaß mit umgangen.

Möchte auf nicht Firmensystemen für Kunden diverse Windows Server Umgebungen nachbauen um unterschiedlichste Support Probleme zu betrachten.

Da eine SharePoint Farm ohne DCs und Exchange wenig Sinn machen, werden viele Kerne benötigt, alles eher Hobby

Der Ansatz DCs im Docker Container ist auch echt spannend.

Dazu noch ein wenig NextCloud + Seafile für mich privat, da spielt der Datendurchsatz tatsächlich nur eine untergeordnete Rolle.

SSDs werden nur verbaut, damit das System zu 99% silent läuft und die Zugriffszeiten akzeptabel sind.

Die Idee den PERC zu flashen und dann per Raiserkarte an den M.2 zu hängen find ich sehr gut, direkt mal nachsehen was man da verbauen sollte. ist die Frage ob der PCIe Gen3 ist.

z.B: sowas hier

Was gerade noch aufgefallen ist, stell ich auf 4x 4x 4x 4x um, funktionieren Grafikkarten nur noch im unteren PCIe Slot. Steck ich diese in den oberen, bekomm ich den Code für „Monitor or display card error“

Möchte auf nicht Firmensystemen für Kunden diverse Windows Server Umgebungen nachbauen um unterschiedlichste Support Probleme zu betrachten.

Da eine SharePoint Farm ohne DCs und Exchange wenig Sinn machen, werden viele Kerne benötigt, alles eher Hobby

Der Ansatz DCs im Docker Container ist auch echt spannend.

Dazu noch ein wenig NextCloud + Seafile für mich privat, da spielt der Datendurchsatz tatsächlich nur eine untergeordnete Rolle.

SSDs werden nur verbaut, damit das System zu 99% silent läuft und die Zugriffszeiten akzeptabel sind.

Die Idee den PERC zu flashen und dann per Raiserkarte an den M.2 zu hängen find ich sehr gut, direkt mal nachsehen was man da verbauen sollte. ist die Frage ob der PCIe Gen3 ist.

z.B: sowas hier

Was gerade noch aufgefallen ist, stell ich auf 4x 4x 4x 4x um, funktionieren Grafikkarten nur noch im unteren PCIe Slot. Steck ich diese in den oberen, bekomm ich den Code für „Monitor or display card error“

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 21

- Aufrufe

- 1K

- Antworten

- 62

- Aufrufe

- 5K

- Antworten

- 42

- Aufrufe

- 5K

- Antworten

- 6

- Aufrufe

- 747