Mal ein paar aktuelle Beispiele, an dennen ich dir zeigen kann, dass der Unterschied deutlich größer ausfallen wird.

1) Hyperthreading hilft in Games deutlich

Zwischen einem 2500k und 2600k liegen nur 100MHz und eben Hyperthreading. In Cinebench sollten laut theoretischem Test maximal 25% im Extremfall bei rumkommen. Bei Games, welche eine Mindesthreadzahl fordern sieht das aber auch mal ganz anders aus. Nicht nur weil sich der 2600k absetzt, sondern weil die fehlenden Ressorcen dem 2500k das Genick brechen.

BF1, DX12, Computerbase

Warum ist das so? Eine CPU, welche zu 100% ausgelastet ist, kann einfach keine kritischen Aufgaben mehr dazwischen schieben, sodass man deutliche Hänger oder Leistungseinbußen hat. Willkommen im SingleCore-Zeitalter - Manche erinnern sich. Eingrund weshalb ich vor Jahren schon einen Intel E3-Xeon empfholen habe. Das hohe OC eines 6600k verpufft daher in der Bedeutungslosigkeit. Ein Grund weshalb eben auch CPUs mit mehr Kernen die deutlich besseren Frametimes aufweisen.

2) fehlende Kerne kann man nicht immer durch Hyperthreading ersetzen.

Zwischen dem 2500k und dem 7700k liegen 30% Takt, Hyperthreading und über 30% IPC. Es kommt fast nichts davon an.

3) Es wird auch Spiele geben, welche nicht alle Kerne nutzen, na und?

3) Es wird auch Spiele geben, welche nicht alle Kerne nutzen, na und?

Es ist doch keine Überraschung, dass es Spiele geben wird, welche auch mal nicht alle Kerne nutzen. Viel interessanter ist die Tatsache, dass man durch einen ausreichenden Takt von grob 3,5Ghz und eine aktuelle IPC keine Nachteile hat. Viele moderne Spielengines zeigen bereits, dass Threads wichtiger sind als ein hoher Takt. Die Spielentwickler kommen nicht drum herum den Overhead zu reduzieren. Selbst unter DX11. 5Ghz als Vorrasusetzung werden wir nicht sehen in den nächten Jahren.

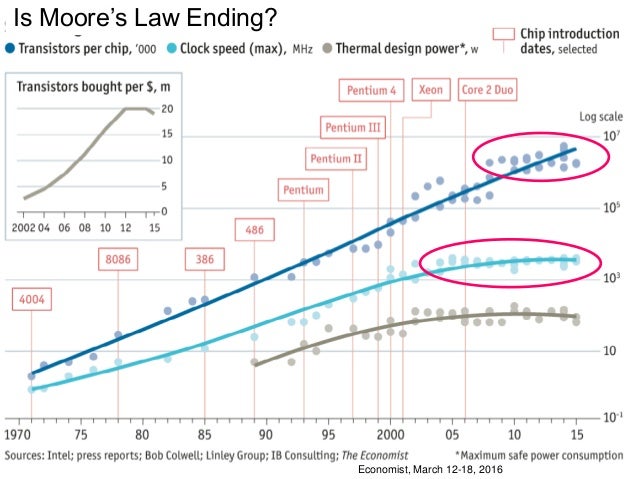

10 Jahre alt. Nach wie vor aktuell. Takt hängt bei grob 4GHz.

Ich bin zwar auch immer davon ausgegagen, dass moderne Spiele eine moderne IPC und Takt vorraussetzen, aber mal ein Beispiel, welches das Gegenteil eindrucksvoll beweist. 2Ghz als Gaming-CPU wäre vor ein paar Jahren noch eine Lachnummer gewesen. Hier skaliert die Engine mit 10 Kernen und lediglich 2GHz Takt suverän ins GPU-Limit. Klar reichen 4 Kerne mit hohem Takt auch aus, darum geht es aber nicht. 4 schnelle Kerne reichen aus, dass heißt aber nicht, dass sie schneller sind.

Beispiel: mit 4 Ghz und 4 Kernen ab ins GPU-Limit.

Dreht man einmal den Takt auf sehr niedrige 2 GHz runter sieht man wie gut die Engine skaliert. Und siehe da man ist wieder im GPU-Limit, also der Grafikkarte geht die Luft aus. Und das wo doch 2 GHz ein Unding sind! Leider hat der 6950x "nur" 10 Cores, daher man sieht garnicht ob noch mehr möglich wäre.

4) Wie sieht die perfekte Gaming CPU aus?

Die gibt es schlicht nicht. Da die Software zu unterschiedlich ist. Aber im Schnitt über alle Anwendungen ist die Frage ganz einfach zu beantworten, da dies Ausreißer ausschließt.

IPC, Takt, Kerne, Threads - jede dieser Eigenschaften sollte man soweit wie möglich mit seinem Budget ausreizen.

Vor 2 Jahren habe ich immer den 5820k empfohlen, aber der war ja vielen schon zu sehr "mehr als 4 Kerne braucht man ja eh nicht". Schauen wir mal in 2 Jahren wieder vorbei. Dann ist mein 5960x an die 4,5 Jahre alt @ Stock schneller als jeder Quad@OC in Games. Bereits heute ist die CPU im Schnitt ja so schnell wie der 7700k trotz 1 Ghz weniger Takt. Und dann kommen noch die 50% OC. Vielleicht topt die Platform ja die Nutzungsdauer von 7 Jahren meines Q6600@3,7Ghz.

Ich bin hier weder für AMD noch für Intel. Ich bekämpfe nur den "4 Kerne reicht für alles Blödsinn" und die mangelhaften Testberichte oder nicht vorhandenen Prognosen zur Zukunft der Gaming-CPUs.

Könnte man machen, da aber AMD über das ganze Ryzen-Lineup mehr Kerne bzw Threads bietet als Intel ist das dann schon wieder egal. Klar sind 8 Kerne in den Konsolen verbaut, aber die Skalierung der Titel zeigt, dass im Gegensatz zu früher hier nicht mehr genau dort aufgehört wird mit der Paralelisierung. Ein Grund wird vermutlich sein, dass die Release-Abstände der Konsolen dank PC Technik nun kleiner ausfallen.