layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Hier mal was zum Vergleichen:

OI läuft als VM unter ESXi 4.1U1 mit Intel Xeon X3450, 16 GB RAM, OI 8GB reservierter RAM und passthrough HBA LSI9211-8

OI-Server <==> Win7 x64 Client

TCP connection established.

Packet size 1k bytes: 103.09 MByte/s Tx, 30.78 MByte/s Rx.

Packet size 2k bytes: 104.43 MByte/s Tx, 30.20 MByte/s Rx.

Packet size 4k bytes: 107.22 MByte/s Tx, 44.61 MByte/s Rx.

Packet size 8k bytes: 100.49 MByte/s Tx, 42.49 MByte/s Rx.

Packet size 16k bytes: 99.99 MByte/s Tx, 43.22 MByte/s Rx.

Packet size 32k bytes: 95.01 MByte/s Tx, 43.04 MByte/s Rx.

Done.

Win7 x64 Server <==> OI-Server Client

TCP connection established.

Packet size 1k bytes: 101031 KByte/s Tx, 109748 KByte/s Rx.

Packet size 2k bytes: 108586 KByte/s Tx, 110564 KByte/s Rx.

Packet size 4k bytes: 106529 KByte/s Tx, 113049 KByte/s Rx.

Packet size 8k bytes: 109598 KByte/s Tx, 110413 KByte/s Rx.

Packet size 16k bytes: 105809 KByte/s Tx, 106210 KByte/s Rx.

Packet size 32k bytes: 107379 KByte/s Tx, 104964 KByte/s Rx.

Done.

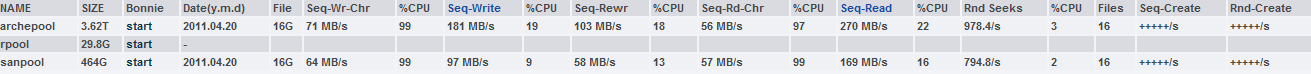

Bonnie++ siehe Anlage:

sanpool: 2 x Hitachi HDS72105 Mirror

archepool 2 x 2 SAMSUNG HD203WI Mirror

OI läuft als VM unter ESXi 4.1U1 mit Intel Xeon X3450, 16 GB RAM, OI 8GB reservierter RAM und passthrough HBA LSI9211-8

OI-Server <==> Win7 x64 Client

TCP connection established.

Packet size 1k bytes: 103.09 MByte/s Tx, 30.78 MByte/s Rx.

Packet size 2k bytes: 104.43 MByte/s Tx, 30.20 MByte/s Rx.

Packet size 4k bytes: 107.22 MByte/s Tx, 44.61 MByte/s Rx.

Packet size 8k bytes: 100.49 MByte/s Tx, 42.49 MByte/s Rx.

Packet size 16k bytes: 99.99 MByte/s Tx, 43.22 MByte/s Rx.

Packet size 32k bytes: 95.01 MByte/s Tx, 43.04 MByte/s Rx.

Done.

Win7 x64 Server <==> OI-Server Client

TCP connection established.

Packet size 1k bytes: 101031 KByte/s Tx, 109748 KByte/s Rx.

Packet size 2k bytes: 108586 KByte/s Tx, 110564 KByte/s Rx.

Packet size 4k bytes: 106529 KByte/s Tx, 113049 KByte/s Rx.

Packet size 8k bytes: 109598 KByte/s Tx, 110413 KByte/s Rx.

Packet size 16k bytes: 105809 KByte/s Tx, 106210 KByte/s Rx.

Packet size 32k bytes: 107379 KByte/s Tx, 104964 KByte/s Rx.

Done.

Bonnie++ siehe Anlage:

sanpool: 2 x Hitachi HDS72105 Mirror

archepool 2 x 2 SAMSUNG HD203WI Mirror

Anhänge

Zuletzt bearbeitet:

Irgendwie hatte ich keinen Draht auf ORACLE).

Irgendwie hatte ich keinen Draht auf ORACLE).

)

)