@ gea, laeyerbreak,

habe mal nach den Preisen für den 9211-8i geschaut. Die günstigste Variante war über 218 Euro. Neue Festplatten kommen mich teurer z.Zt

.

Muss ich mir nochmal überlegen.

Neue Festplatten zu akzeptablen Preisen wird es wohl erst im II. Qu. 2012 wieder geben. Bis dahin wird der Markt von "Wegelagerern" bestimmt.

Also schau einfach, dass du die Zeit bis dahin überbrücken kannst.

Den Test-Server SM X8Si6-F werde ich vorerst mit SATA der Gen 1 betreiben.

Ich hatte dir doch

hier geschrieben, dass es eine Alternative, für weniger als die Hälfte, zu dem LSI9211-8i gibt.

Einer der Gründe für den Storage Server war ja meine Festplatten zu konsolidieren damit ich den meisten Nutzen aus meinen bestehenden Platten raushole, anstatt TB's ungenutzt in verschiedenen Systemen hängen zu haben.

Mit Expandern habe ich gar keine Erfahrung. Würde mich aber interessieren. Habt Ihr vielleicht einen guten Link wo ich mal, als Anfänger zu diesem Thema, mich einlesen kann?

Reale Erfahrung hab ich mit Expandern bis jetzt auch noch nicht. Aber schau doch hier im Oktober nach, da war Expander ein Thema.

Du hast doch den Intel SASUC8i Controller und da weis ich nicht, ob er für den

Intel® RAID Expander Card RES2SV240 geeignet ist. Das sollte dir @gea am ehesten beantworten können.

(Was würde ich denn, außer der Expanderkarte, noch an Hardware brauchen? (Sprich Gehäuse?)

Uih uih.

Zuerst hatte ich ein großes Towergehäuse. Bald war mir aber der Kabelknäuel ein Kraus, denn die Fan-out-Kabel sind nicht einfach zu verstecken. Auch hatte ich für die HDs keine Lüftung.

Dann bin ich über ein US-Forum auf das Servergehäuse

Norco RPC-4224 gestoßen.

Geordert habe ich das Case in

GB, gibts aber auch in

NL.

Als ich im Sommer einen heavy load auf das System hatte stieg die HD-Temp. über 40 Grad und da wurde es Zeit für einen Mod.

Folgendes hab ich dann an dem Case gemacht:

In NL das

Blech für 12 cm Lüfter gekauft.

Alle Lüfter gegen Supermicros 4-pin PWM ausgetauscht und die Lüfter direkt auf das X8Sia-F Board gesteckt.

3 X Supermicro FAN-0077L4, 120/120/38, 4-pin PWM Fan, Rated Current (A): 0.68, Fan Speed (RPM):4,000, Air Flow (CFM): 148.3, Static Pressure (in.H20):0.60, Noise (dBA): 51.0

2 X Supermicro FAN-0062L4, 80/80/32, 4-pin PWM Fan, Rated Current (A): 0.55, Fan Speed (RPM):5,000, Air Flow (CFM):59.1, Static Pressure (in.H20):0.49, Noise (dBA): 47.0

Supermicro Xeon passiv Kühler SNK-P0046P, Supermicro Air Shroud MCP-310-48003-0N

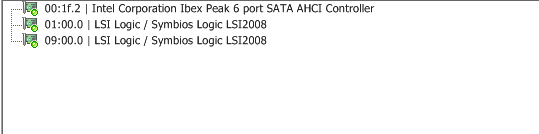

Auf dem Board steckt inzwischen LSI9211-8i und Supermicro AOC-USAS2-L8e für oi mit 12 HDs und Supermicro AOC-SG-I4 für Astaro. ESXi und oi liegt auf einem internen SATA Steckplatz mit 2x2,5 Zoll 160 GB HDs im Raidsonic SR2760-2S-S2B Case.

Bis jetzt hatte ich mit dem ganzen System keine größeren Probleme.

Ziemlich am Anfang ging eine 2,5 Zoll HD hinüber (machte nur noch klack-klack-klack) - also raus mit der defekten Platte Neue rein und das Raidsonic machte einen rebuild, der allerdings mehrere Stunden dauerte.

Für meine ZFS-pools habe ich eine 2 TB HD in Reserve in der Schublade liegen.

---------- Beitrag hinzugefügt um 19:36 ---------- Vorheriger Beitrag war um 18:47 ----------

lol -Danke !! Die Idee ist sehr gut! Leider hat das X9SCM-F kein PCI Slot, nur PCI-E. Aber hast mich auf eine gute Idee gebracht.

Ich werde mal diesen hier testen:

Digitus DS-30102 (hat einen SIL3132). Ist PCI-E x1 und sollte eigentlich gehen.

Kostet ca 25 Euro.

Das wusste ich schon, dass dir PCI fehlt, es ging mir darum ein Produkt zu zeigen, welches den Chipsatz SIL3512 verbaut hat.

Bitte berichte, ob der Digitus DS-30102 Controller von ESXi erkannt wird und wie er läuft.

.

.

) aber ob ich schon in so einer Liga spiele weiß ich noch nicht. Vielleicht gibt es ja was kleineres ... Aber auf jeden Fall habe ich schon mal eine Vorstellung. Merci.

) aber ob ich schon in so einer Liga spiele weiß ich noch nicht. Vielleicht gibt es ja was kleineres ... Aber auf jeden Fall habe ich schon mal eine Vorstellung. Merci.