Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

@laybreak: Danke für die Antworten. Wie nennt sich denn das Tool für die Verschlüsselung unter Solaris11?

Ist eine Option in ZFS.

Die Vergrößerung des Raidz ist nicht gerade zufriedenstellend. Einfache eine neue Platte dran, um das Raidz zu vergrößern wäre mir lieber gewesen

Ist doch Variante 2, die ich genannt hatte.

Geschichtsstunde:

Der Aufstieg von Illumos, Basis aller freien Solaris-artigen ZFS Betriebssysteme:

Fork Yeah! The Rise and Development of illumos

Der Aufstieg von Illumos, Basis aller freien Solaris-artigen ZFS Betriebssysteme:

Fork Yeah! The Rise and Development of illumos

MrDeluxe

Enthusiast

- Mitglied seit

- 01.04.2006

- Beiträge

- 1.474

- Laptop

- Thinkpad E480, E14, T14s

- Details zu meinem Desktop

- Prozessor

- AMD 3700x @ 4,3 Boost-Overdrive + Thermal Grizzly Aeronaut

- Mainboard

- Gigabyte Aorus Pro X570

- Kühler

- Scythe Fuma 2

- Speicher

- G.Skill - F4-3200C14D-16GFX

- Grafikprozessor

- 5700 XT

- Display

- 1xBenq G2411HD, 1xLG 27GL850-B, 1xBenq G2411HD @ Icy Box Monitor Arm IcyBox 3 – IB-MS405-T

- SSD

- WD Black SN750

- HDD

- Samsung 850Evo, Crucial 120GB @ Linux EOS

- Opt. Laufwerk

- N/A

- Soundkarte

- OnBoard

- Gehäuse

- Fractal Design Define R6 USB-C Blackout

- Netzteil

- be quiet straight power 650W

- Keyboard

- CMSTORM

- Mouse

- MX518

- Betriebssystem

- Win11 + Linux Elementary OS

- Sonstiges

- Mobile Phone - Mi 11 Lite 5G @ lineageOS nightly

- Internet

- ▼1000 ▲500

Ist eine Option in ZFS.

Ist doch Variante 2, die ich genannt hatte.

Es ist aber nicht möglich ein bestehendes Raidz zu vergrößern. Sondern man muss ein neues erstellen. So habe ich das zumindest gedeutet.

LuxxRookie

Enthusiast

Hallo liebe ZFS Fan´s, nach ein wenig mitlesen in diesem Thema, bin ich recht neugierig geworden und würde mich gerne näher mit dem Thema ZFS beschäftigen. Daher wollte ich mal hier fragen, ob jemand so nett wäre guten/informativen und aktuellen Lesestoff für mich zu posten.

Hab mir heute schon mal OpenIndiana runtergeladen und mir mal Desktop Variante in einer VM installiert um mir das System anzusehen.

Gruß LuxxRookie

ps: über ein wenig Lesestoff speziell zu OpenIndiana wäre auch nett

Hab mir heute schon mal OpenIndiana runtergeladen und mir mal Desktop Variante in einer VM installiert um mir das System anzusehen.

Gruß LuxxRookie

ps: über ein wenig Lesestoff speziell zu OpenIndiana wäre auch nett

Hallo liebe ZFS Fan´s, nach ein wenig mitlesen in diesem Thema, bin ich recht neugierig geworden und würde mich gerne näher mit dem Thema ZFS beschäftigen. Daher wollte ich mal hier fragen, ob jemand so nett wäre guten/informativen und aktuellen Lesestoff für mich zu posten.

Hab mir heute schon mal OpenIndiana runtergeladen und mir mal Desktop Variante in einer VM installiert um mir das System anzusehen.

Gruß LuxxRookie

ps: über ein wenig Lesestoff speziell zu OpenIndiana wäre auch nett

es gibt nicht soviel und leider kaum was auf deutsch, ansonsten

http://docs.oracle.com/cd/E26920_01/

OpenSolaris derived ZFS NAS/ SAN (Nexenta*, OpenIndiana, Solaris Express) - [H]ard|Forum

OpenSolaris Bible (Bible (Wiley)): Amazon.de: Nicholas A. Solter, Jerry Jelinek, David Miner: Englische Bücher

Zuletzt bearbeitet:

LuxxRookie

Enthusiast

es gibt nicht soviel und leider kaum was auf deutsch, ansonsten

Oracle Solaris 11 Information Library 11/11 Release

OpenSolaris derived ZFS NAS/ SAN (Nexenta*, OpenIndiana, Solaris Express) - [H]ard|Forum

OpenSolaris Bible (Bible (Wiley)): Amazon.de: Nicholas A. Solter, Jerry Jelinek, David Miner: Englische Bücher

Ich danke dir für die Links

schon mal was zum lesen, schade das es nicht viel auf deutsch gibt ^^

schon mal was zum lesen, schade das es nicht viel auf deutsch gibt ^^Edit: Habe bei oracle.com ein Handbuch zum Thema ZSF gefunden, ist das auch empfehlenswert oder eher nicht?

Oracle.com

Zuletzt bearbeitet:

Ich danke dir für die Linksschon mal was zum lesen, schade das es nicht viel auf deutsch gibt ^^

Edit: Habe bei oracle.com ein Handbuch zum Thema ZSF gefunden, ist das auch empfehlenswert oder eher nicht?

Oracle.com

Oracle wird nach und nach die gesamte Dokumentation zu Solaris 11

ins Deutsche übersetzen. Da die Information zu 95% auch für OpenIndiana

und Illumian passt, ist das die beste Quelle in Deutsch:

http://docs.oracle.com/cd/E26920_01/

Zuletzt bearbeitet:

LuxxRookie

Enthusiast

Oh ok, das ist erfreulich zu hören  ich danke dir

ich danke dir

dann werde ich mal anfangen zu lesen

ich danke dir

ich danke dir dann werde ich mal anfangen zu lesen

millenniumpilot

Enthusiast

Hallo Ihr,

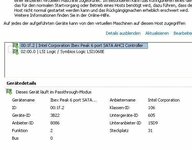

der Delock 70154 (PCI-Controller mit 4 SATA-Ports und einem SIL3114) funktioniert mit dem ESXi 5 . Habe dann testweise den internen Controller des Boards mit einer 80er Platte an den OI durchgereicht, alles ohne Probleme.

Millenniumpilot

der Delock 70154 (PCI-Controller mit 4 SATA-Ports und einem SIL3114) funktioniert mit dem ESXi 5 . Habe dann testweise den internen Controller des Boards mit einer 80er Platte an den OI durchgereicht, alles ohne Probleme.

Millenniumpilot

Anhänge

millenniumpilot

Enthusiast

Hallo Ihr, Hallo Gea,

ich hätte da eine Frage zum Absichern des NFS-Shares für die VMs des ESX. Ich möchte, das nur die IP des ESX auf das Share zugreifen kann.

Irgendwie habe ich da wohl etwas falsch gemacht. Beim Aktivieren von NFS auf dem ZFS-Pool kann man wohl laut eingeblendeten Hilfetext des Nappit anstatt ON auch weitere Parameter angeben. Ich habe mich an die Hilfe gehalten und folgende Parameter angeben rw=@192.168.0.9/24,root=@192.168.0.9/24 storage/vmware

bei der anschließenden Abfrage der ZFS Details erhalte ich folgenden String:

storage/vmware sharenfs rw=@192.168.0.9/24,root=@192.168.0.9/24storage/vmware

Man beachte das fehlende Leerzeichen nach der Netmaske vor "storage/vmware", ob es relevant ist weis ich aber nicht.

Ich habe mich leider in der IP vertan, dies ist nicht die IP des ESX-Host. Trotzdem kann ich ohne Probleme virtuelle Maschienen auf dem NFS-Share anlegen. Der Schutz greift also nicht. Ohne den Fehler mit der falschen IP hätte ich dies wahrscheinlich nicht einmal bemerkt.

Kann mir bitte einer einen Tip geben, an welcher Stelle ich die entspr. Parameter eingeben muss, damit sie auch greifen?

ich hätte da eine Frage zum Absichern des NFS-Shares für die VMs des ESX. Ich möchte, das nur die IP des ESX auf das Share zugreifen kann.

Irgendwie habe ich da wohl etwas falsch gemacht. Beim Aktivieren von NFS auf dem ZFS-Pool kann man wohl laut eingeblendeten Hilfetext des Nappit anstatt ON auch weitere Parameter angeben. Ich habe mich an die Hilfe gehalten und folgende Parameter angeben rw=@192.168.0.9/24,root=@192.168.0.9/24 storage/vmware

bei der anschließenden Abfrage der ZFS Details erhalte ich folgenden String:

storage/vmware sharenfs rw=@192.168.0.9/24,root=@192.168.0.9/24storage/vmware

Man beachte das fehlende Leerzeichen nach der Netmaske vor "storage/vmware", ob es relevant ist weis ich aber nicht.

Ich habe mich leider in der IP vertan, dies ist nicht die IP des ESX-Host. Trotzdem kann ich ohne Probleme virtuelle Maschienen auf dem NFS-Share anlegen. Der Schutz greift also nicht. Ohne den Fehler mit der falschen IP hätte ich dies wahrscheinlich nicht einmal bemerkt.

Kann mir bitte einer einen Tip geben, an welcher Stelle ich die entspr. Parameter eingeben muss, damit sie auch greifen?

Anhänge

Hallo Ihr, Hallo Gea,

ich hätte da eine Frage zum Absichern des NFS-Shares für die VMs des ESX. Ich möchte, das nur die IP des ESX auf das Share zugreifen kann.

Irgendwie habe ich da wohl etwas falsch gemacht. Beim Aktivieren von NFS auf dem ZFS-Pool kann man wohl laut eingeblendeten Hilfetext des Nappit anstatt ON auch weitere Parameter angeben. Ich habe mich an die Hilfe gehalten und folgende Parameter angeben rw=@192.168.0.9/24,root=@192.168.0.9/24 storage/vmware

bei der anschließenden Abfrage der ZFS Details erhalte ich folgenden String:

storage/vmware sharenfs rw=@192.168.0.9/24,root=@192.168.0.9/24storage/vmware

Man beachte das fehlende Leerzeichen nach der Netmaske vor "storage/vmware", ob es relevant ist weis ich aber nicht.

Ich habe mich leider in der IP vertan, dies ist nicht die IP des ESX-Host. Trotzdem kann ich ohne Probleme virtuelle Maschienen auf dem NFS-Share anlegen. Der Schutz greift also nicht. Ohne den Fehler mit der falschen IP hätte ich dies wahrscheinlich nicht einmal bemerkt.

Kann mir bitte einer einen Tip geben, an welcher Stelle ich die entspr. Parameter eingeben muss, damit sie auch greifen?

das fehlende Leerzeichen ist ein bug.

Wie sieht es aber mit den Rechten aus? Stehen die permissions von storage/vmware auf

root only? Die share Einstellungen bedeuten ja nur, dass dieser Rechner als Root agiert.

Das bdeutet nicht dass jemand anderes nicht darf, wenn er genügend Rechte hat (z.B. als everyone)

millenniumpilot

Enthusiast

Hallo Gea,

die Folder-ACLs stehen auf root-only, Permissions auf 700+.

Kenne mich mit NFS nicht aus, bin halt die letzten Jahre stark windowslastig geworden.

Ich hatte gehofft/vermutet, daß nur die angegebene IP eine Verbindung zum NFS-Share aufbauen darf. Da diese aber die falsche ist, hätte es nicht funktionieren dürfen.

Ich vermute, ich habe da wohl einen Denkfehler und werde mich weiter belesen müssen, wie man ein NFS-Share absichert. Mir fällt auch gerade ein, da der ESX-root das gleiche Passwort verwendet wie der OI-root. Vielleicht geht´s ja deswegen.

Edit: habe beim Studium der ZFS-Dokumente gesehen, das der Syntax für meine Zwecke eh ungeeignet war, will nur eine IP zulassen. Daher lautet der korrekte Syntax wohl rw=192.168.0.7,root=192.168.0.7 storage/vmware

Leider komme ich damit nun nicht mehr mit dem ESX auf das NFS rauf, obwohl der ESX die IP 192.168.0.7 besitzt. Habe die Experimente daher ersteinmal angebrochen und den setnfs-String nun auf rw=@192.168.0.0/24,root=@192.168.0.0/24 storage/vmware gesetzt. Damit kommt schon mal nicht jeder, sondern nur ein root auf das NFS-Share rauf.

Gruß Millenniumpilot

die Folder-ACLs stehen auf root-only, Permissions auf 700+.

Kenne mich mit NFS nicht aus, bin halt die letzten Jahre stark windowslastig geworden.

Ich hatte gehofft/vermutet, daß nur die angegebene IP eine Verbindung zum NFS-Share aufbauen darf. Da diese aber die falsche ist, hätte es nicht funktionieren dürfen.

Ich vermute, ich habe da wohl einen Denkfehler und werde mich weiter belesen müssen, wie man ein NFS-Share absichert. Mir fällt auch gerade ein, da der ESX-root das gleiche Passwort verwendet wie der OI-root. Vielleicht geht´s ja deswegen.

Edit: habe beim Studium der ZFS-Dokumente gesehen, das der Syntax für meine Zwecke eh ungeeignet war, will nur eine IP zulassen. Daher lautet der korrekte Syntax wohl rw=192.168.0.7,root=192.168.0.7 storage/vmware

Leider komme ich damit nun nicht mehr mit dem ESX auf das NFS rauf, obwohl der ESX die IP 192.168.0.7 besitzt. Habe die Experimente daher ersteinmal angebrochen und den setnfs-String nun auf rw=@192.168.0.0/24,root=@192.168.0.0/24 storage/vmware gesetzt. Damit kommt schon mal nicht jeder, sondern nur ein root auf das NFS-Share rauf.

Gruß Millenniumpilot

Zuletzt bearbeitet:

millenniumpilot

Enthusiast

Hallo Ihr, hallo Wirrkopf

Ich hatte gestern bei stundenlangen Kopieraktionen von 5TB Daten vom Windowsserver auf das ZFS auch einen Verbindungsabbruch gemeldet bekommen. Die Verbindung stand aber noch bzw. wieder. Nach Wegdrücken der Fehlermeldung konnte ich weiter arbeiten. ALso wohl der gleiche Effekt wie von Wirrkopf beschrieben. Konnte der Fehler schon eingegrenzt werden?

Aktuell arbeite ich noch mit 2vCPU und der VMXNet3-NIC.

Leicht enttäuscht bin ich etwas von der internen Datenübertragungsrate zw. den VM und dem OI. Trotz VMXNet3, aktivierten VMCI und Scrub-Raten von 580MB/s bekommen ich nur SMB-Übertragungsraten von 75..80MB/s zw. OI und den VMs beim kopieren von großen Dateien (> 4..8GB). Da erhalte ich sogar zwischen physischen Maschinen und dem OI bessere Werte. Komisch

Gruß Millenniumpilot

Ich bin jetzt fast am Ende meine Lateins. Auch Versuche mit dem ESXi 5 ergeben immer noch alle 1-2 Tage einen Verbindungsabbbruch des virtuellen NFS/SMB Servers. Bis auf das Bios Update habe ich alle möglichen Fehlerquellen ausgeschaltet (nur 1vCPU, e1000 NIC, OI151A, ESXi5 ohne jede Modifikation)

Ich hatte gestern bei stundenlangen Kopieraktionen von 5TB Daten vom Windowsserver auf das ZFS auch einen Verbindungsabbruch gemeldet bekommen. Die Verbindung stand aber noch bzw. wieder. Nach Wegdrücken der Fehlermeldung konnte ich weiter arbeiten. ALso wohl der gleiche Effekt wie von Wirrkopf beschrieben. Konnte der Fehler schon eingegrenzt werden?

Aktuell arbeite ich noch mit 2vCPU und der VMXNet3-NIC.

Leicht enttäuscht bin ich etwas von der internen Datenübertragungsrate zw. den VM und dem OI. Trotz VMXNet3, aktivierten VMCI und Scrub-Raten von 580MB/s bekommen ich nur SMB-Übertragungsraten von 75..80MB/s zw. OI und den VMs beim kopieren von großen Dateien (> 4..8GB). Da erhalte ich sogar zwischen physischen Maschinen und dem OI bessere Werte. Komisch

Gruß Millenniumpilot

Mal ne Frage von nem ZFS Anfänger (Achtung Freenas GUI Benutzer  ):

):

Ich hab mir ein Dataset mit 100 GB eingerichtet. Nun wollte ich das größer machen und hab einfach das Quota des Datasets auf 500 GB gesetzt. Freenas zeigt mir das auch an und meine Freigabe (afp) zeigt ebenfalls 500 GB als große an. Doch leider will Timemachine das nicht verstehen. TM kann das Backup nicht machen da es denkt da wäre zu wenig Platz?

Weitere Frage:

Hab ich was falsch gemacht oder muss ich vielleicht erstmal etwas warten bis Freenas dem Dataset die 500 GB tatsächlich zur Verfügung stellt?

€:

Das liegt doch tatsächlich an Timemachine. Irgendwie schreibt TM in das Backup wie groß das Volume ist auf das es schreibt.

Kann mir wer ein Shell Tutorial für ZFS empfehlen? Ich will die GUI irgendwann mal loswerden :P

Noch ne Frage (da kommen bestimmt noch ein paar):

Ich habe mir den intel SASUC8I HBA geleistet. Muss ich den unbedingt auf IT Firmware flashen oder kann der auch so bleiben wie er ist (denn er funktioniert ja imo. ganz gut trotz intel FW)?

):

): Ich hab mir ein Dataset mit 100 GB eingerichtet. Nun wollte ich das größer machen und hab einfach das Quota des Datasets auf 500 GB gesetzt. Freenas zeigt mir das auch an und meine Freigabe (afp) zeigt ebenfalls 500 GB als große an. Doch leider will Timemachine das nicht verstehen. TM kann das Backup nicht machen da es denkt da wäre zu wenig Platz?

Weitere Frage:

Hab ich was falsch gemacht oder muss ich vielleicht erstmal etwas warten bis Freenas dem Dataset die 500 GB tatsächlich zur Verfügung stellt?

€:

Das liegt doch tatsächlich an Timemachine. Irgendwie schreibt TM in das Backup wie groß das Volume ist auf das es schreibt.

Kann mir wer ein Shell Tutorial für ZFS empfehlen? Ich will die GUI irgendwann mal loswerden :P

Noch ne Frage (da kommen bestimmt noch ein paar):

Ich habe mir den intel SASUC8I HBA geleistet. Muss ich den unbedingt auf IT Firmware flashen oder kann der auch so bleiben wie er ist (denn er funktioniert ja imo. ganz gut trotz intel FW)?

Zuletzt bearbeitet:

millenniumpilot

Enthusiast

Hallo Ihr,

ich habe heute mal die Infos von layerbreak in meine eigene power.conf eingearbeitet. Was ich noch nicht getestet habe ist, ob es nicht doch ausreicht, als Platte die einfache Bezeichnung /dev/dsk/c1t0d0s0 zu verwenden.

Bei meinem X8SIL-F mit Xeon, 32GB ECC-RAM, SASUC8I und 8x Hitachi 7k3000 2TB sinkt die Stromaufnahme im Idle von 86W auf 42W. Man darf nur keine VMs wie einen Mailserver o.ä. auf dem Pool laufen haben

Die Halbierung der Stromaufnahme lässt mich darüber nachdenken, auch den Mailserver auf dem lokalen Datatore des ESXi laufen zu lassen oder einen extra Pool aus 2 kleinen Platten für die VMs zu generieren. 8 Platten für 12..15h am Tag schlafen zu legen hat schon etwas....

Die Verzögerung beim Zugriff auf die Shares ist zwar groß, kommt wahrscheinlich auch nur 1..2 mal am Tag vor. Mir fällt dabei auf, das die 8 Platten ein ordendliches staggered Spin-up durchführen, leider klappt dies wegen fehlender Backplanes noch nicht beim EInschalten des Servers.

Gruß Millenniumpilot

HBA als IT flashen.

Code:autopm enable autoS3 default cpu-threshold 1s S3-support enable # Auto-Shutdown Idle(min) Start/Finish(hh:mm) Behavior autoshutdown 30 9:00 9:00 noshutdown cpupm enable system-threshold always-on device-thresholds /pci@0,0/pci15ad,1976@10/sd@0,0 always-on device-thresholds /scsi_vhci/disk@g5000cca374f780fb always-on device-thresholds /scsi_vhci/disk@g5000cca374f7791e always-on device-thresholds /scsi_vhci/disk@g50024e9003ce031b 10m device-thresholds /scsi_vhci/disk@g50024e9003ce0317 10m device-thresholds /scsi_vhci/disk@g50024e9003ce0368 10m

ich habe heute mal die Infos von layerbreak in meine eigene power.conf eingearbeitet. Was ich noch nicht getestet habe ist, ob es nicht doch ausreicht, als Platte die einfache Bezeichnung /dev/dsk/c1t0d0s0 zu verwenden.

Bei meinem X8SIL-F mit Xeon, 32GB ECC-RAM, SASUC8I und 8x Hitachi 7k3000 2TB sinkt die Stromaufnahme im Idle von 86W auf 42W. Man darf nur keine VMs wie einen Mailserver o.ä. auf dem Pool laufen haben

Die Halbierung der Stromaufnahme lässt mich darüber nachdenken, auch den Mailserver auf dem lokalen Datatore des ESXi laufen zu lassen oder einen extra Pool aus 2 kleinen Platten für die VMs zu generieren. 8 Platten für 12..15h am Tag schlafen zu legen hat schon etwas....

Die Verzögerung beim Zugriff auf die Shares ist zwar groß, kommt wahrscheinlich auch nur 1..2 mal am Tag vor. Mir fällt dabei auf, das die 8 Platten ein ordendliches staggered Spin-up durchführen, leider klappt dies wegen fehlender Backplanes noch nicht beim EInschalten des Servers.

Gruß Millenniumpilot

Aurel

Enthusiast

Leider kann ich in dem Thread nicht nach 4k suchen

deshalb bin ich wohl gezwungen, meine Frage direkt zu stellen *g*

Ich wollte mir eine KOmbination aus NAS und HTPC zusammenstellen Lautstärke ist ja heutzutage nicht mehr wirklich ein Problem (aus meiner Sicht)

Realisieren wollte ich dies mit Ubuntu + ZFS + XBMC

allerdings finde ich immer wieder Hinweise auf das Problem mit den neuen 4k-HDDs und ZFS. im Original BSD/Solaris scheint es über ein Befehl lösbar zu sein, allerdings finde ich nichts vergleichbares für Linux.

Hat da jemand mehr informationen?

Wäre wirklich super. Vielen Dank !

deshalb bin ich wohl gezwungen, meine Frage direkt zu stellen *g*

Ich wollte mir eine KOmbination aus NAS und HTPC zusammenstellen Lautstärke ist ja heutzutage nicht mehr wirklich ein Problem (aus meiner Sicht)

Realisieren wollte ich dies mit Ubuntu + ZFS + XBMC

allerdings finde ich immer wieder Hinweise auf das Problem mit den neuen 4k-HDDs und ZFS. im Original BSD/Solaris scheint es über ein Befehl lösbar zu sein, allerdings finde ich nichts vergleichbares für Linux.

Hat da jemand mehr informationen?

Wäre wirklich super. Vielen Dank !

allerdings finde ich immer wieder Hinweise auf das Problem mit den neuen 4k-HDDs und ZFS. im Original BSD/Solaris scheint es über ein Befehl lösbar zu sein, allerdings finde ich nichts vergleichbares für Linux.

Es gibt eigentlich kein Problem ausser dass ein Pool aus diesen Platten (sofern Sie vorgeben 512 Byte Typen zu sein) ca 10-20% langsamer ist als er es sein könnte. Man könnte zwar einen Pool unter Solaris oder FreeBSD mit ashift=12 anlegen und importieren - würde ich aber nicht machen. Das ist schon unter Solaris/ FreeBSD experimentell und würde ich da auch nicht machen.

Am Besten, noch keine 4k Platten kaufen (es gibt von Hitachi und Seagate Alternativen) oder damit leben.

Hallo Leute,

mein all-in-one läuft soweit soweit sehr stabil und ich bin sehr zufrieden.

Jedoch habe ich noch ein Problem:

Leider kann ich meine VM's nicht sichern...

Situation:

ESXI 5

OI 151a + napp-it VM (2x VMNETX3 NIC)

Windows SBS 2011 VM (1 x VMNETX3 NIC)

Fehler:

Wenn ich versuche die VM's zu sichern (zb. über ein anderes NFS-System) kommt es währen des Kopiervorganges zu Abbrüchen. Da dies wohl kein Einzelfall ist würde ich gerne wissen ob es noch andere Möglichkeiten zum Sichern gibt.

Da beide VM's auch direkten Zugriff auf Hardware haben kann ich auch kein Snapshot machen.

Gruß und ein frohes Fest Euch allen

mein all-in-one läuft soweit soweit sehr stabil und ich bin sehr zufrieden.

Jedoch habe ich noch ein Problem:

Leider kann ich meine VM's nicht sichern...

Situation:

ESXI 5

OI 151a + napp-it VM (2x VMNETX3 NIC)

Windows SBS 2011 VM (1 x VMNETX3 NIC)

Fehler:

Wenn ich versuche die VM's zu sichern (zb. über ein anderes NFS-System) kommt es währen des Kopiervorganges zu Abbrüchen. Da dies wohl kein Einzelfall ist würde ich gerne wissen ob es noch andere Möglichkeiten zum Sichern gibt.

Da beide VM's auch direkten Zugriff auf Hardware haben kann ich auch kein Snapshot machen.

Gruß und ein frohes Fest Euch allen

Hallo Leute,

mein all-in-one läuft soweit soweit sehr stabil und ich bin sehr zufrieden.

Jedoch habe ich noch ein Problem:

Leider kann ich meine VM's nicht sichern...

Situation:

ESXI 5

OI 151a + napp-it VM (2x VMNETX3 NIC)

Windows SBS 2011 VM (1 x VMNETX3 NIC)

Fehler:

Wenn ich versuche die VM's zu sichern (zb. über ein anderes NFS-System) kommt es währen des Kopiervorganges zu Abbrüchen. Da dies wohl kein Einzelfall ist würde ich gerne wissen ob es noch andere Möglichkeiten zum Sichern gibt.

Da beide VM's auch direkten Zugriff auf Hardware haben kann ich auch kein Snapshot machen.

Gruß und ein frohes Fest Euch allen

Die OpenIndiana VM läßt sich per ESXi snapshot nur sichern, wenn diese ausgeschaltet ist. Ist aber kein Problem. Da ist nichts wichtiges drauf und man kann zudem OI ZFS System-snapshots machen

Für die Windows VM gilt gleiches, falls die auch mit pass-through arbeitet.

Ich sehe dafür aber keinen wirklichen Grund. Ansonsen sollte man damit ohne Probleme ESXi hot-Snaps machen können.

Ansonsten macht man snaps des SAN storages per ZFS snapshots. Falls z.B. wegen einer laufenden Datenbankanwendung hot-snaps benötigt werden (also inkl. Arbeitsspeicher) zuvor einen ESXi hot-snap machen, dann einen ZFS snap, um anschließend den ESXi snap wieder zu löschen.

Sichern per NFS oder einfacher SMB geht natürlich nicht, solange die VM's laufen und damit Dateien offen sind. Also entweder VM's herunterfahren oder ein ZFS snapshot basiertes Verfahren mit zfs send benutzen. Alternativ per Windows - vorherige Version einen ZFS snapshot wegsichern.

Zuletzt bearbeitet:

Hi gea,

danke für die schnelle Antwort!!

Die Windows VM hat ein USB device als passthrou daher geht der Snapshot so nicht. Habe dann doch noch gelernt, dass man bei ausgeschalteter VM in ESXI ein snpashot erstellen kann. Soweit so gut.

Z. ZT habe ich 4 x mirrod vdev am laufen - da ich die Geschwindigkeit über mein Netzt nicht wirklich nutzen kann, wollte ich das Pool in ein Raidz + 1 x Spare umwandeln. Die OI VM macht mir dabei keine Sorgen da diese auf der der Boot HD installiert ist. Aber die Windows VM würde ich gerne auf ein externes Medium (zb. per NFS auf Windows Home Server) übertragen und da kommt es, trotz ausgeschalteter VM, zu den Abbrüchen. Sieht aus als ob es an der Zugriffsberechtigung liegt . KA was man da wo einstellen muss...

. KA was man da wo einstellen muss...

OK. never mind, wenn ich aus dem (ESXI) Datenspeicherbrowser runter lade scheint es zu klappen ... (Kopiervorgang läuft gerade).

Gruß

danke für die schnelle Antwort!!

Die Windows VM hat ein USB device als passthrou daher geht der Snapshot so nicht. Habe dann doch noch gelernt, dass man bei ausgeschalteter VM in ESXI ein snpashot erstellen kann. Soweit so gut.

Z. ZT habe ich 4 x mirrod vdev am laufen - da ich die Geschwindigkeit über mein Netzt nicht wirklich nutzen kann, wollte ich das Pool in ein Raidz + 1 x Spare umwandeln. Die OI VM macht mir dabei keine Sorgen da diese auf der der Boot HD installiert ist. Aber die Windows VM würde ich gerne auf ein externes Medium (zb. per NFS auf Windows Home Server) übertragen und da kommt es, trotz ausgeschalteter VM, zu den Abbrüchen. Sieht aus als ob es an der Zugriffsberechtigung liegt

. KA was man da wo einstellen muss...

. KA was man da wo einstellen muss...OK. never mind, wenn ich aus dem (ESXI) Datenspeicherbrowser runter lade scheint es zu klappen ... (Kopiervorgang läuft gerade).

Gruß

NFS kopoeren... Sieht aus als ob es an der Zugriffsberechtigung liegt. KA was man da wo einstellen muss...

OK. never mind, wenn ich aus dem (ESXI) Datenspeicherbrowser runter lade scheint es zu klappen ... (Kopiervorgang läuft gerade).

Gruß

Beim NFS sharen entweder der ESXi-ip root-Rechte geben oder alle Dateien rekursive auf 777 (bzw. ACL everyone@=full bzw modify) setzen.

Oder die Dateien per SMB kopieren (am Einfachsten und man hat Zugriff auf die Snaps mit 'vorherige Version'). Auch da alle Dateien auf ACL Everyone@=full oder modify setzen, z.B. per napp-it ACL extension oder als root von einigen Windows Versionen.

Die Variante mit dem ESXi Browser geht auch, ist aber mit Abstand am Langsamsten.

Hi gea,

danke für die Antwort,

an diesen rechten verzweifel ich gerade

Bekomme ständig die Meldung kine Berchtigung für Anonymous...

Habe per ACL volle rechte für Everyone eingestellt. Auf der Windows 7 Machine Gast Konto aktiviert. Eine Gruppe "Jeder" gibt es ja nicht...

Gast der HomeUser Gruppe zugeordnet. Per

"idmap add -d 'wingroup:HomUser' 'unixgroup:staff" HomeUser=staff group gesetzt.

Scheiter ständig an dieser Anonymous Meldung

Irgendwas mache ich da falsch ...

danke für die Antwort,

an diesen rechten verzweifel ich gerade

Bekomme ständig die Meldung kine Berchtigung für Anonymous...

Habe per ACL volle rechte für Everyone eingestellt. Auf der Windows 7 Machine Gast Konto aktiviert. Eine Gruppe "Jeder" gibt es ja nicht...

Gast der HomeUser Gruppe zugeordnet. Per

"idmap add -d 'wingroup:HomUser' 'unixgroup:staff" HomeUser=staff group gesetzt.

Scheiter ständig an dieser Anonymous Meldung

Irgendwas mache ich da falsch ...

Hi gea,

danke für die Antwort,

an diesen rechten verzweifel ich gerade

Bekomme ständig die Meldung kine Berchtigung für Anonymous...

Habe per ACL volle rechte für Everyone eingestellt. Auf der Windows 7 Machine Gast Konto aktiviert. Eine Gruppe "Jeder" gibt es ja nicht...

Gast der HomeUser Gruppe zugeordnet. Per

"idmap add -d 'wingroup:HomUser' 'unixgroup:staff" HomeUser=staff group gesetzt.

Scheiter ständig an dieser Anonymous Meldung

Irgendwas mache ich da falsch ...

SMB funktioniert folgendermaßen:

- Anmeldung erfolgt mit einem Solaris User/pw

Irgendwelche Einstellungen an der Win7 Maschine sind unerheblich

-idmapping stellt eine Beziehung einer Domänen-User-SID zu einer Solaris User-ID her

keine Domäne: kein mapping, alle mappings löschen, Anmeldung erfolgt als Unix-User

(Grund: Ein Unix-Dateisystem kann ja keine SID speichern so wie ntfs. Daher beziehen sich

die permissions und die ACL immer auf unix id's. Das mapping übersetzt beide, falls die

Anmeldung als Windows-Domänen-user erfolgt)

- ACL everyone@ (oder Solarisuser xyz) auf full setzen mit Vererbung=ein

Dann erhalten alle neu angelegten Ordner/Dateien diese Rechte

Für bereits angelegte Dateien eventuell Rechte rekursiv neu setzen

-Guest-access auf dem SMB share deaktivieren falls Rechte gewünscht

- SMB (Solaris Kernel Server) ist ACL only

unix-permissions sind nicht relevant. ACL mit napp-it acl-extension setzen

Die ACL Basisrechte everyone@, group@ und owner@ sind dazu da, die unix-permissions

als ACL darzustellen

Im Gegensatz zu NFS V3

Da gibt es keine user-Anmeldung. Zugriff erfolgt entweder über permission 777 (jeder darf)

oder eingeschränkt über die ip des zugreifenden Rechners

Zuletzt bearbeitet:

millenniumpilot

Enthusiast

Hallo Ihr,

als Solaris- und ZFS-Neuling habe ich eine Frage zum Monitoring.

Will jetzt zwecks Backup einen zweiten, diesmal nativen, Openindiana mit ZFS aufsetzen.

Dazu soll ein Board eingesetzt werden (Asus P5Q), welches bei Vollbestückung mit 4x2GB RAM aus der QVL-Liste mir unter Windows2003 die Daten wiederholt zerhackt hat.

Dass äußerste sich so, das die Daten äusserlich korrekt auf den Fileserver geschrieben und auch wieder gelesen wurden, Zip-Archive aber häufig plötzlich CRC-Fehler aufwiesen, Filme Störungen hatten und Setupprogramme plötzlich mit Fehlermeldungen abbrachen. Nach Reduzierung auf 4GB Hauptspeicher traten keine korrupten Dateien mehr auf. Also genau ein Szenario, welches ZFS feststellen und verhindern kann.

Wie bemerke ich solche Probleme unter Openindiana, wo wird soetwas geloggt?

Wo muss ich nachschauen?

Gruß Millenniumpilot

als Solaris- und ZFS-Neuling habe ich eine Frage zum Monitoring.

Will jetzt zwecks Backup einen zweiten, diesmal nativen, Openindiana mit ZFS aufsetzen.

Dazu soll ein Board eingesetzt werden (Asus P5Q), welches bei Vollbestückung mit 4x2GB RAM aus der QVL-Liste mir unter Windows2003 die Daten wiederholt zerhackt hat.

Dass äußerste sich so, das die Daten äusserlich korrekt auf den Fileserver geschrieben und auch wieder gelesen wurden, Zip-Archive aber häufig plötzlich CRC-Fehler aufwiesen, Filme Störungen hatten und Setupprogramme plötzlich mit Fehlermeldungen abbrachen. Nach Reduzierung auf 4GB Hauptspeicher traten keine korrupten Dateien mehr auf. Also genau ein Szenario, welches ZFS feststellen und verhindern kann.

Wie bemerke ich solche Probleme unter Openindiana, wo wird soetwas geloggt?

Wo muss ich nachschauen?

Gruß Millenniumpilot

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Hallo Ihr,

als Solaris- und ZFS-Neuling habe ich eine Frage zum Monitoring.

Will jetzt zwecks Backup einen zweiten, diesmal nativen, Openindiana mit ZFS aufsetzen.

Dazu soll ein Board eingesetzt werden (Asus P5Q), welches bei Vollbestückung mit 4x2GB RAM aus der QVL-Liste mir unter Windows2003 die Daten wiederholt zerhackt hat.

Dass äußerste sich so, das die Daten äusserlich korrekt auf den Fileserver geschrieben und auch wieder gelesen wurden, Zip-Archive aber häufig plötzlich CRC-Fehler aufwiesen, Filme Störungen hatten und Setupprogramme plötzlich mit Fehlermeldungen abbrachen. Nach Reduzierung auf 4GB Hauptspeicher traten keine korrupten Dateien mehr auf. Also genau ein Szenario, welches ZFS feststellen und verhindern kann.

Wie bemerke ich solche Probleme unter Openindiana, wo wird soetwas geloggt?

Wo muss ich nachschauen?

Gruß Millenniumpilot

Moin,

das hört sich aber mehr nach defektem RAM an und da kann auch oi oder ZFS dich nicht schützen. Die Daten werden ja schon vorher korrumpiert bevor sie auf Platte kommen.

Deshalb immer nur ECC.

barnacle2k

Enthusiast

Wenn die CPU oder der RAM fehler Produzieren kann ZFS Datenfehler möglicherweise

nicht verhindern/erkennen. bzw Fehler melden wo keine sind.

Deshalb ECC Ram und vernünftig stabile CPU.

Teste den Computer über nacht mit memtest x86.

nicht verhindern/erkennen. bzw Fehler melden wo keine sind.

Deshalb ECC Ram und vernünftig stabile CPU.

Teste den Computer über nacht mit memtest x86.

Moin,

das hört sich aber mehr nach defektem RAM an und da kann auch oi oder ZFS dich nicht schützen. Die Daten werden ja schon vorher korrumpiert bevor sie auf Platte kommen.

Deshalb immer nur ECC.

Genau in dem Fall ist doch ZFS nützlicher bzw. ein Vorteil, da es beim Schreiben auch die Checksummen prüft und sicherstellt, dass die Datei nicht "am Weg zur Platte" Fehler bekommt ... und auf jeden Fall fehlerfrei auf den Pool/Festplatte geschrieben wird/wurde.

Oder täusche ich mich da ?!

layerbreak

Enthusiast

- Mitglied seit

- 30.12.2010

- Beiträge

- 590

Genau in dem Fall ist doch ZFS nützlicher bzw. ein Vorteil, da es beim Schreiben auch die Checksummen prüft und sicherstellt, dass die Datei nicht "am Weg zur Platte" Fehler bekommt ... und auf jeden Fall fehlerfrei auf den Pool/Festplatte geschrieben wird/wurde.

Oder täusche ich mich da ?!

Jain,

der Fehler kommt doch schon vorher, wenn die Daten durch einen defekten RAM "verbogen" werden. Die Checksumme von ZFS ist aber korrekt - bezogen auf die falsch angelieferten Daten. ZFS bekommt doch nie die korrekten Daten zu Gesicht.

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 1K

[Kaufberatung]

Neuer ZFS Homeserver

- Antworten

- 20

- Aufrufe

- 2K

- Antworten

- 16

- Aufrufe

- 859

- Antworten

- 3

- Aufrufe

- 736