Werbung

[h3]Schnellerer GDDR5X[/h3]

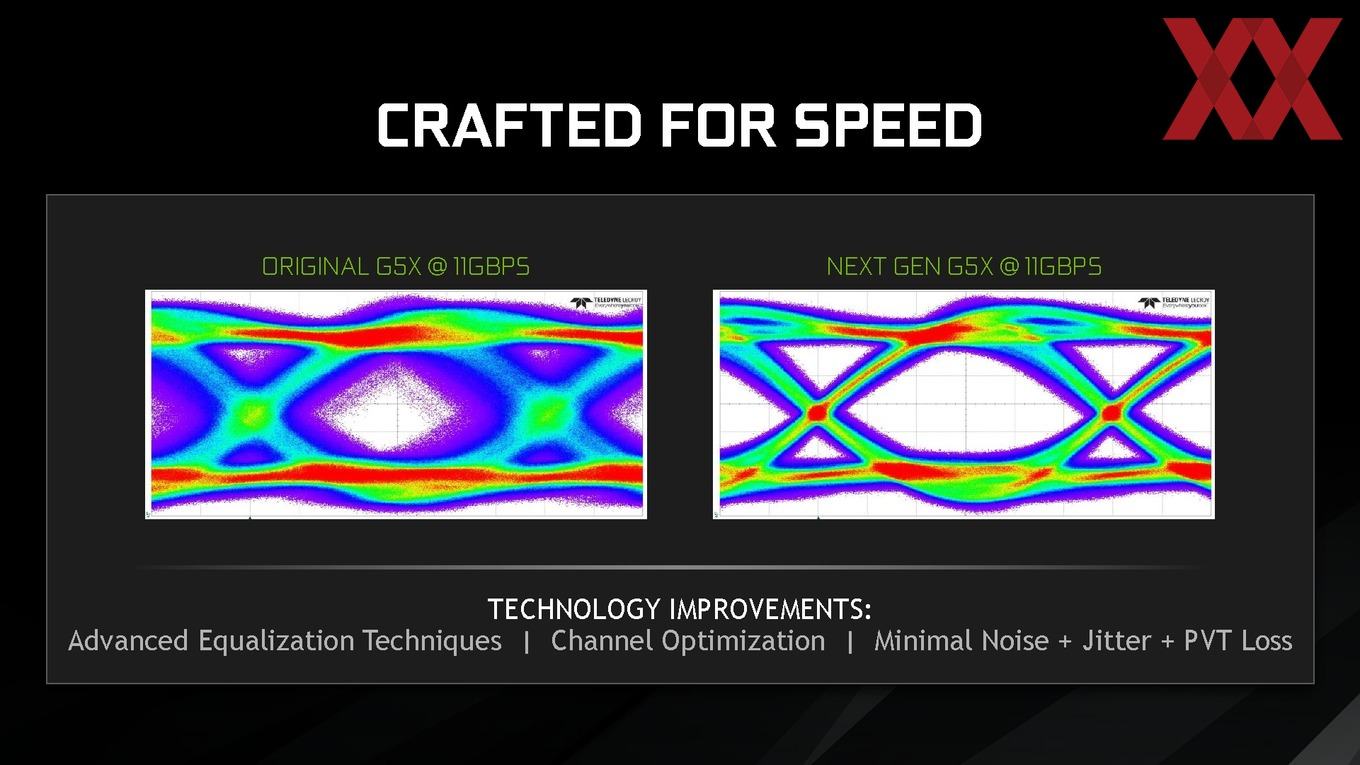

Große Änderungen gibt es beim Speicher. Zwar setzt NVIDIA wieder auf GDDR5X und nicht auf HBM der 2. Generation, im Vergleich zum GDDR5X-Speicher der GeForce GTX 1080 und Titan X hat NVIDIA zusammen mit Micron aber die Bandbreite deutlich steigern können. Dies gelingt durch verschiedene Optimierungen in der Signalübertragung.

NVIDIA zeigte dazu zwei Bilder, welche die Signalintegrität aufzeigen. Das Auge in der Mitte sollte möglichst klar und deutlich sein. Ist es das nicht, kommt es zu fehlerhaften Übertragungen. Zu den Optimierungen gehört unter anderem, dass man Signale verwendet, die sich überlagern und derart ausgleichen, das ein klareres Signal dabei herauskommt. Damit ist es NVIDIA und Micron möglich, den Takt des Speichers von 1.250 auf 1.375 MHz zu erhöhen.

[h3]Tiled Caching[/h3]

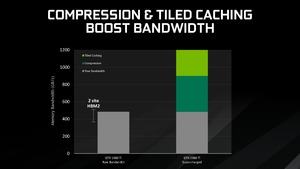

Bereits in den vorangegangenen Generationen legte NVIDIA großen Wert auf eine möglichst gute Speicherkomprimierung, denn die Speicherbandbreite ist ein entscheidender Faktor für die Leistung einer GPU. Da neue Speichertechnologien langwierig und teuer sind, versuchen AMD und NVIDIA über eine möglichst gute Komprimierung hier etwas Potenzial einzusparen.

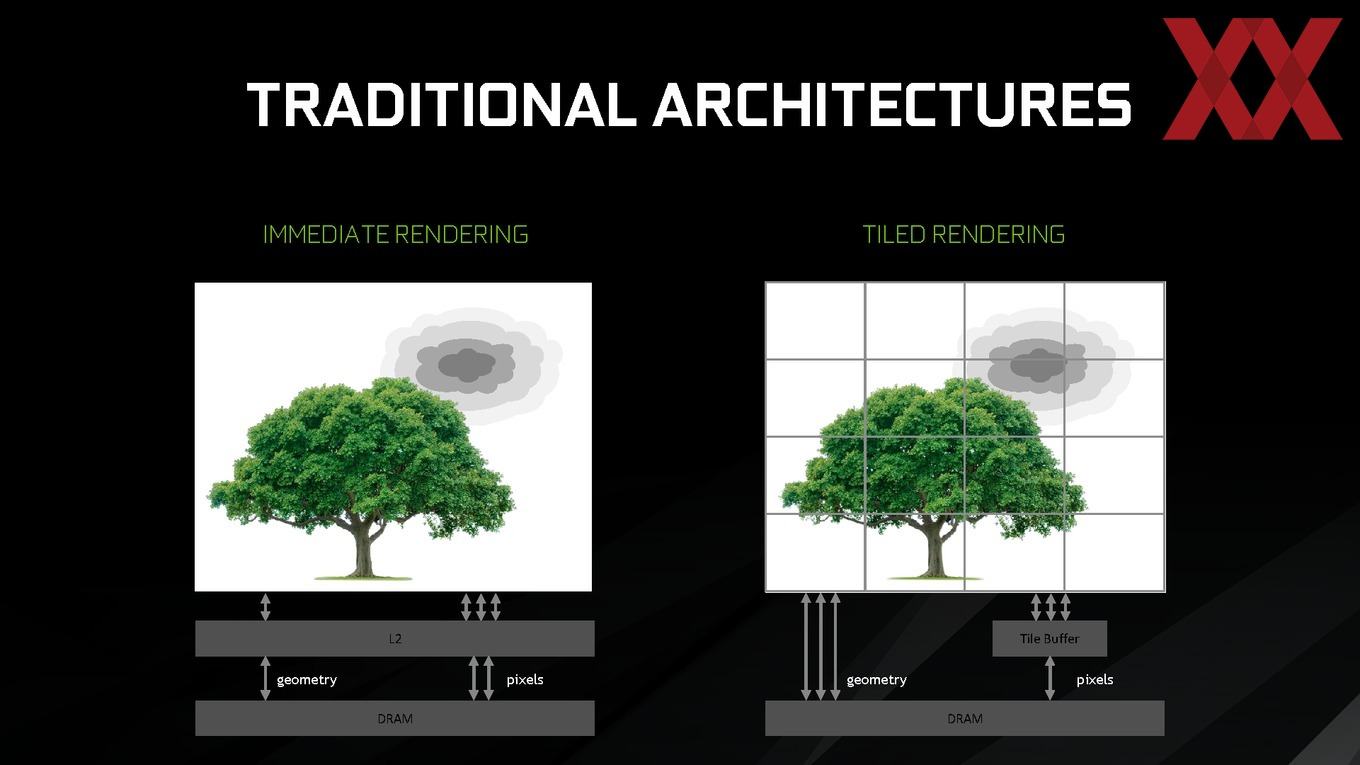

Um den Flaschenhals aufzuzeigen, machte NVIDIA ein Beispiel, welches die beiden Extreme aufzeigt. Da wäre das Immediate Rendering, in dem ein Frame in einem Durchlauf bearbeitet wird. Die Geometrie-Daten werden vom DRAM in den L2-Cache und letztendlich in die GPU übertragen. Nach den Berechnungen werden die Pixel wieder aus der GPU in den L2-Cache und nach der Komprimierung in den DRAM übertragen. Die Bandbreite zwischen L2-Cache und DRAM wird zu einem limitierenden Faktor.

Der zweite Ansatz ist das Tiled Rendering, bei dem eine Szene in Tiles, also Kacheln aufgeteilt wird. Für jede Kachel müssen am Anfang die Geometrie-Daten übertragen werden, was der große Nachteil dieser Rendering-Technologie ist. Die Ausgabe der Pixel hingegen verbraucht weniger Bandbreite, da ein schneller Tile-Buffer verwendet wird. Dazu wird der L2-Cache genutzt, der einen Bereich zugewiesen bekommt, in dem ausschließlich diese Tile-Daten abgelegt werden. Die Ausgabe erfolgt aus jenem Tile-Buffer.

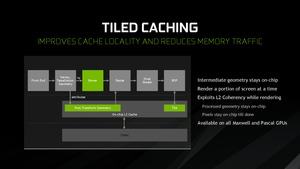

Das Tiled Caching soll nun das Beste aus beiden Welten sein. Dazu verwendet NVIDIA eine Technik, die bereits seit der Maxwell-Generation in den GPUs eingebaut ist. Bereits im August des vergangenen Jahres tauchten erste Informationen dazu auf. Auch AMD verwendet mit der Vega-Architektur einen solchen Ansatz, bisher aber wollte dies NVIDIA nicht offiziell bestätigen. Ein sogenannter Binner mit Queue sitzt zwischen Geometry und Rasterizer. In diesen Binner werden die Geometrie-Daten geladen und dort in Tiles berechnet, wenn die Queue voll ist. Die Geometrie-Daten verbleiben dabei im L2-Cache und müssen nicht ständig aus dem DRAM in den L2-Cache übertragen werden, wie das bei der Behandlung einzelner Tiles der Fall ist. Die in Tiles gerenderten Pixel verbleiben ebenfalls im L2-Cache und werden erst zur Ausgabe in den DRAM übertragen. Damit wird der Flaschenhals bei der Übertragung zu vieler Daten zwischen dem L2-Cache und dem DRAM umgangen. Das Tiled Caching kann aber nicht in jedem Fall angewendet werden und so muss NVIDIA auch auf das Immediate Rendering zurückfallen.

Mit solchen Technologien kann NVIDIA den Schritt zu schnellerem Speicher wie eben HBM2 noch etwas hinauszögern, ohne zu große Einbußen bei der Leistung zu haben. GDDR5X @ 11 GBit/s wie er nun bei der GeForce GTX 1080 Ti zum Einsatz kommt liegt hinsichtlich der Bandbreite auf Niveau von HBM. HBM2 ist mit 720 - 1.000 GB/s zwar noch einmal deutlich schneller, in der Fertigung zusammen mit dem Interposer aber auch deutlich teurer. Durch die Speicherkomprimierung und das Tiled Caching will NVIDIA eine virtuelle Speicherbandbreite von 1.200 GB/s erreichen, von denen 484 GB/s in Hardware in Form des schnellen Speichers umgesetzt sind und der Rest über die genannten Technologien erreicht wird. Für die Komprimierung und das Tiled Caching wird NVIDIA sicherlich die bestmöglichen Szenarien gewählt haben. Ohnehin handelt es sich bei der Darstellung nur um einen theoretischen Vergleich.

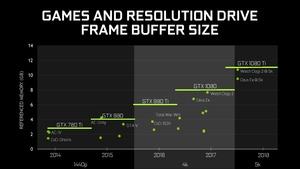

Die 11 GB an GDDR5X der GeForce GTX 1080 Ti reichen laut NVIDIA in nächster Zeit auch noch aus, denn Spiele wie Watch Dogs 2 oder Deus Ex: Mankind Devided belegen selbst in 5K nur etwa 11 bzw. 9 GB im Grafikspeicher.

[h3]Bessere Kühlung und Spannungsversorgung[/h3]

NVIDIA will die Kühlung und die Spannungsversorgung der GeForce GTX 1080 Ti noch einmal im Vergleich zu den Vorgängern verbessert haben. Durch das Weglassen des DVI-Ausganges gewinnt NVIDIA etwas Platz an der Slotblende. Nun noch vorhanden sind 1x HDMI 2.0b und 3x DisplayPort 1.3/1.4. Die Kühlfläche des Kühlers soll sich verdoppelt haben. Ebenfalls verbaut ist eine Vapor-Chamber.

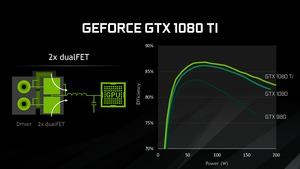

Auf Seiten der Spannungsversorgung spricht NVIDIA von sieben, doppelt bestückten Phasen, also 14 Dual-FETs, die bis zu 250 A liefern können. Durch die neue Bestückung mit Dual-FETs steigert NVIDIA auch die Effizienz der Karte. Jede GPU hat dabei einen Sweet Spot, bei der die Ansteuerung besonders effektiv ist. NVIDIA vergleicht die GeForce GTX 1080 Ti gegen die GeForce GTX 1080 und GeForce GTX 980 und will hier noch einmal deutliche Verbesserungen erreicht haben.

Von der Anzahl einmal abgesehen nichts getan hat sich beim Typ und der Auslegung der Spulen, der Kondensatoren und der MOSFETs. Auch der MOSFET-Treiber sind identisch (TPS53603A von Texas Instruments). Die Treiber der MOSFETs für die GPU werden weiterhin von einem uP9511P VRM-Controller von uPI Semiconductor angesteuert. Eine Änderung gibt es aber beim VRM-Controller für die Speicher-MOSFETs, denn dieser uP1658P kann den Speicher mit mehr als zwei Power-States ansteuern. Die NVIDIA Titan X konnte ihren Speicher in zwei Spannungsstufen ansteuern. Die GeForce GTX 1080 Ti Founders Edition hat hier aber eine VID-Tabelle hinterlegt, die mehrere unterschiedliche Speicherspannungen ermöglicht.

Die insgesamt sieben Spannungsphasen teilen sich wie folgt auf: Zwei Phasen sind für die Versorgung des Speichers verantwortlich. Die GPU verwendet die restlichen fünf Spannungsphasen. Versorgt werden diese Phasen über den 6-Pin- und 8-Pin-Anschluss sowie den PCI-Express-Steckplatz. Der PCI-Express-Steckplatz versorgt dabei zwei Phasen der GPU, der 6-Pin-Anschluss ebenfalls zwei Phasen der GPU und der 8-Pin-Anschluss übernimmt weitere zwei Phasen der GPU und zusätzlich die des Speichers. Nun fehlt aber noch eine Phase der GPU, die sowohl vom 6-Pin- als auch vom 8-Pin-Anschluss versorgt wird.

Der Begriff Dual-FET-Design ergibt sich aus dem Umstand, dass pro Phase zwei Kondensatoren, eine Spule und wieder zwei MOSFETs zum Einsatz kommen. Bei einem Single-FET-Design wären dies zwei Kondensatoren, eine Spiele und nur ein MOSFET. Die doppelte Anzahl an MOSFETs pro Phase ermöglicht eine Aufteilung der Spannungsversorgung auf diese beiden Komponenten, was die Temperaturen deutlich reduzieren sollte.

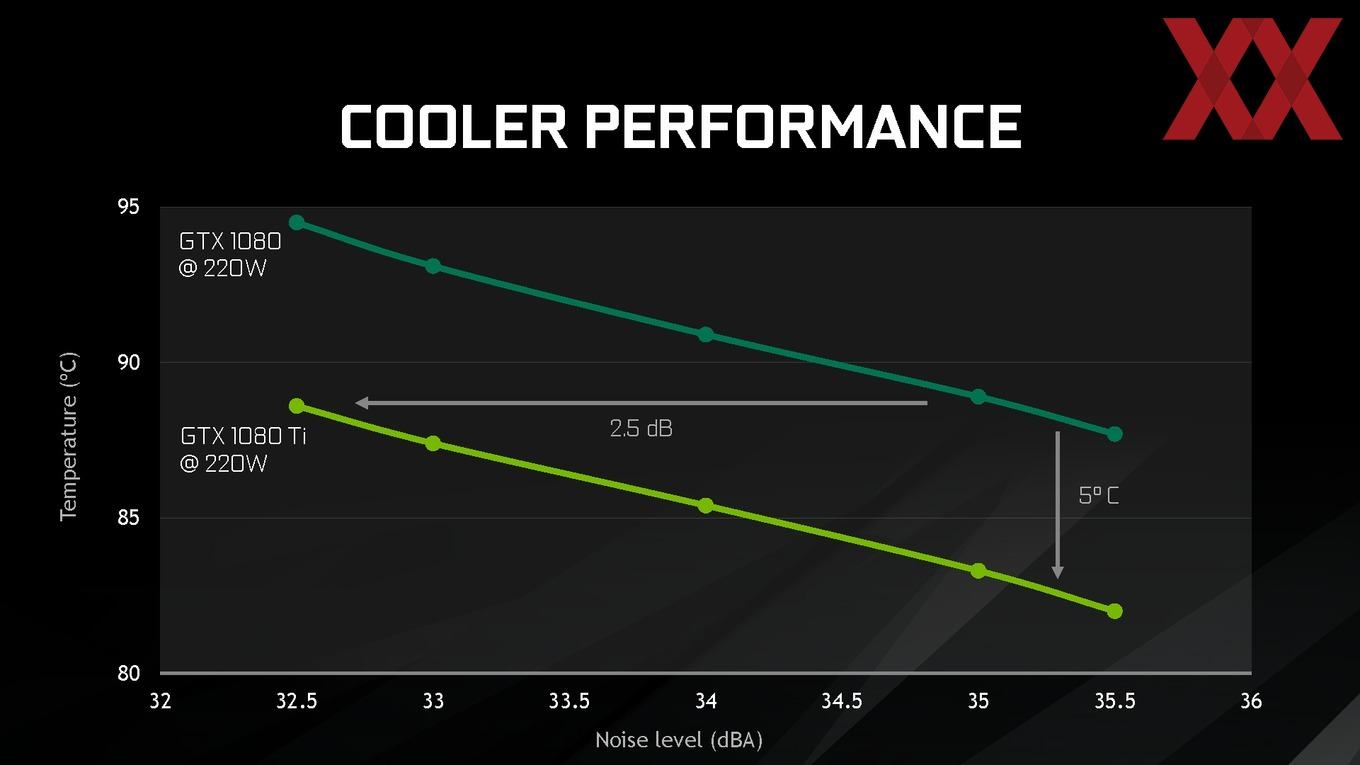

Auch beim Kühler sollen die Maßnahmen dazu beigetragen haben, dass die Karte leiser ist und gleichzeitig niedrigere Temperaturen vorweisen kann. NVIDIA spricht von 5 °C niedrigeren Temperaturen und 2,5 db(A) geringerer Lautstärke. In unseren Tests wird die Karte aber noch beweisen müssen, ob sie in der Lage ist, dieses Versprechen zu halten. NVIDIA nennt hier nur Zahlen, bei denen beide Kühler getestet und diese mit 220 W an Wärmeleistung belastet wurden. Unsere Messungen folgen in diesem Artikel etwas später.

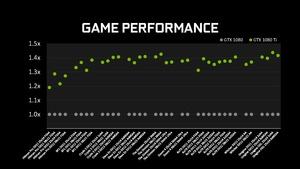

Die Frage nach der Sinnhaftigkeit einer GeForce GTX 1080 Ti beantwortet NVIDIA mit einem Vergleich früherer Ti-Versionen. So soll die GeForce GTX 780 Ti gegenüber der Non-Ti ein Plus von 18 % an Leistung vorzuweisen haben. Die GeForce GTX 980 Ti erbrachte ein Plus von 25 % gegenüber der GeForce GTX 980 und die GeForce GTX 1080 Ti soll nun im Schnitt 35 % schneller sein, als die GeForce GTX 1080. Auch hierzu liefern wir die Werte ja später noch. Die zusätzliche Strom- und Spannungsversorgung erfolgt bei der GeForce GTX 1080 Ti über jeweils einen 8-Pin- und einen 6-Pin-Anschluss.