Mit GPT-4 (Generative Pre-trained Transformer 4) und dem darauf basierenden Chatbot ChatGPT sowie weiteren LLMs (Large Language Models) wie LAMA (LAnguage Model Analysis) wurde kürzlich eine neue Welle an KI-Systemen geschaffen, die zusammen mit der KI-Kunst aus Midjourney, Stable Diffusion und DALL-E eine wahre KI-Revolution ausgelöst haben. Bei NVIDIA hat man Weitsicht bewiesen und bereits 2018 die Weichen für DLSS gestellt. Wir schauen uns den aktuellen Stand der Technik an.

In diesem Technik-Artikel werden wir uns ausschließlich der DLSS-Technik widmen. Dies hat natürlich auch einen Grund, denn von allen drei Upscaler-Techniken der GPU-Hersteller ist sie sicherlich die am weitesten entwickelte. XeSS darf sich noch am ehesten als technisch ebenbürtig bezeichnet werden, denn auch Intel setzt auf eine KI-Rekonstruktion (was das ist, dazu kommen wir gleich). AMD hingegen nutzt für FSR 2 noch immer eine reines Upscaling samt Nachschärfen und wird erst mit FSR 3 auf eine Frame Interpolation, was nur eine andere Bezeichnung für die Erstellung kompletter Frames ist – auch dazu gleich mehr.

Aber was ist DLSS eigentlich? DLSS steht für Deep Learning Super Sampling. Ein Supercomputer bei NVIDIA berechnet regelmäßig ein sogenanntes "Ground Truth". Dazu werden verschiedene Spiele bzw. Frames in 16K-Auflösung mit 64x Supersampling (64xAA gerendert. Es entsteht ein AI-Modell, ähnlich wie GPT-4 oder Transformer, nur eben für Spiele.

Auf die Details gehen wir in den kommenden Abschnitten ein. Wer Interesse daran hat genau zu erfahren, wie DLSS und Frame Generation funktionieren, kann einfach weiterlesen. Wer dies nicht möchte, kann direkt zu den Benchmarks springen und sich einfach nur anschauen, welches Leistungsplus mittels DLSS möglich ist.

Vorweg noch: Einige Nutzer sind von der Vielfalt der Möglichkeiten in den Einstellungen zur DLSS überfordert oder sehen Abhängigkeiten, wo es eigentlich keine gibt. DLSS 3 besteht aus dem AI-Upscaler in Form von DLSS 2. Die Frame Generation und Reflex sind optionale Funktionen, die man auch wieder deaktivieren kann. Man kann die Frame Generation aber auch verwenden, ohne das DLSS zu aktivieren und auch Reflex ist ohne DLSS und Frame Generation zu aktivieren, wenn das Spiel die Reflex-API denn verwendet.

NVIDIA verwendet für DLSS ein immer wieder neu trainierte und optimierte KI-Modell, dass letztendlich vom Spieler verwendet wird, um die Darstellungsqualität und Leistung auf der eigenen GeForce-RTX-Karte zu verbessern. Das aktuell auf dem lokalen System gerenderte Bild mit niedriger Auflösung wird in höherer Auflösung Pixel für Pixel rekonstruiert. Da in einer niedrigeren Auflösung gerendert wird, werden höhere FPS erreicht. Die Rekonstruktion sorgt dann für die möglichst optimale Darstellung in der Ausgabeauflösung, die um den Faktor vier höher sein kann.

DLSS 3 wird mittels vier Komponenten verarbeitet: Einem Optical Flow Accelerator, Bewegungsvektoren der Spiele-Engine, einem konventionellen AI Frame Generator und der Reflex-Pipeline, die für niedrigere Latenzen sorgen soll.

Ein Problem von DLSS in der ersten Umsetzung war die fehlende temporale Instabilität. Objekte, die sich von Frame zu Frame über den Bildschirm bewegten oder solche, die extrem dünne Strukturen aufwiesen, wurden nicht korrekt dargestellten und flimmerten oder waren Mal sichtbar und Mal nicht. Auch die sogenannten Sternschnuppen, wenn beispielsweise Schneeflocken einen Schweif hinter sich herzogen, waren Probleme für die früheren Versionen von DLSS. Mit DLSS 3 und auch schon bei DLSS 2.2 verarbeitet NVIDIA den neuen Frame und den vorherigen, um festzustellen, wie sich die Szene verändert.

Diese Änderungen bzw. Bewegungsmuster werden im neuronalen Netzwerk mit einbezogen und sollen verhindern, dass es zu den beschriebenen Bildfehlern kommt. Die erhöhte temporale Stabilität stellt einen großen Sprung in der Bildqualität von DLSS dar.

DLSS 3 mit Frame Generation

Mit DLSS 3 geht NVIDIA nun noch einen Schritt weiter und nutzt dazu einige Hardware-Ressourcen der Ada-Lovelace-Architektur, was DLSS 3 in dieser Form auch auf die Karten der GeForce-RTX-40-Serie beschränkt. DLSS 3 mit Frame Generation ist nicht mehr nur ein AI-Upscaler, der intern mit einer niedrigeren Auflösung rendert und die Frames dann in einer höheren Auflösung wieder ausgibt, sondern es werden komplette Frames neu generiert, ohne dass die Grafik-Pipeline dazu verwendet wird. Diese Zwischenbilder durchlaufen also nicht den klassischen Prozess eines Renderings auf der Grafikkarte.

Ein Optical Flow Accelerator (OFA) bzw. eine Optical Flow Engine war bereits Bestandteil der Ampere-Architektur (GeForce-RTX-30-Serie). Verwendet wird er unter anderem in der Erkennung von Bewegungsvektoren für ein Video-Encoding. Der in der Ada-Lovelace-Architektur verwendete OFA kommt auf eine Rechenleistung von 300 TOPS (Tera-Operationen pro Sekunde) und ist mehr als doppelt so schnell wie bei der Vorgänger-Architektur. Diese Rechenleistung ist ein wichtiger Baustein zu dem, was über die Frame Generation erreicht wird.

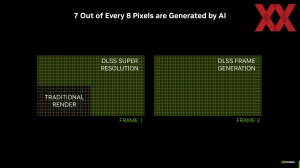

Das DLSS als AI-Upscaler berechnet bei einer Ausgabeauflösung von 4K einen Eingangsframe mit 1080p und skaliert diesen dann wieder in die 4K-Auflösung. Aus knapp 2 Millionen Pixel (1.920 x 1.080 Pixel) werden 8,3 Millionen Pixel (3.840 x 2.160 Pixel). Frame 1 in obiger Darstellung zeigt den "klassischen" DLSS-Mechanismus. Mit der Frame Generation kommt ein komplett neu erstellter Frame hinzu, sodass in diesem Beispiel nur etwa 2 Millionen Pixel durch die Grafikkarte gerendert werden, aber 2x 8,3 Millionen Pixel über zwei Frames in 4K-Auflösung ausgegeben werden.

Für die Frame Generation ist der OFA ein wichtiger Bestandteil. Der Optical Flow Accelerator versorgt das neuronale Netz mit Richtung und Geschwindigkeit der Pixel von Frame zu Frame. Diese Framepaare aus dem Spiel werden zusammen mit der Geometrie und den Pixelbewegungsvektoren in ein neuronales Netz eingespeist, dass sogenannte Zwischenbilder erzeugt.

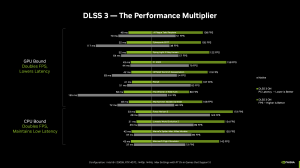

Da DLSS 3 neue Frames erzeugt, ohne das Spiel einzubeziehen, profitieren sowohl GPU- als auch CPU-begrenzte Spiele davon. Mehr FPS durch DLSS und Frame Generation sind logisch- Da die Zwischenbilder aber ohne jegliches Zutun des Prozessors erstellt werden, da die Grafikkarte ja nicht den sonst üblichen Weg der Grafik-Pipeline gehen muss, wird die Limitierung durch den Prozessor, der die Grafikkarte ja füttern muss, ebenfalls aufgehoben.

Ausgeführt werden viele der Berechnungen neben der Optical Flow Engine auch in den Tensor Cores. Diese sind ein integraler Bestandteil der Ada-Love-Architektur und stellen die notwendige Rechenleistung zur Verfügung, damit ein DLSS funktionieren kann. Die verbesserten Tensor-Cores der vierten Generation in der Ada-Lovelace-Architektur erreichen für FP8-Berechnungen einen bis zu 5-Fach höheren Durchsatz im Vergleich zur dritten Generation in der Ampere-Architektur.

DLSS 3 und Reflex im Zusammenspiel

Ein Punkt, der für das DLSS 3 und die Frame Generation zumindest eine Nebenrolle spielt, sind die Systemlatenzen. NVIDIA hat schon vor einiger Zeit eine Reihe an APIs vorgestellt, welche für den Spieler als Reflex-Technologie die Latenzen deutlich reduzieren sollen.

Das Rendering soll just-in-time erfolgen – kurz nach der Eingabe durch den Spieler, wodurch die Warteschlange für das GPU-Rendering wegfällt und der CPU-Rückstau reduziert wird. Dies führt zu Latenzreduzierungen, die über die üblichen reinen Treibertechniken hinausgehen. Zusammen mit hohen FPS und ebenso hohen Aktualisierungsraten des Monitors sind die Systemlatenzen ein wichtiger Bestandteil für kompetitive Spieler.

Das Problem im Zusammenhang mit DLSS 3 und der Frame Generation ist nun, dass Zwischenframe gar keine Eingaben des lokalen Spielers oder in einem Multiplayer-Szenario die Eingaben der anderen Spieler mit aufnimmt und darstellt. Der Zwischenframe kann sozusagen nur lokale Informationen mit einbeziehen.

In durch die GPU limitierten Szenarien reduziert der Einsatz von DLSS 3 mit Frame Generation die Systemlatenz. In durch die CPU limitierten Szenarien werden die FPS durch die generierten Zwischenframes deutlich erhöht, die Systemlatenz aber bleibt weitestgehend im Rahmen. Sie erhöht sich leicht, für jeden zweiten Frame aber können die Eingaben weiterhin mit eingebogen werden und bei einer Verdopplung der FPS kann die Systemlatenz also stabil gehalten werden.

Die Anforderungen für das Raytracing steigen

Mit DLSS 3 stellt NVIDIA dem Spieler ein Werkzeug zur Seite, welches viele Aspekte des Gaming unterstützt. Aber DLSS ist auch ein Hilfsmittel, welches eine gewisse Notwendigkeit hat, denn das Raytracing stellt hohe Anforderungen an die Hardware. Fallen die FPS durch die Aktivierung der Raytracing-Effekte unter einen Wert, den der Spieler noch als spielbar erachtet, bringt das DLSS die FPS wieder in einen akzeptablen Bereich.

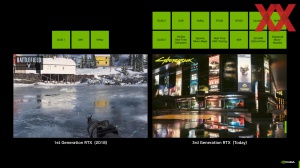

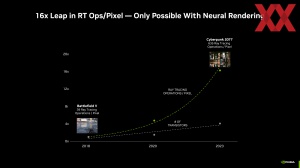

Über die bisherigen GPU-Generation mit Raytracing-Beschleunigung sind die Anforderungen an die Hardware deutlich gestiegen. 2018 mit der Turing-Architektur wurden für einen Pixel, der mit einem Raytracing-Effekt berechnet wurde, 39 Raytracing-Operationen durchgeführt. In 2023 sind es in Cyberpunk 2077 im Overdrive Mode nun 635 Raytracing-Operationen pro Pixel.

Rein über die rohe Rechenleistung der GPUs sind solche Anforderungen nicht mehr zu stemmen. Die notwendigen Berechnungen müssen also effektiver werden, damit noch spielbare FPS möglich bleiben.

Die Raytracing-Einheiten oder RT-Cores der 3. Generation von Ada Lovelace haben einen doppelt so hohen Durchsatz an ihren Recheneinheiten wie ihre Vorgänger, wodurch die Raytracing-Rechenleistung um bis zu 2,8x gesteigert wird. Für die GeForce RTX 4090 bedeutet dies theoretisch 191 RT-TFLOPS, verglichen mit 78 RT-TFLOPS bei der GeForce RTX 3090 Ti.

Zudem bieten die RT-Cores der 3. Generation Funktionen wie die Opacity Micro-Map-Engines und Micro-Mesh-Engines. Dies sind neue, spezielle Hardwareeinheiten zur Beschleunigung besonders anspruchsvoller Raytracing-Workloads, die dann per Software angesprochen werden können.

Die Opacity-Micro-Maps sind eine Form der Optimierung für das Raytracing. Darstellungsdetails werden vordefiniert auf die Objekte der Spiele-Welt kodieren. Ein Raytracing kann für bestimmte Objekte extrem komplex sein. Laub und Vegetation im Allgemeinen sind solche Beispiele. Solche Objekte sind für die zu berechnenden Strahlen schwierig, da es unzählige Richtungen gibt, in die zwischen Blättern und Ästen reflektiert werden kann. Die RT-Cores der dritten Generation verwendet Opacity-Micro-Maps, um den Opazitätsstatus dieser Elemente zuzuweisen, der undurchsichtig, transparent oder unbekannt sein kann. Komplexen Objekte wurden bisher gar nicht oder nur ungern mit Raytracing-Effekten belegt. Die Opacity Micro-Maps sollen machen die nun möglich.

Die Displaced Micro-Meshes (DMM) werden ebenfalls durch die RT-Cores der dritten Generation generiert. Die für die Raytracing-Berechnungen verwendeten Bounding Volume Hierarchies (BVH) sollen damit 10-mal schneller aufgebaut werden können und 20-mal weniger Grafikspeicher benötigen.

Dies sind nur einige der Techniken die NVIDIA in der Ada-Lovelace-Architektur verwendet, um die Berechnungen der Raytracing-Effekte zu optimieren.

DLSS 3 und Raytracing gehen Hand in Hand

Durch die immer aufwendigeren Raytracing-Effekte steigen die Anforderungen an die Hardware. DLSS bietet hier die Möglichkeit dies zu kompensieren. Von dieser Möglichkeit machen auch schon viele Spieler Gebrauch. Immer wieder gibt es aber aus dieser Richtung viel Kritik am Einsatz der rechenintensiven Raytracing-Effekte. Umfragen sollen immer wieder verdeutlichen, dass gerade die Raytracing-Effekte nur ungern genutzt werden.

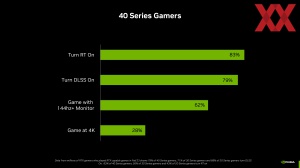

Das Problem solcher Umfragen ist immer die Datenbasis, bzw. die Zielgruppe, die hier angesprochen wird. Dies gilt natürlich auch für die nun von NVIDIA veröffentlichten Daten. Ermittelt hat NVIDIA diese über die GeForce Experience. Der Nutzer stimmt dem Sammeln dieser Daten mit der Nutzung zu, dies kann jedoch deaktiviert werden.

Den Zahlen von NVIDIA zufolge, nutzten im Jahre 2018 37 % aller Spieler mit einer Karte der GeForce-RTX-20-Serie die Raytracing-Effekte und 26 % setzten auf das damals noch nicht optimal umgesetzte DLSS in der ersten Generation.

Die neuesten Daten stammen aus dem Februar 2023. Laut diesen nutzen 79 % der Nutzer einer GeForce-RTX-40-Karte das DLSS und sogar 83 % schalten die Raytracing-Effekte an. Die Daten aus den weiteren Serien sehen wie folgt aus:

| GeForce-RTX-40-Serie | GeForce-RTX-30-Serie | GeForce-RTX-20-Serie | |

| Raytracing | 83 % | 56 % | 43 % |

| DLSS | 79 % | 71 % | 68 % |

Die Daten zeigen eine klare Tendenz: Mit der neuen Generation nutzen mehr und mehr Spieler die Techniken. Dies liegt sicherlich einerseits daran, dass mehr und mehr Spiele diese unterstützen und andererseits auch an der stetig besser gewordenen Umsetzung.

Vor allem beim DLSS (Deep Learning Super Sampling) hat NVIDIA mit DLSS 2 und zuletzt DLSS 3 große Sprünge hinsichtlich der Bildqualität und Leistungssteigerung gemacht. Einstige Schwachstellen, wie Objekte in Bewegung und solche mit feinen Strukturen, werden nun mit DLSS 2/3 weitestgehend ohne störendes Flackern dargestellt. Per Upscaling und damit dem Rendering in einer niedrigeren Auflösung sowie der Erstellung ganzer Frames (Frame Generation) werden nur noch bis zu 1/8 der dargestellten Pixel eigentlich berechnet. Die restlichen 7/8 entstammen dem Upscaling und der Frame Generation.

Bei den Raytracing-Effekten sieht es noch etwas anders aus. Die Anforderungen sind hier noch immer hoch und werden künftig weiter steigen. Das Pathtracing wird der nächste Schritt sein. Aber die Hardware wird immer leistungsfähiger und somit werden immer höhere Frameraten problemlos realisiert.

Wozu das alles?

Wir haben bereits beschrieben, dass die Anforderungen an die Raytracing-Leistung immer höher werden. Gleichzeitig wollen Spieler in immer höheren Auflösungen und an Monitoren mit höheren Aktualisierungsraten spielen. Die FPS aber sollen beibehalten werden. DLSS 3 und Frame Generation helfen den Verlust an FPS zu kompensieren. Viel mehr noch, sie bieten höhere FPS bei einer gleichzeitig besseren Darstellungsqualität.

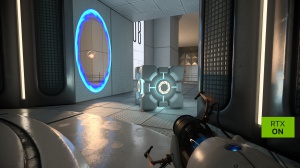

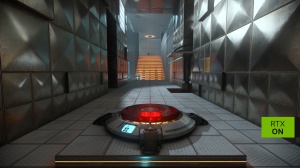

Aber es gibt auch schon einen Ausblick darauf, wie es in dieser Richtung weitergehen wird. Das Pathtracing ist dieser nächste Schritt. In Form von Portal RTX haben wir bereits eine Pathtracing-Umsetzung gesehen. NVIDIA tat dies in Eigenregie. Für den RT Overdrive Mode von Cyberpunk 2077 hat man sich mit dem Entwicklerstudio CD Projekt Red zusammengetan. Beides sind Darstellungsoptionen, die eigentlich über das hinaus gehen, was aktuelle Hardware stemmen kann. DLSS wird als Hilfsmittel genutzt dennoch spielbare FPS zu erreichen.

Aber noch ein paar Worte zur Umsetzung beider Titel:

In Portal RTX werden Effekte wie Schatten, Reflexionen, globale Beleuchtung, Lichtbrechungen und mehr per "einfacher" Raytracing-Umsetzung berechnet, sondern man geht noch einen Schritt weiter. Licht kann von hinten oder aus einem anderen Raum einfallen, Glas bricht das Licht, Oberflächen reflektieren Details aufgrund ihres Reflektionsgrades, Spiegelungen können Objekte hinter dem Spieler zeigen und Objekte können sich selbst reflektieren.

Dazu sind verschiedene Techniken, wie NVIDIA RTX Direct Illumination (RTXDI) im Einsatz. RTXDI Ermöglicht es, dass zahllose direkte Lichtquellen, unabhängig von ihrer Größe und Lichtpfade, Schatten werfen. Die Reservoir Spatio-Temporal Importance Resampling Global Illumination (ReSTIR GI) verbessert das indirekte Licht und ermöglicht eine Durchleuchtung der Szene und der dunklen Bereiche, die nicht direkt beleuchtet werden. Außerdem arbeitet ReSTIR GI intelligenter als frühere Raytracing-Techniken für die globale Beleuchtung und verbessert die Effizienz des Entrauschen-Vorganges.

Der Real-Time Denoiser (NRD) ist eine neue räumlich-zeitliche Raytracing-Denoising-Bibliothek, die bei der Konvertierung der Rohdaten des Raytracing in Echtzeit unterstützend wirkt. Portal mit RTX, RTX Remix und anderen neuen Raytracing-Spiele werden den NRD verwenden bzw. tun dies schon.

Der RT Overdrive Mode von Cyberpunk 2077 verbessert die ohnehin schon vorhandenen Raytracing-Effekte. Im Vergleich zur reinen Rasterization-Darstellung werden alle Beleuchtungs-Effekte durch solche mittels Raytracing ersetzt. Bei den Berechnungen der Schatten erfolgt das gleiche Prozedere. Aber in weiten Bereichen kennen wir diese Verbesserungen in der Darstellung schon durch die erste Umsetzung der Raytracing-Effekte.

Aber der RT Overdrive Mode bietet auch Unterschiede im Vergleich zum schon aufwendigen Psycho-Preset von Cyberpunk 2077. Dies liegt daran, dass im Psycho-Preset noch immer teilweise Rasterization-Effekte für die Berechnung der Beleuchtung und Schatten zum Einsatz kommen, was im RT Overdrive Mode nicht mehr der Fall ist.

So haben sich die Entwickler entschieden, für eine Raytracing-Berechnung der lokalen Beleuchtungssituation für direktes Licht nur neonfarbenes Licht mit einzubeziehen. Im RT Overdrive Mode werden sämtliche Lichtquellen bedacht. Diese Lichtquellen konnten dann zwar einen per Raytracing berechneten Schatten erzeugen, aber auch hier schoben die Entwickler aus Performancegründen meist einen Riegel vor und bezogen nicht alle Lichtquellen mit ein. Auch dies ändert sich im RT Overdrive Mode.

Eine kleine Übersicht erklärt die Unterschiede in der Behandlung der verschiedenen Effekte:

| Cyberpunk 2077 Psycho-Preset | Cyberpunk 2077 RT Overdrive Mode | |

| Direkte Beleuchtung | Raytracing für diffuse Lichtquellen Raytracing für Schatten Raytracing für bestimmte Lichtquellen Rasterization für die meisten Lichtquellen | NVIDIA ReSTIR Direct Lightning |

| Indirekte Beleuchtung | Raytracing für Umgebungsbeleuchtung Raytracing für Umgebungsbeleuchtung (Sun GI) Raytracing für Reflexionen Rasterization in Teilen per Image based Lightning Probes | NVIDIA ReSTIR Global Illumination |

Jede direkte und indirekte Lichtquelle wird im RT Overdrive Mode per Raytracing berechnet. ReSTIR Direct Lightning und ReSTIR Global Illumination sind die beiden Techniken, die zum Einsatz kommen. Sämtliche direkt und indirekt beleuchteten Pixel werden mit multiplen Rays berechnet, sodass man hier in weiten Teilen von einem Pathtracing sprechen kann. Nicht alle Lichtquellen beleuchten die Umgebung und nicht alle Lichtquellen werfen an allen Objekten einen per Raytracing berechneten Schatten. Dort wo die Entwickler aufgrund zu großer Leistungseinbußen auf den Einsatz von Raytracing verzichtet haben, sind diese Einschränkungen im RT Overdrive Mode nicht mehr vorhanden.

Anhand einiger Beispiele wollen wir uns die Darstellung mit reiner Rasterizer-Technik sowie den Raytracing-Modi anschauen:

Zunächst vergleichen wir die Rasterizer gegenüber Raytracing im Psycho-Preset. Die Unterschiede in der Berechnung der Beleuchtung und Schatten sind sehr deutlich. In der reinen Rasterizer-Darstellung werden die meisten Lichtquellen gar nicht mit einbezogen, sondern eine Lightning-Map verwendet, die unsichtbare Lichtquelle an bestimmten Positionen einsetzt, um die Szene zu beleuchten. Eine realistische Berechnung findet erst mit Raytracing statt. Wie bereits erwähnt, werden hier allerdings größtenteils nur die neonfarbenen Lichtquellen entsprechend behandelt.

Bei den Schatten sind die Unterschiede ebenfalls deutlich. Anstatt fixer Shadow Maps oder gar keiner Schatten, obwohl diese zum Beispiel im Falle der Kante zwischen Werkbankarbeitsfläche und Wand vorhanden sein sollten, werden diese mit Raytracing korrrekt berechnet bzw. solche physikalischen Eigenschaften überhaupt erst mit einbezogen.

Auf den ersten Blick aber sicherlich am auffälligsten sind die fehlenden Reflexionen in metallischen Oberflächen oder wie hier einer Pfütze. Per Screen Space Reflection (SSR) werden zwar einige Elemente als Reflexion dargestellt, aber es gibt in der SSR-Technik auch einige Limitierungen, die per Raytracing nicht vorhanden sind und die somit bietet sich eine Umsetzung per Raytracing-Technik auch geradezu an.

RT Overdrive Mode legt eine Schippe drauf

Der RT Overdrive Mode nimmt nun auch noch die Limitierungen heraus, die wir bisher in der Raytracing-Umsetzung in Cyberpunk 2077 gesehen haben. Anstatt eine Auswahl an Lichtquellen für die Beleuchtung und den Schattenwurf mit einzubeziehen, sind es nun sämtliche vorhandene Lichtquellen. Einige Vergleiche zwischen der Raytracing-Darstellung im Psycho-Preset sowie im RT Overdrive Mode sollen dies aufzeigen:

Nicht nur werden alle Lichtquellen, seien es direkte oder indirekte, mit einbezogen, auch geschieht dies über mehrere Bounces. Licht, das durch eine offene Tür einfällt, erhellt nicht nur die gegenüberliegende Wand, sondern erhellt auch die weiteren Bereiche des Raumes, da weitere Bounces des Lichts berechnet werden.

Teilweise ändert sich die gesamte Beleuchtungssituation durch die Verwendung weiterer Bounces. Das rote Licht erhellt für ein Raytracing im Psycho-Preset zwar die direkt Umgebung, die kompletten Oberfläche zeigen aber weiterhin eine Situation, in der die Szene in ein bläuliches Licht getaucht wäre. Im RT Overdrive Mode erhellt das hellrote Licht dann auch alle Oberfläche in der Form, wie man es erwarten würde.

Dies gilt auch für anderen Bereiche im Spiel, in denen der Sonnenschein eigentlich dafür sorgen sollte, dass Oberfläche ohne direkte Sonneneinstrahlung in indirekter Form mit einem eher rötlichen Licht angestrahlt werden sollten. Per Raytracing im Psycho-Preset ist dies aber nicht möglich. Erst der RT Overdrive Mode berechnet diese indirekte Beleuchtung über mehrere Bounches korrekt.

DLSS-Benchmarks: Cyberpunk 2077

"There is no such thing as a free lunch" – Aufwändige Raytracing-Effekte kosten Leistung. Dies ist bei den Teileffekt-Umsetzungen schon der Fall, für ein Pathtracing wie in Portal RTX und dem RT Oveerdrive Mode von Cyberpunk gilt dies umso mehr.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

Zunächst haben wir uns angeschaut, wie groß der Unterschied in den FPS mit einer GeForce RTX 4080 ist, wenn man Cyberpunk 2077 in 4K im Rasterization-Render (Ultra) gegenüber der Raytracing- (Psycho) und der RT-Overdrive-Umsetzung ausführt.

Cyberpunk 2077 - Rasterization vs. Raytracing ohne DLSS

3.840 x 2.160 Pixel - GeForce RTX 4080

Werbung

Alleine schon durch die Raytracing-Effekte brechen die FPS um mehr als die Hälfte ein. Von gut spielbaren 65 FPS bleiben nur noch 27 FPS übrig. Im RT Overdrive Mode sind es dann nicht einmal mehr 14 FPS.

Es bedarf also einem Hilfsmittel wie DLSS, um hier wieder auf spielbare FPS zu kommen. Für die aktuell erhältlichen Modelle aus der GeForce-RTX-40-Serie haben wir uns die Leistungsunterschiede der vier DLSS-Qualitätsmodi angeschaut. Als Referenz dient immer die native Darstellung.

NVIDIA GeForce RTX 4090

Cyberpunk 2077 - RT Overdrive Mode

3.840 x 2.160 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4090

Cyberpunk 2077 - RT Overdrive Mode

3.840 x 2.160 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4070 Ti

Cyberpunk 2077 - RT Overdrive Mode

2.560 x 1.440 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4070

Cyberpunk 2077 - RT Overdrive Mode

2.560 x 1.440 Pixel - DLSS + Frame Generation

DLSS-Benchmarks: Portal RTX

Portal RTX stellt ebenfalls ein völlig neues Niveau an Herausforderungen an die Hardware. Selbst eine GeForce RTX 4090 erreicht hier in 4K keine 30 FPS. Also wird auch hier der Einsatz von DLSS zur Pflicht. Genau wie bei Cyberpunk 2077 haben wir uns die Leistung der vier GeForce-RX-40-Series-Karten in den DLSS-Profilen angeschaut.

Datenschutzhinweis für Youtube

An dieser Stelle möchten wir Ihnen ein Youtube-Video zeigen. Ihre Daten zu schützen, liegt uns aber am Herzen: Youtube setzt durch das Einbinden und Abspielen Cookies auf ihrem Rechner, mit welchen Sie eventuell getracked werden können. Wenn Sie dies zulassen möchten, klicken Sie einfach auf den Play-Button. Das Video wird anschließend geladen und danach abgespielt.

Ihr Hardwareluxx-Team

Youtube Videos ab jetzt direkt anzeigen

NVIDIA GeForce RTX 4090

Portal RTX

3.840 x 2.160 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4080

Portal RTX

3.840 x 2.160 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4070 Ti

Portal RTX

2.560 x 1.440 Pixel - DLSS + Frame Generation

NVIDIA GeForce RTX 4070

Portal RTX

2.560 x 1.440 Pixel - DLSS + Frame Generation

DLSS: Ein Zugewinn oder nur eine Krücke?

Lange herrschte auch bei uns eine gewisse Skepsis darüber, wohin uns NVIDIA mit DLSS führen wird. Die ersten Umsetzungen waren auch mehr oder weniger enttäuschend. DLSS setzte sich zur Aufgabe die durch die Raytracing-Effekte verloren gegangenen FPS wiederherzustellen und dabei die Bildqualität mindestens auf gleichem Nivea zu halten. Diese Zielsetzung konnte DLSS aber über Monate hinweg nicht erfüllen. Erst mit DLSS 2.2 bot der KI-Wiederherstellung die von Anfang an angedachte Bildqualität und konnte sich ab dort auch deutlich besser etablieren.

Verwendet wird es nicht nur bei Spielen, die rechenintensive Raytracing-Effekte einsetzen. Eine unterstützende Technik kann DLSS auch sein, wenn auf eigentlich zu schwacher Hardware in zu hohen Qualitätsstufen oder Auflösungen gespielt werden möchte. Oder aber es geht bei kompetitiven Shootern darum, möglichst hohe FPS zu erreichen. Somit erweitert das DLSS auch den Umfang der kompatiblen Hardware – vor allem bei eher schwachbrüstiger Hardwareausstattung.

DLSS ist eine optionale Funktion. Wer es nicht nutzen möchte, muss dies auch nicht tun. Wer weiterhin das volle nativ gerenderte Bild haben möchte, bekommt dies auch. Aber er muss eventuell Kompromisse machen: Entweder mit DLSS spielen oder die Auflösung und/oder die Qualitätsstufe heruntersetzen. In die Kritik geraten ist DLSS aber nicht zuletzt auch durch die direkte Verknüpfung mit den Raytracing-Effekten. Diese, kombiniert mit einer hohen Qualitätsstufe, verlangen selbst aktueller Hardware alles ab. Die Forderung war demnach, dass NVIDIA einfach stärkere Hardware entwickeln oder warten sollte, bis diese soweit ist, um die Raytracing-Effekte ohne derart große Leistungseinbußen einbauen zu können.

DLSS ist aber nicht nur ein Hilfsmittel zur Wiederherstellung oder simple für mehr FPS. Einige Anti-Aliasing-Umsetzungen in Spielen bieten eine schlechtere Bildqualität und hier kann DLSS (oder nur DLAA) bereits eine Hilfe sein. Das Versprechen eine bessere Bildqualität als im nativen Rendering zu liefern, kann NVIDIA inzwischen größtenteils abliefern.

Im Rückblick könnte man durchaus argumentieren, dass NVIDIA vielleicht 1-2 Jahre zu früh damit war. Aber es mussten auch die Hardwarevoraussetzungen und Techniken geschaffen werden, damit wir heute die Umsetzungen in einer Form sehen, wie sie vor 3-4 Jahren noch undenkbar gewesen wären. Bei NVIDIA kann man mit dieser Einschätzung also nicht ganz falsch gelegen haben, denn die Konsolen auf Basis eines Custom-Chips von AMD und die AMD-GPUs selbst bieten ja auch inzwischen eine Hardwarebeschleunigung für das Raytracing. Dies gilt auch für den zweiten Aspekt, das KI-Upscaling – Intel hat XeSS und AMD wird mit FSR 3 ebenfalls auf komplett generierte (nicht mehr die Rendering-Pipeline durchlaufende) Frames setzen.

Bei aller Kritik an NVIDIA und so manchen Entscheidungen, eine gewisse Weitsicht kann man dem Unternehmen hier sicherlich zuschreiben und davon profitiert man heute. Die GPUs liefern die bessere Raytracing-Beschleunigung und DLSS 3 mit Frame Generation bietet in den meisten Fällen die bessere Bildqualität – plus der Vorteile der Frame Generation im Hinblick auf CPU-limitierte Szenarien.

Die Rückmeldungen aus unserer Community zeichnen das eben beschrieben Bild sehr schön nach: Es gibt diejenigen, die weiterhin jeden Frame aus der Rendering-Pipeline der GPU sehen wollen, aber es gibt sehr viele Nutzer mehr, die inzwischen weder auf die Raytracing-Effekte, noch auf eine DLSS-Unterstützung verzichten möchten. Die Techniken sind gekommen um zu bleiben. Unsere GPU-Tests setzen auf Benchmarks mit aktiven Raytracing-Effekten und im Rahmen neuer Modelle werden wir uns auch dem KI-Upscaling immer wieder widmen – egal ob DLSS, FSR oder XeSS.

Was das Pathtracing betrifft, stehen wir gerade erst am Anfang. Portal RTX und der RT Overdrive Mode von Cyberpunk 2077 sind als Technologie-Demos zu verstehen. Sie zeigen, wie aufwendig die Umsetzung ist und daher sind wir hier auf die Unterstützung von DLSS angewiesen. NVIDIA hat sich dazu entschieden, die RTX Remix Runtime als Open-Source-Software anzubieten. Somit ist es Moddern möglich, Klassiker wie eben Portal in einer Ray- oder Pathtracing-Version neu aufzulegen. Wie lange es dauern wird, bis eine Raytracing-Umsetzung wie in Portal RTX und dem RT Overdrive Mode zum Standard wird, ist nur schwer vorherzusagen. Ohne ein KI-Upscaling wird es in nächster Zeit aber nicht gehen.