Werbung

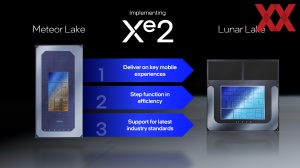

Zusammen mit Lunar Lake feiert auch eine neue Grafik-Architektur ihr Debüt. Die zweite Arc-Generation alias Battlemage alias Xe2-Architektur wird im Compute-Tile in Form einer integrierten Grafikeinheit eingesetzt. Die Xe2-Architektur wird aber nicht nur in Lunar Lake zum Einsatz kommen. Intel bestätigte bereits, dass es auch dedizierte GPUs geben wird.

Wann diese dedizierten GPUs in Arc-Grafikkarten zu finden sein werden wollte Intel aber noch nicht verraten. Battlemage wird aufgrund des inzwischen viel besseren Treibers einen deutlich einfacheren Einstieg haben, als dies bei der ersten Generation der Fall war. Wie sich Battlemage in Lunar Lake schlägt werden wir ab dem Spätsommer wissen. Ob Intel mit der zweiten Arc-Generation eine echte Konkurrenz zu AMD und NVIDIA sein kann, wird sich dann später zeigen müssen.

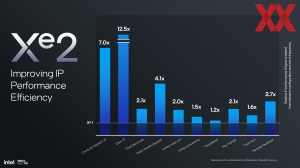

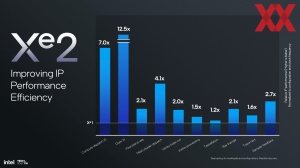

Für die Xe2-Architektur hat Intel fast sämtliche Aspekte einer Grafik-Architektur verbessert. Der grundsätzliche Aufbau der Xe2-Kerne und der GPU als Gesamtkonstrukt bleibt aber sehr ähnlich.

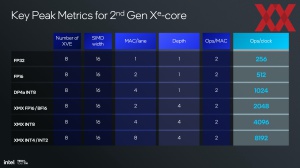

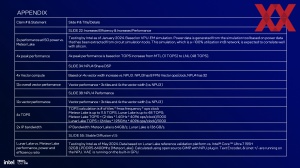

Jeder der Xe2-Kerne besitzt acht 512 Bit breite Vektoreinheiten, acht XMX-Einheiten für 2.048 Bit Matrix-Berechnungen und 192 kB an shared L1-Cache. Die ALUs können nun anstatt einer 8-Bit-Operation (SIMD8, Single instruction, multiple data) gleich SIMD16 ausführen, was die Effizienz erhöht. Zudem können auch SIMD32-Operationen ausgeführt werden.

Die XMX-Einheiten unterstützen die Datenformate INT2, INT4, INT8, FP16 und BF16. Auch FP64-Einheiten gibt es in der Xe2-GPU von Lunar Lake und anders als bei den diskreten GPUs der ersten Arc-Generation, wo man diese FP64-Einheiten weggelassen ist, ist davon auszugehen, dass diese in den diskreten Varianten von Battlemage vorhanden sein werden. Die komplette Vektor-Einheit kann gleichzeitig Fließkomma-, Integer- und XMX-Operationen ausführen. Die XMX-Einheiten sind zudem in der Lage 2.048 FP16-Operationen und 4.096 INT8-Operationen pro Takt auszuführen.

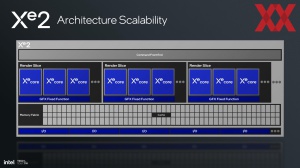

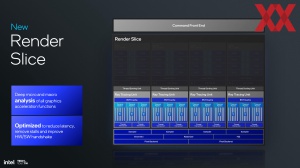

Organisiert sind die Xe2-GPUs wieder in Render Slices. In diesen sitzen dann auch wieder die weiteren Funktionsblöcke wie die Geometrie-, Rasterizer- und HiZ-Einheiten sowie das Pixel-Backend.

Die GPU besitzt einen eigenen L2-Cache, der größer als in der Xe-Architektur ist. Wie groß, dazu kommen wir dann später. Der größere Cache soll natürlich dabei helfen, dass möglichst viele Daten möglichst nahe der GPU gespeichert und von den Xe2-Kernen abgerufen werden können.

Der L2-Cache bzw. das Pixel Backend kann in diesem nun auch eine 8:N-Kompression durchführen, was den Platzbedarf von Daten in verlustfreier Qualität verbessern soll. Ein Fast Clear sorgt dafür, dass nicht mehr notwendige Daten nicht aufwändig durch Nullen überschrieben werden müssen, sondern Datensätze schneller aus dem L2-Cache entfernt werden können.

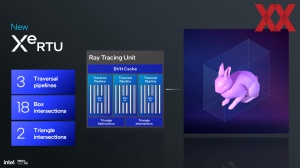

Neben den neuen Vektor- und XMX-Einheiten hat Intel auch die Raytracing-Beschleuniger verbessert. Jeder Xe2-Kern verfügt über einen dieser Beschleuniger. Diese verfügen nun über drei anstatt nur zwei Traversal Pipelines. Die Anzahl der "Box Intersection", also der Schnittpunkte die berechnet werden können, erhöht sich von 12 auf 18 – analog zur Erhöhung der Pipelines um 50 %. In den neuen Raytracing-Beschleunigern sind nun aber die Berechnung von zwei Triangle Intersections anstatt derer nur einer möglich. Die Leistung der Raytracing-Beschleuniger soll sich in etwa verdoppeln.

Xe2-Architektur in Lunar Lake

Soweit die Details zur Xe2-Architektur als grundsätzliche Neuauslegung dieser. Für die verschiedenen Umsetzungen wird es aber unterschiedliche Ausbaustufen dieser Xe2-Architektur geben.

Für Lunar Lake sieht Intel acht Xe2-Kerne vor. Daraus ergeben sich dementsprechend 64 Vektor-Einheiten, zwei Geometrie-Pipelines, acht Sampler, acht Raytracing-Beschleuniger und vier Pixel-Backends. Der L2-Cache wird mit einer Kapazität von 8 MB daherkommen. Bei Meteor Lake war dieser in der Xe-GPU nur 4 MB groß.

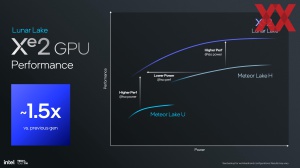

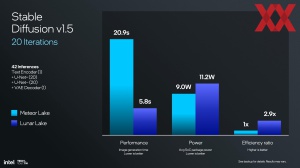

Bei gleicher Leistungsaufnahme geht Intel davon aus, dass die Xe2-GPU in Lunar Lake um etwa 50 % schneller ist, als die in Meteor Lake. Ob sich dies so bewahrheiten wird, werden am Ende der Benchmarks zeigen müssen.

Media- und Display-Engine

Zur GPU bzw. zur Ausgabe von grafischem Inhalt gehören auch die Media- und Display-Engine. Auch diese haben ein Update erhalten.

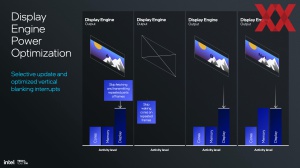

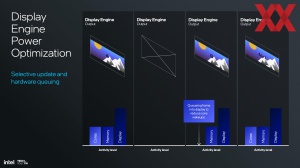

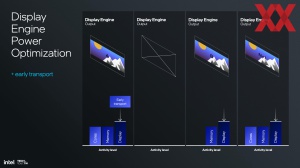

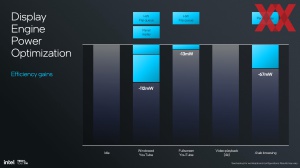

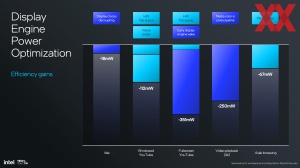

So kann die Display-Engine der Xe2-GPU in Lunar Lake über ihre drei Display-Pipes auch entsprechend viele und vor allem hochauflösende Displays ansprechen. Unterstützt werden bis zu 8K60 auf einem Display und dreimal 4K60 HDR. Neu ist der Embedded-Display-Standard eDP 1.5 mit Panel Refresh und Early Transport als neue Funktion.

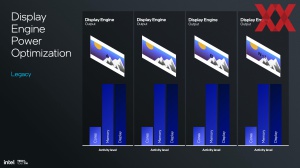

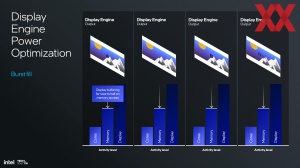

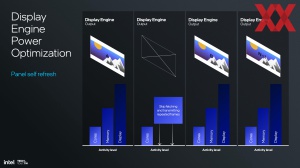

Early Transport setzt dabei auf Panel Self Refesh (PSR) auf. Dabei geht es darum, dass ein Display mit sagen wir 60 Hz nicht auch 60 neue Bilder darstellt und diese daher nicht immer wieder neu berechnet werden müssen. Um einen Frame darzustellen, arbeiten die Kerne, Speicher und die Display-Engine zusammen. Bei einem Frame, der per PSR nur aufgefrischt wird, ist es jedoch nicht zwangsläufig notwendig, dass all diese Komponenten arbeiten. Dies soll sich positiv auf die Akkulaufzeit auswirken.

Für Early Transport werden die Frames in Paketen und damit früher an das Panel geschickt, dieses speichert sie zwischen und gibt sie zu einem späteren Zeitpunkt aus. Auch finden die Berechnungen als in einem Schwung statt, um dann einen Großteil der beteiligten Komponenten weitestgehend abzuschalten. Es geht darum Strom zu sparen und auch wenn wir hier nur von wenigen hundert Milliwatt sprechen, so wirken sich diese auf Dauer natürlich auch auf die Akkulaufzeit aus.

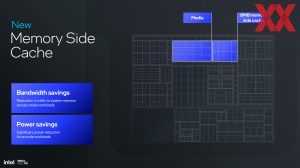

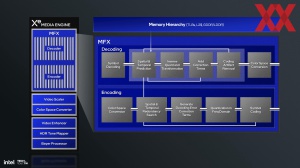

Die Media-Engine nutzt für ihre En- und Decoder unter anderem den neuen 8 MB großen Side Cache. Von der GPU selbst kann dieser zwar theoretisch auch genutzt werden, mit 8 MB bietet er aber keinen großen Vorteil gegenüber dem ohnehin schon 8 MB großen L2-Cache.

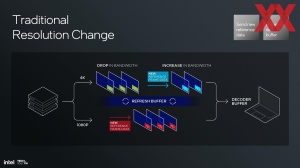

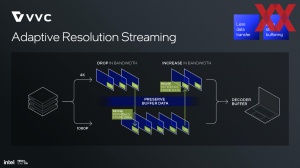

Die Media Engine der Xe2-GPU in Lunar Lake bietet ein Decoding mit bis zu 8K60 10 Bit HDR und ein Encoding mit bis zu 8K60 10 Bit HDR. Unterstützt werden die Codecs AVC, VP9, H.265, AV1 und nun neu auch H.266 bzw. VVC.

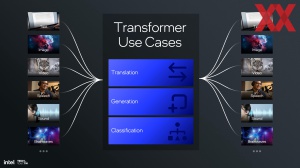

Die NPU soll wichtiger werden

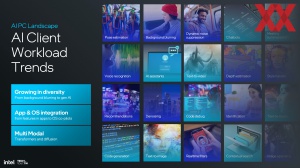

Die dritte der wohl wichtigsten Komponenten nach der CPU-Kernen und der GPU ist die NPU in Lunar Lake. NPUs sind keine neue Funktion in Chips, mit dem KI-Hype aber legen viele Hersteller einen größeren Wert darauf bzw. die KI-Leistung soll sich mehr auf die NPUs verschieben, um eine effiziente Ausführung von KI-Modellen, lokal auf dem eigenen Rechner, zu ermöglichen.

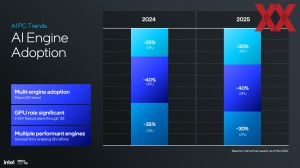

Aktuell geht Intel davon aus, dass rund 40 % der KI-Workloads auf der GPU ausgeführt werden und dies auch in etwa so bleiben wird. Der Anteil dessen, was auf den CPU-Kernen ausgeführt wird, soll in den nächsten fünf Jahren von 35 % auf 30 % zurückgehen. Dementsprechend wird der Anteil der NPU von 25 % auf 30 % steigen.

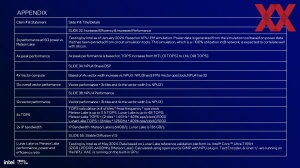

| Gesamtleistung | NPU | CPU | GPU | |

| Intel Lunar Lake | 120 TOPS | 48 TOPS | 5 TOPS | 67 TOPS |

| Intel Meteor Lake | 32,2 TOPS | 10,6 TOPS | 2,82 TOPS | 18,8 TOPS |

| Qualcomm Snapdragon X Elite | - | 45 TOPS | - | - |

| Ryzen-7040-Serie (Phoenix) | 33 TOPS | 10 TOPS | - | - |

| Ryzen-8040-Serie (Hawk Point) | 39 TOPS | 16 TOPS | - | - |

| Ryzen Next-Gen (Strix Point) | - | 39+ TOPS | - | - |

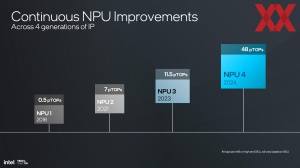

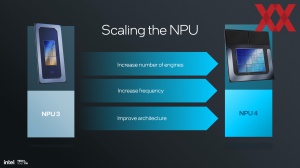

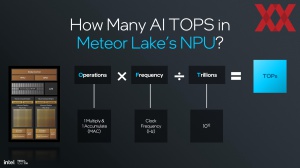

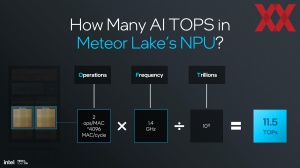

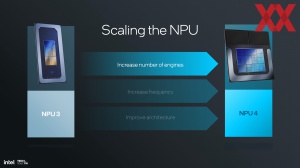

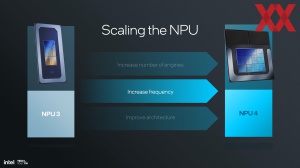

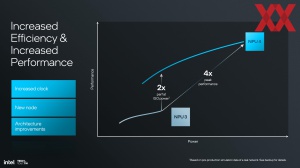

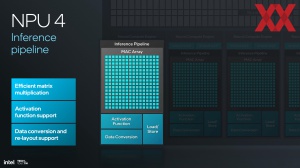

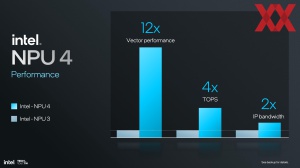

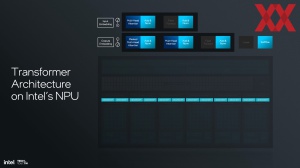

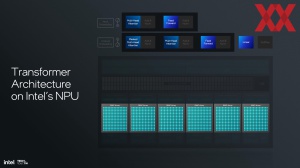

Die NPU 4 in Lunar Lake nimmt einen größere Teil des Chips ein. Die Leistung steigt von aktuell etwa 11 TOPS auf 48 TOPS an. Erreicht wird diese Leistungssteigerung vor allem durch mehr Funktionseinheiten in der NPU 4.

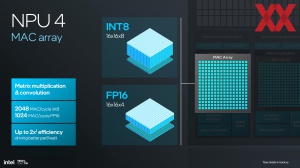

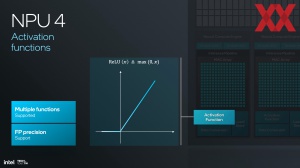

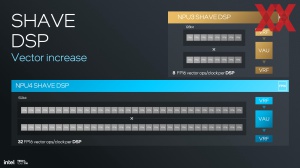

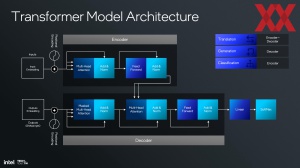

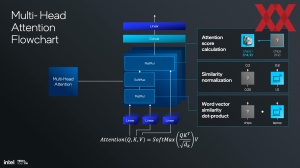

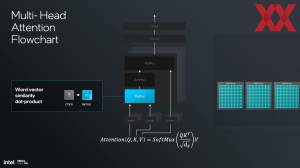

Aus zwei NCEs (Neural Compute Engines) mit jeweils 2.048 MAC-Arrays der NPU 3 werden nun sechs NCEs bei Lunar Lake, was zugleich auch bedeutet, dass wir nun insgesamt 12.288 MACs zur Verfügung haben. Hinzu kommen 12 SHAVE DSPs, was ebenfalls einer Verdreifachung entspricht. Die SHAVE DSPs sind für die Vektor-Berechnungen zuständig und genau wie bei den CPU- und GPU-Architekturen sind die KI-Workloads auch immer eine Mischung aus Vektor- und Matrix-Berechnungen, die sich entsprechend ausbalanciert in den Funktionseinheiten widerspiegeln sollten. Neben der höheren Anzahl an SHAVE DSPs haben diese zudem auch noch eine viermal höhere Vektor-Leistung.

Dies wird dadurch erreicht, dass die SHAVE DSPs von 128 auf 512 Bit verbreitert werden. Pro Taktzyklus können sie 32 Vektor-Operationen in FP16 ausführen – bisher waren es nur acht.

Die MAC-Arrays können 2.048 MACs/Taktzyklus in INT8 oder 1.024 MACs/Taktzyklus in FP16 ausführen. Damit sind sie nicht schneller als die MACs der NPU 3, aber mit allen weiteren Änderungen und in der Fertigung des Chips um den Faktor zwei effizienter.

Der dazugehörige Cache, den Intel als Scratchpad bezeichnet, wird von 4 auf 9 MB vergrößert. Mit den aktuellen KI-Modellen sieht Intel keinerlei Notwendigkeit das Scratchpad ebenfalls zu verdreifachen – mit 9 MB ist man aber auch nahe genug dran. Mittels einer neuen DMA-Engine wird die Bandbreite des Scratchpads verdoppelt.

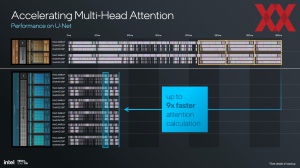

Von einer schnelleren NPU profitiert eine KI-Anwendung natürlich, sofern sie denn auch darauf ausgeführt wird. In den komplexen Berechnungen ist es Intel zudem noch gelungen die deutlich breitere NPU auch effizienter zu machen, indem man die einzelnen Berechnungen in den MACs und DSPs effizienter parallel ausführt.

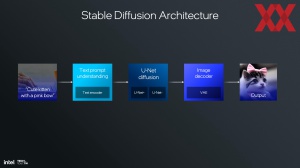

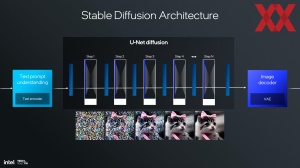

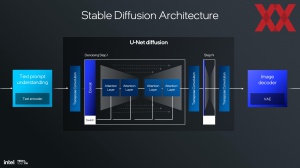

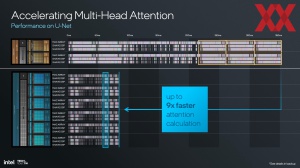

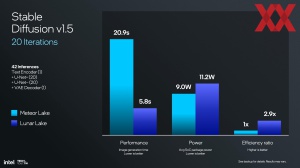

Nun kann man sich noch am Beispiel von Stable Diffusion anschauen, dass die Promt-Eingabe und Verarbeitung, sowie die Berechnung und Ausgabe auf vielerlei Beschleunigern läuft. Im Unterschied zu Meteor Lake kommt der NPU in Lunar Lake aber bereits eine höhere Bedeutung zu.

Schneller, aber nicht zwangsläufig sparsamer arbeiten CPU, GPU und NPU für solche KI-Anwendungen zusammen. Eine kurzzeitig höhere Leistungsaufnahme bei kürzerer Berechnungszeit bedeutet aber auch, dass der Gesamt-Energieaufwand geringer ist und Lunar Lake so am Ende auch sparsamer sein soll.