Werbung

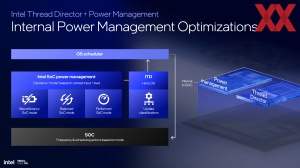

Mit dem ersten Performance-Hybrid-Designs führte Intel auch den Thread Director ein. Er soll sicherstellen, dass die Anwendungen auch immer auf den richtigen Kernen laufen und schnellstmöglich ausgeführt werden. Der Thread Director füttert den Scheduler des Betriebssystems mit den notwendigen Informationen. Der Thread Director selbst führt eine Klassifizierung der Anwendungen bzw. Threads durch, dessen Feedback Tabelle durch den Scheduler gelesen werden, um dann wiederum die Aufgaben auf die P- und E-Kerne zu verteilen.

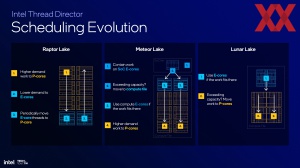

Für die Desktop-Prozessoren wie Raptor Lake findet diese Aufteilung wie folgt statt: Anspruchsvolle Aufgaben werden den P-Kernen zugeteilt, solche die weniger anspruchsvoll sind den E-Kernen.

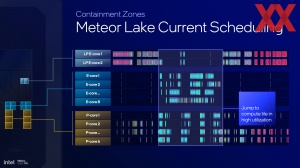

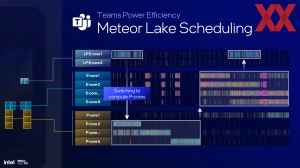

Um einen Prozessor wie Meteor Lake besonders effizient zu machen, müssen hier anderen Vorgaben zur Anwendung kommen. So werden alle Threads zunächst auf den LP E-Kernen ausgeführt und der Thread Director versucht diese auch so lange und gut es geht darauf zu belassen. In einem ersten Schritt werden sie dann vom SoC-Tile auf den Compute-Tile übergeben, wo sie auf den E-Kern-Clustern ausgeführt werden. Reicht auch dies nicht aus, geht es weiter zu den P-Kernen. Man kann sich an dieser Stelle aber sehr gut vorstellen, dass dies ein sehr ineffizienter Weg sein kann, wenn es um eine möglichst hohe Rechenleistung geht, wenn die Threads über drei Ebene weitergegeben werden müssen.

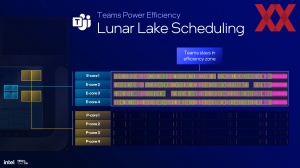

Für Lunar Lake werden die Threads ebenfalls direkt auf den E-Kernen platziert, falls diese ausreichend schnell sind. Ist dies nicht der Fall, werden sie an die P-Kerne übergeben.

Dies hat natürlich noch mehrere Stufen. So wird zunächst versucht nur einen E-Kern zu verwenden. Für eine höhere Multi-Threaded-Leistung werden dann mehr und mehr E-Kerne hinzugenommen. Reicht auch dies nicht mehr aus, geht es auf die P-Kerne.

Der Vorteil von Lunar Lake ist nun, dass sich die E- und P-Kerne auf einem Tile, dem Compute-Tile, befinden. Dies ist zwar auch bei Meteor Lake der Fall, hier werden aber zunächst die LP E-Kerne bevorzugt, was häufig einen Wechsel auf den E-Kerne im Compute-Tile zur Folge hat und schlicht weniger effizient sein kann.

Zudem verfolgt der Thread Director in Lunar Lake ein Containment auf den E-Kernen – so lange dies eben möglich ist. Damit möchte Intel die Effizienz der gesamten Plattform verbessern. Die hohe Leistung der neuen E-Kerne aber soll gleichzeitig dafür sorgen, dass wir hier keinerlei Leistungseinbußen sehen.

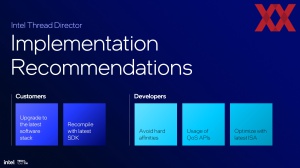

Verbesserte Algorithmen und ein feingranulares Handling der Workloads sollen neben der neuen Priorisierung dafür sorgen, dass der Thread Director in Lunar Lake die Threads schneller und effizienter auf die Kerne aufteilt.

Einfacheres Design und weniger Overhead

Mit Meteor Lake sollte das desintegrierte Design die große Stärke sein. Compute-, GPU-, I/O- und SoC-Tile sollten möglichst effizient miteinander arbeiten und die Tatsache, dass der SoC-Tile viele Aufgaben ohne die restlichen Komponenten erledigen kann, für eine hohe Effizienz des Designs sorgen. So ganz ausgezahlt hat sich dies jedoch nicht. Die Leistung der Kerne bot keinerlei Verbesserung und das komplexe Design sorgt eher für einen gegenteiligen Effekt: Zu viel Overhead und damit zu viel Aufwand für das System einen möglichst idealen Betriebsstatus zu erreichen.

Mit Lunar Lake soll dies nun anders sein und es hat auch einen guten Grund, warum Intel nur noch zwei Tiles einsetzt: Der geringere Aufwand in der Übertragung von Daten zwischen den Tiles macht das Design schneller und effektiver. Wann immer Daten zwischen den Tiles in Meteor Lake ausgetauscht werden müssen, bedeutet dies eine Verzögerung. Mit den CPU-Kernen, der GPU und der NPU auf dem Compute-Tile soll Lunar Lake dieses Problem nicht mehr haben.