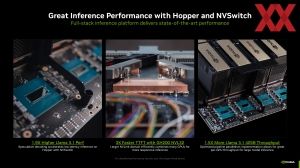

Die MLCommons hat heute die Trainings-Ergebnisse in der aktuellsten Version vorgestellt und diese beinhalten erstmals NVIDIAs B200-Beschleungier sowie den Google TPUv6p Trillium. Mit den Inference-4.1-Ergebnissen feierten sowohl der B200 als auch der TPUv6e ihre Prämiere. An das Inferencing werden jedoch andere Herausforderungen gestellt, als dies beim Training der Fall ist. Die Blackwell-GPU wurde von NVIDIA zunächst mit dem Fokus auf das Inferencing vorgestellt. Aber natürlich soll auch das Training eine wichtige Rolle spielen.

Während wir für das Inferencing in der Version 4.1 erstmals Ergebnisse der Instinct MI300X gesehen haben, fehlen diese in den Trainings-Ergebnissen. Dominiert werden die Benchmarks demnach von NVIDIA und Google, die für das Training auch riesige Cluster zum Einsatz bringen. Für den TPUv5 wären dies beispielsweise 1.024 Pods mit insgesamt 4.096 Beschleunigern. Bei NVIDIA sprechen wir sogar vom EOS-Supercomputer mit 1.452 Knoten und 11.616 H100-Beschleunigern.

Für die Preview der TPUv6p alias Trillium geht Google schon soweit, dass hier 768 Pods mit 3.072 Beschleunigern zusammenarbeiten. NVIDIA hingegen setzt immerhin schon auf acht Knoten des neuen Nyx-Supercomputers mit demnach 64 Blackwell-Beschleunigern.

Llama2 70B Lora

NVIDIA NeMO

Werbung

Stable Diffusion

NVIDIA NeMO, Google MaxDiffusion

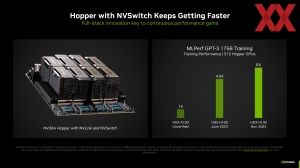

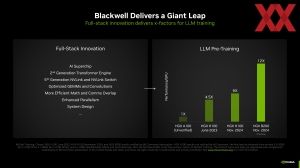

Während der Leistungsunterschied zwischen dem H100- und H200-Beschleuniger für das Teil-Training von Llama 2 mit 70 Milliarden Parametern nur recht gering ist, erledigen die acht B200-Beschleuniger dies in fast der Hälfte der Zeit. Für Stable Diffusion lieferte Google eigene Ergebnisse zum TPUv5p, NVIDIA hat hier klar die Nase vorne.

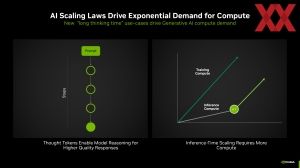

Weiterentwicklungen gab es nicht nur bei der Hardware, sondern auch der Software. Vor allem mit Blackwell will NVIDIA noch einmal einige Verbesserungen im Zusammenspiel aus der Hard- und Software erreicht haben, die sich aber erst zeigen werden, wenn die Hardware in größeren Stückzahlen im Feld verwendet wird. Von den vorherigen Beschleuniger-Generationen kennen wir diese Entwicklung bereits. Teilweise konnte allein durch Software-Optimierung die Leistung der Hardware um 30 % und mehr gesteigert werden.

GPT3

NVIDIA NeMO, Google MaxDiffusion

Die Ergebnisse für die TPUv6p sind sicherlich zunächst einmal im Hinblick auf die Skalierung zu sehen und diese funktioniert in Googles Infrastruktur offenbar recht gut. Was die Gesamtleistung betrifft, ist ein kompletter EOS-Supercomputer mit 11.000 Beschleunigern natürlich schneller. Die Frage ist aber, wie viel Energie musste für das Training aufgewendet werden. Die Ergebnisse der TPUv5p zeigen, dass Google hier noch einiges an Potential zur weiteren Optimierung hat.

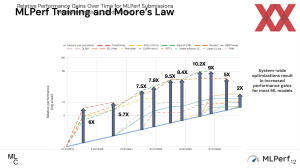

Die Leistung der AI-Systeme verlangsamt sich

Anhand der Zahlen der vorherigen Trainings-Ergebnisse zeigen die neuen Zahlen aber auch einen Trend: Zwar liegt die Weiterentwicklung der Leistung noch über dem des Moorschen Gesetzes, die Entwicklung verlangsamt sich allerdings.

Ein Grund hierfür ist allerdings, dass die Modelle immer größer und komplexer werden. Die Hardware kann hier nicht mithalten, auch wenn mit 80 GB, 141 GB, 180 GB und ab nächsten Jahr 288 GB Speicher pro Beschleuniger dieser stetig weiter wächst. Llama 3.1 besitzt inzwischen bis zu 405 Milliarden Parameter und größere Modelle werden für kommendes Jahr erwartet.

Die aktuellen Ergebnisse für MLPerf Training 4.1 findet ihr direkt bei der MLCommons.

NVIDIA enthüllt neuen KI-Supercomputer

Für eine erste Einreichung an Benchmarks mit B200-Beschleuniger verwendete NVIDIA zumeist noch DGX-B200-Systeme, aktuell befindet sich aber auch der Nyx-Supercomputer als Nachfolger von EOS im Aufbau, der aus DGX-B200-Systemen besteht. Eingereicht wurde unter anderem ein Ergebnis mit acht Knoten und demnach 64 B200-Beschleunigern.

Zum geplanten Ausbau des Nyx-Supercomputer machte NVIDIA keinerlei Angaben. EOS kommt auf 1.452 Knoten mit insgesamt 11.616 Beschleunigern. Ob NVIDIA einen ähnlich großen Ausbau plant, ist nicht bekannt.