Werbung

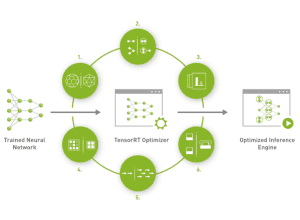

Neben der Unterstützung für RTX Video Super Resolution auf Karten der GeForce-RTX-20-Serie präsentiert NVIDIA heute die Programmbibliothek TensorRT-LLM für Windows. TensorRT-LLM ist eine speziell auf Large Language Models angepasste Open-Source-Bibliothek, die für Datacenter-Beschleuniger bereits vorgestellt wurde und als Early Access zur Verfügung steht. Mit TensorRT-LLM zeigt sich einmal mehr, dass eine Weiterentwicklung und Optimierung der Software einen mindestens ebenso großen Effekt auf die Leistung solcher Modelle haben kann, wie neue Hardware.

Mit TensorRT-LLM für Windows können nun auch Nutzer unter Windows und mit Endkunden-Hardware (GeForce-RTX-Karten) davon profitieren. Ein lokales Inferencing eines LLMs soll mit TensorRT-LLM um den Faktor vier schneller ablaufen, als dies ohne diese Programmbibliothek der Fall ist.

Einen Vorteil in der Leistung bietet TensorRT-LLM zudem im Falle einer lokalen Erweiterung der Trainingsdaten. LLMs sind anfällig, wenn sie Fragen beantworten oder Aufgaben bearbeiten sollen, die sich eigentlich gar nicht kennen oder dessen Umfang sie nicht leisten können. Dann tendieren LLMs dazu, zu halluzinieren – sie erfinden schlichtweg eine Antwort, die auf falschen Daten basiert. Per Retrieval-Augmented Generation (RAG) können dem Netzwerk lokale Vektor-Daten oder eine ganze Datenbank vorgegeben werden, aus denen eine Antwort generiert werden soll. Auch dies wird durch TensorRT-LLM beschleunigt.

TensorRT-LLM für Windows soll in Kürze auf der Developer-Webseite bei NVIDIA verfügbar sein. Entsprechend optimierte Open-Source-Modelle sowie eine RAG-Demo werden auf ngc.nvidia.com und github.com/nvidia angeboten.

TensorRT-LLM für Windows und Stable Diffusion

TensorRT-LLM für Windows beschleunigt zudem das Ausführen von lokalen Stable-Diffusion-Instanzen. Wo selbst eine GeForce RTX 4090 je nach Bildgröße und Größe des Modells von mehreren Sekunden bis Minuten rechnet, soll die TensorRT-LLM-Bibliothek dies deutlich beschleunigen können. Laut NVIDIA ist man in der Lage, die Bilder im Faktor sieben schneller zu erstellen, als dies ein Mac mit M2 Ultra kann.