Werbung

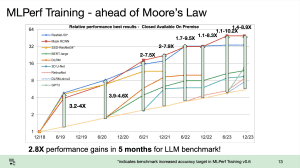

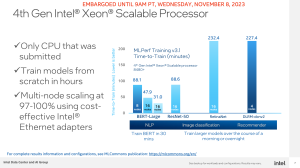

Die MLCommons hat eine weitere Runde Ergebnisse im Bereich Datacenter-Training und HPC vorgestellt. Interessant sind dabei die Trainings-Ergebnisse, denn hier taucht einiges an Hardware erstmals auf bzw. skaliert mit deutlich mehr Beschleunigern, als dies bei den bisherigen Ergebnissen der Fall war.

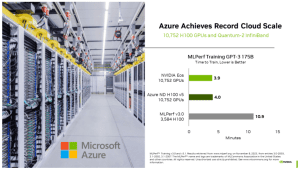

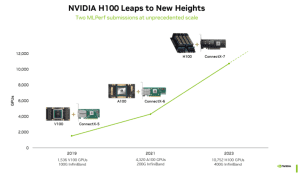

NVIDIA und Azure präsentieren Ergebnisse mit 1.344 Knoten. In seiner Cloud-Instanz setzt Azure dazu pro Knoten auf jeweils zwei Intel Xeon Platinum 8480C mit jeweils 56 Kernen sowie acht H100-Beschleuniger. Insgesamt kommen hier also 10.752 H100-Beschleuniger zum Einsatz. Ebenso aufgebaut ist die maximale Ausbaustufe des EOS-Supercomputers von NVIDIA, wenngleich hier mit den Xeon Platinum 8462Y andere Host-Prozessoren mit 32 Kernen zum Einsatz kommen. Aber auch hier waren 1.344 Knoten und damit insgesamt 10.752 H100-Beschleunigern im Einsatz. Damit können NVIDIA und Azure ihre Systeme fast um den Faktor drei größer skalieren, als dies bisher der Fall war.

Bei diesen riesigen Systemen rücken das Netzwerk und der Interconnect in den Fokus. Laut NVIDIA kommt für EOS eine Fat Tree Topologie zum Einsatz. Dies vereinfacht das Netzwerk in gewisser Weise, da hier mehrere Ebenen in einer Baum-Struktur miteinander verbunden sind. Die tieferliegenden Ebenen sind aber nicht direkt miteinander verbunden.

Mit 10.752 H100-Beschleunigern erreicht NVIDIA eine positiv zu bewertende Leistungssteigerung, die innerhalb der erwarteten Skalierung liegt. Die dreifache Anzahl an Beschleunigern erbringt die dreifache Leistung bzw. die Zeit für das Training großer KI-Netzwerke wird um zwei Drittel reduziert. Durch die enorme Skalierung der Systeme von NVIDIA wird die Time-to-Train also massiv reduziert.

Erstmals reicht auch Google Ergebnisse der TPU-v5e ein. Ein Cluster bestehend aus 4.096 TPUs kam hier zum Einsatz. Ebenfalls erstmals vorzufinden sind Ergebnisse für die NVIDIA L40S.

Bei Google fallen die Ergebnisse auch so gut aus, weil es eine weitere Optimierung bei der Software gegeben hat, die im übrigen auch bei NVIDIA einen gewissen Effekt hat, wo es auch immer wieder Verbesserungen gibt. Google verwendet in sieben von acht Layern (den Gradient Layern) des Trainings-Prozesses nun INT8 und nicht wie bisher BFloat16. Durch die Reduzierung in der Komplexität des Datenformats wird der Durchsatz erhöht.

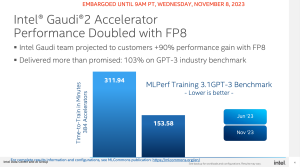

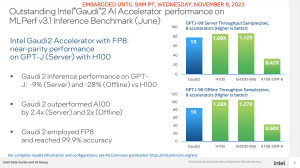

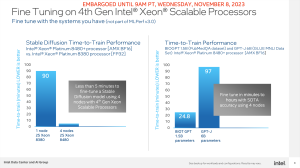

Eine ähnliche Maßnahme gab es auch bei Intel. Hier wird nun bei den Gaudi2-Beschleunigern mit FP8 gerechnet und im Vergleich zu den vorherigen Ergebnissen kann Intel die Benchmarks um den Faktor zwei schneller ausführen. Damit rückt man auch näher an den Konkurrenten NVIDIA heran, wenngleich der KI-Gigant noch immer einen gewaltigen Vorsprung hat. Das Preis/Leistungsverhältnis verschiebt sich aber in Richtung Intel.

NVIDIA ist und bleibt für viele Datacenter-Anwendungen das Maß der Dinge. Aber wie immer muss man genau hinschauen und je nach Anwendung unterscheiden. KI-Anwendungen sind sicherlich eine Domäne von NVIDIA, die große Kapazitäten bei TSMC für die Fertigung und das Packaging belegen. Die Preise sind wegen der großen Nachfrage weiterhin hoch. Hier kommt dann Intel ins Spiel, die mit den Gaudi2-Beschleunigern eine preisliche Alternative darstellen.