Hallo,

also ich habe den Kontroller auf dem MSI 975 PowerUP Editition Board nicht zum laufen bekommen, der Adaptec Support hat nur gemeint man solle das neueste Bios für Board und Kontroller verwenden, das hatte ich aber schon, und mich dann an MSI verwiesen.

Mitterweile habe ich Board CPU und RAM gewechselt und ein neues Problem.

Board ist jetzt ein MSI P54D3 Platinum mit 2x2GB Corsair, und einem Q9550 Prozessor.

Im Spiel TF2 habe ich jetzt plözlich Ruckler, alle paar Sekunden und immer dann wenn ein neuer Sound der vorher noch nicht gespielt wurde auftaucht, wie z.B. nachladen... dann Freezed das Bild ca. 0,5-1 sec. und der Sound looped. Als Soundkarte habe ich diese SB X-Fi.

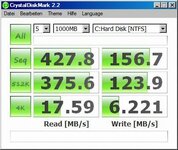

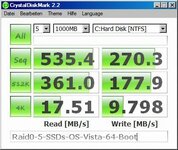

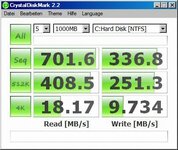

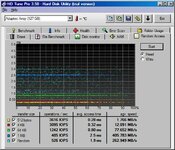

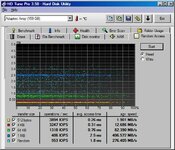

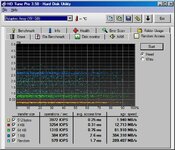

Das seltsame ist auf den Screenshot. Wenn ich die X-Fi im Gerätemanager deaktiviere habe ich ca. doppelt so schnelle Zugriffszeiten auf dem RAID. Ist ein Raid 5 mit 5x WD 1TB Green + Hot standby.

Auf den Raid ist auch das BS aber es ist nicht so das die X-Fi eine Plattenlast erzeugt. Bei dem Test ist keine Musik gelaufen o.ä.

Mir ist dann aufgefallen das die Soundkarte, Raidcontroller und Grafikkarten den IRQ 16 belegen, ich habe dann durch rumprobieren die X-Fi auf IRQ 17 bekommen was aber keinen Unterschied macht.

Mir kommt das schon etwas komisch vor.

Vielleicht hat jemand einen Tipp.

viele Grüße

Andy

also ich habe den Kontroller auf dem MSI 975 PowerUP Editition Board nicht zum laufen bekommen, der Adaptec Support hat nur gemeint man solle das neueste Bios für Board und Kontroller verwenden, das hatte ich aber schon, und mich dann an MSI verwiesen.

Mitterweile habe ich Board CPU und RAM gewechselt und ein neues Problem.

Board ist jetzt ein MSI P54D3 Platinum mit 2x2GB Corsair, und einem Q9550 Prozessor.

Im Spiel TF2 habe ich jetzt plözlich Ruckler, alle paar Sekunden und immer dann wenn ein neuer Sound der vorher noch nicht gespielt wurde auftaucht, wie z.B. nachladen... dann Freezed das Bild ca. 0,5-1 sec. und der Sound looped. Als Soundkarte habe ich diese SB X-Fi.

Das seltsame ist auf den Screenshot. Wenn ich die X-Fi im Gerätemanager deaktiviere habe ich ca. doppelt so schnelle Zugriffszeiten auf dem RAID. Ist ein Raid 5 mit 5x WD 1TB Green + Hot standby.

Auf den Raid ist auch das BS aber es ist nicht so das die X-Fi eine Plattenlast erzeugt. Bei dem Test ist keine Musik gelaufen o.ä.

Mir ist dann aufgefallen das die Soundkarte, Raidcontroller und Grafikkarten den IRQ 16 belegen, ich habe dann durch rumprobieren die X-Fi auf IRQ 17 bekommen was aber keinen Unterschied macht.

Mir kommt das schon etwas komisch vor.

Vielleicht hat jemand einen Tipp.

viele Grüße

Andy