Ich finde einfach das Beispiel schlecht, da nicht ersichtlich ist, ob die Skalierung vom Teiber oder der GameWorks Bibliotheken kommt.

Wie willst du das außeinander halten? Wenn man es außeinanderhalten wollen würde, müsste man synthetischen Workload testen, wo man die Bibliotheken wechselweise an und ausknipsen kann. Und das ganze noch mit verschiedenen Treibern. Gibts sowas? Ich glaube nicht...

Ansonsten, es gibt bspw. auch MP BF4 Benches, zwischen AMD DX und NV DX. Das war als die Leute anfingen die Mantle Ergebnise zu "glauben" und die Prophezeitung mit dem NV "Wundertreiber" gegenprüfen wollten -> Ergebnis identisch. Da hatte sontin seinerzeit im GPU Unterforum mal nen Link gepostet. Ich glaube das war pcper.com. Sprich das AMD DX skaliert bei fixen CPUs flacher als das von NV.

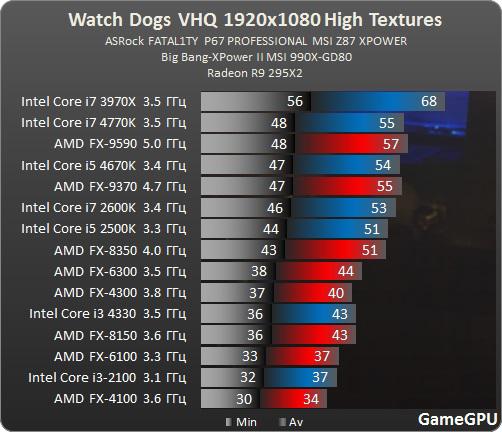

Sind halt alles nur Momentaufnahmen, kann sich mit dem nächsten Patch oder nächsten Treiber wieder völlig anders verhalten. Dennoch ist die Tendenz an den Bildern klar ersichtlich... Von irgendwelchen Benachteiligungen sehe ich da nix. Auch gelten die AMD CPUs nicht umsonst in Sachen Spieleperformance nicht zu den "Rennern", was absolute Performance angeht. Wieso sollte das hier auf einmal anders ausschauen?

Ich seh irgendwie weder AMD noch NVIDIA in der Breite skalieren, da ansonsten sich der fx 8150 vom fx 6300 hätte absetzen müssen. Die restliche Skalierung der CPUs finde ich auch durchaus schlüssig, wenn man sich diese nur Herstellerintern anschaut.

?? Was siehst du da nicht skalieren? Klar zu erkennen ist, das bspw. SMT bei NV skaliert, wärend es bei AMD nicht skaliert. (~10%...). Ebenso ist klar erkennbar, das die NV GPUs bei schnelleren CPUs deutlich mehr Performance rauskloppen als die gleichen CPUs mit einem AMD GPU Gespann. Oder anders ausgedrückt, das AMD GPU Gespann benötigt mehr CPU Performance um auf "Touren" zu kommen.

Und der 8150 ist alte Technik (Bulldozer), der 6300 ist Vishera. Man schaue auf den Vorsprung von 8150 zu 8350, was durchaus viel ist für gleiche "Bedinungen". Teilweise 20%...

Und wenn du auf FX6 auf FX8 Skalierung anspielst -> das sind gerade mal 33% mehr Einheiten verbaut. Der Hexacore Intel skaliert bei 50% theoretischer Performance ebenso alles andere als Perfekt. Interessant wäre mal ein gegentest mit nem 8 Kern Intel. Sprich Xeon E5-2687w. Könnte bspw. auch daran liegen, das die Threadzahlen 3, 6 und 12 teilweise etwas aus der Skalierungsreihe fallen...

Der Skalierungs Unterschied (nv vs AMD) kann somit auch am Frame Pacing liegen, das Standard mäßig im Catalyst Treiber aktiviert ist.

Und ein I7-4770k wird sich im CPU Limit niemals so weit von einem FX-9590 entfernen können, da werden wohl wieder nicht alle Ressourcen (Kerne) genutzt.

Es ist völlig wurscht wie viele Cores da genutzt werden. Mein Argument zielt einzig darauf an, das die Skalierung des Treibers über den CPU Speed bei AMD zu NV völlig anders ausschauen kann.

Was die Treiber angeht, wurde beim Test oben mit den jeweils neuesten Treibern getestet