E

EchseDino

Guest

Deine Karte schafft 12500 Punkte bei 1080 mV? Jetzt bin ich traurig. Aber zumindest die Temperaturen scheinen ähnlich zu sein, da mach ich mir keine Sorgen. Wie groß ist denn bei dir der Unterschied zwischen der GPU Temperatur und dem Hotspot? Im Standartprofil sind es bei mir immer um die 21°C.Hab es bei mir jetzt nochmal bei warmen Temps Timespy probiert.

Standardprofil 102°C Hotspot knapp unter 12000 Punkte

Mein OCUV - 100mV + 5%PL 98°C Hotspot Setup knapp 12500

Mein UV Setup - 120mV +5%PL 92°C Hotspot genau 12000 Punkte

Schon echt krass, wenn die chipgüte so variiert bei der 6700XT

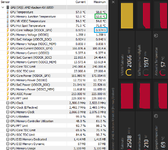

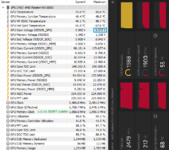

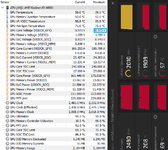

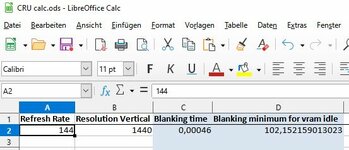

Interessant, zumindest das Problem scheint die 6700 XT nicht zu haben. Die schluckt bei 1440p 144Hz 7W.1. Warum schluckt meine Karte im Idle ca. 30 Watt? Laut ersten Recherchen im Internet immer noch ein Problem was AMD nicht in den Griff bekommt oder sollte das ein Treiber schon gelöst haben? VRam Takt liegt immer voll an und dadurch wird die Karte unnötig warm. 🙄 (UWQHD 144hz)