HWL News Bot

News

Thread Starter

- Mitglied seit

- 06.03.2017

- Beiträge

- 113.964

... weiterlesen

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Und NVidia hat jetzt mit IceLake genau was zu tun?

Dann kommt man das nächste sinnvolle Upgrade (IL + ggf. Ampera) wohl erst 2019...

Schon hart wenn Nvidia 3 Jahre lang mit der gleichen GPU Architektur an der Spitze bleiben kann...

Ja irgendwie ist es seit ner ganzen Weile recht langweilig. Muss man fast hoffen das AMD mit ihren Nachfolgern im CPU und GPU Bereich richtig punkten und so Intel bzw nVidia dazu zwingen ihre Produkte schneller auf den Markt zu bringen. So wirklich glauben kann ich daran zwar nicht nach den letzten Jahren, jedoch erkennt man daran das die Dominanz der letzten Jahre schlecht für alle Consumer ist.

IL verschiebt sich von 2018 auf 2019 und der erwartete Pascal Nachfolger erscheint nun vermutlich auch nicht mehr 2018 sondern 2019.

Dauert halt alles länger als zunächst angenommen.

.

.Das interessante ist ja, das die meisten hier im Forum seit Jahren meist Intel & Nvidia Konsumenten sind, und es eigentlich besser wissen müssten.

Wegen ein paar % Mehrleistung die jeder wollte, haben wir heute den Salat. (Ist kein Angriff, nur Feststellung)

Dazu kommt dass der 0815 Michel der keine Ahnung von Hardware hat, auch meist zu diesen 2 Marken greift.

Einen Bulldozer im Jahre 2012-2016 zu kaufen war natürlich nur selten sinnvoll.

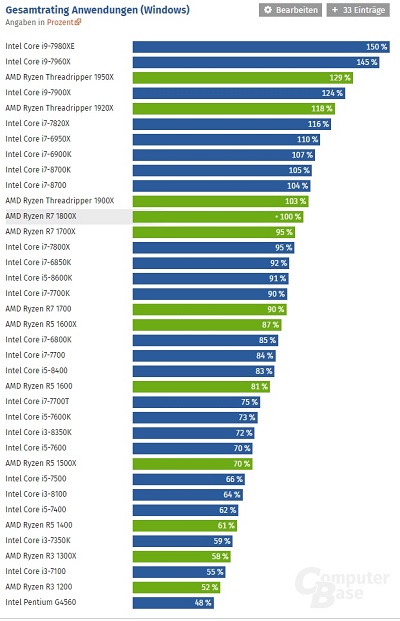

Doch jetzt gibt es ja Zen, seien wir mal ehrlich. Ein Zen reicht für die große Mehrheit der User mehr als aus und hat AMD Typisch das gute P/L.

Wegen ein paar % Mehrleistung extra viel bezahlen und das Reiche Unternehmen Supporten ?

Aber damals war es echt was anderes und sehr auffällig, die A64 CPUs waren in den meisten Fällen klar besser und meist günstiger und dennoch gab es in MM/Saturn nicht einen AMD Rechner...Hi Mastergamer. Intel hat nicht vor 15 Jahren zuletzt Unsinn gemacht. Die haben schon wieder das Kartell im Nacken.

.

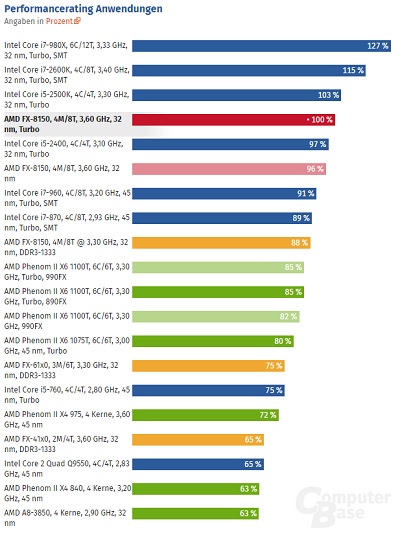

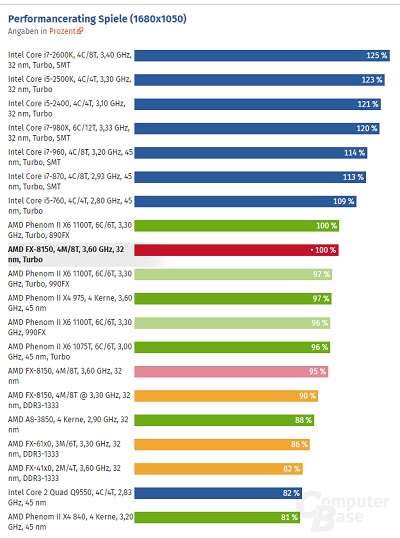

Der Bulli war "damals" eine schlechte Weiterentwicklung der Phenoms. Mehr nicht. Schau' dir doch mal die Passmarks an:der bulli reichte damals für die mehrheit der user auch aus und war günstiger als die konkurenz, was genau macht ryzen denn heute eigentlich so viel besser?

nicht falsch verstehen, der ryzen 1600 und 1700 sind mit etwas übertaktung gute cpus mit nem guten p/l-verhältnis,

finde es nur interessant das der bulli so verpöhnt und ryzen so in den himmel gelobt wird^^

AMDs Modul-Konzept ging nicht auf. Und die Leistung lag Lichtjahre hinter Intel zurück. Man brauchte die Brechstange in Takt und Stromverbrauch, um auf -4- Modulen mit Intel mitzuhalten. Also quasi doppelter Verbrauch bei gleicher Leistung.

Ryzen ist da ein Quantensprung. AMD ist mit einem Sprung etwa auf dem Niveau von Haswell gelandet - aber auf acht Töpfen.

Und wenn es Ryzen nicht gäbe, hätten wir bei Intel den 6-Kerner erst 2018 gesehen. Oder vielleicht noch später. Bei Intel weiß man ja nie.

Tatsächlich weiß ich gar nicht, wieso alle auf den FX CPUs rumhacken. Die sind seit 2012 Leistungsmäßig für fast alles außreichend, ich spiele mit einem FX8350 auf 4,6GHZ immernoch in 4K.

Eventuell gibt es ja 2018 einen Anreiz aufzurüsten, vielleicht ja mal wieder ins blaue Lager.

, wieso hast du dir aber für diese Auflösung eine 56er geholt?

, wieso hast du dir aber für diese Auflösung eine 56er geholt?

Mit Coffee Lake hat Intel vor einigen Monaten seine aktuellen Prozessoren-Generation für den Desktop ins Rennen geschickt.

vor einigen Monaten

MONATEN!!

Und man kriegt immer noch keine verdammten CPUs zu den damals beworbenen Preisen!

@sTOrM41

Auf was hast du deinen 8700 non K getaket?

Dies widerspricht der News wonach die Fertigung Ende 2018 beginnen soll und schon im August schrieb Anandtech:Realistisch ist 10nm++ erst Mitte 2019 frühestens möglich für desktop

Abwarten, in der News steht:Und nebenbei die ipc bleibt identisch zu cfl kaby lake und skylake

Die Unterscheidung zwischen Architektur und Fertigungsprozess scheint in den letzten Jahren aber verloren gegangen zu sein und die Codename stehen scheinbar nur noch für die Fertigungsprozesse.Intel wird der nächsten Generation allerdings auch eine neue Architektur spendieren.

Und jetzt schauen wir mal ganz genau hin.ist das so.. na schaun wir mal genau hin

?

? ?).

?).

Aber was sehen wir am Ende!?

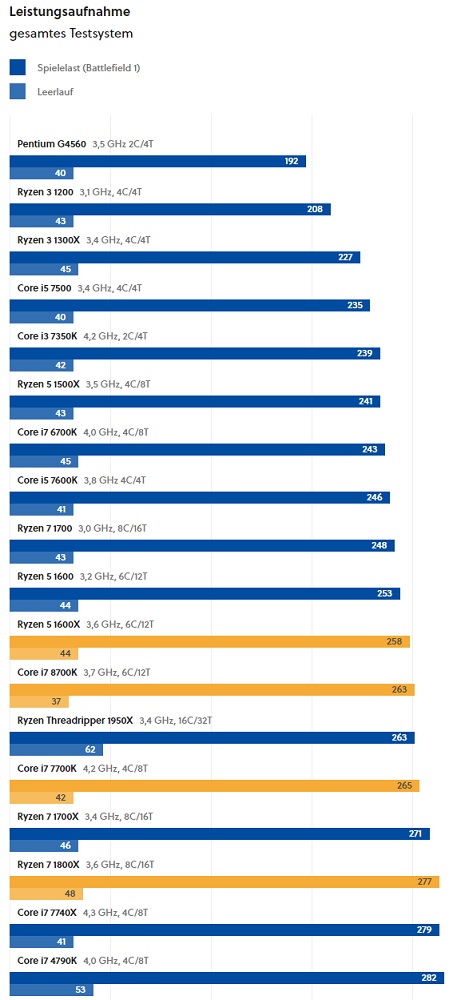

ich hab grade den stromverbrauch im verlinkten video entdeckt, schade das der mensch es nicht für nötig hält anzugeben wie da überhaupt gemessen wurde und auch nicht mit welchen spannungen.

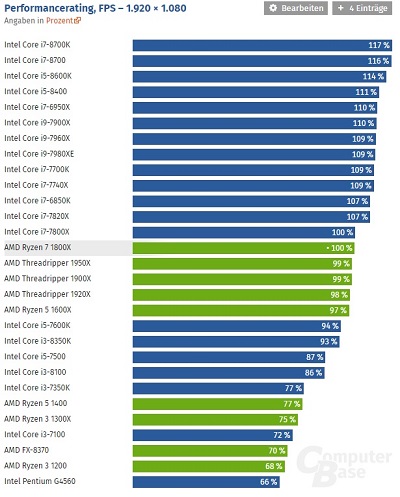

Wobei 135W schon recht hoch ist. Man nehme ein Z370 Board, daß durch Multi Core Enhancement, Auto Core Voltage und Auto Loadline Calibration unter Last 6x 4,7Ghz bei 1,40V draufballert

und Spiele wie BF1 oder AC Origins die alle 6 Kerne auslasten. Vermutlich wird die 150W Marke geknackt. Leider fehlen solche Messungen um aufzuzeigen wie schlecht 14nm++ tatsächlich ist !

Nicht FF sondern nm, aber egal. Außerdem steht doch in der News:Intel selbst gibt erst für 10FF++ Leistungssteigerungen ggü. 14FF++ aus, also muss Icelake 10FF++ sein in Wirklichkeit.

Wenn diese neue Architektur auch mehr IPC bedeutet, dann wird wie damals beim Wechsel vom 4790K zum 6700K mehr Leistung erreicht, obwohl der Takt geringer ausfällt. Die Leistung der Transistoren ist ja nicht gleichbedeutend mit der Leistung der CPU, diese hängt von deren Verschaltung ab und damit der Architektur der CPU!Intel wird der nächsten Generation allerdings auch eine neue Architektur spendieren. Damit soll die Leistung und auch Effizienz nach oben geschraubt werden.

Doch auch er dürfte dies wissen, aber es wäre natürlich seinem Ziel gegen Intel zu stänkern abträglich, wenn er dies auch berücksichtigen würdeDass dir offenbar nicht bekannt ist, wie sinnfrei es ist, AVX Volllast im Verbrauchsrating ggü. non AVX Last im Anwendungsrating zu stellen!?

Was auch bedeuten dürfte, dass der AVX Offset nicht aktiv war, wie es viele UEFIs im Default handhaben dürften. Bei intensiver AVX Last ist aber bei den großen Xeons schon seit Haswell und im Mainstream seit Kaby Lake eine Absenkung des Taktes, eben der AVX Offeset! Nur dürften die Boardhersteller dies im Mainstream eher selten umsetzen, da viele Übertakter davon immer noch nichts wissen und sich wundern würde wenn dann beim Stabilitätstest mit Prim eine geringere Taktfrequenz anliegt als sie erwarten. Da würden dann wohl das Board als nicht für Übertaktung geeigneten Schrott brandmarken und dies möchte offenbar kein Boardhersteller riskieren, dann sollen sie lieber die CPUs als stromhungrige Hitzköpfe bezeichnenCB bescheingt dem Cinebench Run mit vollem 4,3GHz Allcore Turbo gerade mal um die 135W Gesamtsystemverbrauch beim 8700k. Prime95 fast 180W.

RYZEN hat ja auch keine großen AVX Einheiten, die sind nur 128 Bit breit und deren Nutzung erzeugt daher keine hohe Leistungsaufnahme wie es bei aktuellen Intel CPUs der Fall ist. Daher kann man dort auch auf einen AVX Offset verzichten, wie Intel damals auch darauf verzichtet hatte, also deren CPUs auch keine größeren AVX Einheiten hatten. Deshalb nimmt fortunes ja auch die Leistungsaufnahme bei Prime, denn es wird ja in aller Regel nicht die Performance bei Prime mit angegeben und so fällt dann gar nicht auf wie lahm der RYZEN dabei im Vergleich zu den Intel CPUs mit fetten AVX Einheiten ist.Die 160W beim 1800X decken sich hingegen 1:1 mit einer "Normallast" Anwendung.

Schaut bitte künftig bei Reviews immer auch auf den CPU Takt und gebt den mit an, sonst sind die Angaben leider recht wertlos. Die Boards verhalten sich auch in der Default Einstellung oft unterschiedlich und folgen eben meist nicht den Vorgaben der CPU Hersteller.Das deckt sich mit anderen Systemen und Reviews wie bspw. beim Luxx

6 x 4,7GHz ist massiv übertaktet und da sollte eine erhöhte Leistungsaufnahme nicht verwundern, zumal wenn dies per Autoeinstellung passiert, bei der die UEFI Entwickler mehr Spannung anlegen als für die meisten CPUs nötig wäre, einfach um auf der sicheren Seite zu sein.Man nehme ein Z370 Board, daß durch Multi Core Enhancement, Auto Core Voltage und Auto Loadline Calibration unter Last 6x 4,7Ghz bei 1,40V draufballert

Klar, dann messe mal einen RYZEN 5 oder eine Broadwell-E 6 Kerner bei 4,7GHz auf allen 6 Kernen um zu sehen wie schlecht Intel 14nm++ tatsächlich istLeider fehlen solche Messungen um aufzuzeigen wie schlecht 14nm++ tatsächlich ist !