HowTo 10: Brute-Force Server 2016 Installation mit UEFI-BIOS (oder: "bist Du nicht willig...")

Aus gegebenem Anlass: Falls jemand - so wie ich - versucht, einen

Server 2016 mit einem

reinen UEFI-Bios aufzusetzen und der Windows-Installer ums Verrecken nicht durchlaufen will...

In meinem Fall bricht er ab, nachdem man den Zieldatenträger ausgewählt hat. Immer. Egal was ich probiert habe und ging eben selbst dann nicht, nachdem ich der Disk bzw. dem Installer mit diversen manuellen Eingriffen auf die Sprünge helfen wollte. (USB-Boot-Stick mit Rufus probiert. Manueller bootstick (u.a. mit FAT32 und dism Split-Image) probiert. 3 verschiedene USB-Sticks ausprobiert. DVD-Installation probiert. Nix wollte.)

Ja, ich hätte auch einfach im Bios einfach den Legacy Modus aktivieren können. Wollte ich aber nicht (u.a. weil verschiedene andere OS auf anderen Datenträgern sitzen, prima nur mit UEFI zurecht kommen und ich da nichts verfummeln wollte...)

Ja, es geht bestimmt auch irgendwie eleganter. Mir ist aber der Geduldsfaden gerissen, hatte keinen Bock mehr auf irgendwelche HowTos und halbgare Ideen im Netz die dann doch nicht funktionieren und dann wollte ich's halt einfach wissen So geht's auf jeden Fall. Übrigens auch mit Windows 10 wenn das mal rumzickt.

Hier jetzt also der Brute-Force Ansatz:

(Im Prinzip sind das nur zwei simple Befehle - wenn man weiß wie. Ich hab die mal unten

fett für hervorgehoben. Der Rest ist nur Dreingabe, um die richtigen Quellen und Ziele zu identifizieren.)

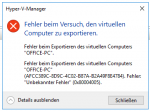

0. Ausgangsbasis: Ihr habt eine Server 2016 ISO. Ihr wolltet installieren aber nach der Auswahl des Installation-Ziels wirft der Installer eine Fehlermeldung (Datenträger nicht verfügbar, Error 0000000...irgendwas oder ähnliches). Wenn ihr danach diskpart aufruft oder wieder im Installer weiter geht, sind auf der Ziel-Disk dann 4 Partitionen (Recovery, System, Reserved, Primary) angelegt, aber nichts drin.

Vom Installer ab in die Kommandozeile mit Shift+F10 (und da bleiben wir auch):

1. diskpart

2. list disk / select disk # (# = Nummer Eurer Zieldisk)

3. list partition (dort nach der Partition mit dem Label "Primary" Ausschau halten, bei mir 4)

4. select partition # (Partition "Primary")

5. format fs=ntfs quick

6. assign letter=J

7. exit

8. Wechseln ins Stammverzeichnis des Installationsmediums (kann man identifizieren mit: wmic logicaldisk list brief --> SSS_X64FREE...DV9"), also z.B. "e:"

9. Gewünschtes Install-OS suchen: "dism /get-wiminfo /wimfile:e:\sources\install.wim"; Beispiel: DataCenter-Edition mit GUI ist Index Nr. 4

10. Kontrolle: dism /get-wiminfo /wimfile:e:\sources\install.wim /Index:4

Sieht gut aus.

11.

dism /Apply-Image /ImageFile:e:\sources\install.wim /Index:4 /ApplyDir:J:\

So, jetzt haben wir immerhin schon einmal die doofe Installation auf der Disk. Kommen wir zum Boot-Environment.

12. diskpart

13. select disk # (# = Nummer Eurer Zieldisk)

14. list partition (dort nach der Partition mit dem Label "System" ausschau halten, bei mir 2)

15. select partition # (# = System Partition)

16. format fs=fat32 quick

17. assign letter=K

18.

bcdboot J:\windows /s K:

Wenn alles richtig funktioniert hat, sollte dann auf Laufwerk K sowas wie ein Verzeichnis /boot drin sein.

19. Reboot, Passwort setzen, Sprache, Keyboard-Layout usw. auswählen, fertig.

So eine kleine dreckige Mistkiste.

EDIT: Howto im Startpost ergänzt.