Verstehe dieses Fazit absolut nicht, RDNA2 war gegen Ampere wesentlich stärker als RDNA3 gegen Lovelace.

RDNA2s Raster war quasi gleich auf mit Ampere, RT stark im Rückstand, aber die Energieeffizienz ging ganz klar an AMD, insbesondere unter Teillast.

Jetzt mit RDNA3 liegt Raster einen ganzen Tier zurück, man kämpft nicht mehr mit dem 102 Die, sondern dem 103 Die und RT liegt noch weiter zurück als zuvor. Die Effizienz ist auch vollkommen gekippt, auf einmal liefert Nvidia wesentlich mehr Leistung pro Watt und gerade unter Teillast, wo RDNA2 noch gut einsparen konnte, saugt RDNA3 besonders viel und wird von Lovelace vollkommen deklassiert.

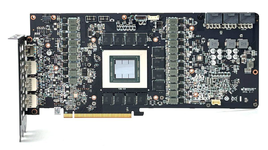

die rtx 4090 ist auch einfach ein monströser singlechip, mit 50%+ mehr "cores" als die 3090 ti.

mit all seinen problemen. schlechte ausbeute bei der herstellung, weil bei der größe des chips die wahrscheinlichkeit größer ist, das irgendwas kaputt ist.

zudem werden die rtx 4000er in 4n hergestellt.

die rx 7000er sind ein mix aus 5nm und 6nm.

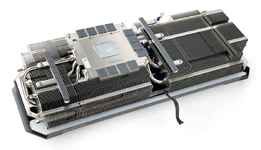

das chiplet design ist neu und ich denke es muss halt noch wirklich in den griff bekommen werden.

der größere herstellungsprozess und dadurch das chiplets benutzt werden, denke ich kommt es zu dem hohen stromverbrauch gegenüber den rtx 4000er.

jedes chiplet will mit strom versorgt werden. ich denke daher kommt es zu dem hohen verbrauch auch bei niedriger auflösung oder framelimit. (hoffe ihr versteht was ich meine ^^

ernsthafte frage:

kann das per treiber im nachgang gefixt werden?

oder bedarf es dafür einer neuen hardware revision?

kurz gesagt, das power management der rx 7000er passt noch nicht, weil die erfahrung mit dem neuen chiplet design fehlt.

ansonsten ist die rx 7900xtx ja nicht schlecht. wenn man auch mit anderen tests vergleicht immer schneller als eine rtx 4080 die ja nun auch bei der präsentation als gegner/ziel angegeben wurde.

mal sehen was neue treiber bringen.

werde, wenn sich da nichts ändert, sehen was einer 4070ti kostet und dann entscheiden.

Irgendwie überzeugt mich nicht mal eine 4090RTX bei Raytracing. Ich will keine 2000€ bezahlen um bei 4K jetzt schon am Limit zu kratzen.

Irgendwie überzeugt mich nicht mal eine 4090RTX bei Raytracing. Ich will keine 2000€ bezahlen um bei 4K jetzt schon am Limit zu kratzen.