Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Radeon RX Vega: AMD stellt Direktvergleich zur GeForce GTX 1080 her

- Ersteller HWL News Bot

- Erstellt am

Oberteufel

Enthusiast

Gibt's hier außer Off-Topic bla bla irgendwelche neue Fakten zu RX Vega?

nope... auch hier der gleiche Spaß wie in Budapest. (ist von heute)

RX Vega at PDXLAN 30 7/23/17 : Amd

Musst dich noch gedulden

sTOrM41

Admiral , HWLUXX Superstar

- Mitglied seit

- 13.10.2005

- Beiträge

- 22.317

- Details zu meinem Desktop

- Prozessor

- Ryzen 5700X

- Speicher

- 32GB

- Grafikprozessor

- RTX 4070

AMD Reality Check at FX GamExperience - Legit ReviewsThe AMD Reality Check Challenge

Gesendet von meinem SM-G930F mit Tapatalk

Gesendet von meinem SM-G930F mit Tapatalk

mr.dude

Urgestein

- Mitglied seit

- 12.04.2006

- Beiträge

- 6.420

Ist mir ehrlich gesagt völlig wuscht, weswegen du rumheulst.Stimmt, da kullern dann immer noch die Tränen weil es AMD schon lange nicht mehr gibt.

Dummerweise mehr schlecht als recht.Unserem Pro scheint entgangen zu sein, dass Nvidia bereits seit Jahren auch abseits von dGPUS für Consumer aktiv ist.

Keine Ahnung, aus welchem Märchenbuch du dein Halbwissen her hast. Aber Adaptive Sync beginnt nicht bei 48 Hz. Das kann deutlich tiefer liegen. Freesync Monitore gibt's zB schon ab 30 Hz. Alles darunter macht eh wenig Sinn. Und das tolle an Adaptive Sync ist, dass es keine proprietäre Hardware benötigt. Im Gegensatz zu G-Sync.Und was ist an dem Standard so toll? Die Range, die bei 48Hz beginnen kann?

Hab's mal korrigiert. So passt es. In der Tat, G-Sync ist Kundenverarsche. Gut erkannt.Aus Sicht von Nvidia ist diese Kundenverarsche natürlich ideal, das ist korrekt.

Hardwareaner

Banned

- Mitglied seit

- 10.03.2017

- Beiträge

- 1.161

Da scheinst du wenig bis gar nichts mitbekommen zu haben.Dummerweise mehr schlecht als recht.

Wie erklärst du dir dann Modelle wie diesen hier:Keine Ahnung, aus welchem Märchenbuch du dein Halbwissen her hast. Aber Adaptive Sync beginnt nicht bei 48 Hz. Das kann deutlich tiefer liegen. Freesync Monitore gibt's zB schon ab 30 Hz. Alles darunter macht eh wenig Sinn. Und das tolle an Adaptive Sync ist, dass es keine proprietäre Hardware benötigt. Im Gegensatz zu G-Sync.

Dell SE2717H Preisvergleich Geizhals Deutschland

Merkst du nicht wie lächerlich du dich mit solchen Verleumdungen machst? Was bist du für ein armes Würstchen, das Zitate fälschen muss, weil es nicht argumentieren kann...Hab's mal korrigiert. So passt es. In der Tat, G-Sync ist Kundenverarsche. Gut erkannt.

Naja, es passt zu dir.

Zuletzt bearbeitet:

OiOlli

Enthusiast

- Mitglied seit

- 16.05.2015

- Beiträge

- 3.127

- Details zu meinem Desktop

- Prozessor

- Ryzen R7 5800X3D

- Mainboard

- Asus B 550 Strix F Wifi

- Kühler

- Noctua NH-U12A

- Speicher

- 2x 32 GB Kingston FURY DIMM DDR4 3600

- Grafikprozessor

- XFX Speedster MERC 310 Radeon RX 7900 XT Black Edition

- Display

- Cooler Master TEMPEST GP27Q

- SSD

- Samsung 980 Pro 2 TB, Samsung 970 Evo Plus 2 TB

- Opt. Laufwerk

- BD-Brenner

- Soundkarte

- Soundblaster Z

- Gehäuse

- Raijintek Zofos Evo Silent

- Netzteil

- BeQuiet Straight Power 11 750 Platinum

- Keyboard

- HyperX Alloy Elite 2

- Mouse

- Logitech G403

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Opera One 107

- Internet

- ▼100 Mbit ▲40 Mbit

Jo bei dem Monitor beginnt Freesync erst bei hohen Frequenzen und jetzt? Er sagte kann. Mein Monitor beginnt ab 35 Hz und geht bis 120 Hz. Wow 5 Hz mehr als bei G-sync. Wobei ich das Future gerade sowieso nicht nutzen kann, da ich eine 1070 drin habe.

Hardwareaner

Banned

- Mitglied seit

- 10.03.2017

- Beiträge

- 1.161

Das "Feature" ist für den Popo. Genauso wie der Standard, der unwissenden Käufern die am Ende schnell enttäuscht sind das Geld aus der Tasche ziehen soll.Jo bei dem Monitor beginnt Freesync erst bei hohen Frequenzen und jetzt?

35Hz sind schon mal wesentlich besser. Nvidia macht es jedoch richtig und schreibt für G-Sync 30Hz vor. Da gibts dann keine Extrawürste. Zwar ist das teurer, aber immerhin kann sich der Kunde auf das Logo verlassen und muss keine Lotterie eingehen.

Motkachler

Urgestein

Das "Feature" ist für den Popo. Genauso wie der Standard, der unwissenden Käufern die am Ende schnell enttäuscht sind das Geld aus der Tasche ziehen soll.

35Hz sind schon mal wesentlich besser. Nvidia macht es jedoch richtig und schreibt für G-Sync 30Hz vor. Da gibts dann keine Extrawürste. Zwar ist das teurer, aber immerhin kann sich der Kunde auf das Logo verlassen und muss keine Lotterie eingehen.

Keine lotterie aber sich bei jeder neunen karte nicht nur beim moni von NV aufs neue abzocken lassen.

Zuletzt bearbeitet:

unl34shed

Enthusiast

Das "Feature" ist für den Popo. Genauso wie der Standard, der unwissenden Käufern die am Ende schnell enttäuscht sind das Geld aus der Tasche ziehen soll.

35Hz sind schon mal wesentlich besser. Nvidia macht es jedoch richtig und schreibt für G-Sync 30Hz vor. Da gibts dann keine Extrawürste. Zwar ist das teurer, aber immerhin kann sich der Kunde auf das Logo verlassen und muss keine Lotterie eingehen.

Es ist doch egal, ob es 35, 48 oder 60HZ als Minimal Frequenz sind, sowohl adaptive Sync als auch G-Sync beherschen Frame-doubling, sollte die FPS unter die min. Refreshrate fallen, wird das selbe Bild eben mehrfach angezeigt. Wichtig ist nur, dass die max. Refreshrate doppelt so groß ist, wie die minimale ist. Und ja, da gibt es ein paar Monitore, bei denen das nicht so ist. Hier muss man etwas aufpassen und in die Specs schauen!

Da so niedrige FPS im allgemeinen aber sowieso als unspielbar gelten, liegt der Vorteil jetzt wo?

Und ein anderer Punkt, warum die 30Hz von GSync per se nicht besser sein müssen (gilt natürlich auch für Adaptive Sync). Hast du ein Display mit hoher Refreshrate, willst du das die Pixel ihre Farben schnell ändern können und das ist ein Widerspruch zu lange Farben anzeigen.

Wird der Frequenzbereich zu groß, forcierst man so entweder Ghosting im hohen Hz Bereich, weil die Pixel zu träge sind oder Flackern im niedrigen Hz Bereich, weil die Pixel schon ihre Werte verlieren (bleeding). Letzteres hatten übrigens die ersten G-Sync Monitore

. Wie da aktuell der Stand ist, weiß ich nicht.

. Wie da aktuell der Stand ist, weiß ich nicht.SuLux

Enthusiast

- Mitglied seit

- 16.03.2005

- Beiträge

- 2.209

- Ort

- Chickenmeadow

- Desktop System

- Wintermute

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-14700K

- Mainboard

- Asus Prime Z690-A

- Kühler

- Arctic Liquid Frezzer III 360mm weiß A-RGB

- Speicher

- ADATA XPG LANCER RGB White Edition DIMM Kit 32GB, DDR5-6000, CL30-40-40

- Grafikprozessor

- PowerColor Radeon RX 7800 XT Hellhound Spectral White

- Display

- Cooler Master GP27-FQS

- SSD

- 980 PRO 2TB, CT2000P5PSSD8 2TB, CT2000P3PSSD8 2TB, SSD 870 QV 2TB, Kingston NV2 4 TB

- Opt. Laufwerk

- ext. USB bei Bedarf

- Soundkarte

- Onboard

- Gehäuse

- Lian Li Lancool 216 weiß

- Netzteil

- Enermax Revolution D.F. 12 weiß 850W ATX 3.1

- Keyboard

- Steelseries Apex 3

- Mouse

- Steelseries Rival 3 Wireless, G502 Hero

- Betriebssystem

- Windows 11 Pro

- Sonstiges

- DT 990 Pro Limited Edition Black an Fiio Olympus 2 E10K Type C

Echt ermüdend. Egal ob im CPU oder GPU Bereich. Ständig die Gleichen die sich gegenseitig dumm anmachen.

Trefft euch doch alle mal und haut euch gegenseitig schön in die Fresse.

Vielleicht kehrt dann hier im Forum Ruhe ein und wir müssen eure seichten Posts nicht mehr ertragen.

Trefft euch doch alle mal und haut euch gegenseitig schön in die Fresse.

Vielleicht kehrt dann hier im Forum Ruhe ein und wir müssen eure seichten Posts nicht mehr ertragen.

VorauseilenderGehorsam

Legende

- Mitglied seit

- 16.02.2017

- Beiträge

- 10.697

- Details zu meinem Desktop

- Prozessor

- Ryzen 5600G, Ryzen 5800x3d

- Mainboard

- Asrock B550m Steel Legend, Gigabyte A520i AC

- Kühler

- Arctic Freezer II 360, Arctic Freezer 36

- Speicher

- G.Skill 32GB Trident Z, 16GB Trident Z

- Grafikprozessor

- APU, AMD Sapphire 6800xt

- Display

- Samsung C49RG9

- SSD

- Samsung 980 Pro 500GB, Samsung 980 Pro 2TB

- Soundkarte

- Aune S6 Pro Dac/KHV

- Gehäuse

- Asus AP201, Corsair 2000D Airflow

- Netzteil

- Corsair RM750x, Corsair SF600

- Keyboard

- Keychron V6, Keychron K4 ISO DE

- Mouse

- Logitech MX Master S2, Roccat Kone Air Pro

- Betriebssystem

- Windows 10 Pro, Windows 11 Home

- Webbrowser

- Firefox - EDGE - Chrome

- Sonstiges

- HD58x Jubilee - Focal Elear - Corsair HS80 Max

- Internet

- ▼110 ▲14

So "hart" hätte ich es zwar nicht ausgedrückt, stimme dir aber im Ansatz zu. (erinnere mich noch gut, damals mit der 970er und den damaligen AMD Karten. (3.5GB)

Gubb3L

Urgestein

- Mitglied seit

- 18.01.2012

- Beiträge

- 9.925

So "hart" hätte ich es zwar nicht ausgedrückt, stimme dir aber im Ansatz zu. (erinnere mich noch gut, damals mit der 970er und den damaligen AMD Karten. (3.5GB)

Das waren spaßige Zeiten. Sobald Nvidia genannt wurde war mindestens einer da der auf die 3,5gb angespielt hat.

Oder etwas davor die Ramdebatte um die 770er 2gb. Da waren die Nvidia Jünger ja noch fest davon überzeugt das die 2gb ja noch Jahrzehnte ausreichen werden und 3gb total überflüssig sind.

audioslave

Experte

Zwar ist das teurer, aber immerhin kann sich der Kunde auf das Logo verlassen und muss keine Lotterie eingehen.

In meinen Augen ist das keine Lotterie. Sollte man aus irgendwelchen Gründen wirklich ins Klo greifen und es ergibt sich ein Problem bei der Zusammensetzung der Komponenten, dann wird zurückgeschickt. Es schicken alle möglichen Menschen mehrfach Krempel hin und her weil sie entweder gänzlich unwissend oder extrem penibel sind. So tickt die Welt doch heute. Sich vier Fernseher nach hause senden lassen, testen, zurückschicken (natürlich alles kostenlos) und dann das Angebot bei Blödmarkt kaufen.

Lotterie siehst du im Marktplatz, wo Leute ihre "Perlen" verkaufen. Egal ob 5,X GHz oder was weiß ich wie viel MHz GPU.

Meiner Meinung nach sollte man einfach seine GPU so stark dimensionieren, dass man auf Synch Quatsch verzichten kann (ist natürlich schwierig wenn man 4K toll findet).

- Mitglied seit

- 08.11.2007

- Beiträge

- 6.945

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühler

- Arctic Liquid Freezer II 280 Rev. 4

- Speicher

- 32GB DDR4 3200

- Grafikprozessor

- AMD RX 6900XT MBA

- Display

- LG OLED42C2

- SSD

- Kingston A2000 1TB NVME, Lexar NM790

- Soundkarte

- Topping MX3

- Gehäuse

- Cooler Master Qube 500

- Netzteil

- Corsair SF600 600Watt SFX

- Keyboard

- Akko 5075B plus

- Mouse

- Glorious Model D Wireless

- Betriebssystem

- Linux Arch EndeavourOS

- Internet

- ▼300Mbit

Wird mit Freesync 2 nicht die Range vorgegeben?

Hatte eben gelesen, dass die Maximalfrequenz das 2,5-fache der Minimalfrequenz sein muss.

Startet die Range also bei 30Hz muss Freesync bis mindestens 75Hz funktionieren.

Da man bei 30Hz bzw 30fps allerdings eh nicht mehr wirklich gut spielen kann, braucht man sich mMn auch nicht nach Monitoren umschauen, die dort starten.

Bei 40Hz hätte man dann schonmal bis 100Hz abgedeckt, was schon einiges besser sein sollte.

Und wieso die Technik, laut Hardwareaner dem NVidia-Troll (was hat der hier eigentlich zu suchen?), hier für den Popo sein soll, G-Sync aber scheinbar der heilige Gral ist, muss ich auch nicht verstehen.

Er soll mir mal einen G-Sync Monitor mit einem 144Hz IPS Panel und WQHD Auflösung zeigen...Ach da gibts ja nur noch 5 zur Auswahl...Mensch, der Rest ist TN und VA ist damit gar nicht vorhanden...und die fangen bei dann lächerlichen 690€ an weil G-Sync ja so toll ist.

Bei Freesync gibts ähnlich viele Monitore mit ebenfalls ordentlicher Range und kann dann noch zwischen TN, VA oder IPS wählen und zahle für einen IPS mit 40-144Hz Freesync range knapp über 500€.

Aber scheint völlig für den Popo zu sein.

Hatte eben gelesen, dass die Maximalfrequenz das 2,5-fache der Minimalfrequenz sein muss.

Startet die Range also bei 30Hz muss Freesync bis mindestens 75Hz funktionieren.

Da man bei 30Hz bzw 30fps allerdings eh nicht mehr wirklich gut spielen kann, braucht man sich mMn auch nicht nach Monitoren umschauen, die dort starten.

Bei 40Hz hätte man dann schonmal bis 100Hz abgedeckt, was schon einiges besser sein sollte.

Und wieso die Technik, laut Hardwareaner dem NVidia-Troll (was hat der hier eigentlich zu suchen?), hier für den Popo sein soll, G-Sync aber scheinbar der heilige Gral ist, muss ich auch nicht verstehen.

Er soll mir mal einen G-Sync Monitor mit einem 144Hz IPS Panel und WQHD Auflösung zeigen...Ach da gibts ja nur noch 5 zur Auswahl...Mensch, der Rest ist TN und VA ist damit gar nicht vorhanden...und die fangen bei dann lächerlichen 690€ an weil G-Sync ja so toll ist.

Bei Freesync gibts ähnlich viele Monitore mit ebenfalls ordentlicher Range und kann dann noch zwischen TN, VA oder IPS wählen und zahle für einen IPS mit 40-144Hz Freesync range knapp über 500€.

Aber scheint völlig für den Popo zu sein.

DerGoldeneMesia

Enthusiast

- Mitglied seit

- 21.05.2007

- Beiträge

- 4.439

Der dürfte einfach unmnegen Geld haben der Hardwareaner, nur dann könnt ich auch einen oled fernseher und xbox X kaufen

- Mitglied seit

- 08.11.2007

- Beiträge

- 6.945

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühler

- Arctic Liquid Freezer II 280 Rev. 4

- Speicher

- 32GB DDR4 3200

- Grafikprozessor

- AMD RX 6900XT MBA

- Display

- LG OLED42C2

- SSD

- Kingston A2000 1TB NVME, Lexar NM790

- Soundkarte

- Topping MX3

- Gehäuse

- Cooler Master Qube 500

- Netzteil

- Corsair SF600 600Watt SFX

- Keyboard

- Akko 5075B plus

- Mouse

- Glorious Model D Wireless

- Betriebssystem

- Linux Arch EndeavourOS

- Internet

- ▼300Mbit

Meiner Meinung nach sollte man einfach seine GPU so stark dimensionieren, dass man auf Synch Quatsch verzichten kann (ist natürlich schwierig wenn man 4K toll findet).

Weißt du überhaupt was der Synch "Quatsch" macht?

Es eliminiert Tearing und da kannste so viele FPS haben wie du willst, das geht ohne eine Sync-Methode nicht weg.

schapy

Urgestein

.... oder Nvidia FastSync - kostet nix, geht mit Nvidiahardware & ohne Sync Monitor bei genügend frames kaum einen Tearingeffekt und keinen Inputlag.

def

Legende

- Mitglied seit

- 02.12.2006

- Beiträge

- 9.825

- Ort

- Hamburg

- Details zu meinem Desktop

- Prozessor

- Intel i5-10600K

- Mainboard

- GIGABYTE Z590I AORUS ULTRA

- Kühler

- Thermalright Peerless Assassin 120 SE White ARGB

- Speicher

- G.Skill Trident Z RGB 16GB DDR4 B-Dies

- Grafikprozessor

- ASUS Dual GeForce RTX 2080 OC

- Display

- Acer Nitro XV2 XV272UP

- SSD

- Kingston KC3000

- Soundkarte

- Fiio K5 Pro @ Sivga SV004&7 + FIFINE K670 / Canton Smart GLE 9 S2

- Gehäuse

- Cooler Master MasterBox NR200P

- Netzteil

- Corsair SF450 80 PLUS Gold

- Keyboard

- WOB Rainy75 E-White

- Mouse

- CoolerMaster MM730

- Betriebssystem

- Microsoft Windows 11 Pro 64Bit

- Sonstiges

- Google Pixel 7 & 7a

natürlich hat man über fastsync auch input lag, genau wie mit jeder anderen sync technik auch. es gibt kein sync feature, egal von wem und egal was, das KEIN input lag verursacht, egal wie hoch/gering dieser ist

mag bei vielen spielen egal sein, im professionellen gaming bereich, gerade was FPS angeht spielt das allerdings ne sehr große rolle

mag bei vielen spielen egal sein, im professionellen gaming bereich, gerade was FPS angeht spielt das allerdings ne sehr große rolle

schapy

Urgestein

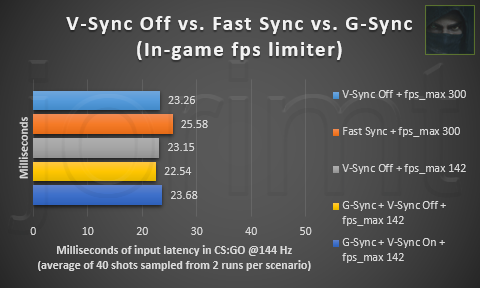

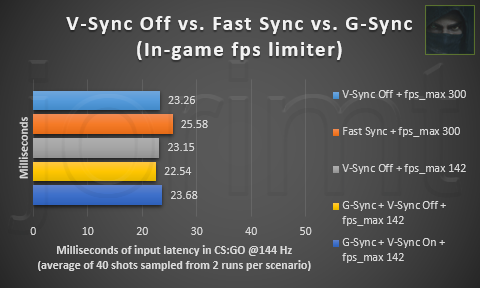

kaum einen Inputlag gegenüber VSync:

https://forums.geforce.com/default/topic/936446/fast-sync-and-maxwell/

https://forums.geforce.com/default/topic/936446/fast-sync-and-maxwell/

Zuletzt bearbeitet:

- Mitglied seit

- 08.11.2007

- Beiträge

- 6.945

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühler

- Arctic Liquid Freezer II 280 Rev. 4

- Speicher

- 32GB DDR4 3200

- Grafikprozessor

- AMD RX 6900XT MBA

- Display

- LG OLED42C2

- SSD

- Kingston A2000 1TB NVME, Lexar NM790

- Soundkarte

- Topping MX3

- Gehäuse

- Cooler Master Qube 500

- Netzteil

- Corsair SF600 600Watt SFX

- Keyboard

- Akko 5075B plus

- Mouse

- Glorious Model D Wireless

- Betriebssystem

- Linux Arch EndeavourOS

- Internet

- ▼300Mbit

Fastsync ist ne Katastrophe...

Kein Tearing mehr, kaum inputlag aber Stottering aus der Hölle.

Da spiele ich lieber mit V-Sync und begrenze per Framelimiter auf 59FPS --> kein Tearing, kein input lag, kein Stuttering.

Kein Tearing mehr, kaum inputlag aber Stottering aus der Hölle.

Da spiele ich lieber mit V-Sync und begrenze per Framelimiter auf 59FPS --> kein Tearing, kein input lag, kein Stuttering.

schapy

Urgestein

habe ich andere Erfahrungen gemacht - OK ich spiele aber auch jenseits der 120fps und würde 59fps schon als Augenkrebs fördernd bezeichnen .....

oooverclocker

Semiprofi

- Mitglied seit

- 29.08.2012

- Beiträge

- 5.610

Ich weiß nicht, warum ihr immer solche Herstellerfolien postet...

Hier ist Fast Sync plötzlich das langsamste. Es ist halt doch nur eine alte Technik, die mehr oder weniger schon in OpenGL drin ist. Und es würde doch auch keinen Sinn ergeben, wenn es tatsächlich so gut funktionieren würde, wie angegeben, denn dann wäre ja G-Sync sinnlos, und Nvidia könnte einfach Adaptive Sync supporten und kostenlos integrieren.

Edit: Wenn die Bilder verzögert werden, damit sie auf die Refresh-Rate des Monitors passen, entstehen auch Mikroruckler. Da bringt es dann nichts, wenn dafür kein Tearing mehr da ist...

Hier ist Fast Sync plötzlich das langsamste. Es ist halt doch nur eine alte Technik, die mehr oder weniger schon in OpenGL drin ist. Und es würde doch auch keinen Sinn ergeben, wenn es tatsächlich so gut funktionieren würde, wie angegeben, denn dann wäre ja G-Sync sinnlos, und Nvidia könnte einfach Adaptive Sync supporten und kostenlos integrieren.

Edit: Wenn die Bilder verzögert werden, damit sie auf die Refresh-Rate des Monitors passen, entstehen auch Mikroruckler. Da bringt es dann nichts, wenn dafür kein Tearing mehr da ist...

Zuletzt bearbeitet:

RAZ0RLIGHT

Enthusiast

Meiner Meinung nach sollte man einfach seine GPU so stark dimensionieren, dass man auf Synch Quatsch verzichten kann (ist natürlich schwierig wenn man 4K toll findet).

Leider nicht möglich bei dem Müll den man als PC Spieler vorgesetzt bekommt, zumindest wenn man nen 120Hz+ Monitor + mindestens 1440p hat

ProphetHito

Experte

kaum einen Inputlag gegenüber VSync:

Anhang anzeigen 407085

https://forums.geforce.com/default/topic/936446/fast-sync-and-maxwell/

hast du wirklich ein nichtsaussagendes Marketingschild für voll genommen? eines aus dem NV-Forum? hm ja dann . . . glauben wir doch einfach einer Grafik...mit der man Geld machen will...räusper

AMD Radeon RX Vega 3DMark Fire Strike performance | VideoCardz.com

Und extra im comment: "Something I didn't verify yet, so take it with a grain of salt. Rumor has it it will launch on 8th August. No custom cards at launch."

Aber ich glaube so langsam an die 299-349 Dollar für die Karte. Damit wäre alles andere eigentlich fast egal.

Und extra im comment: "Something I didn't verify yet, so take it with a grain of salt. Rumor has it it will launch on 8th August. No custom cards at launch."

Aber ich glaube so langsam an die 299-349 Dollar für die Karte. Damit wäre alles andere eigentlich fast egal.

schapy

Urgestein

@Overclocker - und wo ist da VSync Only in deinem Vergleich? Fastsync ist einzig und allein eine Alternative zu VSync - Nicht für Freesync nicht für Gsync, und funktioniert auch nur wenn man genügend FPS liefert - sprich bei einem 120HZ Monitor müssen es merh als 120fps sein sonst funktioniert es nicht .....

RAZ0RLIGHT

Enthusiast

.... oder Nvidia FastSync - kostet nix, geht mit Nvidiahardware & ohne Sync Monitor bei genügend frames kaum einen Tearingeffekt und keinen Inputlag.

Fast Sync ist leicht verbessertes Triple Buffering also nur hilfreich wenn man mehr FPS hat als der Monitor Refresh Rate hat.

Die einzige sinnvolle Sync Technik ist meiner Meinung nach Freesync/Gsync aka Adaptive Sync wie es offiziell heißt. (nicht zu verwechseln mit Nvidias Adpative VSync)

Nvidia Fast Sync Better Than G-Sync and V-Sync? - YouTube

Schöne Erklärung von einer neutraleren Quelle zu allen Sync Varianten.

Hier sieht man auch wunderschön, dass Fast Sync einfach nur Triple Buffering ist

Verdammt wird Zeit dass Vega erscheint, hier gibts ja nurnoch Offtopic

Zuletzt bearbeitet:

- Mitglied seit

- 08.11.2007

- Beiträge

- 6.945

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühler

- Arctic Liquid Freezer II 280 Rev. 4

- Speicher

- 32GB DDR4 3200

- Grafikprozessor

- AMD RX 6900XT MBA

- Display

- LG OLED42C2

- SSD

- Kingston A2000 1TB NVME, Lexar NM790

- Soundkarte

- Topping MX3

- Gehäuse

- Cooler Master Qube 500

- Netzteil

- Corsair SF600 600Watt SFX

- Keyboard

- Akko 5075B plus

- Mouse

- Glorious Model D Wireless

- Betriebssystem

- Linux Arch EndeavourOS

- Internet

- ▼300Mbit

habe ich andere Erfahrungen gemacht - OK ich spiele aber auch jenseits der 120fps und würde 59fps schon als Augenkrebs fördernd bezeichnen .....

Aha...gleich mal wieder völlig übertreiben. Aber gut, das kann ich auch, denn dein TN Monitor würde bei mir das gleiche verursachen.

Ich besitze seit ein paar Jahren einen Dell IPS Bildschirm und der hat nunmal 60Hz.

Ich kaufe mir keine neue Harware, wenn die jetzige noch einwandfrei läuft.

Fastsync habe ich getestet und das auch bei 80-100fps in BF1. Es ist ne Krankheit! Es ruckelt ohne Ende!

Da spiele ich lieber mit Tearing als mit dem gestotter bei dem mir auch 120fps oder mehr nichts mehr bringen.

Ceiber3

Urgestein

- Mitglied seit

- 21.11.2011

- Beiträge

- 4.897

- Desktop System

- Master System

- Laptop

- P775TM1G i9-9900k, 16 GB Ram, 1 TB NVMe, GTX 1070

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 7950X3D

- Mainboard

- ASUS ROG Strix X670E-I Gaming WIFI

- Kühler

- Externer 1280mm Supernova mit D5 Pumpe und OCTO Steuerung

- Speicher

- 48 GB DDR5-6000 CL30 von Corsair

- Grafikprozessor

- Manli RTX 4090 Gallardo 24 GB DDR6X

- Display

- 3440x1440, 200Hz, HDR1000, Lichtsensor, G-Sync Ultimate

- SSD

- Samsung 970 M.2

- HDD

- Nop

- Opt. Laufwerk

- (p≧w≦q)

- Soundkarte

- Asus HIVE mit Optischen Kabel zur 7.1 Anlage

- Gehäuse

- MasterBox NR200P Mini ITX Gehäuse

- Netzteil

- Corsair SF1000 Platinum

- Betriebssystem

- Winerror und Linux Mint, Dualboot

- Webbrowser

- Nur der eine "Firefox"

- Internet

- ▼250 ▲40

Bei mir ruckelt Fastsync überhaupt nicht. Jedenfalls merke ich nichts davon. Habe auch ein IPS Panel.

Ähnliche Themen

- Antworten

- 4

- Aufrufe

- 1K

- Antworten

- 7

- Aufrufe

- 830

- Antworten

- 0

- Aufrufe

- 308