Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

-

Hardwareluxx führt derzeit die Hardware-Umfrage 2025 (mit Gewinnspiel) durch und bittet um eure Stimme.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Weshalb Ryzen eine hervorragende Gaming CPU 2017 ist

- Ersteller G3cko

- Erstellt am

OiOlli

Enthusiast

- Mitglied seit

- 16.05.2015

- Beiträge

- 3.263

- Details zu meinem Desktop

- Prozessor

- Ryzen R7 9800X3D

- Mainboard

- GIGABYTE X870 Eagle WIFI7

- Kühler

- Noctua NH-U12A

- Speicher

- 2x 32 GB CORSAIR Vengeance DDR5 RAM 6000MHz CL30

- Grafikprozessor

- XFX Speedster MERC 310 Radeon RX 7900 XT Black Edition

- Display

- Cooler Master TEMPEST GP27Q

- SSD

- Samsung 990 Pro 4 TB, Samsung 980 Pro 2 TB,

- Soundkarte

- Soundblaster Z

- Gehäuse

- Fractal Design Meshify 2 XL Black

- Netzteil

- BeQuiet Straight Pure Power 12 M 750 Watt

- Keyboard

- HyperX Alloy Elite 2

- Mouse

- Logitech G403

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Opera One 107

- Internet

- ▼100 Mbit ▲40 Mbit

Deswegen ja Subjektiv und Zufall.Vielleicht lag es auch daran, dass Windows 10 jetzt komplett neu drauf ist. Andererseits hatte ich ein ähnliches Phänomen schon bei Unity.ich frage mich wie viel davon einbildung ist und wie viel realität

S

sualk027

Guest

Der I5 3550 wird durch den 1600(x) ersetzt.

Von 4 Kernen und 4 Threads auf zu 6/12.

Primärer Grund ist, dass beispielsweise in Battlefield 1 mein 5 Jahre alter I5 auf 100% läuft, wobei selbst meine bereits betagte Gtx 970 nur zu 60% ausgelastet werden kann. Außerdem immer mal wieder plötzliche Framedrops......

Die Multicore-Leistung sollte (theoretisch) praktisch verdoppelt werden, von daher scheint mir das eine ganz gut Investition ^^

Dieses Battlefield habe ich heute mal ausgiebiger gespielt.

1. Versucht mal mit einem 3770k die Meshqualität auf ultra zu stellen und dann in Amiens die 100fps-Marke zu halten.

2. SMT gehört auf meinem Gerät abgestellt, das läuft einfach unrund. Gibt dann ohne 64% Auslastung.

G3cko

Enthusiast

Thread Starter

- Mitglied seit

- 06.05.2005

- Beiträge

- 3.331

Nvidia hat einen deutlichen DX12 Bottleneck und das bereits mit einer GTX1060.

https://www.youtube.com/watch?v=RkJUPPHI4-I

Bei einer GTX1080Ti sind die Unterschiede noch deutlicher.

So oder so kann man einfach nicht eine neue CPU nur mit einer Grafikkarte des Wettbewerbers testen. Der Teiber ist immernoch die wichtigste Komponente. Alle Benchmarks ohne eine AMD Karte als Vergleich sind daher relativ wertlos.

- IPC auf Broadwell-E Niveau

- Anwendungsperformance vergleichbar

- Spieleperformance zum Großteil vergleichbar

- deutliche Ausreißer werden nicht mit einer AMD Karte gegengeprüft. Ryzen hat sofort eine Spieleschwäche... Zeigt mir mal eine deutsche Technikseite, welche sich mit diesem Ansatz wirklich beschäftigt hat. Dies wäre das erste gewesen, was ein guter Redakteur hätte tun müssen....

https://www.computerbase.de/2017-03.../#diagramm-battlefield-1-dx12-multiplayer-fps

Der 1800x verliert in BF1 DX12 über 25% fps gegenüber DX11! In einer API, welche den Prozessor eigentlich entlasten soll. Jeder weiß doch das DX12 aktuell Probleme macht. Bei Nvidia deutlich mehr als bei AMD. Qualitätsjournalismus vom Feinsten.

Übrigns noch einmal etwas zu den Frametimes, was ich aber bereits auf Seite 1 ansprach.

https://www.youtube.com/watch?v=RkJUPPHI4-I

Bei einer GTX1080Ti sind die Unterschiede noch deutlicher.

So oder so kann man einfach nicht eine neue CPU nur mit einer Grafikkarte des Wettbewerbers testen. Der Teiber ist immernoch die wichtigste Komponente. Alle Benchmarks ohne eine AMD Karte als Vergleich sind daher relativ wertlos.

- IPC auf Broadwell-E Niveau

- Anwendungsperformance vergleichbar

- Spieleperformance zum Großteil vergleichbar

- deutliche Ausreißer werden nicht mit einer AMD Karte gegengeprüft. Ryzen hat sofort eine Spieleschwäche... Zeigt mir mal eine deutsche Technikseite, welche sich mit diesem Ansatz wirklich beschäftigt hat. Dies wäre das erste gewesen, was ein guter Redakteur hätte tun müssen....

https://www.computerbase.de/2017-03.../#diagramm-battlefield-1-dx12-multiplayer-fps

Der 1800x verliert in BF1 DX12 über 25% fps gegenüber DX11! In einer API, welche den Prozessor eigentlich entlasten soll. Jeder weiß doch das DX12 aktuell Probleme macht. Bei Nvidia deutlich mehr als bei AMD. Qualitätsjournalismus vom Feinsten.

Übrigns noch einmal etwas zu den Frametimes, was ich aber bereits auf Seite 1 ansprach.

Zuletzt bearbeitet:

angelsdecay

Enthusiast

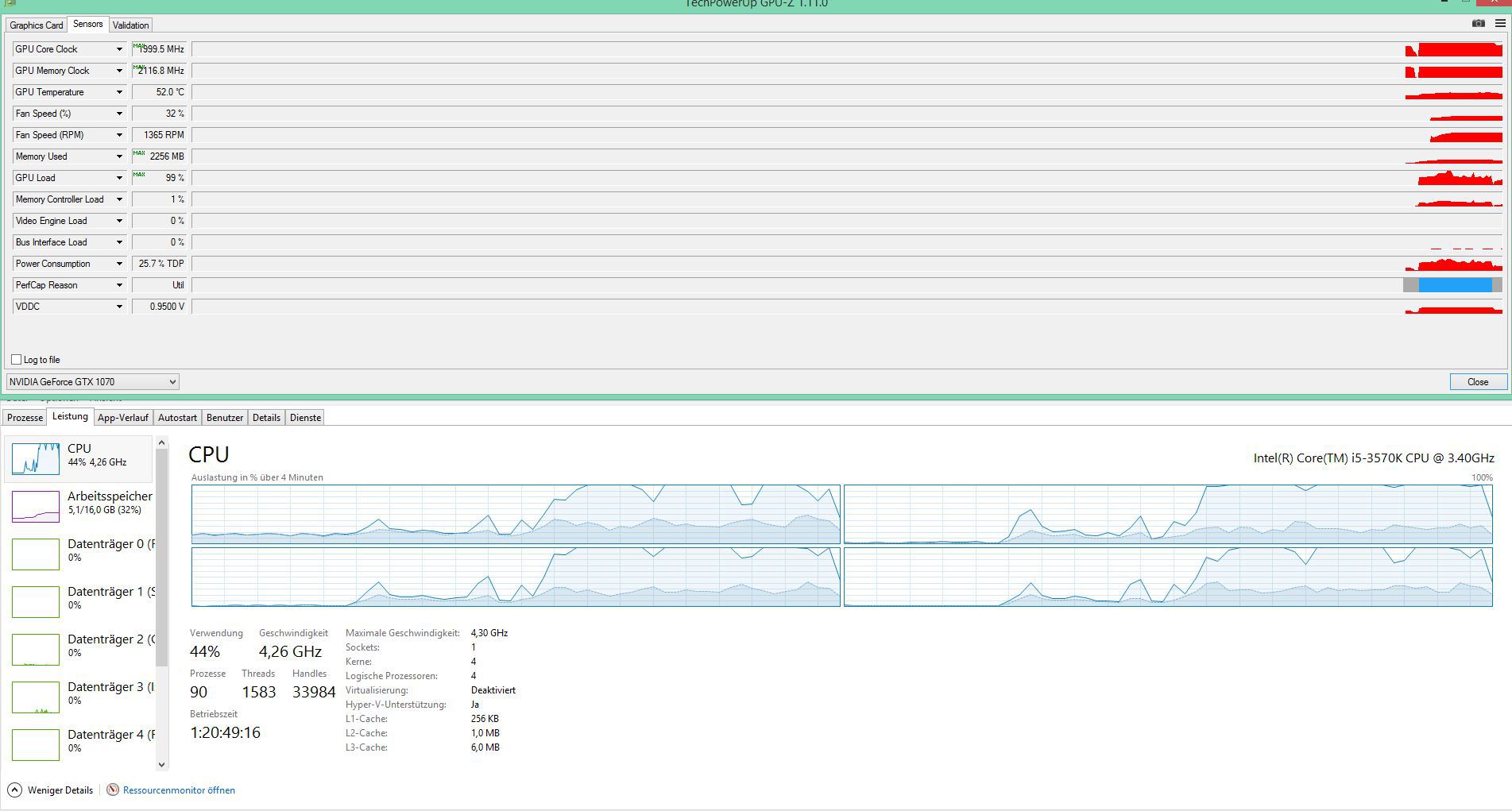

Fram,etimes sind etwas kryptisch für den laien

besser wäre ein fps verlauf in dem benchmark szenen

oberer Zeile gpu load grafikarten auslastung ~95% bedeutet das ein 5% schnellere CPu Takt diesen gap schließt

untere Grafik die passende FPS die mehr werden mit mehr CPu Takt.

Werte min 50fps maximum 77fps

In mathe mit 5% mehr Cpu takt = min 52fps max 80fps

ich habe derzeit 3,6ghz cpu Takt ich müsste die cpu auf 3,8ghz oc um meine gpu voll auszulasten

zum vergleich eine gtx1080 (+30% also -30 gpu load 95-30 =65%) würde mir da nicht helfen weil mein ci7 5820k schon limitiert mit 5% in 1080p Auf gtx1080 würde das ein cpu takt von 4,7ghz benötigen um ein cpu bottleneck zu vermeiden.

Directx ist cpu takt orientiert. Da kann man nur noch mehr grafik effekte einsetzen.Die api limitiert hier heftig

In dx12 theoretisch mit amd gcn ist dieses limit nicht existent

besser wäre ein fps verlauf in dem benchmark szenen

oberer Zeile gpu load grafikarten auslastung ~95% bedeutet das ein 5% schnellere CPu Takt diesen gap schließt

untere Grafik die passende FPS die mehr werden mit mehr CPu Takt.

Werte min 50fps maximum 77fps

In mathe mit 5% mehr Cpu takt = min 52fps max 80fps

ich habe derzeit 3,6ghz cpu Takt ich müsste die cpu auf 3,8ghz oc um meine gpu voll auszulasten

zum vergleich eine gtx1080 (+30% also -30 gpu load 95-30 =65%) würde mir da nicht helfen weil mein ci7 5820k schon limitiert mit 5% in 1080p Auf gtx1080 würde das ein cpu takt von 4,7ghz benötigen um ein cpu bottleneck zu vermeiden.

Directx ist cpu takt orientiert. Da kann man nur noch mehr grafik effekte einsetzen.Die api limitiert hier heftig

In dx12 theoretisch mit amd gcn ist dieses limit nicht existent

Zuletzt bearbeitet:

ich habe AMD nicht schlecht geredet, nur gefragt wie man stark man der meinung vertrauen kann. es ist schließlich bekannt, dass foren gerne für werbung genutzt werden wie "steigt alle auf die neue wunder-CPU um und gebt wieder 500€ aus"...

Wenn dir die Meinung eines AMD Fanboys dies Wert ist (man sagt ja, jeder der einen hat, ist einer) -

Wovon kam ich? > 3930K @ 4,4Ghz mit 2400 DDR3 CL9 gepaart mit einer 290x Lightning @1300Mhz

Was habe ich jetzt > R7 1700 @4Ghz mit DDR4 3200 CL14 gepaart mit einer 290x Lightning @Default, aus Loop entfernt, da ich mir vermutlich Vega holen werde. Aus dem Loop entnommen schon mal erledigt, wenn ich schon dran war, mach ich nämlich extremst ungern. Daher ist mein Fluid auch gern mal 3 Jahre drin

Was hab ich gezockt und zocke ich jetzt noch: Doom, Mass Effekt, BF1, Star Citizen, bissle GW2, Forza Horizon....

Was hab ich gemerkt: Ziemlich Smoother geworden das ganze. Bei Star Citizen hatte ich hin und wieder immer so kleine mini Stocker, schiebe ich aber doch erstmal eher dem Spiel in die Schuhe.

BF1, ich zocke ja gern auf 64er Servern, sehr fluffig und ohne irgendwelche kleinen Pupsigen Hänger, GENAU DANN WENN MAN 3 TYPEN VOR DER NASE HAT UND DIE UMBRATZEN KÖNNTE... wenn nicht genau dann der Hänger käme...

Mass Effekt hatte ich nur die ersten 3 Stunden noch mit dem Intel gezockt, konnte da jetzt inzwischen mit dem Ryzen keinen Unterschied feststellen, obwohl die FPS natürlich geringer waren, da der Default Takt der 290x anliegt ( 1080 ) statt 1300. Aber fühlte sich nicht anders als zuvor an, trotz geringerer Fps.

GW2 im Zerk (WVWVW) erste Sahne. Endlich mal regelmäßig Bilder vor die Nase geliefert bekommen und keine abwechselnde Diashow.

Forza Horizon: Die immer wieder kehrenden kleinen Hänger, so alle 30sek sind einfach nur WEG.

Doom... was soll ich sagen... läuft auf beiden gleich. FPS wegen Default 290x halt bissle weniger, aber super fluffig, besonders wegen Vulkan.

Anwendungen krasser Sprung.

Bisher bin ich voll zufrieden, und für den 1700 hab ich nur 313€ bezahlt, war ja diese komische Rakuten Oster Aktion. Den Spire Kühler der dabei war, hab ich bei ebay für 30€ verkauft, also ich kann echt nicht meckern.

Bastelkiste @FX 8350 hatte ich natürlich auch... aber da hab ich mehr mit Boinc gespielt

Achja, ganz vergessen:

Diese Meinung könnte Werbung, ein wenig bezahlter Troll, ein wenig Aggression und Schalentiere enthalten :P

Wir wollen ja das Klischee aufrecht erhalten

Zuletzt bearbeitet:

BF2-Gamer

Legende

- Mitglied seit

- 22.01.2010

- Beiträge

- 11.537

Kennt das hier schon jemand?

AMD is zurück! Ryzen 5 bricht 6-Kern Rekorde. OC auf 5905 MHz (6C/12T) - YouTube

AMD is zurück! Ryzen 5 bricht 6-Kern Rekorde. OC auf 5905 MHz (6C/12T) - YouTube

Winchester73

Enthusiast

- Mitglied seit

- 10.08.2013

- Beiträge

- 1.021

- Desktop System

- Winch

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- Gigabyte X570S UD

- Kühler

- Arctic Liquid Freezer III 360

- Speicher

- 2x16GB DDR4 Crucial Ballistix 3600 @ 16-18-18-38 (CL-RCD-RP-RAS)

- Grafikprozessor

- XFX Swift Radeon RX 9070 XT OC White

- Display

- 1-AOC24G1WG4 144Hz, 0-Samsung LC34G55T (DP)

- SSD

- 7 SSDs (4x M2 NVMe) 5x1TB/2x512GB

- HDD

- Alle rausgeworfen

- Opt. Laufwerk

- Asus BW-16D1HT Blu-ray

- Soundkarte

- Steelseries Arctis Nova 7P

- Gehäuse

- Fractal Design Define R5

- Netzteil

- Seasonic FOCUS GX-750

- Keyboard

- Cherry MX 3.0S RGB, Corsair K55 RGB Pro

- Mouse

- Razer Basilisk V3 X Hyperspeed

- Betriebssystem

- W11Pro 24H2 Build 26100.3476

- Webbrowser

- FF,Edge,Chrome

- Internet

- ▼1000MBit/s ▲50MBit/s

Du bist doch die größte INTEL-Bratze die im Netz unterwegs ist. Bei dir ist das negative Geschwurbel in AMD-Threads doch schon konditioniert. Und deine Ausreden sind dermassen bemitleidenswert..... .ich habe AMD nicht schlecht geredet, nur gefragt wie man stark man der meinung vertrauen kann. es ist schließlich bekannt, dass foren gerne für werbung genutzt werden wie "steigt alle auf die neue wunder-CPU um und gebt wieder 500€ aus"...

OiOlli

Enthusiast

- Mitglied seit

- 16.05.2015

- Beiträge

- 3.263

- Details zu meinem Desktop

- Prozessor

- Ryzen R7 9800X3D

- Mainboard

- GIGABYTE X870 Eagle WIFI7

- Kühler

- Noctua NH-U12A

- Speicher

- 2x 32 GB CORSAIR Vengeance DDR5 RAM 6000MHz CL30

- Grafikprozessor

- XFX Speedster MERC 310 Radeon RX 7900 XT Black Edition

- Display

- Cooler Master TEMPEST GP27Q

- SSD

- Samsung 990 Pro 4 TB, Samsung 980 Pro 2 TB,

- Soundkarte

- Soundblaster Z

- Gehäuse

- Fractal Design Meshify 2 XL Black

- Netzteil

- BeQuiet Straight Pure Power 12 M 750 Watt

- Keyboard

- HyperX Alloy Elite 2

- Mouse

- Logitech G403

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Opera One 107

- Internet

- ▼100 Mbit ▲40 Mbit

Muss das sein?

sweetchuck

Enthusiast

- Mitglied seit

- 14.08.2014

- Beiträge

- 1.426

So oder so kann man einfach nicht eine neue CPU nur mit einer Grafikkarte des Wettbewerbers testen. Der Teiber ist immernoch die wichtigste Komponente. Alle Benchmarks ohne eine AMD Karte als Vergleich sind daher relativ wertlos.

Nur daß es derzeit keine High-End-Karte von AMD zu kaufen gibt. Und als Käufer einer neuen CPU würde ich schon erwarten, daß diese auch ordentlich mit einer Grafikkarte der Konkurrenz zusammenarbeitet - real ist das ja auch so.

G3cko

Enthusiast

Thread Starter

- Mitglied seit

- 06.05.2005

- Beiträge

- 3.331

Nur daß es derzeit keine High-End-Karte von AMD zu kaufen gibt. Und als Käufer einer neuen CPU würde ich schon erwarten, daß diese auch ordentlich mit einer Grafikkarte der Konkurrenz zusammenarbeitet - real ist das ja auch so.

Ich zitiere mich mal selbst:

Das Problem an den 720p Benchmarks ist, dass diese zwar sehr wichtig sind, jedoch der User mit den Ergebnissen alleine gelassen wird. Ich kann daher beide Seiten verstehen. Die Einen welche sagen: "Wer spielt denn in 720p" und die anderen "Man muss eine CPU im CPU-Limit testen". Das Problem ist nur, welchen Mehrwert hat man noch, wenn uralte Software getestet wird und teilweise mehr als 300fps erreicht werden? In den Rankings wird dann alles auf einen Prozentwert zusammengekloppt und ein Fazit gezogen. So einfach ist es nun mal nicht. 720p Benchmarks sind ein theoretischer Wert und man kommt eben nicht drum rum diesen zu bewerten. Und gerade wenn ich aus 720p Benchmarks eine Prognosse für die Zukunft ableiten möchte, ist es eben noch wichtiger genauer hinzuschauen und auch möglichst aktuelle Software zu verwenden.

Ich weiß nicht wieviele 1080Ti Besitzer in FullHD spielen oder 1080 non-Ti Besitzer in 720p. Diese Werte sind eher theoretischer Natur um herrauszufinden, wie sich die CPU in Zukunft womöglich performancetechnisch schlägt. Dabei muss man aktuelle Software berücksichtigen und vor allem bei einer so neuen Architektur kann ich mich nicht auf einen Grafikkartenhersteller verlassen.

Man hätte ja auch genauso mit einer GTX1060 oder RX480 in 720p oder 800x600 testen können. Es geht ja nur um die CPU-Leistung, da ist die Auflösung egal, hauptsache die Grafikkarte limitiert nicht.

Denn das ist ein wesentlich anders Ergebnis, besonders bezogen auf die Kaufentscheidung, wenn es am Grafikkartentreiber liegt und nicht an der CPU. Ryzen hat keine Spieleschwäche. Wenn überhaupt hat Nvidia aktuell eine DX12-Ryzen-Schwäche. Das werden wir aber deutlich stärker sehen wenn Vega released wird.

Zuletzt bearbeitet:

CH4F

Enthusiast

- Mitglied seit

- 18.02.2011

- Beiträge

- 5.707

- Ort

- Bad Godesberg

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X

- Mainboard

- Asus Strix X570-E

- Kühler

- BQ Dark Rock Pro 3

- Speicher

- 32 GB DDR4-3600

- Grafikprozessor

- Asus TUF RTX 4080

- Display

- HP X27i

- SSD

- SanDisk Ultra 3D 2TB

- Gehäuse

- BeQuiet Pure Base 500

- Netzteil

- Corsair RM650x

- Keyboard

- Corsair K60 RGB Low-Profile

- Mouse

- Roccat Kone Pure Owl-Eye

- Betriebssystem

- W11

Ryzen ist ein ARM-Prozessor.

Gesendet von iPhone mit Tapatalk

Gesendet von iPhone mit Tapatalk

sweetchuck

Enthusiast

- Mitglied seit

- 14.08.2014

- Beiträge

- 1.426

Man hätte ja auch genauso mit einer GTX1060 oder RX480 in 720p oder 800x600 testen können. Es geht ja nur um die CPU-Leistung, da ist die Auflösung egal, hauptsache die Grafikkarte limitiert nicht.

Und genau da liegt der Grund, warum man mit ner High-End-Karte testet.

G3cko

Enthusiast

Thread Starter

- Mitglied seit

- 06.05.2005

- Beiträge

- 3.331

Und genau da liegt der Grund, warum man mit ner High-End-Karte testet.

Exakt, nur spielt es halt absolut keine Rolle ob das nun eine High-End Karte oder eine Midrange-Karte ist. Man muss nur gucken, dass man immer im GPU-Limit ist. Also vernünftige Settings wählen.

Ich kann nichts dafür, wenn viele nicht verstehen was ein GPU- oder CPU-Limit ist. Das hat ersteinmal wenig mit der Hardware als solches zu tun, sondern viel mehr mit den Settings.

Es ist aber nicht die Aufgabe eines CPU Designers, seine CPU nach den Grafikkarten Treibern einer Konkurrenz Firma zu designen!

Software heißt deshlab Software, weil sie eben formbar ist. Intels Core-Architektur ist nun über 10 Jahre am Markt. Intels Ryzen brand aktuell. Treiber müssen eben angepasst werden, dass ist die Aufgabe der Software nicht der Hardware. Wenns nach deiner Logik ginge würde es bis heute keine MultiCore-CPUs geben, deutlich effizientzere Befehlssätze, DX-Level, etc......

Ich bin doch mit dir völlig d'accord!

Es geht doch hauptsächlich um diesen Satz:

Und es ist Nvidias Sache dafür zu sorgen nicht die von AMD und ihrem CPU Design!

Es geht doch hauptsächlich um diesen Satz:

Nur daß es derzeit keine High-End-Karte von AMD zu kaufen gibt. Und als Käufer einer neuen CPU würde ich schon erwarten, daß diese auch ordentlich mit einer Grafikkarte der Konkurrenz zusammenarbeitet - real ist das ja auch so.

Und es ist Nvidias Sache dafür zu sorgen nicht die von AMD und ihrem CPU Design!

B

bawder

Guest

stimme zu, der satz ist sehr realitätsfern.

G

Gelöschtes Mitglied 240287

Guest

Intels ryzen? Schöner Schreibfehler

Naja der Punkt bei nV wird ein anderer sein.

Bei Bulli hat man sehr schnell reagiert. Allerdings war der Markt da auch noch ein anderer.

Jetzt sieht man das wohl aus einer anderen Betrachtung.

Intel ist /war ja quasi Monopolist. Amd geht es finanziell nicht gut.

AMD ist im graka Bereich der einzige Konkurrent zu nV.

Wieso sollte nV also daher gehen und ihre Treiber auf AMD prozessoren optimieren?

Man stärkt damit seinen stärksten Konkurrenten im Grafik Markt. Viel mehr Sinn macht es für nV doch eben nicht auf Ryzen zu optimieren so lange es geht, um somit bei einigen dafür zu sorgen eben doch eher eine Intel CPU zu kaufen, so landet weniger Geld bei AMD die sie für Konkurrent Produkte im Grafik Markt investieren könnten

Ist kein nV schlecht reden. Würde wohl aus Unternehmenssicht nicht anders handeln...

Daher vermute ich das man erst auf ryzen optimiert wenn dieser einen entsprechenden Markt Anteil inne hat, wodurch man es quasi muss

Finde ich selbst nicht schön sowas.

Habe zwar nur nV Karten gerade aktiv. Begründet sich aber darin das ich damals meine TI sehr günstig bekommen habe. Und das zweit System (der fx) mit der nv Karte schlicht besser läuft, Stichwort DX11 overheat was bei der Schwachen CPU sich leider deutlich bemerkbar macht. (hatte vorher nur amd Karten mit im zweit System und das Thema ist ja mehr als genug breit getreten).

Für das zweite System, dafür das Frauchen nur wenige Titel daran mit zockt, lohnt sich aber noch kein kompletter Plattform wechsel.

In System 1 hätte ich absolut kein Problem wieder eine amd Karte zu verbauen mit entsprechend mehr bums als meine TI. Das wird aber noch etwas dauern da es da a) nicht wirklich was gibt von amd und b) ich aktuell eh nur in full HD spiele und da reicht die ti wohl noch ein gutes Jahr für

Kaufe immer gerne große Karten um dann 2-3 Jahre keine neue kaufen zu müssen. Freue mich am Anfang über die brachiale Leistung die schon über denensioniert ist und somit ich für jeden Mist und jeder Mod verschwenden kann. Und wenn die Karte dann irgendwann nach 2-3 Jahren Probleme kriegt ansehnliche Details @fullhd /60fps zu stemmen wird sie halt ersetzt zu viel Leistung gibt es nicht.

zu viel Leistung gibt es nicht.

Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

Naja der Punkt bei nV wird ein anderer sein.

Bei Bulli hat man sehr schnell reagiert. Allerdings war der Markt da auch noch ein anderer.

Jetzt sieht man das wohl aus einer anderen Betrachtung.

Intel ist /war ja quasi Monopolist. Amd geht es finanziell nicht gut.

AMD ist im graka Bereich der einzige Konkurrent zu nV.

Wieso sollte nV also daher gehen und ihre Treiber auf AMD prozessoren optimieren?

Man stärkt damit seinen stärksten Konkurrenten im Grafik Markt. Viel mehr Sinn macht es für nV doch eben nicht auf Ryzen zu optimieren so lange es geht, um somit bei einigen dafür zu sorgen eben doch eher eine Intel CPU zu kaufen, so landet weniger Geld bei AMD die sie für Konkurrent Produkte im Grafik Markt investieren könnten

Ist kein nV schlecht reden. Würde wohl aus Unternehmenssicht nicht anders handeln...

Daher vermute ich das man erst auf ryzen optimiert wenn dieser einen entsprechenden Markt Anteil inne hat, wodurch man es quasi muss

Finde ich selbst nicht schön sowas.

Habe zwar nur nV Karten gerade aktiv. Begründet sich aber darin das ich damals meine TI sehr günstig bekommen habe. Und das zweit System (der fx) mit der nv Karte schlicht besser läuft, Stichwort DX11 overheat was bei der Schwachen CPU sich leider deutlich bemerkbar macht. (hatte vorher nur amd Karten mit im zweit System und das Thema ist ja mehr als genug breit getreten).

Für das zweite System, dafür das Frauchen nur wenige Titel daran mit zockt, lohnt sich aber noch kein kompletter Plattform wechsel.

In System 1 hätte ich absolut kein Problem wieder eine amd Karte zu verbauen mit entsprechend mehr bums als meine TI. Das wird aber noch etwas dauern da es da a) nicht wirklich was gibt von amd und b) ich aktuell eh nur in full HD spiele und da reicht die ti wohl noch ein gutes Jahr für

Kaufe immer gerne große Karten um dann 2-3 Jahre keine neue kaufen zu müssen. Freue mich am Anfang über die brachiale Leistung die schon über denensioniert ist und somit ich für jeden Mist und jeder Mod verschwenden kann. Und wenn die Karte dann irgendwann nach 2-3 Jahren Probleme kriegt ansehnliche Details @fullhd /60fps zu stemmen wird sie halt ersetzt

zu viel Leistung gibt es nicht.

zu viel Leistung gibt es nicht. Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

Zuletzt bearbeitet von einem Moderator:

brometheus

Urgestein

Wieso sollte nV also daher gehen und ihre Treiber auf AMD prozessoren optimieren?

Wenn man davon ausgeht, dass es keine geheimen Absprachen zwischen Nvidia und Intel gibt, hat Nvidia sehr wohl ein Intresse daran, dass ihre Hardware gut mit Amd-Prozessoren funktioniert. Wenn der Anteil der Rechner mit Ryzen-Cpu zunimmt (und danach sieht es ja aus), ist dies ein Markt / eine Zielgruppe, die für Nvidia verloren geht, falls deren GPU nicht gut mit Ryzen funktionieren. Das die Cpus vom gleichen Hersteller wie die Konkurrenz-gpus kommen ist dabei vollkommen egal.

Ich bin mir sicher, dass akutelle Probleme nur bestehen, weil Nvidia noch keine Zeit hatte die Treiber entsprechend anzupassen. Ich bin mir ziemlich sicher, dass in Zukunft die GPUs von Nvidia genauso gut mit einem R7 wie mit einem I7 funktionieren werden, solang es keine technischen Probleme gibt, die das verhindern. Nvidia ist es nämlich egal, ob die Cpu von Intel oder Amd ist, solange die GPU von NV kommt.

E: Allerdings kann ich mir gut vorstellen, dass die Optimierungen nur der aktuellen Generation zu Gute kommen, da ältere Hardware bei NV ja ziemlich stiefmütterlich behandelt wird.

Zuletzt bearbeitet:

G

Gelöschtes Mitglied 240287

Guest

Noch keine Zeit.... Nv hat nicht so eine kleine Treiber Abteilung wie AMD

Aber du sagst es ja selbst... Wenn der Anteil zu nimmt werden Sie.... Und genau das habe ich doch auch gesagt

Aktuell nein weil es den Anteil jetzt noch nicht gibt und man so, wie oben geschrieben, man den ein oder anderen sicher verleitet aufgrund der nv Performance zu Intel zu greifen, und man so eben nicht den Konkurrenten stärkt.

Wird sicher auch aufgehen, da vega noch nicht da ist und so leute mit einer 1080 tj etc. Sicher eher auf Intel schielen wegen genau dem Thema.

Wenn aber der Markt Anteil entsprechend ist wird man natürlich nicht drum herum kommen weil dann würde man sich natürlich selbst das Wasser abgraben.

Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

Aber du sagst es ja selbst... Wenn der Anteil zu nimmt werden Sie.... Und genau das habe ich doch auch gesagt

Aktuell nein weil es den Anteil jetzt noch nicht gibt und man so, wie oben geschrieben, man den ein oder anderen sicher verleitet aufgrund der nv Performance zu Intel zu greifen, und man so eben nicht den Konkurrenten stärkt.

Wird sicher auch aufgehen, da vega noch nicht da ist und so leute mit einer 1080 tj etc. Sicher eher auf Intel schielen wegen genau dem Thema.

Wenn aber der Markt Anteil entsprechend ist wird man natürlich nicht drum herum kommen weil dann würde man sich natürlich selbst das Wasser abgraben.

Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

brometheus

Urgestein

Nv hat nicht so eine kleine Treiber Abteilung wie AMD

Zaubern können die auch nicht. Auch wenn sie die meiste Zeit das bessere Ergebnis rausholen, hat es in der Vergangenheit schon ab und zu etwas gedauert, bis Probleme behoben werden konnten, besonders bei Hardware bedingten Angelegenheiten.

Ich bin mir ziemlich sicher, dass Nvdia schon jetzt Ryzen als relevant bewertet und nicht erst in einem halben Jahr, wenn der Marktanteil bei vielleicht 20% oder so liegt.

Tiefgreifende Änderungen brauchen nunmal Zeit, auch wenn man die deutlich größere Finanz- und Personalkraft hat.

E:

Wenn der Anteil zu nimmt werden Sie....

Ein erfolgreiches Unternehmen wartet nicht erst darauf, dass der Markt sich verändert, sondern reagiert schon vorher, bevor der Markt sich zum oftmals eigenen Nachteil verändert hat.

Ich bin mir ziemlich sicher, dass NV nicht erst abwaret, ob Ryzen wirklich erfolgreich wird. Wenn es erstmal soweit ist, und es allgemein verbreitet ist, dass Nvidia nicht gut mit Ryzen funktioniert, dann wäre es schon zu spät.

E2: Erfolgreiche Unternehmen agieren, schlechte Unternehmen reagieren.

Zuletzt bearbeitet:

G

Gelöschtes Mitglied 240287

Guest

Das ist richtig bezüglich der Änderungen /Optimierungen.

Und es wäre sehr wünschenswert wenn sie auf ryzen schon optimieren würden.

Glaub ich allerdings wie erwähnt nicht dran zum jetzigen Zeitpunkt.

Macht aber auch nichts

Ich hoffe selbst das du recht hast

Ich bin zugegebenermaßen mehr ein amd Sympathisant als Intel oder nV. Trotzdem kaufe ich hardware so wie ich sie brauche und für mich am besten ist und es sich anbietet. Ich hab auch mal ein 8350 im Haupt sys gehabt, ebenso wie eine r9 390. War beides nicht so der Knaller wie erhofft und gewollt , hab dann auf den i7 gewechselt und hatte eine 970... Dann kam der Speicher gate... Fury gefiel mir auch nicht.. Also die Ti rein...

Wäre demnach auch glücklicher wenn ich Hardware unabhängig weiter kaufen könnte und nicht anhand dessen welche hw irgendwo auf eine andere hw optimiert ist.

Schlimm genug das ich aufgrund des dx11 overheats Problem, womit ich wirklich Probleme hatte, eine amd graka im sys 2 ebenfalls gegen eine nV Karte tauschen MUSSTE, nur um in den betreffenden Spielen erwartete Performance zu haben ohne gleich die komplette Plattform wechseln zu müssen, was sie wie gesagt aktuell noch nicht lohnt für das System und sein einsatzzweck.

Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

Und es wäre sehr wünschenswert wenn sie auf ryzen schon optimieren würden.

Glaub ich allerdings wie erwähnt nicht dran zum jetzigen Zeitpunkt.

Macht aber auch nichts

Ich hoffe selbst das du recht hast

Ich bin zugegebenermaßen mehr ein amd Sympathisant als Intel oder nV. Trotzdem kaufe ich hardware so wie ich sie brauche und für mich am besten ist und es sich anbietet. Ich hab auch mal ein 8350 im Haupt sys gehabt, ebenso wie eine r9 390. War beides nicht so der Knaller wie erhofft und gewollt , hab dann auf den i7 gewechselt und hatte eine 970... Dann kam der Speicher gate... Fury gefiel mir auch nicht.. Also die Ti rein...

Wäre demnach auch glücklicher wenn ich Hardware unabhängig weiter kaufen könnte und nicht anhand dessen welche hw irgendwo auf eine andere hw optimiert ist.

Schlimm genug das ich aufgrund des dx11 overheats Problem, womit ich wirklich Probleme hatte, eine amd graka im sys 2 ebenfalls gegen eine nV Karte tauschen MUSSTE, nur um in den betreffenden Spielen erwartete Performance zu haben ohne gleich die komplette Plattform wechseln zu müssen, was sie wie gesagt aktuell noch nicht lohnt für das System und sein einsatzzweck.

Vom Smarty gesendet. Autokorrektur Fehler werden später behoben.

Zuletzt bearbeitet von einem Moderator:

brometheus

Urgestein

Ich bin zugegebenermaßen mehr ein amd Sympathisant als Intel oder nV. Trotzdem kaufe ich hardware so wie ich sie brauche und für mich am besten ist und es sich anbietet.

Da stimme ich dir uneingeschränkt zu. Sowohl Intel als auch NV verfolgen ein Modell mit stark segmentierten Märkten, bei denen der Kunde für jedes einzelne Feature einen fetten Aufpreis zahlt. Leider waren die Produkte von Amd in der Vergangenheit recht schwach, wodurch man diese Kundenunfreundlichen Konzepte in Kauf nehmen musste, aber zum Glück tut sich jetzt ja was daran.

angelsdecay

Enthusiast

So das Thema 720p Test und aussage kraft bezogen ob sie denn Sinnvoll sind. bin ich logisch nachgegangen.

theoretisch müsste jede GPu die im cpu limit kommt eine andere schnellere gpu gleich schnell sein

das ist wie man öfters beobachten kann nicht ganz der Fall

Ich habe nach langen nachdenken. und probieren herausgefunden das man das so lösen kann

theoretisch hat gpu 1 bei 720p GPu Auslastung bei cpu takt 3,6ghz 95%

In 1080p aber dieselbe Auslastung (95%)nur 40fps warum

logisch würde man sagen wenn 720p schon min 60fps hat wieso dann nicht in 1080p

das liegt an der Auflösung

entgegengesetzt Meinungen das Auflösung allein die gpu verantwortlich ist stimmt das nicht ganz.

Die Zeichnungsbefehle (drawcalls) werden ja mehr je höher die Auflösung

Somit wird von der CPu mehr Daten verlangt

So kann man die Gleichung bereitstellen

60fps mal 1280 Zeilen geteilt durch 1920 Zeilen, die min und max werte bei 1080p mit 95% Auslastung der gpu.

Sieht dann so aus 60*1280/1920=40fps

Warum keine fläche als Rechnung?

Das ist im Grunde egal ob nun die Höhe oder die breite genommen wird.

Nimmt man die fläche also 1920*108110 muss man das ergebnis mal 2 nehmen weil fps in zeilen gelten und nicht als fläche. in 3d darstellung aber wohl oculust rift und co

Nun zu gpu 2 wieso hat eine gtx1080 deutlich mehr fps obwohl diese auch mit 95% Auslastung hat in 1080p wie eine gtx1060

Das liegt daran das man einfach die textur und raster operation Einheiten sowie die shader und den gpu Takt berücksichtigen muss

mathe

gtx1060 - gtx1080

60fps/80tmu*160tmu=120fps

60/1923 gpu coreclock*1733gpu core clock=54

60/48rop*64rop=80

60/1280shader*2048shader=96

(120+54+80+96)/4= 87,5fps bei einer gtx1080 anstatt 60fps einer gtx1060

man könnte noch den vram Takt dazunehmen

dann wäre es 85fps

ausgehend von 3dmark firstrike gpu test 2

Die Taktfrequenzen gtx 1060 1923mhz und gtx1080 1733 entnahm ich als bsp es gibt solche Ergebnisse in 3dmark results nicht daher dient das nur als bsp

Dort übliche gtx1080 Takt ist 2100mhz

Das Ergebnis kann vom realen Endwert abweichen.

Das liegt zum einen an CPu Takt und somit cpu limit ~5-10% zum anderen am OS

theoretisch ist der Annäherungswert von 720p Test nur in diesen Szenario als CPu Zukunftsvorhersage möglich.

Die große unbekannte ist ob die cpu noch für die schnellste gpu genug drawcalls bereitstellen kann in 1080p bzw 720p

Dann muss der cpu Takt soweit angehoben werden bis die gpu voll ausgelastet ist

Erst dann kann man die min max fps feststellen und gpu vergleichen ob die cpu ausreicht um bei der nächsten gpu gen genug fps darzustellen.

Das Problem das langsam eintritt ist das die gpu zu schnell werden und oft schon die CPU in 1080p limitiert

Das liegt am leidigen Directx Problem das CPU Takt die gpu auslasten kann. In DX12 (vulkan per gpgpu) wird das Umgangen

Aber eine gtx1080ti bekommt man einfach nicht ausgelastet in 1080p mit nur 4ghz takt eher sind schon 4,8ghz notwendig.

egal ob die spiele mehr cores benötigen.

Ausnahmen bestätigen die Regel ,die max fps richten sich nach dem cpu Takt.

tmu = textur mapping unit. Das macht Dreiecke im Prinzip die Auflösung und je mehr desto besser. leichter Einfluss auf fps (abk gt/s)

shader = shader, gpu Recheneinheiten dadurch wird die Geschwindigkeit der gpu bestimmt (abk gflops wichtig dabei das Ergebnis der Rechnung wird mal 2 genommen weil shader immer 2 Operationen gleichzeitig erledigen)

gpu core clock = gpu Takt je höher desto schneller beeinflusst alles in der gpu (abk mhz bzw ghz)

ROP = raster operation Das füllt den Bildschirm mit Farben und Bildern.(abk GP/s)

Somit ist die frage nach Sinn der 720p Test geklärt weil mathematisch fast geklärt.

Ungenauigkeiten bleiben weil kein Test, nicht mal benchmarks 100% gleich sind und bis zu 10% abweichen können.

generell kann man sagen das gpu OC mittlerweile völlig sinnrfrei ist

Es mangelt heutzutage an cpu Einzelkern Takt. und wir sind an einer wand 5ghz gekommen. Bei hexacores ist derzeit Schluss bei 4,4ghz mit lukü.

Das dx11 Ein Kern Problem von MS muss entfernt werden.

theoretisch müsste jede GPu die im cpu limit kommt eine andere schnellere gpu gleich schnell sein

das ist wie man öfters beobachten kann nicht ganz der Fall

Ich habe nach langen nachdenken. und probieren herausgefunden das man das so lösen kann

theoretisch hat gpu 1 bei 720p GPu Auslastung bei cpu takt 3,6ghz 95%

In 1080p aber dieselbe Auslastung (95%)nur 40fps warum

logisch würde man sagen wenn 720p schon min 60fps hat wieso dann nicht in 1080p

das liegt an der Auflösung

entgegengesetzt Meinungen das Auflösung allein die gpu verantwortlich ist stimmt das nicht ganz.

Die Zeichnungsbefehle (drawcalls) werden ja mehr je höher die Auflösung

Somit wird von der CPu mehr Daten verlangt

So kann man die Gleichung bereitstellen

60fps mal 1280 Zeilen geteilt durch 1920 Zeilen, die min und max werte bei 1080p mit 95% Auslastung der gpu.

Sieht dann so aus 60*1280/1920=40fps

Warum keine fläche als Rechnung?

Das ist im Grunde egal ob nun die Höhe oder die breite genommen wird.

Nimmt man die fläche also 1920*108110 muss man das ergebnis mal 2 nehmen weil fps in zeilen gelten und nicht als fläche. in 3d darstellung aber wohl oculust rift und co

Nun zu gpu 2 wieso hat eine gtx1080 deutlich mehr fps obwohl diese auch mit 95% Auslastung hat in 1080p wie eine gtx1060

Das liegt daran das man einfach die textur und raster operation Einheiten sowie die shader und den gpu Takt berücksichtigen muss

mathe

gtx1060 - gtx1080

60fps/80tmu*160tmu=120fps

60/1923 gpu coreclock*1733gpu core clock=54

60/48rop*64rop=80

60/1280shader*2048shader=96

(120+54+80+96)/4= 87,5fps bei einer gtx1080 anstatt 60fps einer gtx1060

man könnte noch den vram Takt dazunehmen

dann wäre es 85fps

ausgehend von 3dmark firstrike gpu test 2

Die Taktfrequenzen gtx 1060 1923mhz und gtx1080 1733 entnahm ich als bsp es gibt solche Ergebnisse in 3dmark results nicht daher dient das nur als bsp

Dort übliche gtx1080 Takt ist 2100mhz

Das Ergebnis kann vom realen Endwert abweichen.

Das liegt zum einen an CPu Takt und somit cpu limit ~5-10% zum anderen am OS

theoretisch ist der Annäherungswert von 720p Test nur in diesen Szenario als CPu Zukunftsvorhersage möglich.

Die große unbekannte ist ob die cpu noch für die schnellste gpu genug drawcalls bereitstellen kann in 1080p bzw 720p

Dann muss der cpu Takt soweit angehoben werden bis die gpu voll ausgelastet ist

Erst dann kann man die min max fps feststellen und gpu vergleichen ob die cpu ausreicht um bei der nächsten gpu gen genug fps darzustellen.

Das Problem das langsam eintritt ist das die gpu zu schnell werden und oft schon die CPU in 1080p limitiert

Das liegt am leidigen Directx Problem das CPU Takt die gpu auslasten kann. In DX12 (vulkan per gpgpu) wird das Umgangen

Aber eine gtx1080ti bekommt man einfach nicht ausgelastet in 1080p mit nur 4ghz takt eher sind schon 4,8ghz notwendig.

egal ob die spiele mehr cores benötigen.

Ausnahmen bestätigen die Regel ,die max fps richten sich nach dem cpu Takt.

tmu = textur mapping unit. Das macht Dreiecke im Prinzip die Auflösung und je mehr desto besser. leichter Einfluss auf fps (abk gt/s)

shader = shader, gpu Recheneinheiten dadurch wird die Geschwindigkeit der gpu bestimmt (abk gflops wichtig dabei das Ergebnis der Rechnung wird mal 2 genommen weil shader immer 2 Operationen gleichzeitig erledigen)

gpu core clock = gpu Takt je höher desto schneller beeinflusst alles in der gpu (abk mhz bzw ghz)

ROP = raster operation Das füllt den Bildschirm mit Farben und Bildern.(abk GP/s)

Somit ist die frage nach Sinn der 720p Test geklärt weil mathematisch fast geklärt.

Ungenauigkeiten bleiben weil kein Test, nicht mal benchmarks 100% gleich sind und bis zu 10% abweichen können.

generell kann man sagen das gpu OC mittlerweile völlig sinnrfrei ist

Es mangelt heutzutage an cpu Einzelkern Takt. und wir sind an einer wand 5ghz gekommen. Bei hexacores ist derzeit Schluss bei 4,4ghz mit lukü.

Das dx11 Ein Kern Problem von MS muss entfernt werden.

@angelsdecay

Ich glaube nicht, dass die Draw Calls wirklich von der Auflösung abhängen.

Bei den Draw Calls muss die CPU ja nur die Position der Objekt berechnen und durch eine höhere Auflösung kommen ja nicht einfach Objekte hinzu. Bei Spielen hat man oft Vektoren mit 3 Koordinaten, um die Eckpunkte (3D) abzubilden.

Ich glaube nicht, dass die Draw Calls wirklich von der Auflösung abhängen.

Bei den Draw Calls muss die CPU ja nur die Position der Objekt berechnen und durch eine höhere Auflösung kommen ja nicht einfach Objekte hinzu. Bei Spielen hat man oft Vektoren mit 3 Koordinaten, um die Eckpunkte (3D) abzubilden.

Zuletzt bearbeitet:

angelsdecay

Enthusiast

ja und nein

Warum nun Objekte in HD sind weniger detailliert und haben Unter Umständen auch weniger punkte wo sich was bewegt.

bsp 16pixel haben 4 Bewegungspunkte wodurch Position verändert werden

In FHD aber sind es 36pixel und dann 9 Punkte wo sich was bewegt

Das tritt nicht auf jedes game zu aber das hängt stark davon ab für welche Auflösung man ein Spiel entwickelt.

Bis 2012/13 war es so das HD und FHD die min fps identische waren weil alle Spiele in 720p konzeptioniert wurden dank PS3 xbox360

Ab 2013/14 ist die Auflösung aber 1080p und somit sind viele Charaktermodelle detaillierter und haben höhere Bewegungspunkte

Und davon auch mehr.ob nun 200 zerg bei starcraft2 je Charaktermodelle im 720p je 4 Punkte haben um die Textur zu bewegen oder je 8 Punkte verdoppelt die CPU last.

Das wäre ein extrem bsp, was ich zuletzt erlebt habe. Zerg Massenschlacht 600 Einheiten von 130fps auf 10fps in 1080p

Und in 720p durch den niedrigeren cpu last aber 150-20fps

Gezielt solche Szenen nachstellen ist schwer, am besten geht das in der Kampagne.

Warum nun Objekte in HD sind weniger detailliert und haben Unter Umständen auch weniger punkte wo sich was bewegt.

bsp 16pixel haben 4 Bewegungspunkte wodurch Position verändert werden

In FHD aber sind es 36pixel und dann 9 Punkte wo sich was bewegt

Das tritt nicht auf jedes game zu aber das hängt stark davon ab für welche Auflösung man ein Spiel entwickelt.

Bis 2012/13 war es so das HD und FHD die min fps identische waren weil alle Spiele in 720p konzeptioniert wurden dank PS3 xbox360

Ab 2013/14 ist die Auflösung aber 1080p und somit sind viele Charaktermodelle detaillierter und haben höhere Bewegungspunkte

Und davon auch mehr.ob nun 200 zerg bei starcraft2 je Charaktermodelle im 720p je 4 Punkte haben um die Textur zu bewegen oder je 8 Punkte verdoppelt die CPU last.

Das wäre ein extrem bsp, was ich zuletzt erlebt habe. Zerg Massenschlacht 600 Einheiten von 130fps auf 10fps in 1080p

Und in 720p durch den niedrigeren cpu last aber 150-20fps

Gezielt solche Szenen nachstellen ist schwer, am besten geht das in der Kampagne.

REDFROG

Enthusiast

OkDie wenigsten Spiele Entwickler werden da richtung Ryzon gehen....

Ähnliche Themen

M

- Antworten

- 10

- Aufrufe

- 1K

- Antworten

- 27

- Aufrufe

- 2K

M

- Antworten

- 1

- Aufrufe

- 452

- Antworten

- 83

- Aufrufe

- 7K