super Test, danke

bin nur enttäuscht, die Leistung an sich geht in Ordnung, aber für keine 900 Euro.

bin nur enttäuscht, die Leistung an sich geht in Ordnung, aber für keine 900 Euro.

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Der Preis für diese Leistung sollte bei max 550€-600€ liegen, wen ich den FC3 Bench sehe wird mir schlecht, da ist sie genau so schnell wie eine 680 er bei den Min FPS..

Schade, wird nicht gekauft...

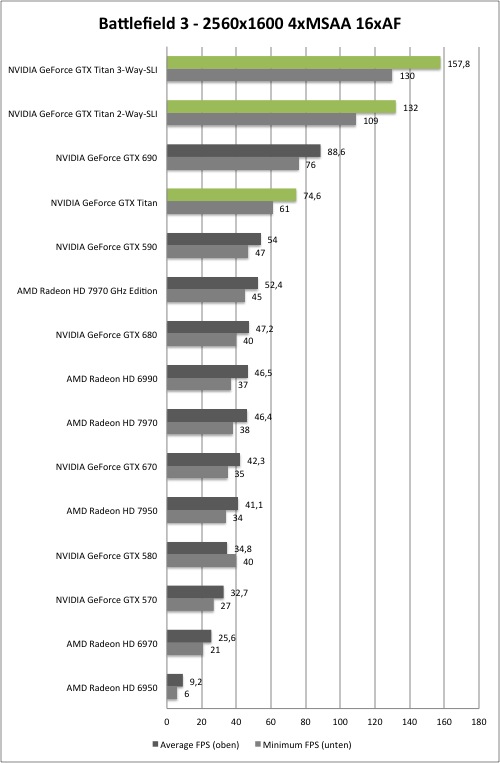

Bei BF3 stimmt was mit den Werten der GTX 580 nicht. Da sind die Min-FPS höher als die Average. Werte versehentlich vertauscht?!

Wann kann ich die kaufen?

@Don/ Redaktion

Gerade bei der Titan interessiert mich besonders die CPU Computing Leistung in der realen Welt. Wo Nvidia seit der GTX 480 immer weiter abgebaut hat, hat AMD derzeit Leistungstechnisch die Nase deutlich vorne, wird aber bei professioneller Software kaum Unterstützt.

Möchte man in der 3D-Branche auf der GPU Rendern, ist man also derzeit quasi auf Nvidia angewiesen.

Leider gibt es für iRay und Vray keinen Benchmark (außer selbst erstellte Demoszenen), für den octane Renderer gibt es allerdings eine Szene vom Hersteller direkt. Kann einfach hier heruntergeladen werden: Octane Render. Demoszenen gibt es auch unter dem Link

Wäre echt klasse, denn im Gegensatz zu Luxmark oder sonstigen Synthetischen Tests ist Octane eine Anwendung die wirklich genutzt wird und auch vom Rating her nah an Vray RT liegt.

die +50% zur 680 sind nicht geblieben, wurde ja fleißig mit solchen Werten um sich geworfen.

Am Ende sinds 20-30% geworden... ernüchternd

Ich lade mir das mal herunter und schaue es mir an.

Mir sagt der OctaneRenderer, es seien keine CUDA-GPUs vorhanden.

Schonmal drüber nach gedacht wenn das Ding im CPU Limit hängt nützt die beste Karte nix schau dir die Triple Screen Benches an u du weißt bescheid was für Potential darin ist

Das Ding ist nunmal mit heutigen CPUs unten rum nicht ans Limit zu bekommen,frag doch mal Intel ob sie dir ne 7GHZ CPU basteln dann sehe das ganze Szenario in den Mickie Maus Auflösungen anderst aus

Geiles Ding, warten wir mal was Sie bringt wenn Sie von 2 Xeons Befeuert wird. Ich denk da hängt es. Thx an HWLuxx für die Benches. mfg