Werbung

Bereits nach der Vergleichstabelle behandelten wir die Anzahl der Shader-Prozessoren und andere Details in absoluten Zahlen. Nun aber soll es um die Zusammenarbeit aller Komponenten gehen.

Durch Klick auf das Bild gelangt man zu einer vergrößerten Ansicht

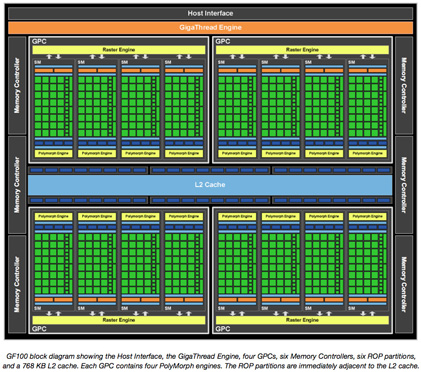

Grundsätzlich besteht die GF100-GPU aus vier Graphics Processing Clustern, 16 Streaming-Multiprozessoren und sechs Speichercontrollern. Zum Launch der ersten Karten werden sich diese anhand der Anzahl der Komponenten unterscheiden um die verschiedenen Preis-Segmente abdecken zu können.

Die CPU-Kommandos werden von der GPU über das Host-Interface gelesen. Die GigaFetch-Engine nimmt sich dann die notwendigen Daten aus dem Arbeitsspeicher und kopiert diese in den Grafikspeicher. Die Speicheranbindung setzt sich aus sechs 64-Bit-Speichercontrollern zusammen. Insgesamt ist das Speicherinterface somit 384-Bit breit und kann bis zu 6 GB GDDR5-Speicher anbinden. Je nach Ausbaustufen können also 1,5, 3 oder die vollen 6 GB verbaut werden. Die GigaThread-Engine erstellt und verteilt Thread-Blöcke und gibt diese an den Streaming-Multiprozessoren-Scheduler, wo alle anfallenden Operationen auf die Shader-Prozessoren und andere Einheiten verteilt werden.

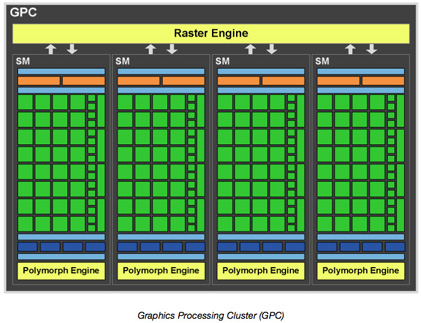

Graphics-Processing-Cluster:

Ein Graphics-Processing-Cluster besteht aus einer Raster-Engine und bis zu vier Streaming-Multiprozessoren. Die GPCs bilden den wichtigsten Block innerhalb der GF100-GPU, denn sie bilden die Basis für die wichtigsten Operationen. Das GPC arbeitet effizienter als vorangegangenen Architekturen, da es Vertex-, Geometrie-, Textur- und Pixel-Operationen vereint und gleichzeitig mit den Anforderungen skaliert.

Durch Klick auf das Bild gelangt man zu einer vergrößerten Ansicht