Werbung

64kB shared-Memory und L1-Cache:

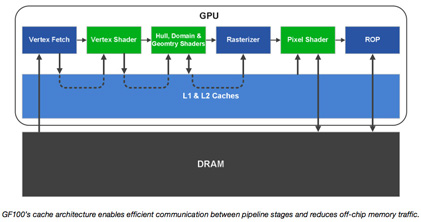

In der GF100-GPU stehen 64 kB shared-Memory pro Streaming-Multiprozessor zur Verfügung. 48 kB sind dabei frei konfigurierbar, 16 kB werden dann als L1-Cache verwendet. Es besteht aber ebenfalls die Möglichkeit 16 kB shared-Memory zu verwenden, dann sind 48 kB L1-Cache verfügbar.

Ein shared-Memory sorgt dafür, dass Daten, die von mehreren Threads verwendet werden, nicht mehr vom Speicher in die GPU und zurückgeschrieben werden müssen, sondern sozusagen auf der GPU verbleiben können. Dadurch können Berechnungen deutlich schneller ausgeführt werden.

L2-Cache:

Für den schnellen Datenaustausch innerhalb der GPU ebenfalls wichtig ist der L2-Cache. Dieser ist bei der GF100-GPU 768 kB groß. Er vereint Speicher-Systeme aus früheren Architekturen. So ersetzt er den L2-Texture-Cache, ROP-Cache und die On-Chip-FIFOs. Zudem ist er der zentrale Anlaufpunkt für alle Algorithmen, die auf Daten zurückgreifen müssen, die zu Beginn ihrer Berechnungen noch gar nicht vorlagen. Beispiele sind hier Physik-Berechnungen und Ray-Tracing. Zudem war es in früheren Architekturen üblich bestimmte Schreib- und Lesepfade einzupflegen. So gab es einen write-only ROP-Pfad oder aber einen read-only Texture-Pfad. Der L2-Cache besitzt so genannte "unified read/write" Pfade und ist damit deutlich flexibler, da gewisse Lese- oder Schreibzugriffe nicht mehr so oft blockiert sein können.

Durch Klick auf das Bild gelangt man zu einer vergrößerten Ansicht