Bisher haben wir nur einige Tech-Demos zur Verfügung, um die GeForce-RTX-exklusiven Funktionen wie DLSS (Deep Learning Super Sampling) und einige RTX-Effekte ausprobieren zu können. Im Rahmen der Tests zur GeForce RTX 2080 und GeForce RTX 2080 Ti sowie dem ersten Modell der GeForce RTX 2070 haben wir uns die Leistung von DLSS in zwei Tech-Demos sowie die Ray-Tracing-Leistung im Zusammenspiel mit DLSS bereits angeschaut.

Bisher aber beschränken sich die belastbaren Benchmarks auf die reine Rasterization-Leistung über die klassische Render-Pipeline. Damit einher geht auch, dass wir die Leistungsaufnahme der Karte nur unter diesen Bedingungen getestet haben. Was aber passiert, wenn zu den Shadern auch noch die Tensor- und RT-Cores hinzukommen? Taktet die GPU dann geringer, weil mehr "Recheneinheiten" aktiv sind? Und wie sieht es mit der Leistungsaufnahme aus?

Hier die bisherigen Benchmarks zu den drei GeForce-RTX-Karten:

Final Fantasy XV Benchmark

3.840 x 2.160

Werbung

UE4-Demo Infiltrator

3.840 x 2.160

Star Wars Elevator Demo

Ray Tracing + DLSS - 2.560 x 1.440 Pixel

Star Wars Elevator Demo

Ray Tracing - 3.840 x 2.160 Pixel

Doch wir wollen etwas tiefer in das Thema einsteigen. NVIDIA gibt für die GeForce RTX 2080 Ti Founders Edition eine Thermal Design Power von 260 W an. Misst man nur den Verbrauch der Karte, hält sich diese auch an das gesetzte Limit. Eine Vollauslastung der Shader zu erreichen, stellt kein Problem dar, doch wir wollten einmal messen was passiert, wenn auch die Tensor und RT Cores aktiv werden.

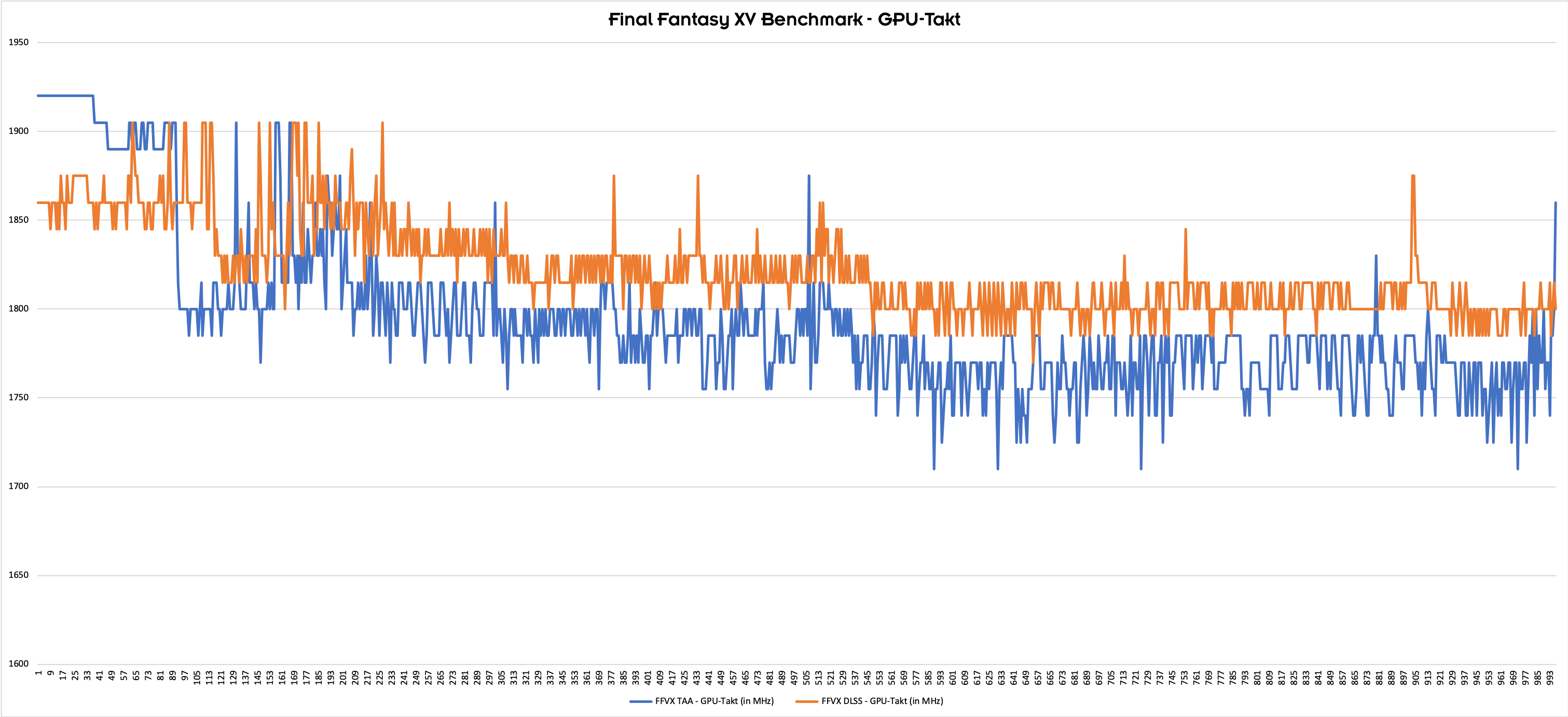

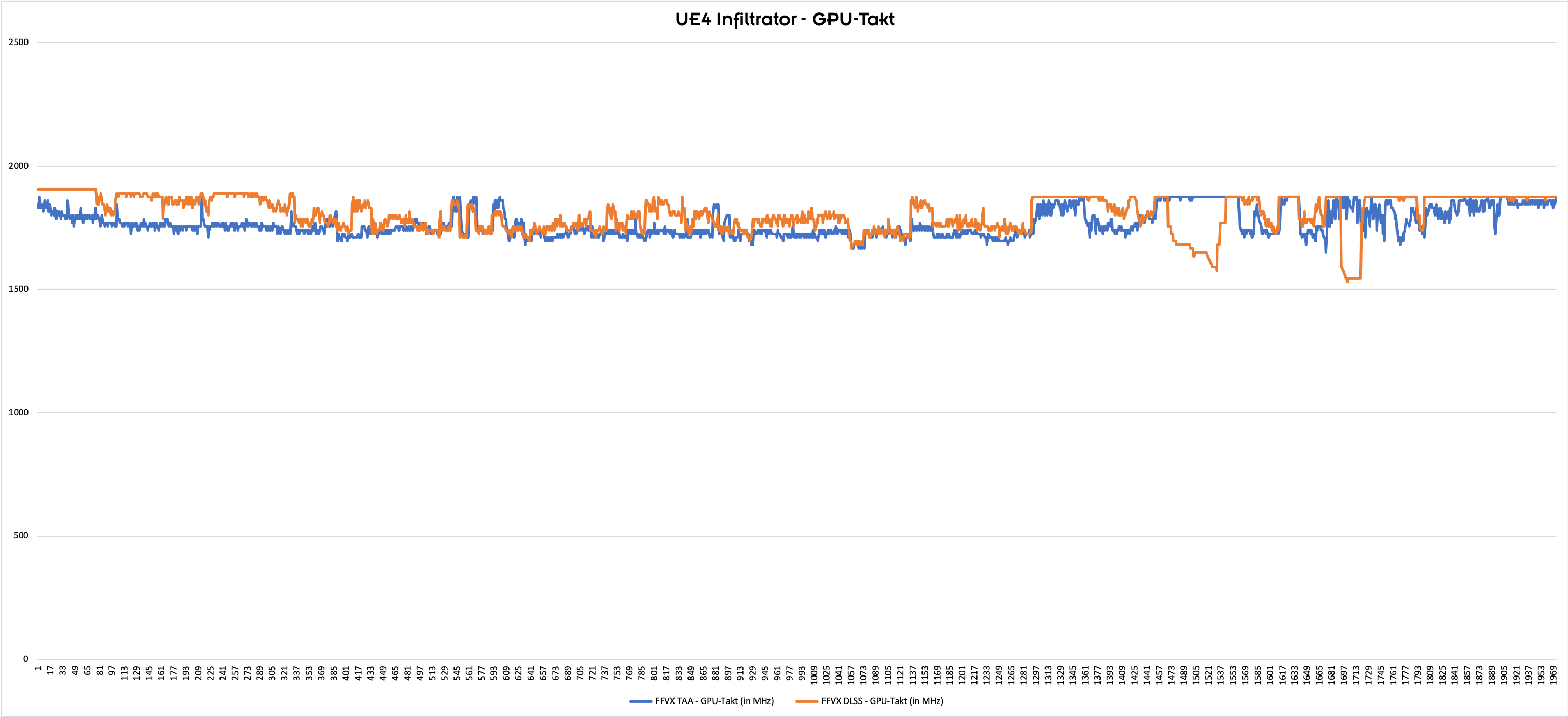

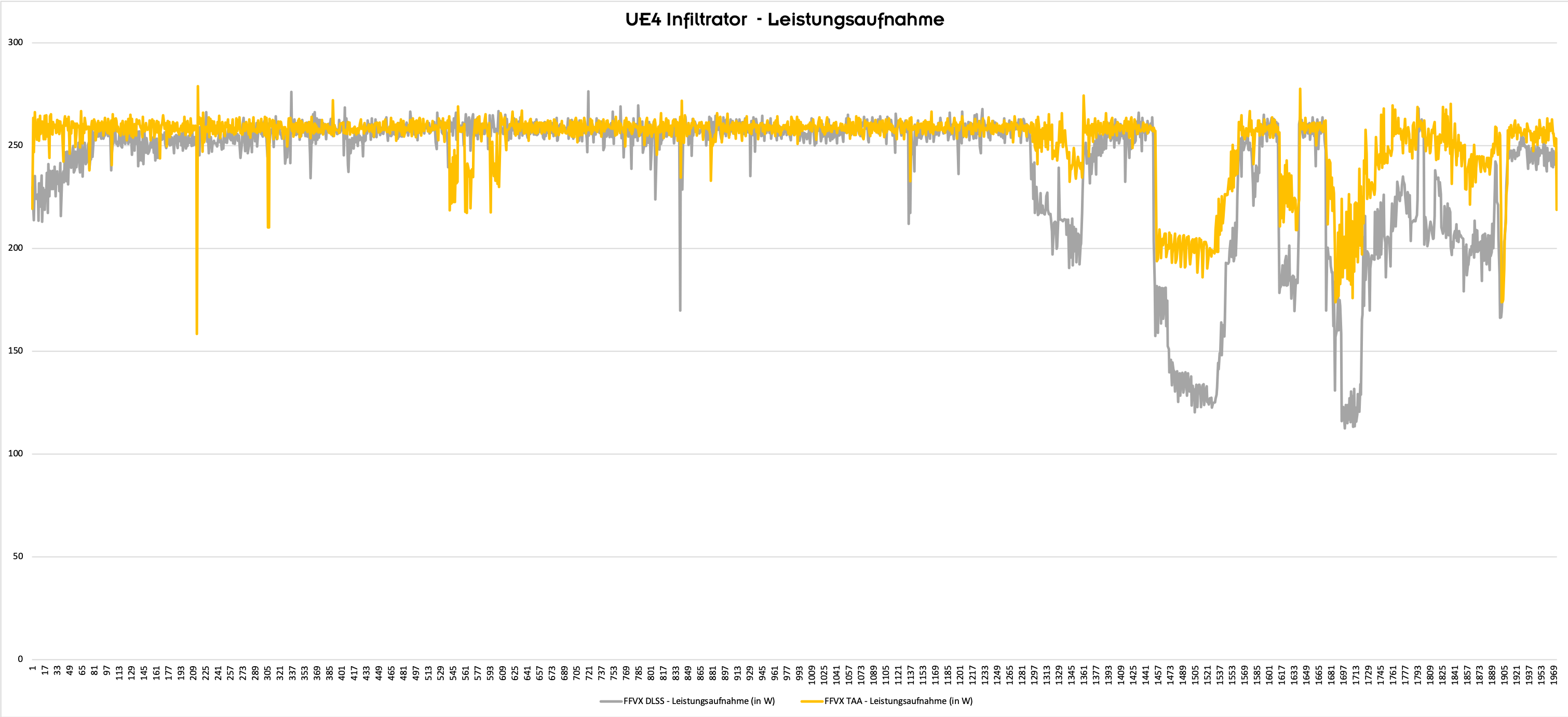

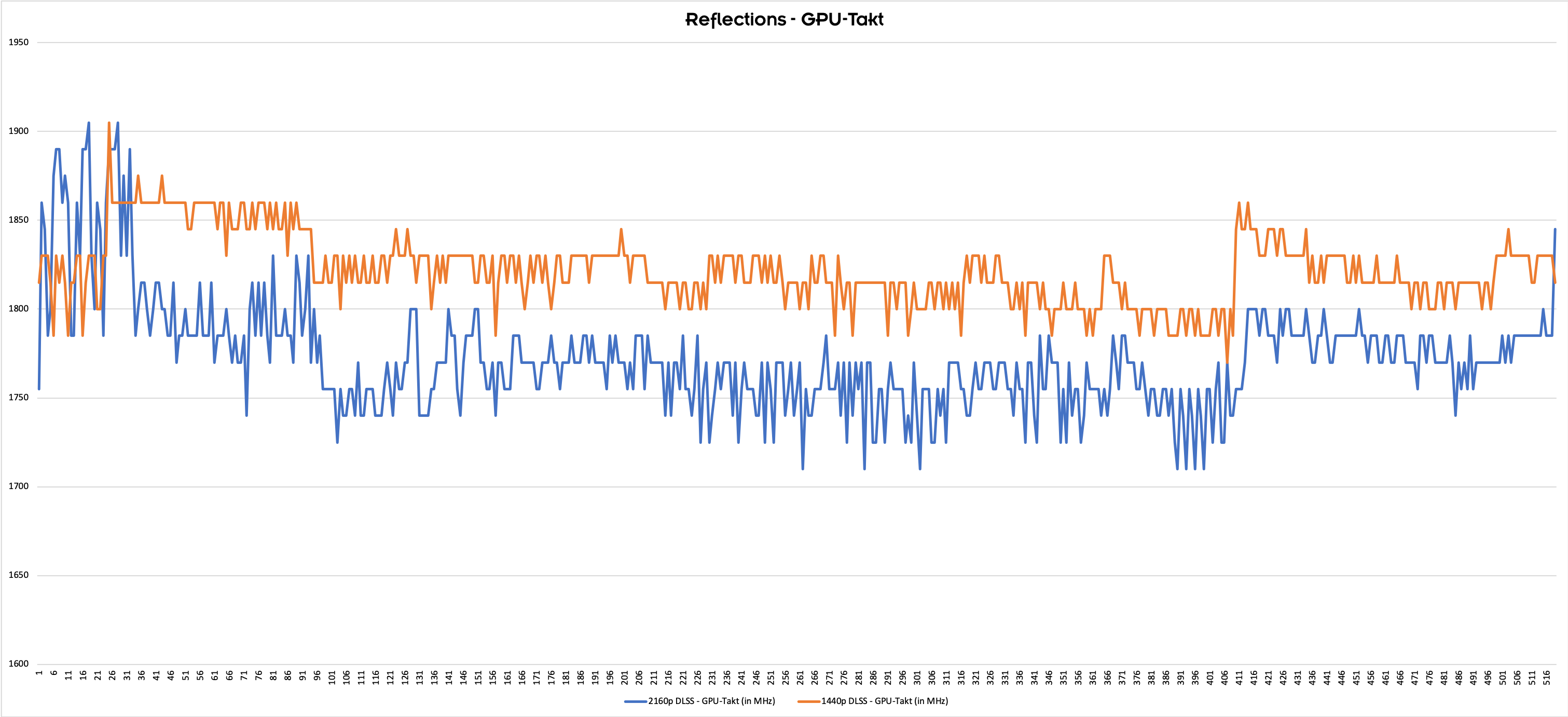

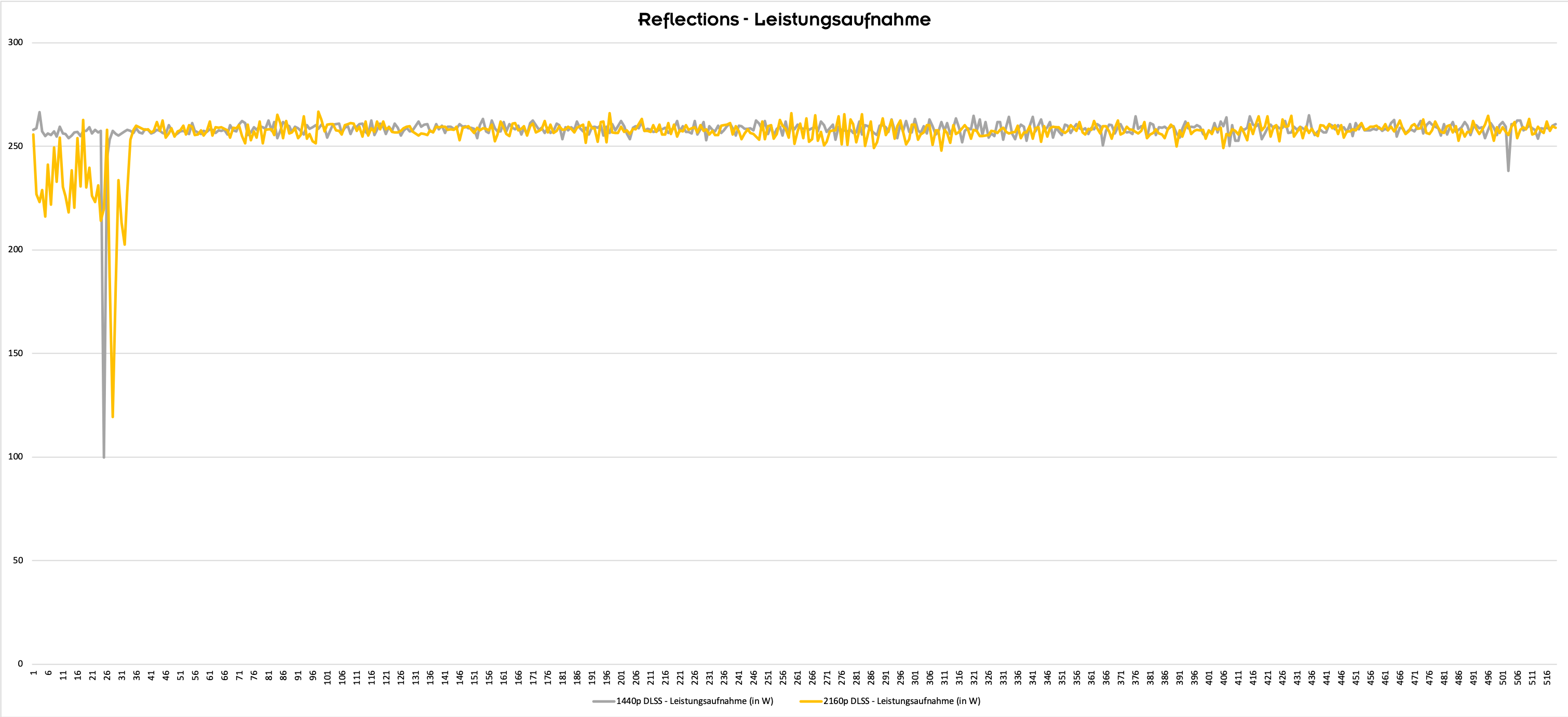

Für die Tests haben wir eine GeForce RTX 2080 Ti Founders Edition verwendet. An Software zum Einsatz kam der spezielle Benchmark von Final Fantasy XV, der mit TAA und DLSS ausgeführt wird und die Unreal Engine 4 Demo "Infiltrator", die ebenfalls mit TAA und DLSS ausgeführt werden kann sowie die Ray-Tracing-Tech-Demo "Reflections".

Über den Wechsel zwischen einer Berechnung mit TAA und mit DLSS-Unterstützung können wir für Final Fantasy XV und "Infiltrator" die Tensor Cores aktivieren. In den Standardeinstellungen von "Reflections" läuft die Demo bei einer Auflösung von 2.560 x 1.440 Pixel mit aktiviertem DLSS und rendert in einer unbekannten, niedrigeren Auflösung von vermutlich 1.280 x 720 Pixeln. Wird das 2160p-Preset für 3.840 x 2.160 Pixel mit DLSS gewählt, findet das Rendering auf nativen 1.920 x 1.080 Pixeln statt.

Aufgezeichnet wurde jeweils der GPU-Takt (per Software ausgelesen) und die Leistungsaufnahme (per Stromzange an den beiden 8-Pin-Anschlüssen und dem PCI-Express-Steckplatz. Zugleich wurde die Spannung gemessen und beides in 0,1 ms Abständen aufgezeichnet).

Final Fantasy XV (DLSS)

"Infiltrator" (DLSS)

"Reflections"? (DLSS + RTX)

Für die Leistungsaufnahme ist die Analyse recht einfach: Die Karte kommt unter Last immer auf ihre maximale Thermal Design Power, was auch nicht weiter überraschend ist. Besonders Final Fantasy XV und "Reflections" zeigen sehr deutlich dieses Verhalten. In der "Infiltrator"-Demo sehen wir am Ende der Demo einen minimal geringeren GPU-Takt und auch eine geringere Leistungsaufnahme. Warum dies ausgerechnet hier der Fall ist, erschließt sich uns nicht. DLSS scheint den Vorteil zu haben, dass die GPU-Last wegen des fehlenden Anti Aliasing sinkt, was wiederum den höheren GPU-Takt zur Folge hat.

Interessant ist, dass wir für "Reflections" mit DLSS und RTX zwar eine stabile Leistungsaufnahme messen, der GPU-Takt aber ist bei niedrigerer Auflösung (1440p) höher als mit einer gesteigerten Auflösung (2160p). Grund hierfür könnte sein, dass die RT Cores bei höherer Auflösung deutlich mehr zu tun haben und das Power-Budget mit den Shadern geteilt werden muss, was wiederum einen niedrigeren Takt dieser Recheneinheiten zur Folge hat. Womöglich greift aber auch hier das Argument der niedrigeren GPU-Last durch die geringere Auflösung.

An dieser Stelle sei aber auch erwähnt, dass alle Messungen auf Basis speziell angepasster Tech-Demos entstanden sind. Auch gut einen Monat nach dem offiziellen Verkaufsstart der Karten gibt es kein Spiel, welches DLSS oder die RTX-Funktionen unterstützt. Besonders die fehlende Unterstützung von DLSS in Spielen ist auffällig, denn eigentlich sollte dies laut Aussage von NVIDIA problemlos zu integrieren sein. Einige Spiele auf der Liste, die DLSS später einmal unterstützen sollen, sind auch schon erschienen. Dazu gehören Ark: Survival Evolved, Final Fantasy XV: Windows Edition, Player Unknown’s Battlegrounds und Shadow of the Tomb Raider. Eigentlich sollte ein Training des Deep-Learning-Netzwerks auf dem Supercomputer bei NVIDIA in der gewünschten Zielauflösung ausreichen, um DLSS zu ermöglichen. Doch ganz so einfach scheint es dann wohl doch nicht zu sein.

Auf Seiten der RTX-Spiele erwartet uns am 19. November Battlefield V. Wann der Patch für Shadow of the Tomb Raider erscheint, steht noch in den Sternen. Für das kommende Jahr sind noch einige weitere Titel mit RTX-Unterstützung angekündigt, auf die Besitzer einer GeForce-RTX-Karte sicherlich sehnsüchtig warten.

'It just works" wurde von NVIDIA im Rahmen der Präsentation der GeForce-RTX-Karten mehrfach betont. So einfach scheint das Ganze aber offenbar doch nicht zu sein. Die aktuelle und letzte Version der GeForce Experience 3.15.0.186 nennt zumindest schon einmal die Unterstützung der GeForce-RTX-Karten:

"Ab sofort werden GeForce RTX-Grafikkarten unterstützt. So kannst du deine Gaming-Maschine mit Game Ready-Treibern und optimalen Spieleeinstellungen optimieren und Inhalte mit Ansel, Freestyle und Highlights aufnehmen. GeForce Experience unterstützt jetzt außerdem RTX-Technologien wie das Deep-Learning-Super-Sampling (DLSS)."

Wie sich die Turing-GPUs genau verhalten, wenn die Tensor- und/oder RT-Cores hinzukommen, werden wir noch sehen müssen. Spiele, die DXR/RTX-Effekte zu- und abschalten lassen, könnten hier weitere Erkenntnisse liefern. Derzeit gibt es aber noch keines. Bei NVIDIA haben wir angefragt, ob es dazu offizielle Informationen gibt. Auf dem Tech Day wurde lediglich mitgeteilt, dass Shadereinheiten, RT-Cores und Tensor-Cores gleichzeitig laufen können. Eine vollständige Auslastung bei 100 % aller drei Komponenten käme in der Praxis nicht vor. Wie sich die Ressourcen hinsichtlich des Power-Budgets verhalten, ist unbekannt.