Werbung

Es gibt eine neue Runde unabhängiger, bzw. gegenseitig geprüfter Benchmark-Ergebnisse aus dem Server-Bereich. Genauer gesagt geht es um die Inferencing-Ergebnisse in der Version 2.1. Diese sollen eine unabhängige Beurteilung der Server-Systeme in den verschiedenen Anwendungsbereichen ermöglichen. Große Unternehmen werden natürlich weiterhin eine eigene Evaluierung vornehmen, aber in der Außendarstellung konnten die Hersteller meist nur mit eigenen Benchmarks aufwarten, denen natürlich mit Skepsis begegnet wurde.

Für die Inferencing-Ergebnisse 2.1 hat die MLCommons diverse Datacenter- und Edge-Anwendungen neu aufgestellt. Möglichst viele Szenarien sollen praxisrelevant abgedeckt werden. Aus dem Alltag sind viele der Anwendungen kaum mehr wegzudenken. Als Beispiel sei eine Anfrage an den Sprachassistenten genannt, der ein Musikstück erkennen soll. Sprache zu Text, Text auswerten, Musik erkennen und analysieren, in der Datenbank nach dem entsprechenden Eintrag suchen und eine Empfehlung geben und am Schluss womöglich wieder eine Sprachausgabe. Alleine ein solch vermeintlich einfache Aufgabe beinhaltet bereits zahlreiche Schritte, die auf KI-Systemen in Rechenzentren abgearbeitet werden müssen.

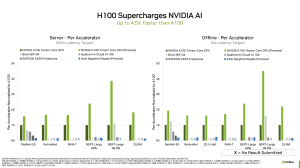

Aber kommen wir nun zu den Ergebnisse. Diese sind wie immer in Form einer Tabelle bei MLCommons abrufbar. NVIDIA hat die Ergebnisse in Teilen grafisch aufbereitet und gibt eine gute Übersicht über die Ergebnisse.

NVIDIA sah sich bisher mit dem A100-Beschleuniger in einer alleinige Vorreiterrolle. In den vergangenen Ergebnisrunden gab es aber immer wieder sogenannte Edge Cases, in denen ihnen Konkurrenz gemacht werden konnte. Alleine aber schon durch die Skalierung auf mehrere tausend Beschleuniger in einem System ermöglicht es NVIDIA in Sachen Leistung derzeit unschlagbar zu sein. Die Effizienz spielt dabei häufig keine große Rolle. Vielmehr geht es um kurze Berechnungszeiten, um immer wieder schnell zu neuen Ergebnisse zu kommen.

In der aktuellen Runde liefert NVIDIA erstmals Ergebnisse mit dem neuen H100-Beschleuniger auf Basis der Hopper-Architektur. Im Vergleich zu A100 ist dieser um den Faktor 1,5 bis 4,5 schneller. Wir sehen hier also wieder einmal neue Hardware, in den vergangenen Runden sahen wir meist nur Verbesserungen durch eine effektivere Aufbereitung der Daten, bzw. effizientere Software.

Neu sind auch die Ergebnisse des chinesischen Startups Biren, die ihren BR104-Chip erst kürzlich auf der Hotchips-Konferenz genauer vorstellten. Beim BR104 handelt es sich um einen PCIe-Beschleuniger mit einer TDP von 300 W, was die Leistung auch noch einmal herausstellt, denn NVIDIA vergleicht hier mit den eigenen A100- und H100-Beschleunigern, die sich 500 W und mehr genehmigen dürfen. Für ResNet-50 und BERT-Large 99.9% lieferte Biren Ergebnisse und kann hier auch überzeugen. Man hat sich für den chinesischen Markt auf Bild- und Texterkennung spezialisiert und sich daher auch darauf konzentriert.

Auch der südkoreanische Telekomriese sk.telekom schickt mit SAPEON sein hauseigenen Startup, bzw. dessen Hardware ins Rennen. Diese verwenden den X220-Beschleuniger als PCIe-Express-Karte bei sparsamen 75 W und kommen auch damit auf beachtliche Ergebnisse. Man beschränkt sich zwar auch hier auf nur wenige Anwendungsbereiche, sieht darin jedoch den Fokus der eigenen Entwicklung.

Intel lieferte nur einige Preview-Ergebnisse auf Basis von Sapphire Rapids. Ob auch Ponte Vecchio für MLPerf einmal eine Rolle spielen wird, ist nicht ganz klar. Zum jetzigen Zeitpunkt jedenfalls nicht.

Auch wenn einige Neuankömmlinge also durchaus ihren Fußabdruck in den aktuellen Ergebnisse hinterlassen haben, NVIDIA bleibt die dominierende Macht. Dies machte sich manche Ergebnisse in der Vergangenheit langweilig erdrückend. Davon kann nun nicht die Rede sein, denn es gibt durchaus einige spannende Entwicklungen und Unternehmen mit guten Ideen.

Neben der Marktmacht hat NVIDIA den Vorteil, dass man nahezu alle Anwendungsbereiche des Inferencings abdecken kann. Vom sparsamen Edge-System bis zum Datacenter-Cluster. Dank Unterheilung der Hardware in virtuelle Bereiche (MIG) kann ein großer GPU-Beschleuniger sogar mehrere Aufgaben gleichzeitig übernehmen – komplett unabhängig voneinander. Auch innerhalb der Anwendungen selbst ist man breit aufgestellt und kann für nahezu alles eine Lösung liefern. Die kleineren Hersteller hingegen konzentrieren sich auf bestimmte Bereiche.

Schlussendlich sind die Benchmark-Ergebnisse von MLPerf Inference 2.1 ein guter Anhaltspunkt für die Leistung der Systeme. Es zeigt sich aber auch, wie zugeschnitten manche Lösungen sein können und das eine einheitliche Vergleichsbasis nur schwer herzustellen ist.