MehlstaubtheCat

Urgestein

- Mitglied seit

- 03.08.2013

- Beiträge

- 2.035

- Desktop System

- Waltraud

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X3D "geschliffen" @100,3125 MHz BCLK, "13150 CPU-Score Time Spy" "15310 CB R23"

- Mainboard

- ASUS ROG Crosshair VIII Dark Hero

- Kühler

- Artic Frezzer II 360, Revision 7

- Speicher

- 32GB (2x16GB) G.Skill Ripjaws V DDR4-4000 CL16@3811MHz Timings "ultra scharf" (B-Dies)

- Grafikprozessor

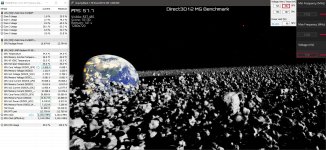

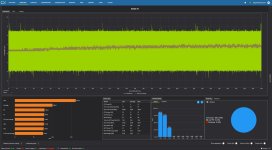

- XFX Speedster SWFT 319 6900XT@OC + UV "23380 Grafik-Score Time Spy" 300Watt, 24/7 Setup! Kein Bench!

- Display

- LG C3 OLED 42" Smart TV 4k 120Hz

- SSD

- Western Digital Black SN850 1TB

- HDD

- 6 weitere HDDs

- Gehäuse

- Fractal Design Define R6 + Etwas mehr gedämmt + 5x BeQuit Silent Wings 3 140mm

- Netzteil

- Seasonic Focus GX Plus Gold 850 Watt

- Mouse

- Razer Viper V3 Hyperspeed

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Sonstiges

- Razer Orbweaver mit braunen Cherrys

- Internet

- ▼250 ▲50

Hi@all!

Ich habe im "Offizieller AMD [[ RX6700 // RX 6700XT // 6750XT // X6800 // 6800XT // 6900XT // 6950XT]] Overclocking und Modding Thread [[ Wakü - Lukü - LN2]]"

Einen Post geschrieben bei dem mich @ApolloX hier in diesen Thread verwiesen hat.

#27777

Da ich aktuell etwas Zeit habe, würde ich gerne etwas "tiefer" in den Bereich UV einer 6900XT eintauchen.

Mein Ziel etwas mehr an Leistung in den Bereichen zu erreichen, in den ich MPT bisher nicht verstehe und ich deshalb dort nichts eingestellt habe.

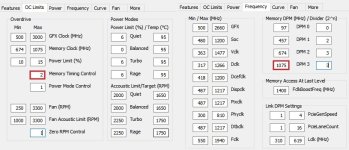

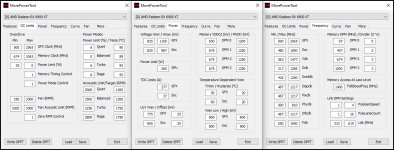

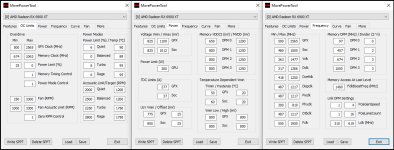

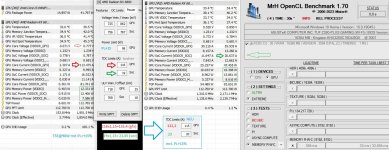

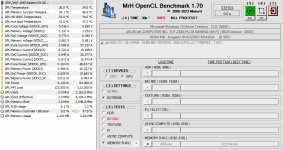

Das hier sind meine aktuellen Einstellungen:

Das ich hier nichts neu schreiben muss wäre es vielleicht nett wenn ihr den oben verlinken Post anschauen könnt.

Was kann ich alles verändern um noch etwas mehr Leistung zu generieren?

Kein Bench das soll 24/7 stabil dann sein.

Gruß

Mehlstaub

Ich habe im "Offizieller AMD [[ RX6700 // RX 6700XT // 6750XT // X6800 // 6800XT // 6900XT // 6950XT]] Overclocking und Modding Thread [[ Wakü - Lukü - LN2]]"

Einen Post geschrieben bei dem mich @ApolloX hier in diesen Thread verwiesen hat.

#27777

Da ich aktuell etwas Zeit habe, würde ich gerne etwas "tiefer" in den Bereich UV einer 6900XT eintauchen.

Mein Ziel etwas mehr an Leistung in den Bereichen zu erreichen, in den ich MPT bisher nicht verstehe und ich deshalb dort nichts eingestellt habe.

Das hier sind meine aktuellen Einstellungen:

Das ich hier nichts neu schreiben muss wäre es vielleicht nett wenn ihr den oben verlinken Post anschauen könnt.

Was kann ich alles verändern um noch etwas mehr Leistung zu generieren?

Kein Bench das soll 24/7 stabil dann sein.

Gruß

Mehlstaub