tonythebuilder

Experte

Thread Starter

- Mitglied seit

- 01.09.2017

- Beiträge

- 529

- Details zu meinem Desktop

- Prozessor

- Intel Xeon w5-2455X

- Mainboard

- ASUS Pro WS W790-Ace

- Kühler

- Noctua NH-U14S DX-4677

- Speicher

- 2x 64 GB DDR5-4800 RDIMM

- Grafikprozessor

- PowerColor 7900 XT (Ref.-Design), Sapphire RX570 ITX 4GB (HwPt)

- Display

- 2x 24" Eizo

- SSD

- T-Force Carder A440 Pro 2TB, Asus Hyper M.2 X16 Gen5: 2x Kingston KC3000 2TB, Corsair MP600 GS 0.5TB

- Soundkarte

- Steinberg UR22C

- Gehäuse

- Phanteks NV7

- Netzteil

- Corsair Professional HX1000i

- Keyboard

- Cherry KC 6000 Slim

- Mouse

- Logitech MX518

- Betriebssystem

- Linux Mint Edge

Intel LGA4677 Mainboard Laberthread

Prozessoren

Intel Xeon w-24xx Preisvergleich (64 Lanes, 1 Sockel)

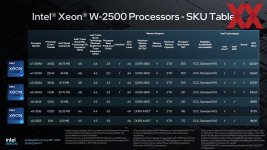

Intel Xeon w-25xx Preisvergleich***

Intel Xeon w-34xx Preisvergleich (112 Lanes, 1 Sockel)

Intel Xeon w-35xx Preisvergleich***

Intel Xeon Bonze 3xxx, Silver 4xxx, Gold 5xxx, Gold 6xxx Platinum 8xxx Preisvergleich (1 - 8 Sockel abhängig von der CPU)***

Intel Xeon Max Preisvergleich

Bei den CPUs unterscheidet man zwischen:

- MCC (Medium Core Count) bis 24 Cores

- XCC (Extreme Core Count) ab 24 bis 60 Cores

- XCC-HBM das sind die Max Server Xeon CPU mit integriertem HBM2e Speicher (5 Versionen gibt es davon)

Chipsätze

W790 (nur w-32xx und w-34xx) Preisvergleich

C741 (nur Xeon Bronze bis Platinum und Max)* Preisvergleich

Es wurden QS und ES CPUs der Server Xeon auf W790 Mainboards getestet und diese funktionieren. Da diese einen anderen Microcode haben als die Retailversionen. Die Retailversion Server Xeon funktionieren NICHT auf W790***

Max CPUs haben keine C-States. Haben somit keine Energiespar Optionen, schon Hardwareseitig. Die Logik dahinter ist die, dass diese nur für Server/HPC gedacht sind. Und somit 24/7 laufen sollen/müssen. Ebenfall scheinen sie nur auf bestimmten Mainboards von Asus/Asrock zu laufen. Biforication können sie ebenfalls nicht. Gute Leistung bringen sie im CPU+HMB Modus. Im CPU+HBM+DDR5 bricht die Performance stark zusammen***

CPU-Kühlung

Luftkühlung Preisvergleich

AiO Preisvergleich

Wasserkühler (nativ) Preisvergleich

Hinweis zur CPU Installation:

Prozessor Installation

Es gibt zwei Kunststoff Adapter/Halter zur Montage der CPU. Diese werden nur bei denn Boxed CPU oder bei eurem Mainboard mit geliefert. Bei Tray CPUs nicht (Meines Wissens nach).

E1B für Xeon CPU mit 64 Lanes (MCC)

E1A für Xeon CPU mit 112 Lanes (XCC)

E1C für Xeon Max (HBM)

Der Kunststoff Adapter/Halter wird erst auf dem Kühlkörper montiert.

Dann wird die CPU, richtig rum, auf die Pins und Cutouts achten, montiert. Darauf achten das die CPU richtig drin sitzt und alle Clips auf der CPU eingerastet sind. Sitz die CPU schief drin könnt ihr denn Sockel beschädigen. Nehmt euch, von daher Zeit, für diesen Schritt.

Erst jetzt die Kunststoffabdeckung vom Sockel demontieren.

Auf das Dreieck im Kunststoff Adapter/Halter und dem Sockel achten. Beide müssen übereinander liegen.

Wenn das Kühler/Adapter/CPU Packet im Sockel steht dann die Metalbügel am Kühler einrasten.

Dann die Kunststoffschrauben über Kreuz gleich mäßig anziehen. Sind die Schrauben nicht richtig angezogen, habt ihr beim starten des Systems allerlei merkwürdige Fehler. Bei mir wurde der RAM nicht erkannt.

Intel gibt ein Drehmomemt von 8 IN-LBF (Inch pound force) an (laut Umrechner 0.903878632 Newton Meter).

Kritik:

Erstens: Wenn Intel ein Drehmoment möchte sollte es Angaben in allen gebräuchlichen Maßeinheiten geben. Und das Metrische System ist nun mal weltweit, dass Maß aller Dinge.

Zweitens: Wir reden bei Boxed CPUs in der Regel über vierstellige Summen. Da sollte es für Intel kein Problem sein einen passenden Drehmomentschlüssel bei zu legen. (AMD schafft das auch)

Arbeitsspeicher

Preisvergleich

Nur DDR5 und auch nur RDIMM.

UDIMMs sind mechanisch nicht möglich.

Auf die QVL Liste eures Mainboards achten.

Intel Xeon w-32xx - Quad Channel Speicher max. 2TB

Intel Xeon w-34xx - Octa Channel Speicher max. 4TB

Intel Xeon Bonze bis Platinum - Octa Channel Speicher max. 4TB per CPU

Intel Max - max 4TB per CPU aber auch ohne RAM nutzbar. HMB only im BIOS einstellen.*

Es sind 8GB, 16GB, 24GB, 32GB, 64GB, 96GB und 128GB Modulle verfügbar. (Stand Januar 2025)

Hardwareluxx Tests und Reviews

Vorstellung der Intel Max CPU von STH auf Youtube. Und hier der Artikel dazu. (Englisch)*

Edits:

* 13. September 2023

** 10. Oktober 2023

*** 27. Dezember 2024

Prozessoren

Intel Xeon w-24xx Preisvergleich (64 Lanes, 1 Sockel)

Intel Xeon w-25xx Preisvergleich***

Intel Xeon w-34xx Preisvergleich (112 Lanes, 1 Sockel)

Intel Xeon w-35xx Preisvergleich***

Intel Xeon Bonze 3xxx, Silver 4xxx, Gold 5xxx, Gold 6xxx Platinum 8xxx Preisvergleich (1 - 8 Sockel abhängig von der CPU)***

Intel Xeon Max Preisvergleich

Bei den CPUs unterscheidet man zwischen:

- MCC (Medium Core Count) bis 24 Cores

- XCC (Extreme Core Count) ab 24 bis 60 Cores

- XCC-HBM das sind die Max Server Xeon CPU mit integriertem HBM2e Speicher (5 Versionen gibt es davon)

Chipsätze

W790 (nur w-32xx und w-34xx) Preisvergleich

C741 (nur Xeon Bronze bis Platinum und Max)* Preisvergleich

Es wurden QS und ES CPUs der Server Xeon auf W790 Mainboards getestet und diese funktionieren. Da diese einen anderen Microcode haben als die Retailversionen. Die Retailversion Server Xeon funktionieren NICHT auf W790***

Max CPUs haben keine C-States. Haben somit keine Energiespar Optionen, schon Hardwareseitig. Die Logik dahinter ist die, dass diese nur für Server/HPC gedacht sind. Und somit 24/7 laufen sollen/müssen. Ebenfall scheinen sie nur auf bestimmten Mainboards von Asus/Asrock zu laufen. Biforication können sie ebenfalls nicht. Gute Leistung bringen sie im CPU+HMB Modus. Im CPU+HBM+DDR5 bricht die Performance stark zusammen***

CPU-Kühlung

Luftkühlung Preisvergleich

AiO Preisvergleich

Wasserkühler (nativ) Preisvergleich

Hinweis zur CPU Installation:

Prozessor Installation

Es gibt zwei Kunststoff Adapter/Halter zur Montage der CPU. Diese werden nur bei denn Boxed CPU oder bei eurem Mainboard mit geliefert. Bei Tray CPUs nicht (Meines Wissens nach).

E1B für Xeon CPU mit 64 Lanes (MCC)

E1A für Xeon CPU mit 112 Lanes (XCC)

E1C für Xeon Max (HBM)

Der Kunststoff Adapter/Halter wird erst auf dem Kühlkörper montiert.

Dann wird die CPU, richtig rum, auf die Pins und Cutouts achten, montiert. Darauf achten das die CPU richtig drin sitzt und alle Clips auf der CPU eingerastet sind. Sitz die CPU schief drin könnt ihr denn Sockel beschädigen. Nehmt euch, von daher Zeit, für diesen Schritt.

Erst jetzt die Kunststoffabdeckung vom Sockel demontieren.

Auf das Dreieck im Kunststoff Adapter/Halter und dem Sockel achten. Beide müssen übereinander liegen.

Wenn das Kühler/Adapter/CPU Packet im Sockel steht dann die Metalbügel am Kühler einrasten.

Dann die Kunststoffschrauben über Kreuz gleich mäßig anziehen. Sind die Schrauben nicht richtig angezogen, habt ihr beim starten des Systems allerlei merkwürdige Fehler. Bei mir wurde der RAM nicht erkannt.

Intel gibt ein Drehmomemt von 8 IN-LBF (Inch pound force) an (laut Umrechner 0.903878632 Newton Meter).

Kritik:

Erstens: Wenn Intel ein Drehmoment möchte sollte es Angaben in allen gebräuchlichen Maßeinheiten geben. Und das Metrische System ist nun mal weltweit, dass Maß aller Dinge.

Zweitens: Wir reden bei Boxed CPUs in der Regel über vierstellige Summen. Da sollte es für Intel kein Problem sein einen passenden Drehmomentschlüssel bei zu legen. (AMD schafft das auch)

Arbeitsspeicher

Preisvergleich

Nur DDR5 und auch nur RDIMM.

UDIMMs sind mechanisch nicht möglich.

Auf die QVL Liste eures Mainboards achten.

Intel Xeon w-32xx - Quad Channel Speicher max. 2TB

Intel Xeon w-34xx - Octa Channel Speicher max. 4TB

Intel Xeon Bonze bis Platinum - Octa Channel Speicher max. 4TB per CPU

Intel Max - max 4TB per CPU aber auch ohne RAM nutzbar. HMB only im BIOS einstellen.*

Es sind 8GB, 16GB, 24GB, 32GB, 64GB, 96GB und 128GB Modulle verfügbar. (Stand Januar 2025)

Hardwareluxx Tests und Reviews

https://www.hardwareluxx.de/index.php/artikel/hardware/arbeitsspeicher/60736-ram-kit-für-octa-channel-g-skill-zeta-r5-im-test.html

https://www.hardwareluxx.de/index.p...am-limit-der-intel-xeon-w9-3495x-im-test.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60458-für-xeon-ws-asus-stellt-das-ws-w790-ace-und-ws-w790e-sage-se-vor.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60611-für-xeon-w-2400-3400-gigabyte-stellt-zwei-workstation-mainboards-vor.html

https://www.hardwareluxx.de/index.php/news/hardware/arbeitsspeicher/60504-g-skill-zeta-r5-ddr5-r-dimm-mit-6-800-mt-s-für-xeon-cpus.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60465-für-xeon-w-3400-und-w-2400-asrock-stellt-das-w790-ws-vor.html

https://www.hardwareluxx.de/index.p...-erste-benchmarks-der-neuen-ws-plattform.html

https://www.hardwareluxx.de/index.p...upermicro-stellt-passende-mainboards-vor.html

https://www.hardwareluxx.de/index.p...die-xeon-w-3400-und-xeon-w-2400-cpus-vor.html

https://www.hardwareluxx.de/index.p...am-limit-der-intel-xeon-w9-3495x-im-test.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60458-für-xeon-ws-asus-stellt-das-ws-w790-ace-und-ws-w790e-sage-se-vor.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60611-für-xeon-w-2400-3400-gigabyte-stellt-zwei-workstation-mainboards-vor.html

https://www.hardwareluxx.de/index.php/news/hardware/arbeitsspeicher/60504-g-skill-zeta-r5-ddr5-r-dimm-mit-6-800-mt-s-für-xeon-cpus.html

https://www.hardwareluxx.de/index.php/news/hardware/mainboards/60465-für-xeon-w-3400-und-w-2400-asrock-stellt-das-w790-ws-vor.html

https://www.hardwareluxx.de/index.p...-erste-benchmarks-der-neuen-ws-plattform.html

https://www.hardwareluxx.de/index.p...upermicro-stellt-passende-mainboards-vor.html

https://www.hardwareluxx.de/index.p...die-xeon-w-3400-und-xeon-w-2400-cpus-vor.html

Vorstellung der Intel Max CPU von STH auf Youtube. Und hier der Artikel dazu. (Englisch)*

Edits:

* 13. September 2023

** 10. Oktober 2023

*** 27. Dezember 2024

Anhänge

Zuletzt bearbeitet: