Verzweifelt? Wenn man keine Gegenargumente hat, wird man persönlich, hm?Also erst argumentierst du aus Gründen der Realitätsnähe mit 1080p und jetzt willst du uns erzählen, dass man CPUs sogar mit 4k benchen muss? Aus Realitätsnähe? Mit 4k?

Lol.

Das kommt etwas verzweifelt rüber.

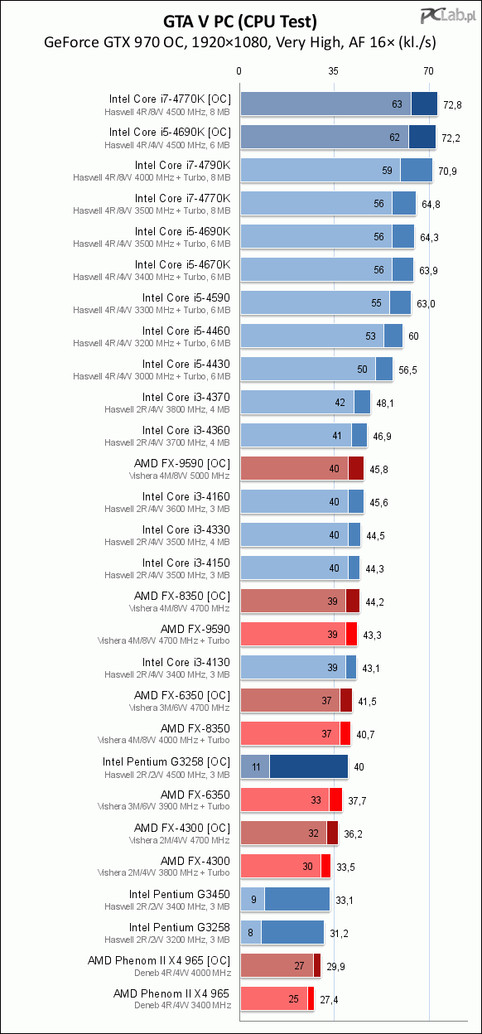

Es ging mir darum, aufzuzeigen, dass das GPU-Limit viel stärker ausgeprägt in Erscheinung tritt, als es Nighteye wahrhaben möchte. Wenn mir jemand erzählen möchte, dass eine Intel-Quad-CPU ab S-Bridge in 1080p oder 4K im Limit läuft, muss ich nur herzlich lachen. Aber du kannst gerne ebenso in den Benchmark schauen und die 1080p-Werte vergleichen. Ich bin mir aber sicher, dass du das schon getan hast. Sonst hättest du argumentiert, statt zu versuchen, mich zu diskreditieren.

Selbst in 1080p trennen den 3570K und den 4790K (3,4GHz vs. 4,0GHz

) nur 3fps. Wenn man, wie zig Gamer, keine TitanX sondern eher eine R270X im Rechner hat, trifft man sogar nur auf 1fps Unterschied.

) nur 3fps. Wenn man, wie zig Gamer, keine TitanX sondern eher eine R270X im Rechner hat, trifft man sogar nur auf 1fps Unterschied.Die GPU-Limit-Problematik ist viel schlimmer als das CPU-Limit - Nighteye, und du scheinbar auch, scheinen diese Problematik gerne miteinander zu verwechseln.

Und du kannst ebenso wie Nighteye nicht lesen. Ich habe nie das Plus an IPC von S-Bridge über I-Bridge hin zu Haswell und Broadwell in Frage gestellt. Aber ich stelle den Sinn und Nutzen, der am Ende dabei rauskommt für Otto-Normal & Gamer massiv in Frage - denn der liegt im Bereich von "Peanuts". Aber ich wiederhole mich gerne: die, die von der IPC-Steigerung profitieren, sind einzig Professionals und jene, die die Ausstattung der neuen Chipsätze brauchen.Aber es ist lächerlich zu sagen, dass die Haswell CPUs nur 7% schneller als die alten S-Bridge CPUs sind.

Werden sie zum Glück nicht. Aber du weißt, was AMDs Mantle bewirkt hat? Und du weißt, was uns in diesem Sinne mit DirectX12 auf breiter Front bevorsteht??Nächstes Jahr kommt mit Pascal eine neue Graka Generation. Wer weiss, was die an Leistung bringen. Vielleicht verschiebt sich dann das GPU Limit? Vielleicht liegen die Werte im 1080p Benchmark dann dort, wo sie heute im 720p Benchmark liegen? Oder werden die GPUs in Zukunft langsamer werden?

Mitdenken mein Lieber, mitdenken.

Ich würde jedenfalls niemandem empfehlen, heute noch eine Sandy Bridge CPU zu kaufen, wenn er für ein paar Euro mehr eine Haswell oder Skylake CPU kriegt.

Einen gebrauchten 2500K bekommt man zwischen 90~130€, je nach Taktfreudigkeit, eine passende P68/Z68/Z77-Plattform gebraucht für ca. 50€. DDR3-RAM haben die meisten noch da, falls nicht, gehen die 8GB hier gebraucht für ca. 40~50€, je nach Takt, raus.

Und du willst mir erzählen, dass ein Aufpreis auf einen 6600K, der jetzt schon auf Höhe von Broadwell (270€) gehandelt wird, neben einer neuen Z170-Platine (ca. 100€) und neuem DDR4-RAM, weil die allerwenigsten DDR3L-RAM im PC haben (50€ exkl. für 8GB DDR4) unter "wenige Euros" fällt?? Etwa 150€ (200€ inkl. RAM) für eine gebrauchte 2500K-Plattform vs. 420€ für eine neue Skylake-Plattform!?

Na, du hast in Mathe aber auch ganz schön gepennt.