Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: this_feature_currently_requires_accessing_site_using_safari

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

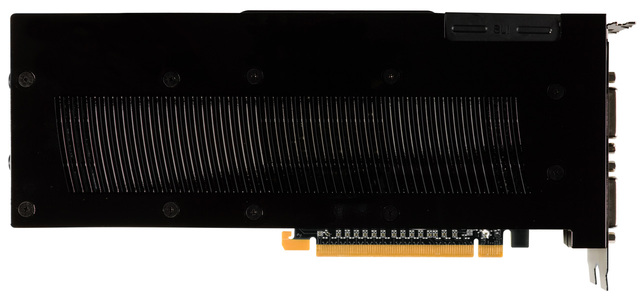

Nvidia GeForce 280 GTX "Sammel-Thread + FAQ" Bitte bei Fragen die erste Seite lesen 3

- Ersteller Le_Frog99

- Erstellt am

- Status

- Für weitere Antworten geschlossen.

Hmmm, ... 177.84, ...

Der Treiber ist vom 07/28/2008

Der 177.89 ist vom 08/12/2008

hat nix zu sagen ,NV hat 4 Enwicklerteams die völlig unabhängig von einander entwickeln.

Der inf Eintrag ist falsch ,von dem `85 auch der just aufgetaucht ist.

Zuletzt bearbeitet:

loopy83

Moderator, HWLUXX OC-Team, TeamMUTTI

Also zu warm mit Sicherheit nicht, denn wir kühlen mit LN2....Hast du getestet, ...

zu warm?

Ich hab noch nichts in Sachen vMod bei der GTX280 gemacht!

Dural hatte mal getestet und kam mit 1,18 (1,24v real) auf ca. 760, mit 1,35v real, knapp über 800.

Wir sind bei 1,45V auf ca. 930 gekommen, aber ich habe nun auch gelesen, dass viele andere mit weniger Spannung an die 1GHz rangekommen sind.

Testen kann ich das erst am WE, wollte mich nur nochmal schlau machen, ob es ein bekanntes Problem ist.

Hätte ja sein können, dass viele schon von solchen Problemem ab 1,4V oder so berichtet haben. Dass die karte dann unabhängig von der temperatur instabil wird. mal abwarten und dann am WE testen

Also zu warm mit Sicherheit nicht, denn wir kühlen mit LN2....

Wir sind bei 1,45V auf ca. 930 gekommen, aber ich habe nun auch gelesen, dass viele andere mit weniger Spannung an die 1GHz rangekommen sind.

Testen kann ich das erst am WE, wollte mich nur nochmal schlau machen, ob es ein bekanntes Problem ist.

Hätte ja sein können, dass viele schon von solchen Problemem ab 1,4V oder so berichtet haben. Dass die karte dann unabhängig von der temperatur instabil wird. mal abwarten und dann am WE testen

Also ich weis nur, dass einige mit LN2 auch mit Standardspannung über 1GHz kamen.

Könnte höchstens sein, dass deine recht schlecht läuft, musste einfach mal vergleichen, default vs. 1.4+v

Edit:

Welche Loadtemps hattet ihr?

loopy83

Moderator, HWLUXX OC-Team, TeamMUTTI

Loadtemps waren so bei -70 GRad.... weiter runter hat nix mehr bei den Taktraten gebracht. Wir testen einfach nochmal mit weniger Spannung, ich hoffe das es daran gelegen hat. Aber mit Standardspannung sind wir nicht so weit gekommen, das weiss ich. Also einfach mal die 1,3-1,35V probieren, wird schon schief gehen

DANKE

DANKE

Wie weit kamt ihr denn mit Standardspannung, vlt. kann es doch sein, dass es "keine so gute" GTX ist.

Einige bei XS kamen mit Standard (1,18 (1,24v real)) so bis knapp über 1GHz/2GHz aber bei höheren Temps.

http://www.partypicssaarland.de/include.php?path=galerie/pic.php&pid=535

Einige bei XS kamen mit Standard (1,18 (1,24v real)) so bis knapp über 1GHz/2GHz aber bei höheren Temps.

http://www.partypicssaarland.de/include.php?path=galerie/pic.php&pid=535

GT200b erst im Q4, aber mit DDR5:

http://www.fudzilla.com/index.php?option=com_content&task=view&id=8987&Itemid=1

http://www.fudzilla.com/index.php?option=com_content&task=view&id=8987&Itemid=1

Loadtemps waren so bei -70 GRad.... weiter runter hat nix mehr bei den Taktraten gebracht. Wir testen einfach nochmal mit weniger Spannung, ich hoffe das es daran gelegen hat. Aber mit Standardspannung sind wir nicht so weit gekommen, das weiss ich. Also einfach mal die 1,3-1,35V probieren, wird schon schief gehen

DANKE

so jetzt mal Butter bei die Fische!

wenn ich auf 1.3 bis max 1.34 gehen will was brauch ich da für einen Podi!

Xog

Neuling

- Mitglied seit

- 01.08.2008

- Beiträge

- 23

GTX 280 und Asus P5E3 Premium passen?

Wegen der Hülle in der Nähe vom DVI:

Hat die Kombi jemand am laufen?

ja past da gibts keine probleme

loopy83

Moderator, HWLUXX OC-Team, TeamMUTTI

Auch nochmal für alle anderen:weist du was man für einen Podi brauch für 1.3 bis 1.34

bau nen 100 Ohm Poti ein und du kannst alle Spannungen einstellen... bis die temps zu hoch werden oder die Karte abschaltet.... 1,7V haben wir schon kurz getestet (ACHTUNG: nicht nachmachen, es sei denn ihr kühlt mit LN2!!!), da kam noch keine OVP... also in sachen Spannung ist die Karte echt gutmütig. Ist eben nur die Frage, ob entsprechende Spannungserhöhungen etwas bringen.

Aber da wissen wir am WE mehr

Was ich praktisch finde, die Karte hat integrierten 3D Sound.... kaum schmeißt man einen Bench an und die Karte schaltet auf die 3D Spannungen, geht ein Pfeifkonzert der Extraklasse los... einfach wahnsinn. Die Geräuschkulisse is mir persönlich beim benchen egal, solange die Ergebnisse stimmen. Aber wenn ich mir so ein teil in den Heimrechner eingebaut hätte und die würde mich so dermaßen vollquatschen, wie schwer sie doch in meinem Spiel zu kämpfen hat, wäre sie schon im hohen Bogen ausm Fenster geflogen....

Zuletzt bearbeitet:

scully1234

Banned

Ja ja viel geduld brauchte ich gestern nacht bis ich die drei dinger zum laufen gebracht habe

Der treiber akzeptierte zuerst die 3 grakas nicht egal was ich machte sobald alle 3 aktiviert waren blieb der bildschirm dunkel.

Bis ich dann nach langen langen grübeln mitten in der nacht nen geistesblitz hatte

Ich ging in den abgesicherten modus von vista u deaktivierte dort erstmal alle grakas bis auf die oberste.Dann startete ich vista normal ging in die systemsteuerung u schaltete nach u nach alle grakas aktiv u siehe da

Nun lies ich noch schnell den vantage einmal durchrauschen mit diesem ergebniss:

Jetzt legte ich mich schlafen um dann unsanft von meinen wecker nach ner knappen stunde zur arbeit gerufen zu werden

Der treiber akzeptierte zuerst die 3 grakas nicht egal was ich machte sobald alle 3 aktiviert waren blieb der bildschirm dunkel.

Bis ich dann nach langen langen grübeln mitten in der nacht nen geistesblitz hatte

Ich ging in den abgesicherten modus von vista u deaktivierte dort erstmal alle grakas bis auf die oberste.Dann startete ich vista normal ging in die systemsteuerung u schaltete nach u nach alle grakas aktiv u siehe da

Nun lies ich noch schnell den vantage einmal durchrauschen mit diesem ergebniss:

Jetzt legte ich mich schlafen um dann unsanft von meinen wecker nach ner knappen stunde zur arbeit gerufen zu werden

jo das kenn ich ,aber was bringt mir das beim Zocken was den Mehrpreis rechtfertigen würde ,mal ehrlich?

Du kannst ja alles in Rente schicken....und gleich kaufen..die ersten Boards...oha wenn ich da zb. an Gigabyte denke....

Hinzugefügter Post:

hihi

hier mach mal mit den 3 Dingern!

4x4 SSAA 16 AF HQ

sind 15 FPS den Rest hat Fraps beim Drucken verschluckt als es knallte.

Du kannst ja alles in Rente schicken....und gleich kaufen..die ersten Boards...oha wenn ich da zb. an Gigabyte denke....

Hinzugefügter Post:

Ja ja viel geduld brauchte ich gestern nacht bis ich die drei dinger zum laufen gebracht habe

Der treiber akzeptierte zuerst die 3 grakas nicht egal was ich machte sobald alle 3 aktiviert waren blieb der bildschirm dunkel.

Bis ich dann nach langen langen grübeln mitten in der nacht nen geistesblitz hatte

Ich ging in den abgesicherten modus von vista u deaktivierte dort erstmal alle grakas bis auf die oberste.Dann startete ich vista normal ging in die systemsteuerung u schaltete nach u nach alle grakas aktiv u siehe da

Nun lies ich noch schnell den vantage einmal durchrauschen mit diesem ergebniss:

Jetzt legte ich mich schlafen um dann unsanft von meinen wecker nach ner knappen stunde zur arbeit gerufen zu werden

hihi

hier mach mal mit den 3 Dingern!

4x4 SSAA 16 AF HQ

sind 15 FPS den Rest hat Fraps beim Drucken verschluckt als es knallte.

Zuletzt bearbeitet:

Krümelmonster

Legende

- Mitglied seit

- 02.12.2005

- Beiträge

- 8.507

- Laptop

- MacBook Pro 16"

- Details zu meinem Laptop

- Prozessor

- Intel® Core™ i7-9750H

- Speicher

- 16 GB 2666 MHz DDR4

- Grafikprozessor

- AMD Radeon Pro 5300M 4 GB GDDR6

- Display

- 3072 x 1920

- SSD

- 512 GB SSD NVMe

- Betriebssystem

- macOS Big Sur

Die Benchmarks sind für 3 x GTX ganz schön schwach. Da hatte ich wirklich mehr erwartet. 13.000 macht ja schon eine Karte alleine mit einem schnell DualCore. Die FPS beim GPU Benchmark sind auch nicht sooo weit von einer X2 entfernt, etwa 10 FPS, mehr nicht.

scully1234

Banned

Die Benchmarks sind für 3 x GTX ganz schön schwach. Da hatte ich wirklich mehr erwartet. 13.000 macht ja schon eine Karte alleine mit einem schnell DualCore. Die FPS beim GPU Benchmark sind auch nicht sooo weit von einer X2 entfernt, etwa 10 FPS, mehr nicht.

Um die power der 3 gtxen auszuschöpfen ist die heutige prozessorgeneration einfach noch nicht schnell genug(waiting for nehalem

).Ich denke bei 4GHZ cpu takt sieht das ganze schon anders aus

).Ich denke bei 4GHZ cpu takt sieht das ganze schon anders aus

War ja auch erst der erste durchlauf von vantage,mitten in der nacht,wo ich bald vor müdigkeit auf die tischplatte geknallt wäre

Zuletzt bearbeitet:

Soulja Boy

Banned

- Mitglied seit

- 04.10.2007

- Beiträge

- 3.152

aja ich frag mich was ihr euch erwartet ist doch klar das die heutigen prozessoren zu schwach sind die bremsen ja noch einzelkarten dieses schlags aus

Mixxery

Neuling

- Mitglied seit

- 08.12.2007

- Beiträge

- 527

Um die power der 3 gtxen auszuschöpfen ist die heutige prozessorgeneration einfach noch nicht schnell genug(waiting for nehalem).Ich denke bei 4GHZ cpu takt sieht das ganze schon anders aus

War ja auch erst der erste durchlauf von vantage,mitten in der nacht,wo ich bald vor müdigkeit auf die tischplatte geknallt wäre

Teste mal Crysis

scully1234

Banned

PHP:

Teste mal Crysis

Gemach gemach bin erst von der arbeit nach hause gekommen u durch die aktion letzte nacht müde wie sau

Krümelmonster

Legende

- Mitglied seit

- 02.12.2005

- Beiträge

- 8.507

- Laptop

- MacBook Pro 16"

- Details zu meinem Laptop

- Prozessor

- Intel® Core™ i7-9750H

- Speicher

- 16 GB 2666 MHz DDR4

- Grafikprozessor

- AMD Radeon Pro 5300M 4 GB GDDR6

- Display

- 3072 x 1920

- SSD

- 512 GB SSD NVMe

- Betriebssystem

- macOS Big Sur

Achso, ich dachte Du hättest mit den Angaben in der Signatur gemessen. Quad auf 4 GHz wäre nämlich wirklich mehr als mau gewesen bei den Werten. Aber wenn es default war, ist es auch kein Wunder.

scully1234

Banned

Achso, ich dachte Du hättest mit den Angaben in der Signatur gemessen. Quad auf 4 GHz wäre nämlich wirklich mehr als mau gewesen bei den Werten. Aber wenn es default war, ist es auch kein Wunder.

Jepp war erstmal alles default,da das board ja neu ist u ich gerade erst alles letzte nacht zum laufen bekommen habe

scully1234

Banned

Dampfkanes

Legende

- Mitglied seit

- 26.09.2007

- Beiträge

- 6.458

- Details zu meinem Desktop

- Prozessor

- Core i7-13900KS

- Mainboard

- Asus ROG STRIX Z790-E GAMING WIFI

- Kühler

- cuplex kryos NEXT RGBpx black 1700, Acryl/Nickel

- Speicher

- 32GB DDR5-7200 CL34-44-44-96

- Grafikprozessor

- iGPU

- Display

- LG UltraGear 38GL950G-B (3840x1600)

- SSD

- Samsung 990 Pro 2TB

- Soundkarte

- Onboard

- Gehäuse

- Thermaltake A500

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech K860

- Mouse

- MX Master 2S

- Betriebssystem

- Win10 22H2

@OliverM84

im Vergleich zu der Ergebnissen vom scully1234 lieg ich doch ziemlich gut. Oder anders gesagt: die Auflösung bei Performance ist einfach zu mickrig.

Oder anders gesagt: die Auflösung bei Performance ist einfach zu mickrig.

Hier fehlt einfach der richtige Monitor. Da liefs bei mir anders.

Zuerst hatte ich eine 8800 GTX. Die hat sich mit dem 17"-Tft nur gelangweilt.

Also musste ein 24"-Breitbild-Monitor her. Da hatte sie schon mehr zu tun. Hatte aber immer noch keine Probs. Dann hab ich für mich die Vorzeuge von AA entdeckt. Immer noch keine Probleme. Dann kam Crysis und nun war die 8800 GTX überfordert. Aber zum Glück hat das ganze ja jetzt mit den GTX 280ern ein HappyEnd gefunden.

wieder etwas mehr zum topic.

Wenn der G200b so spät kommt, fänd ichs schlecht. Früher wär mir lieber. Dann hätte es vielleich eine Möglichkeit für mich gegeben im StepUp von Evga auf die neuen Karten zu wechseln.

Aber wenn die Leistungskrone dieses Jahr zurück zu Nvidia soll, dann wirds wohl nur eine Dual-Karte tun. Von daher muss der Verbrauch runter und bei einer SingleGPU-Karte die Taktraten deutlich rauf.

Kann man nichts machen.

Ciao Tom

im Vergleich zu der Ergebnissen vom scully1234 lieg ich doch ziemlich gut.

Oder anders gesagt: die Auflösung bei Performance ist einfach zu mickrig.

Oder anders gesagt: die Auflösung bei Performance ist einfach zu mickrig.Hier fehlt einfach der richtige Monitor. Da liefs bei mir anders.

Zuerst hatte ich eine 8800 GTX. Die hat sich mit dem 17"-Tft nur gelangweilt.

Also musste ein 24"-Breitbild-Monitor her. Da hatte sie schon mehr zu tun. Hatte aber immer noch keine Probs. Dann hab ich für mich die Vorzeuge von AA entdeckt. Immer noch keine Probleme. Dann kam Crysis und nun war die 8800 GTX überfordert. Aber zum Glück hat das ganze ja jetzt mit den GTX 280ern ein HappyEnd gefunden.

wieder etwas mehr zum topic.

Wenn der G200b so spät kommt, fänd ichs schlecht. Früher wär mir lieber. Dann hätte es vielleich eine Möglichkeit für mich gegeben im StepUp von Evga auf die neuen Karten zu wechseln.

Aber wenn die Leistungskrone dieses Jahr zurück zu Nvidia soll, dann wirds wohl nur eine Dual-Karte tun. Von daher muss der Verbrauch runter und bei einer SingleGPU-Karte die Taktraten deutlich rauf.

Kann man nichts machen.

Ciao Tom

Zuletzt bearbeitet:

Dampfkanes

Legende

- Mitglied seit

- 26.09.2007

- Beiträge

- 6.458

- Details zu meinem Desktop

- Prozessor

- Core i7-13900KS

- Mainboard

- Asus ROG STRIX Z790-E GAMING WIFI

- Kühler

- cuplex kryos NEXT RGBpx black 1700, Acryl/Nickel

- Speicher

- 32GB DDR5-7200 CL34-44-44-96

- Grafikprozessor

- iGPU

- Display

- LG UltraGear 38GL950G-B (3840x1600)

- SSD

- Samsung 990 Pro 2TB

- Soundkarte

- Onboard

- Gehäuse

- Thermaltake A500

- Netzteil

- Corsair HX1200i

- Keyboard

- Logitech K860

- Mouse

- MX Master 2S

- Betriebssystem

- Win10 22H2

Du wirst lachen. Ich hatte gestern oder heute morgen geschaut, wo Du wohnst.Ps:schick mir mal deinen monitor zum benchen vorbei

Was ich mir auch schon überlegt hatte, als ich die neuen Grakas testhalber im Rechner von meinem Vater mit 17"-TFT hatte.

Wenn man die Inf vom Monitor modifizert, müsste man den Bench doch auch mit mehr Auflösung laufen lassen können? Dem Rechner müssts ja wurscht sein obs der Monitor kann bzw ob überhaupt einer dran hängt, oder?

Die Idee kam mir, als der Rechner die maximale Auflösung vom Monitor falsch erkannt hatte (analog angesteckt).

ciao Tom

@OliverM84

im Vergleich zu der Ergebnissen vom scully1234 lieg ich doch ziemlich gut.Oder anders gesagt: die Auflösung bei Performance ist einfach zu mickrig.

Auflösung hin oder her, .. du müssest einfach mehr Punkte auch unter Performance haben. ich hab da mit fast gleichen Einstellungen gute 2000 Punkte mehr in Vantage, die müssen ja irgendwo herkommen?!

Kannst du mal ohne die zusätzliche Karte als PhysX GPU testen?

scully1234

Banned

Das wäre sicherlich machbar aber wer ist kompetent genug da rumzubastelnDu wirst lachen. Ich hatte gestern oder heute morgen geschaut, wo Du wohnst.

Was ich mir auch schon überlegt hatte, als ich die neuen Grakas testhalber im Rechner von meinem Vater mit 17"-TFT hatte.

Wenn man die Inf vom Monitor modifizert, müsste man den Bench doch auch mit mehr Auflösung laufen lassen können? Dem Rechner müssts ja wurscht sein obs der Monitor kann bzw ob überhaupt einer dran hängt, oder?

Die Idee kam mir, als der Rechner die maximale Auflösung vom Monitor falsch erkannt hatte (analog angesteckt).

ciao Tom

Xptweaker

Semiprofi

Um die power der 3 gtxen auszuschöpfen ist die heutige prozessorgeneration einfach noch nicht schnell genug(waiting for nehalem)

es ist mittlerweile schon bekannt das der nehalem im bereich gaming keinen deutlich spürbaren performancegewinn gegenüber dem penryn haben wird

scully1234

Banned

es ist mittlerweile schon bekannt das der nehalem im bereich gaming keinen deutlich spürbaren performancegewinn gegenüber dem penryn haben wird

Das kann ich mir ehrlich gesagt nicht so ganz vorstellen,zuverlässige benches wird es erst geben wenn die cpu auf dem"freien" Markt zur verfügung steht

Auf vorzeitige wahrsagereien sollte man sich aus erfahrung schon nicht verlassen

Auf vorzeitige wahrsagereien sollte man sich aus erfahrung schon nicht verlassen

So hier wie versprochen mal der erste Benchmark von crysis mit den karten in very high u alles an

Zuletzt bearbeitet:

Deathrow2004

Urgestein

- Mitglied seit

- 26.04.2007

- Beiträge

- 13.568

- Ort

- Mönchengladbach

- Details zu meinem Desktop

- Prozessor

- 13600kf

- Mainboard

- Gigabyte Z790 Aorus Elite AX

- Kühler

- Noctua NH-U12A chromax.black

- Speicher

- 32GB G.Skill DDR5-6600@6800

- Grafikprozessor

- Palit RTX 4070ti Gamerock

- Display

- AOC 32" 144Hz

- SSD

- WD SN850x 2TB, WD SN770 2TB

- HDD

- Seagate 8TB

- Soundkarte

- Asus Strix Soar

- Gehäuse

- Corsair 7000D

- Netzteil

- Seasonic Prime PX-850

- Keyboard

- Logitech G815 Lightspeed

- Mouse

- Corsair Scimitar RGB

- Betriebssystem

- Win 11 Pro

- Internet

- ▼1000Mbit ▲50Mbit

Ich bekomm die Pics net angezeigt/vergrößert.

- Status

- Für weitere Antworten geschlossen.