Bzw zeigte ja such NV schon mal RT mit einer 1080Ti auch wenn nicht so performant das es auch andere Wege gibt RT zu berechnen .

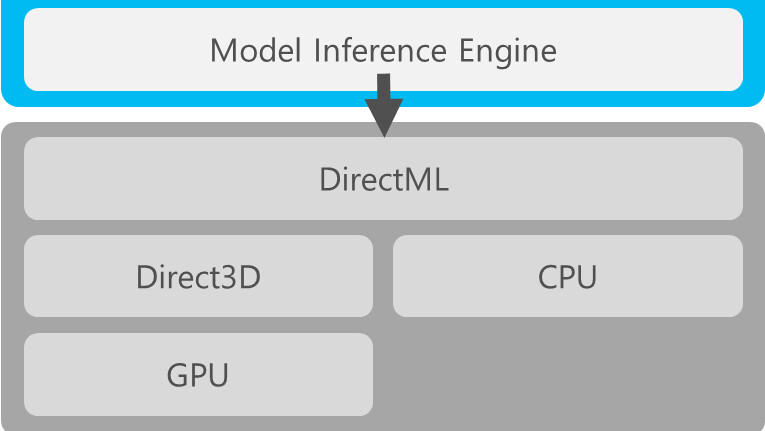

Mit der kommenden Windows-API DirectML für DirectX 12 könnte AMD eine Antwort auf Nvidias DLSS liefern.

www.computerbase.de

Woher stammt denn eigentlich das Märchen, dass RT nur in Hardware geht!?

RT geht schon immer in Software - seit sonst wie lange schon... Das Ding ist nur, es ist halt langsam. Der Knackpunkt ist es, einen Weg zu finden, der es schafft, etwas in Echtzeit zu berechnen. Wie man das macht, ist völlig bumms egal. Ob das jetzt dedizierte Raytracing-Units sind, ob das irgendwelche CPU Cores in Größenordnungen sind oder ob das irgendwelche Unified Shader im GPU Bereich sind. Am Ende völlig egal. Die Software machts.

Aktuell wissen wir nicht, was AMD da bringt - NVs RTX Zeugs ist zumindest grundlegend DXR "geeignet" - was AMD da bringt, muss sich noch zeigen. Vergleichbar mit den Konsolen ist das aucht nicht zwangsweise, da dort möglicherweise die Uhren wieder etwas anders ticken.

Zumal das RT-Problem nicht die Einheiten ansich sind, sonder der Spagat zwischen notwendiger Rechenleistung und resultierender Optik. Nach dem ganzen rumgehube, was die Leute in den Foren immer ablassen, wenn es um DLSS geht, dürfte Raytracing gar nicht gut weg kommen. Denn dort geht es (in aktueller Form) eigentlich mehr darum mit nem Denoiser die mangelnde Performance zu kaschieren.

Den bisher gezeigten Trailern für die neuen Konsolen zur Folge kommt da von AMD auch nichts sonderlich groß leiststungsstarkes. Man sieht den Trailern mit bloßen Auge an, dass direkt ab Start, vor der aller ersten Veröffentlichung der Hardware und des ersten Spiels - die Performance schon so schlecht ist, dass die Auflösung und die Anzahl der Rays seeehr massiv abgesenkt werden muss. Perspektivisch werden sich da sicher neue Mittel und Wege finden, das "besser" zu kaschieren, aber aktuell kommt da mMn nicht so wirklich groß ein Fortschritt von AMD in der Hardware. Ich wäre mir nichtmal sicher, ob da überhaupt was groß in Hardware kommt. Kann - muss aber nicht.

Bei NV darf man allerdings durchaus davon ausgehen, dass Ampere in diese Kerbe massiv weiter reinschlagen wird.

Übrigens Thema DLSS - das was du da verlinkst ist aber schon eher ne andere Baustelle.

MS baut da ne Schnittstelle. Es ist heute doch lange schon möglich, komplett abseits DLSS, ne Art KI für Upscaling zu nutzen. Offline und ohne die Integration in eine Engine. Code, wie man das fabriziert - sogar GPU beschleunigt, gibts zu Hauf im Netz. Das ist aber eben nur die halbe Wahrheit. Sowas nutzt man um spezielle Probleme zu lösen. Bspw. denkbar bei der Restauration von altem Video/Fotomaterial. Der Knackpunkt dabei ist - ne Schnittstelle macht lange keine Implementation. Man muss NV definitv eins lassen -> die grünen haben seit je her ein Händchen für solchen Kram. Das muss man nicht gut heißen, viele kritisieren sogar ihre Bestrebungen in der Richtung, aber in der Vergangenheit gab es schon öfters derartige Ansätze, wo NV mit der Fix-und-Fertig Lösung ums Eck kam, während andere ne Art Schnittstelle brachten -> aber dann viel Arbeit allein rein stecken mussten. Wenn du dich zurück erinnerst - die exakt selbe Diskussion gab es damals zu PhysX vs. DirectCompute Zeiten. MS hat DirectCompute angekündigt und eine Integration ins OS bzw. in die DirectX Themen wurde von den Leuten als positiv aufgenommen -> es gab aber effektiv nie einen wirklichen GPU beschleunigten echten Konkurrenten zu PhysX per GPU. Man könnte meinen, dass das hier ähnlich laufen wird

DLSS basiert in erster Linie auf Berechnungen mit niedriger Genauigkeit -> und profitiert damit vom höheren Durchsatz der Tensor Cores (zumindest ab 2.0). Irgend ein DirectML oder alternative Schnittstellen können sowas in der Basis auch - aber es fehlt halt immernoch die Implementation. MS gibt auch nur bedingt Support an der Stelle.

ICH würde mich allerdings wundern, wenn zumindest in den kommenden Konsolen nicht ne Art Abwandlung davon irgendwie einfließt. Weil es ist ein 1a Mechanismus um massiv Performance zu sparen ohne (wenn überhaupt) optische Nachteile zu haben.

)

)

DLSS basiert in erster Linie auf Berechnungen mit niedriger Genauigkeit -> und profitiert damit vom höheren Durchsatz der Tensor Cores (zumindest ab 2.0). Irgend ein DirectML oder alternative Schnittstellen können sowas in der Basis auch - aber es fehlt halt immernoch die Implementation. MS gibt auch nur bedingt Support an der Stelle.

DLSS basiert in erster Linie auf Berechnungen mit niedriger Genauigkeit -> und profitiert damit vom höheren Durchsatz der Tensor Cores (zumindest ab 2.0). Irgend ein DirectML oder alternative Schnittstellen können sowas in der Basis auch - aber es fehlt halt immernoch die Implementation. MS gibt auch nur bedingt Support an der Stelle.

Darum verbauen sich auch Leute ein 1200W Netzteil in einen pummeligen Gaming Rechner mit einem Quadcore und einer Mid-Range Graka..... mehr ist eben immer besser

Darum verbauen sich auch Leute ein 1200W Netzteil in einen pummeligen Gaming Rechner mit einem Quadcore und einer Mid-Range Graka..... mehr ist eben immer besser