Spieluhr

Banned

- Mitglied seit

- 17.03.2006

- Beiträge

- 11.890

- Ort

- Dortmund

- Details zu meinem Desktop

- Prozessor

- Intel Core i5-13600KF (5,8/5,5)

- Mainboard

- MSI MEG Z690 ACE

- Kühler

- DeepCool Gammaxx L360 RGB V2 (alte Rev.) @ Push'n'Pull 6x AC P12PWM (Rev.4)

- Speicher

- 32GB Corsair Vengeance @ 6667MHz | DDR5

- Grafikprozessor

- AMD RX6500XT *Ersatz wegen defekt*

- Display

- Acer KG 272 UP (WQHD/165Hz)

- SSD

- WD SN850X (2TB) | 2x SK Hynix Platinum P41 (2TB) | Fanxiang S880 (4TB) | Fikwot FN955 (4TB)

- Gehäuse

- Corsair 5000D Airflow White @ 4x AC P12PWM (Rev.4) | 3x DeepCool RF120 RGB (alte Rev.)

- Netzteil

- Corsair RM850x (Serie 2022) 850W.

- Keyboard

- Cherry Stream V2 RGB

- Mouse

- Tecknet GM299 RGB

- Betriebssystem

- W11 Prof. Retail Version

- Webbrowser

- der beknackte Fuchs

- Sonstiges

- Satelliten: PreSonus Eris E4.5BT Studio Kevlar Subwoofer: PreSonus Eris Sub8 Studio (aktiv) Kabels: AdamHall 5Star (IRP) TS/TRS 6,5/3,5 Klinke Absorber: AdamHall Gravity IF01 / PAD ECO2

- Internet

- ▼1000 MBit ▲50 MBit

Das was du Zwischenspeicher nennst ist für die Mapping Tabelle zuständig. Die wird zwar ausgelagert auf den Host und nicht in den DRam wie bei entsprechenden SSDs mit DRam Cache geschrieben aber selbst das geht noch wesentlich flotter als bei alten Sata bzw. mSata SSDs, welche diese direkt in den Nand geschrieben haben und wodurch quasi ein paraleler Zugriff auf diesen stattfinden musste.

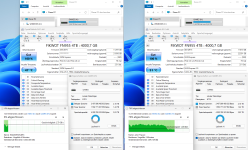

Ich habe hier im Spoiler mal die Lexar im HMB Mode ggü. zwei SSDs mit DRam Cache (P41, SN850X) anhand den PCMark Diskszenarios gebencht.

Gerade im realitätsnahesten FullSystemdrive Benchmark (der aufwendigste und längste) kann die Lexar sehr gut mithalten.

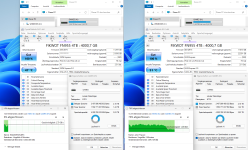

Ähnlich bzw. sogar identisch agieren auch meine S880 bzw. FN955, die auch im HMB Mode laufen mit identischen 232-Layer YMTC Nand und Maxiotek Controller.

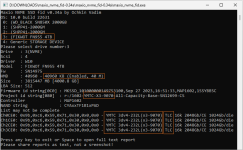

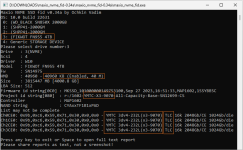

Hier zb. die 4TB FikWot FN955, absolut identisch zur Lexar NM790 und beide unterstützen in der 4TB Version das NVMe2.0 Protokoll:

ps: Es kommt auch immer darauf an, welches Szenario du nun genau meinst. Random Zugriff oder seq. Zugriff?

edit: Da ich keine Lust habe die FN955, die momentan bei mir als Game SSD für verschiedene Biblis dient zu leeren, einfach mal den Epic Ordner auf eine P41 kopiert und dann wieder zurück geschrieben.

Bitte beachten: Die SSD ist schon über 60% befüllt und momentan mangels PCIe4.0 Slots nur @ 3.0 angebunden. Der Epic Ordner umfasst 628GB in 403 Ordner mit gesamt 12911 Dateien:

..die ersten 400GB rutschen quasi mit 2,5~3,0GB/s (PCIe3.0) durch, erst danach bricht die FN955 -füllstandsbedingt- auf ca. 1,2~1,0GB/s ein.

Das sind Geschwindigkeiten die sich durchaus sehen lassen dürfen und selbst meine beiden alten Samsung 980 non_Pro @ PCIe4.0 bzw. die beiden Samsung 970 EVO Plus @ PCIe3.0 haben das so nicht geschafft.

Ich habe hier im Spoiler mal die Lexar im HMB Mode ggü. zwei SSDs mit DRam Cache (P41, SN850X) anhand den PCMark Diskszenarios gebencht.

Gerade im realitätsnahesten FullSystemdrive Benchmark (der aufwendigste und längste) kann die Lexar sehr gut mithalten.

Ähnlich bzw. sogar identisch agieren auch meine S880 bzw. FN955, die auch im HMB Mode laufen mit identischen 232-Layer YMTC Nand und Maxiotek Controller.

Hier zb. die 4TB FikWot FN955, absolut identisch zur Lexar NM790 und beide unterstützen in der 4TB Version das NVMe2.0 Protokoll:

ps: Es kommt auch immer darauf an, welches Szenario du nun genau meinst. Random Zugriff oder seq. Zugriff?

edit: Da ich keine Lust habe die FN955, die momentan bei mir als Game SSD für verschiedene Biblis dient zu leeren, einfach mal den Epic Ordner auf eine P41 kopiert und dann wieder zurück geschrieben.

Bitte beachten: Die SSD ist schon über 60% befüllt und momentan mangels PCIe4.0 Slots nur @ 3.0 angebunden. Der Epic Ordner umfasst 628GB in 403 Ordner mit gesamt 12911 Dateien:

..die ersten 400GB rutschen quasi mit 2,5~3,0GB/s (PCIe3.0) durch, erst danach bricht die FN955 -füllstandsbedingt- auf ca. 1,2~1,0GB/s ein.

Das sind Geschwindigkeiten die sich durchaus sehen lassen dürfen und selbst meine beiden alten Samsung 980 non_Pro @ PCIe4.0 bzw. die beiden Samsung 970 EVO Plus @ PCIe3.0 haben das so nicht geschafft.

Zuletzt bearbeitet:

inmomend reicht es noch habe letztes Jahr gut im die 980 PRO investiert.

inmomend reicht es noch habe letztes Jahr gut im die 980 PRO investiert.